Все видеокарты nvidia geforce по мощности: Спецификации видеокарт NVIDIA / Overclockers.ua

Содержание

Обзор и тестирование мобильной видеокарты GeForce GTX 1650 Ti

Весной 2020 года компания NVIDIA представила бюджетную видеокарту для ноутбуков GeForce GTX 1650 Ti. Это усиленная версия GeForce GTX 1650, которая примечательна тем, что в настольном сегменте Ti-версия так и не вышла. В данном обзоре мы разберем особенности GeForce GTX 1650 Ti Mobile и протестируем видеокарту при стандартных частотах и в разгоне.

В основе рассматриваемой видеокарты графический процессор TU117 архитектуры Turing, который не имеет аппаратной поддержки трассировки и DLSS. Первые видеокарты GeForce GTX 1650 для настольных систем дебютировали весной 2019 года. Они получили частично урезанный чип с 896 ядрами CUDA. Полная конфигурация TU117 с 1024 потоковыми ядрами и 64 текстурными блоками получила реализацию только в мобильных GeForce GTX 1650 Ti. При этом рабочие частоты GPU немного снизились относительно мобильной GeForce GTX 1650, чтобы удержать TDP в рамках 50 Вт. Шина памяти у всех видеокарт 128 бит, объем памяти 4 ГБ. Для GeForce GTX 1650 Ti стандартном является использованием микросхем GDDR6 с эффективной частотой 12 ГГц, а у GeForce GTX 1650 были разные варианты с GDDR5 и GDDR6.

Для GeForce GTX 1650 Ti стандартном является использованием микросхем GDDR6 с эффективной частотой 12 ГГц, а у GeForce GTX 1650 были разные варианты с GDDR5 и GDDR6.

В итоге имеет преимущество GeForce GTX 1650 Ti над GeForce GTX 1650 в 14% по количеству вычислительных блоков и возросшая на 50% пропускная способность памяти.

|

GeForce GTX 1650 Desktop

|

GeForce GTX 1650 Ti Mobile

|

GeForce GTX 1650 Mobile

| |

|

Архитектура

|

Turing

|

Turing

|

Turing

|

|

Ядро

|

TU117

|

TU117

|

TU117

|

|

Количество транзисторов, млн. шт

|

4700

|

4700

|

4700

|

|

Техпроцесс, нм

|

12

|

12

|

12

|

|

Площадь ядра, кв.

|

200

|

200

|

200

|

|

Количество потоковых процессоров CUDA

|

896

|

1024

|

896

|

|

Количество текстурных блоков

|

56

|

64

|

56

|

|

Количество блоков ROP

|

32

|

32

|

32

|

|

Частота ядра (Base/Boost), МГц

|

1485-1565

(1410-1590)

|

1350-1485

|

1395-1560

|

|

Шина памяти, бит

|

128

|

128

|

128

|

|

Тип памяти

|

GDDR5/GDDR6

|

GDDR6

|

GDDR5/GDDR6

|

|

Эффективная частота памяти, МГц

|

8000/12000

|

12000

|

8000/12000

|

|

Объём памяти, ГБ

|

4

|

4

|

4

|

|

Интерфейс

|

PCI-E 3.

|

PCI-E 3.0

|

PCI-E 3.0

|

|

Мощность, Вт

|

75

|

50

|

50

|

Рассмотрим видеокарту составе ноутбука ASUS ROG Strix G15 G512LI.

Характеристики тестовой системы:

- Процессор Intel Core i5-10300H (2,5-4,5 ГГц)

- ОЗУ 16 GB DDR4-2933

- Видеокарта GeForce GTX 1650 Ti 4GB GDDR6

- Накопитель SSD NVMe SSDPEKNW512G8 512 GB

GeForce GTX 1650 Ti со стандартными характеристиками: базовая частота 1350 МГц, Boost Clock 1485 МГц, память GDDR6 12000 МГц.

Реальный Boost в игровом режиме держался в рамках 1600-1700 МГц, т.е. выше заявленного значения Boost Clock. Такие частоты связаны с низкими рабочими температурами. Стресс-тест 3DMark прогрел GPU до 68 °C, что для мобильной видеокарты очень мало.

Для разгона ноутбук переключался в режим «Турбо», что подразумевает более высокие обороты вентиляторов ASUS ROG Strix G15. Частоту GPU удалось повысить до 1500 МГц по базовому уровню при среднем Boost Clock 1635 МГц (реальный Boost поднялся до 1700-1750 МГц) Разгон памяти пришлось ограничить на уровне 13100 МГц, далее начинались проблемы со стабильностью.

Методика тестирования

3DMark Time Spy

Два прогона. Слева указаны баллы GPU Score, справа общий результат.

Assassin’s Creed Odyssey

Встроенный тест производительности прогонялся несколько раз. Дополнительно задействована утилита MSI Afterburner для контроля минимального fps.

Выбран профиль настроек «Очень высокого», качество облаков понижено до высокого уровня, сглаживание среднего уровня.

Battlefield V

Повторялась определенная последовательность действий в начале миссии «Тиральер».

Максимальное качество графики в DirectX 12.

Control

Тестирование проведено на большой локации «Исследовательская зона», где насыщенные световые эффекты сочетаются с множеством отражений. Выполнялась пробежка с метанием предметов, чтобы генерировать пыль и осколки. Несколько повторов.

Максимальное качество графики High в DirectX 11, сглаживание и эффект размытия отключены.

Death Stranding

Тестовая прогулка по первой дождливой локации. Несколько повторов.

Выбрано наивысшее качество графики (Very High).

Doom Eternal

Выполнялась тестовая пробежка и перестрелка на открытой локации первой миссии.

Выбран уровень графики «Высоко».

Far Cry 5

Тестирование проводилось во встроенном игровом бенчмарке.

Выбран профиль Ultra-качества.

Gears 5

Несколько прогонов встроенного бенчмарка на каждой видеокарте.

Максимальное качество графики Ultra, отключен эффект Motion Blur, понижено качество сглаживания, отключен параметр Async Compute.

Horizon Zero Dawn

Несколько прогонов встроенного бенчмарка.

Выбрано высокое качество графики.

Mafia: Definitive Edition

Для тестирования повторялась погоня из первой главы. Несколько повторов на каждой видеокарте.

Несколько повторов на каждой видеокарте.

Выбрано максимальное качество графики (High).

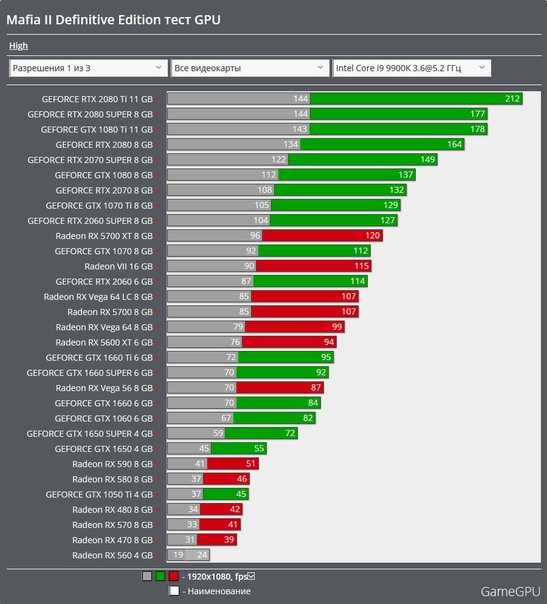

Mafia II: Definitive Edition

Использовался встроенный бенчмарк.

Максимальное качество графики High без эффектов PhysX APEX.

Ori and the Will of the Wisps

Тестирование проводилось путем повторения определенной последовательности действий на первой локации в темном дождливом лесу.

Red Dead Redemption 2

Несколько повторов встроенного игрового теста.

Все основные параметры в режиме среднего качества.

Resident Evil 3

Переигрывался эпизод в прологе.

Максимальное качество графики в DirectX 11.

Shadow of the Tomb Raider

Задействован стандартный игровой бенчмарк, шесть прогонов.

Стандартный профиль высокого качества и сглаживание TAA в DirectX 12.

Star Wars Jedi: Fallen Order

Повторялась тестовая прогулка по планете Богано. Несколько повторов на каждой видеокарте.

Максимальное качество графики. Отключено динамическое разрешение.

The Outer Worlds

Повторялась тестовая прогулка по первой планете. Стартовая локация в зоне приземления нашего космического корабля.

Максимальное качество графики.

The Witcher 3: Wild Hunt

Сюжетный пролог. Герой с напарником скачут по дороге в селение. Этот момент выбран для измерения производительности при помощи Fraps. Шесть повторов для каждой видеокарты.

Этот момент выбран для измерения производительности при помощи Fraps. Шесть повторов для каждой видеокарты.

Выбрано «запредельное» качество», из постобработки активны только лучи света, затенение SSAO.

Tom Clancy’s The Division 2

Задействован встроенный бенчмарк, который прогонялся по несколько раз на каждой видеокарте.

Выбран профиль высокого качества в DirectX 12.

Watch Dogs: Legion

Задействован стандартный игровой бенчмарк.

Выбран профиль графики High в DirectX 11.

Другие материалы в этой категории:

« GeForce GTX 1060 6GB против Radeon RX 580 8GB в современных играх. Большое тестирование

Неудержимая тройка. Большое тестирование GeForce RTX 3090, GeForce RTX 3080 и GeForce RTX 3070 »

ТОП-5 видеокарт GTX 1050 TI — рейтинг лучших видеокарт

Играть на максималках без хорошей видеокарты — практически нереально. Но как быть, если денежки сэкономить так же важно, как и комфортный геймплей? Эта подборка подскажет. Здесь — лучшие бюджетные GTX 1050 TI топовых брендов. Сравнение особенностей, параметров и функций четырехгигабайток, созданных крутыми производителями, помогут выбрать самую оптимальную под себя.

GIGABYTE GEFORCE GTX 1050 TI 4GB DDR5 OC

С этой лапочкой, выпущенной топовым производителем, комфортный гейминг — это просто. Даже весьма требовательные любители современных игр останутся довольны. И отзывы это подтверждают.

Лучшие черты бюджетного видеоадаптера:

- За защиту от перегрева и поддержку оптимальной температуры отвечает активная система охлаждения.

При этом два кулера не создают заметного шума.

При этом два кулера не создают заметного шума. - Максимальное разрешение в 7680×4320 точек позволяет наслаждаться крутой детализацией.

Минус — не заточена под SLI: одновременное подключение нескольких плат не получится.

Интересно: Как собрать ферму для домашнего майнинга: 7 главных составляющих

ASUS GEFORCE GTX 1050 TI 4GB DDR5 GAMING STRIX

Мощь этой недорогой модели в сочетании с хорошей энергоэффективностью подкупают. Но не только экономия энергии делает этот графический ускоритель достойным занять позицию в рейтинге лучших видеокарт для игр.

Есть и другие параметры, за которые ее рекомендуют выбрать.

Ключевые характеристики:

1. Память GDDR5 вкупе с поддержкой OpenGL 4,5 и DirectX 12 делают видеокарту дружественной к современным играм и дают возможность играть на настройках выше средних.

2. За стабильную работу девайса отвечает функция Auto-Extreme, которая контролирует рабочий процесс автоматически.

3. Карта фирмы Асус оснащена солидной системой охлаждения с 2 вентиляторами и радиатором, так что не перегреется.

4. GPU Tweak II — позволит управлять подсветкой и внести нотки индивидуальности в собранный ПК.

5. Запись или трансляция геймплея в реальном времени — не проблема. Незаменимым помощником в этих делах станет софт XSplit Gamecaster.

6. Возможность одновременно подключить до четырех мониторов тоже радует.

Играм нужно место: ТОП-5 лучших HDD на 2 TB – Рейтинг внутренних жестких дисков на 2000 Гб

MSI GEFORCE GTX 1050 TI 4GB DDR5 GAMING X

Одна из самых нафаршированных среди недорогих видеокарт, которые работают на процессоре GP-107 (Pascal). Золотая середина между девайсами начальной и средней категории, где именно она занимает позицию топовой, причем бюджетной. Мегапроизводительность, холодность — лишь парочка причин, по которым карта для игр вошла в рейтинг лучших.

Почему стоит купить:

- Работает устройство довольно тихо.

Пока температура не достигнет 60 градусов, вентиляторы и вовсе находятся в простое.

Пока температура не достигнет 60 градусов, вентиляторы и вовсе находятся в простое. - Как и варианты других производителей из списка, этот хорош тем, что поддерживает последнюю версию DirectX и OpenGL.

- Кроме того, она порадует способностями к адаптивной вертикальной синхронизации и отображению объемной картинки, а также возможностью комфортного стриминга и прочими полезными функциями.

- Еще одна фишка для большего погружения в игровой процесс — интегрированный аудиочип, который поддерживает многоканальное звучание 7.1.

Ликбез: Чем подкреплена криптовалюта: 4 факта об деньгах

MSI GEFORCE GTX 1050 TI 4GB DDR5 OC

Вариант оснащен всем необходимым для того, чтобы геймер чувствовал себя комфортно. Бренд, под которым выпущена эта карточка, постарался на славу. GTA 5, Ведьмак 3, Battlefield 4 или Doom 2016 в FHD на ультранастройках — без проблем. При этом устройство стоит недорого, чем и заслужило свою популярность.

SSD — классное хранилище для игр: ТОП-10 лучших SSD-накопителей

GIGABYTE GEFORCE GTX 1050 TI 4GB DDR5 WINDFORCE OC

Завершающий в топ-список, но отнюдь не плетущийся в хвосте рейтинга лучших — бюджетный видеоадаптер от Гигабайт. Теперь «фризы» и слабенький FPS — не более, чем ночной кошмар, который остался в прошлом.

Теперь «фризы» и слабенький FPS — не более, чем ночной кошмар, который остался в прошлом.

Совет: если нужна «холодная», тихая и высокопроизводительная игровая видеокарта по доступной цене — это один из оптимальных вариантов.

Геймерам на заметку: ТОП-10 лучших игровых мониторов

История графики Nvidia

Почему можно доверять Pocket-lint

(Pocket-lint) — компания Nvidia была основана в 1993 году, но только в 1995 году компания выпустила свой первый графический продукт — NV1. С тех пор многое изменилось, и теперь мы избалованы трассировкой лучей, DLSS и другими замечательными технологиями, которые делают наши игровые возможности еще более приятными.

Мы оглядываемся на историю видеокарт Nvidia и на то, как эти устройства выглядели на протяжении многих лет.

- Подробнее о компьютерных играх совместно с Nvidia

Swaaye/Wikipedia

Nvidia NV1

Nvidia NV1 была выпущена в 1995 году и могла обрабатывать как 2D, так и 3D видео. Он продавался как «Diamond Edge 3D» и даже имел порт для джойстика, совместимый с Sega Saturn.

Он продавался как «Diamond Edge 3D» и даже имел порт для джойстика, совместимый с Sega Saturn.

Несколько игр Sega Saturn были перенесены на ПК, включая Panzer Dragoon и Virtua Fighter Remix. Одних этих функций было недостаточно, чтобы привлечь рынок, поскольку Saturn изо всех сил пытался конкурировать с оригинальной PlayStation.

У NV1 был тяжелый старт, который усугубился выпуском Microsoft DirectX, который был несовместим с графическим процессором, и многие игры не запускались.

Матиас Табо/Википедия

Nvidia RIVA 128

В 1997 году Nvidia выпустила NV3, также известную как Riva 128, что означает «Интерактивное видео и анимация в реальном времени». Эта видеокарта использовала как 2D-, так и 3D-ускорение, а также наложение полигональных текстур.

В то время конкурент Nvidia, 3dfx, доминировал на рынке, но NV3 имела тактовую частоту ядра/памяти 100 МГц и по существу удваивала характеристики 3dfx Voodoo 1.

Было два варианта NV3 в виде Riva 128 и Riva 128ZX. Последний был более мощным с 8 МБ видеопамяти и тактовой частотой 250 МГц.

Последний был более мощным с 8 МБ видеопамяти и тактовой частотой 250 МГц.

NV3 оказался гораздо более успешным, чем первый GPU компании, и помог Nvidia завоевать широкую популярность.

Tors/Wikipedia

Nvidia NV4

В 1998 году Nvidia выпустила NV4, также известную как Riva TNT. Эта видеокарта улучшена по сравнению с предыдущими моделями за счет поддержки 32-битного True Colour. NV4 также имел больше оперативной памяти с 16 МБ SDR SDRAM, что также означало более высокую производительность.

Примерно в это же время Nvidia начала предпринимать шаги по регулярному обновлению графических драйверов, чтобы обеспечить хорошую производительность и совместимость для конечного пользователя, чем компания занимается и по сей день.

Riva TNT от Nvidia была более доступной в то время, чем Vodoo2 от 3dfx, хотя и немного медленнее с точки зрения производительности. Поддержка драйверов была ключом к успеху NV4.

Uwe Hermann/Wikipedia

Nvidia NV5

В 1999 году Nvidia последовала за NV4, выпустив RIVA TNT2. NV5, как она называлась, приобрела ряд обновлений, включая поддержку 32-битного Z-буфера/трафарета, до 32 МБ видеопамяти и поддержку текстур 2048 x 2048.

NV5, как она называлась, приобрела ряд обновлений, включая поддержку 32-битного Z-буфера/трафарета, до 32 МБ видеопамяти и поддержку текстур 2048 x 2048.

Что еще более важно, эта видеокарта имеет улучшенную тактовую частоту (до 150+ МГц), что дает прирост производительности на целых 17 процентов по сравнению с предыдущей моделью.

Эта карта была прямым конкурентом 3dfx Voodoo3, и обе были невероятно популярны.

Hyins/Wikipedia

Nvidia GeForce 256

В конце 1999 года Nvidia выпустила «первый в мире GPU» — Nvidia GeForce 256.

Это был умный маркетинговый ход со стороны Nvidia и начало любви к графическим картам GeForce на долгие годы.

По сравнению с предыдущими картами RIVA она была улучшена за счет увеличения пиксельных конвейеров, но также обеспечила значительный скачок в производительности для компьютерных игр.

Эта карта поддерживает до 64 МБ DDR SDRAM и работает на частоте до 166 МГц. Таким образом, он был на 50 процентов быстрее, чем NV5.

Что еще более важно, GeForce 256 также полностью поддерживала Direct3D 7, что означало, что на нем можно было запускать многие из лучших игр для ПК, доступных в то время.

Вскоре после этого запуска 3dfx обанкротилась, и основным конкурентом Nvidia стала ATI.

Hyins/Wikipedia

Nvidia GeForce2

Nvidia последовала за первым в мире графическим процессором с метко названным GeForce2.

Этот графический процессор выпускался в нескольких различных вариантах, включая модели Ti, Pro, GTS и Ultra. По сути это были карты NV11, 15 и 16. В выпусках 2000 и 2001 годов наблюдалось увеличение конвейеров и более высокая тактовая частота.

Что сделало GeForce2 интересным, так это начало поддержки мультимониторных установок.

Примерно в это же время Nvidia приобрела 3dfx.

Hyins/Wikipedia

Nvidia GeForce3

Вскоре после GeForce2 появилась GeForce3. Эта серия видеокарт под кодовым названием NV20 представляла собой первые графические процессоры Nvidia, совместимые с DirectX 8.

Было три версии — GeForce3, GeForce3 Ti 200 и GeForce3 Ti 500. В этом следующем графическом процессоре GeForce были добавлены программируемые пиксельные и вершинные шейдеры, а также мультисэмпловое сглаживание.

Версия GeForce3, именуемая NV2A, использовалась в оригинальной консоли Xbox.

Hyins/Wikipedia

Серия Nvidia GeForce FX

Скачок вперед на пару поколений, и в 2003 году мы выпускаем серию Nvidia GeForce FX.

Это были видеокарты GeForce пятого поколения, которые поддерживали Direct3D 9, а также ряд новых технологий памяти. К ним относятся DDR2, GDDR2 и GDDR3, а также первая попытка Nvidia использовать шину данных памяти шире 128 бит.

Между тем, GeForce FX 5800 произвела фурор, став первым графическим процессором, оснащенным большим кулером. Один такой большой, что его часто называли «пылесборником» из-за большого количества шума вентилятора.

Hyins/Wikipedia

Серия Nvidia GeForce 6

Вскоре после выпуска серии GeForce FX появилась серия 6 (она же NV40). GeForce 6 стала началом продвижения Nvidia технологии SLI, позволяющей людям комбинировать более одной видеокарты для большей мощности.

GeForce 6 стала началом продвижения Nvidia технологии SLI, позволяющей людям комбинировать более одной видеокарты для большей мощности.

Флагманом этой линейки была GeForce 6800 Ultra, видеокарта с 222 миллионами транзисторов, 16-пиксельными суперскалярными конвейерами и шестью вершинными шейдерами. Он имел поддержку Shader Model 3.0 и был совместим как с Microsoft DirectX 9,.0c и OpenGL 2.0.

В этой серии также использовалась технология Nvidia PureVideo, и она могла декодировать видео H.264, VC-1, WMV и MPEG-2 с меньшим использованием ЦП.

В результате все это привело к большому успеху серии GeForce 6.

FxJ/Wikipedia

Серия Nvidia GeForce7

В 2005 году вышла серия GeForce7, включая 7800 GTX.

Одна только эта карта была настоящей электростанцией для того времени, и благодаря умному охлаждению Nvidia смогла увеличить тактовую частоту до 550 МГц. При этом компании также удалось уменьшить латентность и увеличить шину до 512 бит.

Интересно, что версия 7-й серии была разработана как синтезатор реальности RSX, который был проприетарным процессором, совместно созданным Nvidia и Sony для PlayStation 3.

Shooke/Wikipedia

Серия Nvidia GeForce8 GeForce8 и представила свою микроархитектуру Tesla. Это был первый унифицированный дизайн шейдеров компании, и он также станет одной из наиболее часто используемых архитектур в будущих картах.

Всеми любимый Nvidia GeForce 8800 GTX был флагманом линейки и пользовался невероятной популярностью. Он имел 681 миллион транзисторов, 768 МБ памяти GDDR3 и 128 шейдеров с тактовой частотой 575 МГц.

Наиболее важно то, что эта видеокарта могла запускать Crysis, а это было всем, чего желали компьютерные геймеры в то время.

В 2006 году ситуация также накалялась, когда AMD купила ATI за 5,4 миллиарда долларов и стала занозой в боку Nvidia на долгие годы.

Sk/Wikipedia

Серия Nvidia GeForce9

В начале 2008 года Nvidia выпустила серию GeForce9. Эти карты продолжали использовать архитектуру Tesla, но также добавили поддержку PCIe 2.0, улучшенный цвет и z-сжатие.

Эти карты продолжали использовать архитектуру Tesla, но также добавили поддержку PCIe 2.0, улучшенный цвет и z-сжатие.

К этому времени Nvidia подняла производительность на ступеньку выше, тактовая частота достигла 675 МГц, при этом энергопотребление также снизилось.

Amazon

Серия Nvidia GeForce 400

Следующее значительное обновление произошло в 2010 году, когда Nvidia выпустила серию GeForce 4000. Именно тогда Nvidia представила микроархитектуру Fermi, которая стала следующей крупной архитектурой компании.

Эта серия также имела поддержку OpenGL 4.0 и Direct3D 11 и была прямым конкурентом серии Radeon HD 5000.

Однако серию подвели высокие рабочие температуры и энергопотребление, что вызвало много недовольства пользователей.

HanyNAR

Серия Nvidia GeForce 600

Серия GeForce 600 представила архитектуру Nvidia Kepler, которая была разработана для увеличения производительности на ватт, а также улучшения производительности предыдущей микроархитектуры Fermi.

С помощью Kepler Nvidia удалось увеличить тактовую частоту памяти до 6 ГГц. Он также добавил GPU Boost, который гарантировал, что GPU сможет работать на минимальной тактовой частоте, а также повышать производительность при необходимости, пока не будет достигнуто заранее определенное целевое значение мощности.

Этот диапазон также поддерживал как Direct3D 11, так и Direct3D 12. IT также представил новый метод сглаживания, известный как TXAA.

Маркус Бернс

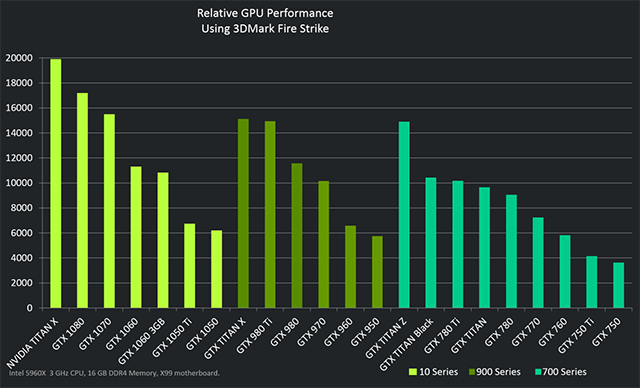

Серия Nvidia GeForce 700

В 2013 году Nvidia подняла ситуацию на новый уровень, выпустив серию 700, которая была дополнена безумной высококлассной картой GTX Titan для энтузиастов.

Эта серия была обновлением микроархитектуры Kepler, но некоторые более поздние карты также имели архитектуры Femi и Maxwell.

GTX Titan может похвастаться 2688 ядрами CUDA, 224 TMU и 6 ГБ оперативной памяти. К этому времени Nvidia удалось втиснуть в свои графические процессоры целых семь миллиардов транзисторов.

Серия GeForce 700 была разработана для обеспечения максимальной энергоэффективности, но также включает в себя другие функции, такие как аппаратное кодирование H.264, интерфейс PCI Express 3.0, поддержку DisplayPort 1.2 и HDMI 1.4a 4K x 2K видеовыхода, а также GPU-Boost 2.0. .

Маркус Бернс

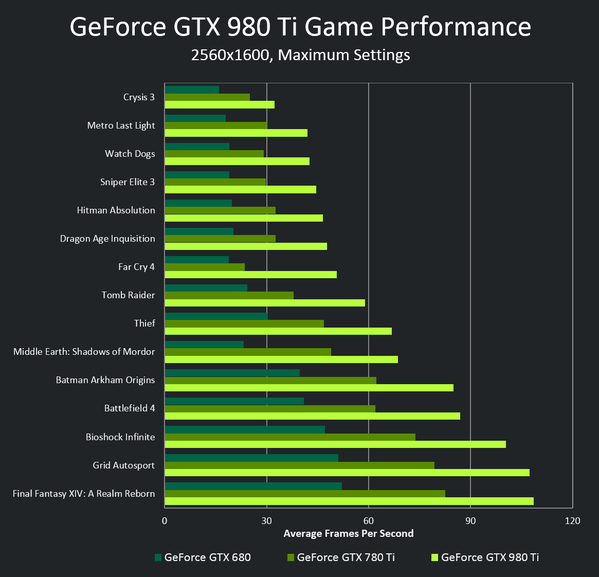

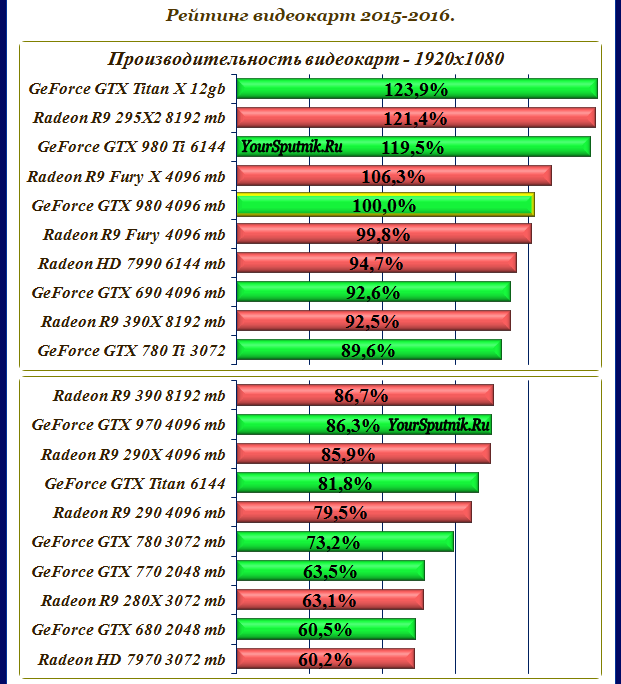

Серия Nvidia GeForce 900

В 2014 году Nvidia, казалось бы, пропустила поколение и сразу перешла к серии GeForce 900. Это было введение в микроархитектуру Maxwell, которая предлагала улучшенные графические возможности, а также лучшую энергоэффективность.

Изначально флагманом этой серии была GeForce GTX 980, за которой позже последовали 980 Ti и GeForce GTX TITAN X.

NVENC также был улучшен для этой серии и появилась поддержка Direct3D 12_1, OpenGL 4.6, OpenCL 3.0 и Vulkan 1.3.

Маркус Бернс

Серия Nvidia GeForce10

В 2014 году Nvidia представила серию GeForce10 на основе микроархитектуры Pascal. GTX 1080 Ti, пожалуй, самый известный из графических процессоров этой серии и вошел в историю как, возможно, одна из самых значительных карт, выпущенных Nvidia.

GTX 1080 Ti, пожалуй, самый известный из графических процессоров этой серии и вошел в историю как, возможно, одна из самых значительных карт, выпущенных Nvidia.

Эта графическая карта доминировала на рынке и предлагала такую превосходную производительность и энергоэффективность по сравнению с ценой, что ее часто будут упоминать при сравнении с будущими графическими процессорами.

Серия 10 также включает новые функции, такие как GPU Boost 3.0, система планирования динамической балансировки нагрузки, тройная буферизация и поддержка DisplayPort 1.4 и HDMI 2.0b.

Маркус Бернс

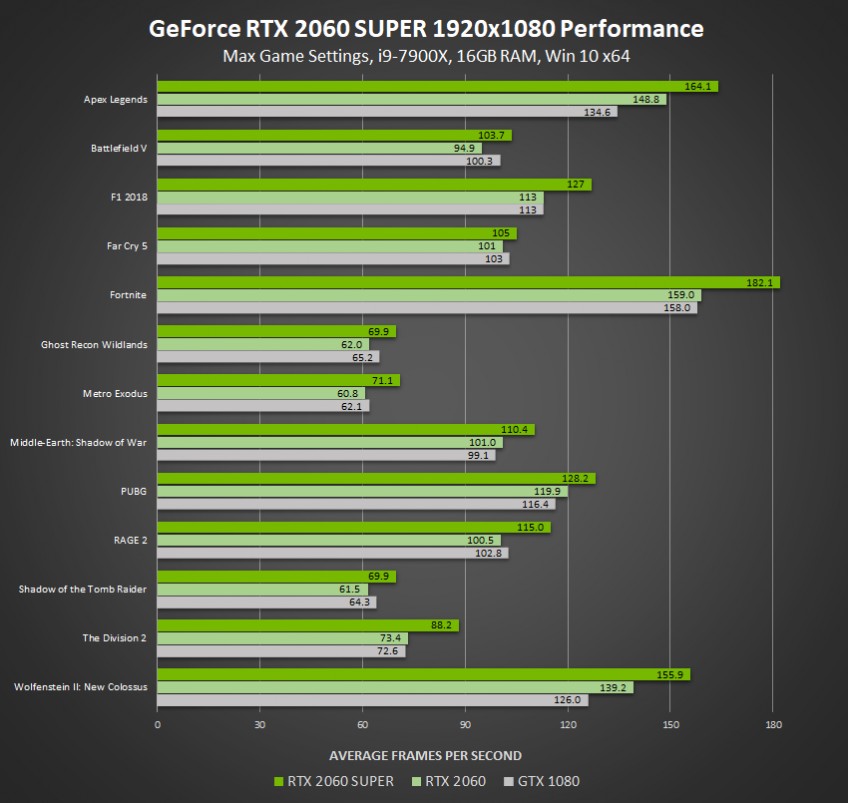

Серия Nvidia GeForce20

Серия GeForce20 была выпущена в 2018 году и представила миру микроархитектуру Turing.

Примечательно, что эти видеокарты были картами RTX первого поколения, и Nvidia продвигала трассировку лучей в качестве основного преимущества.

Использование тензорных ядер и других усовершенствований помогло этим картам совершить огромный скачок в графическом совершенстве. Результатом является реалистичное освещение и убедительные эффекты отражения в игре.

Результатом является реалистичное освещение и убедительные эффекты отражения в игре.

Однако за улучшения пришлось заплатить: RTX 2080 Ti продавалась по невероятной цене 1199 долларов (по сравнению с 699 долларов за 1080 Ti).

Карманный ворс

Серия Nvidia GeForce30

Серия GeForce30 пришла на смену серии 20 в 2020 году и, к сожалению, стала наиболее известной из-за того, что ее просто невозможно было достать из-за нехватки силикона.

Тем не менее, Nvidia RTX 3080 должна была продаваться по цене 699 долларов, что делало ее намного более доступной, чем флагманы предыдущих поколений, и серия также претерпела значительные улучшения.

Флагманская видеокарта GeForce RTX 3090 Ti, анонсированная в марте 2022 года, содержит 10 752 ядра CUDA, 78 RT-TFLOP, 40 Shader-TFLOP и 320 Tensor-TFLOP мощности. Этот мощный зверь также был отмечен как энергоемкий, требующий не менее 850 Вт мощности, а это означает, что для его работы вам, вероятно, понадобится блок питания мощностью 1000 Вт.

Автор Адриан Уиллингс. Монтаж Крис Холл.

Анонсированы новые графические процессоры Nvidia: RTX 4090 и 4080

Что происходит

Nvidia анонсировала свои флагманские игровые видеокарты нового поколения RTX 4090 и RTX 4080.

Почему это важно

Видеокарты на базе Nvidia по-прежнему являются самыми популярными на рынке, и любые новые технологии, которые значительно ускоряют их, заслуживают внимания.

До свидания, Ампер; привет, Ада Лавлейс: Nvidia представила новое поколение графических карт GeForce на своей ежегодной конференции по графическим технологиям, на которой компания два раза в год обновляет архитектуру графического процессора, на этот раз названного в честь математика и пионера программирования.

Nvidia обещает, что флагманская RTX 4090 может работать в два раза лучше в играх с большим количеством растровых изображений и в четыре раза быстрее в играх с полной трассировкой лучей, чем прежний флагман RTX 3090 Ti, а RTX 4080 должен быть в три раза быстрее. быстрее, чем RTX 3080 Ti. Поставка RTX 4090 запланирована на 12 октября по цене от 1599 долларов, а RTX 4080 — в ноябре по цене от 899 долларов; последний будет поставляться в двух версиях: 16 ГБ и 12 ГБ.

быстрее, чем RTX 3080 Ti. Поставка RTX 4090 запланирована на 12 октября по цене от 1599 долларов, а RTX 4080 — в ноябре по цене от 899 долларов; последний будет поставляться в двух версиях: 16 ГБ и 12 ГБ.

В дополнение к картам Nvidia Founders Edition версии с использованием графических процессоров будут доступны у обычных партнеров Nvidia (кроме EVGA), включая Asus, Gigabyte, MSI, PNY и Zotac. RTX 3080, 3070 и 3060 останутся в линейке, и я бы хотел получить на них большие скидки во время сезона праздничных распродаж.

| RTX 4090 | RTX 4080 (16 ГБ) | RTX 4080 (12 ГБ) | |

|---|---|---|---|

| Память | 24 ГБ GDDR6X/384 бит | 16 ГБ GDDR6X/256 бит | 12 ГБ GDDR6X/192 бит |

| CUDA-ядра | 16 384 | 9728 | 7680 |

| Повышенная тактовая частота (ГГц) | 2,52 | 2,51 | 2,61 |

| поколение PCIe | 4 | 4 | 4 |

| Ширина карты | 3 слота | 3 слота | Варьируется |

| Требования к мощности/блоку питания | 450 Вт/850 Вт | 320 Вт/700 Вт | 285 Вт/700 Вт |

| Доступность | 12 октября | ноябрь | ноябрь |

| цена в США | От 1599 долларов. | От 1199 долларов. | От 899 долларов |

Когда RTX 4090 поступит в продажу, будет выпущено несколько бесплатных дополнений, подтверждающих эффективность и производительность: Portal с RTX и новым режимом трассировки лучей: Overdrive Mode для Cyberpunk 2077. приложение для рендеринга, Nvidia Racer RTX.

приложение для рендеринга, Nvidia Racer RTX.

Нвидиа

Архитектура чипов Ады Лавлейс — неясно, будет ли она называться «Ада», что короче, или «Лавлейс», в соответствии с традицией, — представляет семь аппаратных обновлений, некоторые из которых являются производными от ее архитектуры. родственный центр обработки данных, Hopper:

- Построен на 4-нанометровом техпроцессе. В оптимальном случае более мелкие процессы позволяют втиснуть больше кремния в то же пространство с (обычно) улучшенной эффективностью энергопотребления и производительности.

- Ядра трассировки лучей третьего поколения удваивают производительность вычислений того, как лучи взаимодействуют с многоугольниками, определяющими изображение, что, по словам Nvidia, увеличивает скорость операций с плавающей запятой до 2,8x.

- Ядра Tensor четвертого поколения, которые управляют программным обеспечением Nvidia для масштабирования DLSS, позволяют DLSS перейти от генерации отдельных пикселей к более эффективным алгоритмам на основе кадров для своего нового DLSS 3.

Более 35 игр и приложений подписались на внедрение DLSS 3, начиная с в октябре.

Более 35 игр и приложений подписались на внедрение DLSS 3, начиная с в октябре. - Обновленные потоковые мультипроцессоры обеспечивают вдвое большую пропускную способность, чем Ampere SM.

- Изменение порядка выполнения шейдеров оптимизирует передачу данных трассировки лучей в SM для растеризации, что, по словам компании, повышает производительность шейдеров до 2 раз и частоту кадров до 25%.

- Optical Flow Accelerator использует данные о движении пикселей для DLSS для создания новых кадров; Nvidia заявляет, что это повышает производительность в играх с интенсивным использованием процессора (таких как сложные игры-симуляторы, такие как Microsoft Flight Simulator).

- Двойные кодировщики AV1 должны улучшить качество обработки видео на лету для стримеров. Ожидается, что OBS выпустит новую версию своего программного обеспечения для потоковой передачи в октябре, а Discord планирует поддержать ее позже в этом году.

В дополнение к новым возможностям обработки Nvidia представила несколько новых программных алгоритмов для повышения производительности.

мм

мм 0

0 При этом два кулера не создают заметного шума.

При этом два кулера не создают заметного шума. Пока температура не достигнет 60 градусов, вентиляторы и вовсе находятся в простое.

Пока температура не достигнет 60 градусов, вентиляторы и вовсе находятся в простое. Более 35 игр и приложений подписались на внедрение DLSS 3, начиная с в октябре.

Более 35 игр и приложений подписались на внедрение DLSS 3, начиная с в октябре.