Срок доставки товара в течении 1-3 дней !!!

|

|

Самые необычные видеокарты за всю историю компьютеров — часть №1. Видеокарта самая слабая

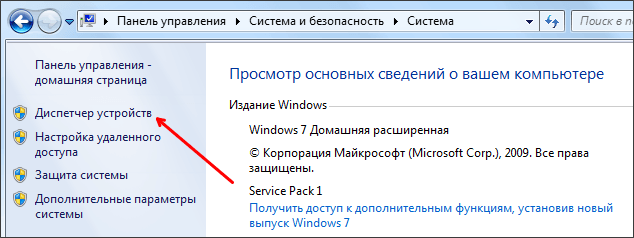

Характеристика видеокарты NVIDIA GeForce: список по мощности

Компания Nvidia была основана в 1993 году. Калифорнийские разработчики уже много лет занимаются созданием видеокарт самого разного назначения. Начиная от бюджетных и заканчивая мощными игровыми решениями – все что угодно можно найти в ассортименте продукции компании. Многолетняя история подразумевает наличие множества поколений технологий, которые сменяли друг друга практически каждый год. Именно об этом и пойдет речь в данной статье. Описание всех Nvidia GeForce, список видеокарт по мощности и году выпуска - обо всем читайте ниже.

Немного о компании

Nvidia является самой крупной компанией-производителем компьютерных комплектующих в сфере видеоускорителей. В фирме работает более 8 тысяч сотрудников. На весь мир известно соперничество компании с AMD (второй крупнейший производитель видеокарт). В истории фирмы имеется несколько ключевых событий, которые повлияли на ее дальнейшее развитие.

В 1995 году компания выпустила свой первый продукт под названием NV1. В 1999 году на рынке появляется первое поколение Nvidia Quadro. Этот графический процессор предназначен специально для рабочих станций.

2006 год отметился выпуском легендарной видеокарты 8800GTX. Она показывала лучшую производительность на протяжении нескольких лет, что привлекало покупателей. К тому же данный ускоритель стал первым, в котором реализована поддержка DirectX 10.

В 2008 году компания представляет разработку собственного физического движка под названием PhysX. С 2012 года Nvidia вступает в The Linux Foundation.

Nvidia Geforce: список видеокарт

Первое поколение GeForce появилось в 1999 году. Устройство было разработано на техпроцессе 220 нм. Видеокарта поддерживала интерфейс DirectX 7 и имела 128-битную шину. Продукт выходил в двух вариантах – с 32 и 64 Мб видеопамяти. Для нынешнего времени эти цифры кажутся смешными и несерьезными, но в конце XX века данная разработка была прорывной.

GeForce 2 был анонсирован в 2001 году. Данное поколение уже было разработано на более совершенном процессе 180 нм. Объемы видеопамяти остались неизменными. Вторая версия является первым поколением, в котором реализована поддержка пиксельных шейдеров первого поколения. С этого момента и начался быстрый подъем компании в гору.

Самыми производительными и прорывными в мире графических технологий были видеокарты Nvidia Geforce. Список по мощности представлен в порядке выхода каждого поколения.

Четвертое поколение GeForce 4 появилось в начале 2002 года. В этой разработке создатели уже полностью отказались от 32Мб видеопамяти в пользу больших объемов. Теперь минимальным размером памяти стало 64 Мб, а максимальным – 128 Мб. Весной того же года вышла разогнанная версия GeForce 4 Ti, которая поддерживала DirectX 8 первой версии.

GeForce 5 series начала выпускаться в марте 2003 года. Данное поколение стало первым, в котором появился объем видеопамяти, равный 256 Мб. Устройства поддерживали DirectX 9 и были разработаны на техпроцессе 150 нм. Новое поколение получило новую индексацию, которая помогала различать их по мощности. Самая младшая версия обозначалась индексом 5200, а самая мощная – 5950. Разогнанные версии получали приставку Ultra.

6 серия GeForce вышла в релиз в конце 2005 года. Данное поколение получило 512 Мб видеопамяти в исполнении 6600 GT. 7 series была анонсирована в 2007 году. Отличий от предыдущего поколения не так много, как хотелось бы.

Легендарный графический процессор

Если брать сравнение всех видеокарт Nvidia GeForce по мощности и вкладу в развитие, то именно восьмая серия GeForce стала прорывной. Особенно это касается двух вариантов видеокарт – это 8600 и 8800. Оба устройства выпускались в версиях GTX и Ultra. Для 8800 также была предусмотрена версия GTS. Объем памяти для продукта был выбран не совсем привычный – 324 и 484 Мб, в зависимости от версии. Именно в этом поколении была реализована поддержка DirectX 10.

GeForce 9 появилась через год, но революции, как это было с предшественником, не получилось. Параллельно с 9-й серией компания начинает выпуск новых разработок, которые дают начало новому модельному ряду видеокарт. Именно о нем и пойдет речь далее.

Видеокарты Nvidia Geforce: список по мощности

- В 2009 году Nvidia анонсируют серию GeForce 100 и 200. Обе версии становятся первыми в мире, чей объем видеопамяти может достигать 1 Гб.

- В 2011 году выходит GeForce Series 400. Объем видеопамяти увеличен до максимально возможных 3 Гб на тот период времени. Появилась поддержка DirectX 11. Видеокарты построены на техпроцессе 40 нм.

- Следующая серия GeForce 500 выходит в этом же году. Разработчики усовершенствовали уже имеющиеся технологии и подтянули производительность в играх. Было решено отказаться от минимального объема памяти 512 Мб в пользу 1Гб. Максимальный объем стал равен 3Гб. Все устройства имели шину на 128 бит. Самая дешевая видеокарта серии стоила около 60 долларов, а самая мощная и дорогая – более 500 долларов.

- GeForce 600 были переименованными в видеокарты предыдущего поколения. Сделано это потому, что они остались теми же, но с увеличенной мощностью. Новое поколение начинается только с версии 650. В самом мощном исполнении видеокарта GeForce 690 предлагает пользователю 4 Гб видеопамяти, поддержку DirectX 11.1.

- GeForce 700 выходит в 2013 году и сразу делает скачок по производительности. Версия 750 Ti даже в 2016 году выдает достойные показатели в тестировании и может посоревноваться с младшими и средними моделями серии 900. Также является достойным конкурентом современное решение от компании AMD. Рейтинг видеокарт GeForce и Radeon включает в себя данную видеокарту, которая занимает позиции, близкие к видеокартам Radeon middle-end класса.

- В рамках этого поколения в 2014 году появляется GTX Titan. Данный «зверь» оснащен 6 или 12 Гб оперативной памяти и шиной на 384 бита. Стоимость устройства составляет около 1 тысячи долларов и выше. Производительность ускорителя находится на самом топовом уровне и обходит все предложенные решения от AMD. Но и цена за данное удовольствие соответствующая.

GeForce 900 Series

2015 год и GeForce 900 серия. В данное поколение входит 6 видеокарт. Первая – 950 GTX. Самая младшая, но от этого не самая слабая видеокарта по сравнению с конкурентными решениями. Устройство оснащается 2 Гб видеопамяти и поддерживает DirectX 11. Поддержка DirectX 12 во всех устройствах 900 серии реализована только на программном уровне. Аппаратная поддержка осуществляется только у видеокарт Radeon.

Второе решение – это GTX 960. Тестирования видеопроцессоров компании Nvidia показывают, что данная видеокарта является оптимальным в плане соотношения по производительности и стоимости. Единственное, что огорчает многих пользователей и геймеров – это применение 128-битной шины в то время, когда конкуренты из AMD уже давно используют шину на 256 бит. Это позволяет увеличить пропускную способность и тем самым повысить производительность.

GTX 970 – самое сомнительное устройство в серии. Сильного прироста производительности по сравнению с 960 не наблюдается, но стоимость устройства гораздо выше. Также Nvidia утверждает, что в данной видеокарте установлено ровно 4Гб видеопамяти. Однако на деле оказалось, что внутри графического ускорителя находится всего 3,5Гб памяти.

GTX 980 и 980 Ti – видеокарты hi-end уровня. Показывают самые высокие результаты во всех тестах на производительность и обгоняют все конкурентные решения от AMD. Видеокарты имеют козырь в рукаве – температура и потребляемая мощность графических процессоров Nvidia гораздо ниже, чем у Radeon. Именно поэтому они не требуют дополнительного охлаждения и стабильно работают даже при повышенной нагрузке и в жаркую погоду.

GTX Titan X стоит особняком от всей серии. Данная видеокарта обладает запредельными характеристиками. Устройство оснащается 8Гб видеопамяти и использует 384-битную шину. Стоимость "Титана" оценивается в 1 тысячу долларов за оригинальный вариант без разгона от сторонних производителей.

Новое поколение

В 2016 году было анонсировано новое поколение 10 Series, которое включает в себя всего два устройства – Gtx 1070 и 1080. Все видеокарты Nvidia, основные характеристик которых представлены выше, меркнут по производительности на фоне нового поколения. Каждая видеокарта обладает 8 Гб видеопамяти и использует 256-битную шину. Приблизительная стоимость оценивается в 800-900 долларов. Остается ждать конкурентные видеокарты от компании AMD и сравнить результаты всех тестов, чтобы в очередной раз определить лидера в бесконечной гонке за производительностью и снижением энергопотребления.

Мобильные видеокарты

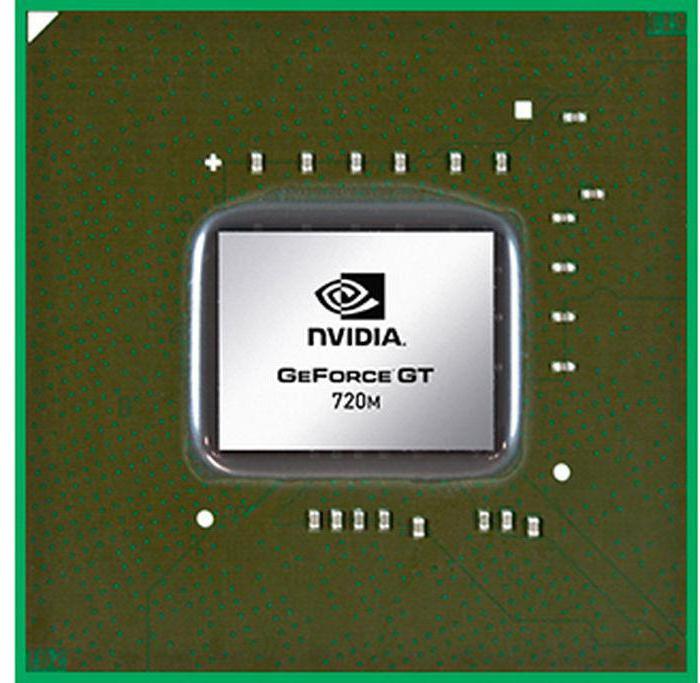

Видеокарты для ноутбуков начали выпускаться с поколения GeForce 2 и обозначались приставкой Go. После выхода полноценной 8-й серии видеокарт компания решила выпустить мобильные варианты устройств с приставкой M.

На сегодняшний день все ноутбуки могут оснащаться мобильными решениями от Nvidia, начиная с 700m и заканчивая 980m. Поколение 10 Series на данный момент еще не адаптировано для мобильных платформ. Видеокарты Nvidia GeForce, список по мощности которых описан выше, обладают гораздо большей производительностью по сравнению с сериями M. Это связано с особенностями строения ноутбуков и отсутствием возможности уместить там полноценную графическую плату.

Серия Quadro

Данные решения предназначены для профессиональной работы с 2D и 3D-приложениями и разработки компьютерных игр. Их стоимость гораздо выше пользовательских игровых видеокарт, но и возможности намного выше. Интересный момент в том, что данные видеокарты могут плохо себя проявлять в производительности игр, несмотря на свою мощность. Поэтому они используются только в рабочих станциях.

Итог

История модельного ряда видеокарт от Nvidia богата различными решениями и прорывными технологиями. Многолетняя конкуренция с AMD подталкивает компанию все больше развиваться и улучшать свою продукцию. Лозунг «выбери свою видеокарту Nvidia» подходит как нельзя кстати: в ассортименте компании вы найдете решения для любых задач и потребностей.

fb.ru

слабая видеокарта и мощный процессор или мощный процессор и слабая видеокарта?, Видеокарта, бюджет, процессор, скорость выполнения, частота, ядра, экран

Что лучше: слабая видеокарта и мощный процессор или мощный процессор и слабая видеокарта?

Видеокарта.

Чаще всего, этот вопрос возникает при нехватке бюджета на то и другое. Так как же найти ответ на этот вопрос? Для начала, нужно разобраться в их задачах. Видеокарта передает изображение на экран компьютера, а также отвечает за скорость работы в интернете (помимо провайдера). Так что, если видеокарта будет слабая, то выводить большое количество информации она просто не будет успевать, из-за чего компьютер будет зависать и тормозить, а также (из-за неисправности) могут появиться артефакты (дефекты) в картинке экрана. Существуют и встроенные видеокарты, но как правило они гораздо слабее дискретных (по другому – отдельных, специально покупающихся).

Процессор.

По названию самого комплектующего можно понять, что он выполняет различные процессы. Скорость выполнения, в свою очередь, зависит от нескольких факторов, чаще всего это: тактовая частота (чем больше, тем лучше) и количество ядер (чем их больше, тем лучше). При рассматривании слабого процессора будет подразумеваться двухядерный с тактовой частотой 2,9 ГГЦ.

Итак, из всего вышесказанного, можно сделать вывод, что процессор обрабатывает различные задачи и процессы, а видеокарта все это дело высылает на экран, благодаря чему, мы можем посещать интернет, играть в любимые игры, работать с файлами и другое.

Теперь давайте представим на основе всех выводов, что же будет, если слабый процессор совместить с мощной видеокартой и запустить требовательное приложение (например, игру)?

1.Процессор: запустили игру ххх, я начинаю обрабатывать процессы

2.Видеокарта: вывожу на экран

3.Процессор: обрабатываю…

4.Видеокарта: вывожу на экран

5.Процессор: я не успеваю справляться с таким количеством информации!

6.Видеокарта: хорошо, я подожду

После чего, компьютер зависает.

Как мы видим на «наглядном примере», мощная видеокарта будет без проблем справляться с задачами, а вот слабенький процессор не сможет, из чего мы видим, что деньги, потраченную на хорошую видеокарту будут выброшены на ветер.

Что же будет, если совместить слабую видеокарту и мощный процессор?

1.Процессор: запустили игру ххх, я начинаю обрабатывать процессы

2.Видеокарта: вывожу на экран

3.Процессор: обрабатываю процессы

4.Видеокарта: я не успеваю выводить такое количество информации!

5.Процессор: хорошо, я подожду.

Можно заметить, что комплектующие просто поменялись ролями, не показав ничего нового.

Вывод: не один вариант не показал себя с лучшей стороны, ведь сборка должна быть сбалансирована, только так можно добиться желаемого результата и не пожалеть о выброшенных на ветер деньгах.

КОНТАКТНАЯ ИНФОРМАЦИЯ

ТЕЛЕФОНЫ:

+7 (4852) 68-38-40 Офис AMD76 в Ярославле.

+7 (4852) 92-91-25 Офис AMD76 в Ярославле.

+7 (4852) 68-28-59 Офис AMD76 в Ярославле.

+7 (4852) 68-28-74 Офис AMD76 в Ярославле.

+7 (4852) 33-89-91 Офис AMD76 в Ярославле.

+7 (4852) 68-24-41 Офис AMD76 в Ярославле.

+7 (4852) 68-24-81 Офис AMD76 в Ярославле.

+7 (495) 134-40-17 Офис AMD76 в Москве.

+7 (499) 648-37-74 Офис AMD76 в Москве.

+7 (812) 424-45-16 Офис AMD76 в Санкт Петербурге.

+7 (345) 265-80-14 Офис AMD76 в Екатеринбурге

✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩✩

P.S. Чтобы не потерять наши контакты, добавьте это объявление в закладки (CTRL + D)

amd76.ru

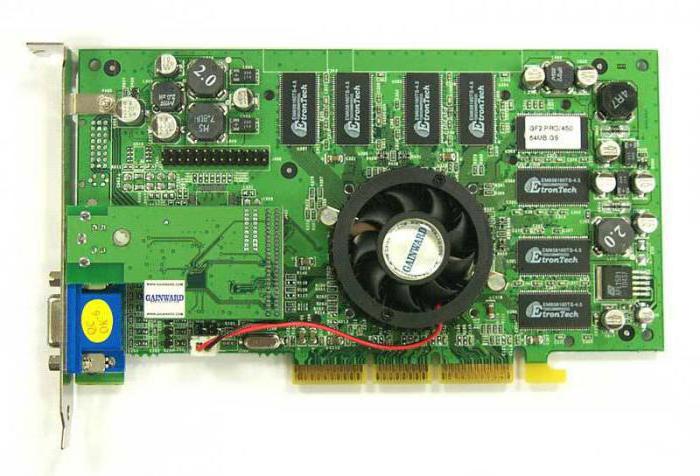

Самые необычные видеокарты за всю историю компьютеров — часть №1

Видеокарты давно уже стали неотъемлемой частью ПК: кому-то хватает интегрированных решений, а кто-то вынужден брать дискретные. И как раз на рынке дискретных видеокарт мы видим ситуацию, схожую с рынком смартфонов: производителей дискретных GPU всего два, AMD и Nvidia, они же производят референсные видеокарты, но при этом позволяют другим производителям изгаляться как угодно — любой дизайн платы, системы охлаждения, цепей питания и т.д. И с учетом того, что производителей больше десятка (Asus, MSI, KFA2, Sapphire, Gainward, Palit, Inno3D, EVGA, PowerColor, Gigabyte и т.д.) — конкуренция на рынке жесткая, и каждый старается придумать что-то свое, и зачастую получаются очень странные решения — о них и поговорим.

KFA2 GTX 460 Сама GTX 460 особого интереса не представляла — в свое время это был хороший середнячок. Однако KFA2 сумела привлечь внимание, сделав на торце видеокарты... 5 антенн: Вы думаете, что она интегрировала в видеокарту Wi-Fi-адаптер? Нет, до этого еще пока не дошло — эти антенны были созданы для беспроводной передачи картинки по стандарту WHDI, что позволяло передавать изображение в 1080р на расстояние до 30 метров на ресивер, который подключался к монитору или телевизору. Увы — на практике задержка сигнала была достаточно большой, так что для игр такая технология подходила слабовато. С учетом более высокой цены, чем у конкурентов (она была сравнима с GTX 470), особых продаж не было, и больше сей трюк уже никто не повторял.

MSI Radeon RX800 Из моего цикла статей по истории видеокарт вы помните (а может и сами знали), что в середине нулевых совершался переход от уже достаточно медленного интерфейса AGP к более быстрому PCI Express, который используется до сих пор. И на рынке из-за этого был раздрай: производители выпускали видеокарты на одних GPU с разными интерфейсами, аналогично как и производители материнских плат. И чтобы облегчить жизнь пользователям, компания MSI выпустила видеокарту... у которой с одной стороны был PCIe, а с другой — AGP:

Да-да, в зависимости от того, какой интерфейс есть на вашей материнской плате, вы можете вставлять видеокарту разными сторонами. Вы скажете — а что же с подключением мониторов? Все предусмотрено — интерфейсы DVI и VGA были вынесены на гибких проводах, так что в любом положении вы сможете подключить ТВ или монитор. К счастью, через пару лет все производители окончательно забросили AGP (за редким исключением), так что сейчас такая «дичь» хороша только как музейный экспонат.

ATI Radeon HD 2400 XT Bite-Taken-Out-Edition Как вы знаете, впервые SLI (объединение двух видеокарт) был применен ныне несуществующей компанией 3dfx. После ее покупки про эту технологию забыли, пока Nvidia в середине нулевых не решила ее возродить. Ее конкурент, ATi, разумеется не хотела остаться в стороне, и придумала свою, аналогичную SLI, технологию CrossFire. Казалось бы — ну придумала и ладно, внедрила бы ее в следующем поколении видеокарт. Но борьба за рынок была настолько жесткой, что «красные» взяли свою однослотовую видеокарту HD 2400... и удлинили ей текстолит, на котором разместили чип для работы с CrossFire и специальный коннектор: Выглядело такое решение, мягко сказать, странно, но своей цели ATi добились — CrossFire появился на рынке немногим позже SLI.

Galaxy GTX 680 В свое время (эдак лет 6 назад) GTX 680 была топовой одночиповой видеокартой современности, имела теплопакет свыше 200 Вт и требовала качественной системы охлаждения, занимавшей как минимум 2 слота. Однако малоизвестная компания Galaxy решила это исправить, и сделала однослотовую (то есть тонкую) GTX 680, да и еще с одной турбиной:

Увы — в продажу она так и не поступила, видно все же такая слабая система охлаждения не смогла справиться с горячим нравом флагмана.

HIS HD 5450 PCI-E x1 Edition Думаю, уже из названия понятно, какая «особенность» у этой видеокарты. Да, она для подключения использовала не PCIe x16, а x1 — слот, который обычно используется для подключения всяких аудио- и сетевых карт: Разумеется, скорости такого интерфейса не хватает для нормальной работы даже среднеуровневых видеокарт, но с учетом того, что HD 5450 является по сути «интернет-затычкой», то тут никаких проблем со скоростью нет.

Zotac GT 610 PCI Вы думали, что видеокарта на шине PCIe x1 — это предел извращений? Как бы не так — в 2011 году Zotac выпустила видеокарту на шине PCI — да-да, то самой, по которой два десятка лет назад подключались видеокарты, и которая в начале нулевых была вытеснена AGP: Абсолютно непонятно, зачем было выпускать такую видеокарту — пропускной способности PCI уже не хватало для не самых топовых 3dfx Voodoo, так что видеокарта 2011 года, пусть и самая слабая в линейке, не работала и на треть своих возможностей. Вы скажете — эта видеокарта нужна тем, у кого на материнской плате нет ни PCIe, ни AGP. Соглашусь, но это материнские платы конца 90ых-начала нулевых, и в лучшем случае там стоит Pentium 3 — сейчас его возможностей с трудом хватает даже для работы с документами, про интернет можно вообще забыть (обычный яндекс грузится с полминуты). Так что видеокарта, которая тянет GTA 5 на минимальных настройках с играбельным FPS, для ПК конца 90ых — жуткий перебор.

На этом мы заканчиваем первую часть статьи — разумеется, диковинных видеокарт еще очень много, и о них мы еще поговорим в дальнейшем.

www.iguides.ru

Две средние видеокарты вместо одной топовой / Видеокарты

Если судить по тестам современных адаптеров с двумя топовыми GPU (Radeon HD 7990, GeForce GTX 690) либо аналогичных конфигураций на базе отдельных карточек, технологии NVIDIA SLI и AMD CrossFireX в целом преодолели период мучительного взросления. Во многих играх двухпроцессорная система демонстрирует почти двукратное преимущество над таким же одиночным GPU, а в прочих вполне можно рассчитывать на бонус в пределах 50–70%. По крайней мере именно так обстоят дела среди игр категории ААА. Менее популярные игрушки обычно ускользают от внимания IT-изданий, и насколько хорошо их оптимизируют под SLI и CrossFireX, судить не беремся. Кроме того, в целом оптимистичную картину портят неудачи в отдельных играх, где либо производительность все-таки плохо масштабируется, либо разработчики питают пристрастие к одной из конкурирующих технологий, игнорируя другую.

В целом видеокарты с двумя GPU уже доказали право на существование на самом верху модельных рядов NVIDIA и AMD. Между тем разъемы SLI и CrossFireX теперь устанавливают даже на слабенькие по меркам геймеров адаптеры вроде Radeon HD 7770 и GeForce GTX 650 Ti BOOST. И каждый раз, когда в руки попадает очередная дешёвая видеокарта с поддержкой SLI или CrossFireX, возникает желание проверить — а как себя ведет пара таких малышек? С одной стороны, интерес чисто академический. Процессоры в геймерских видеокартах младшего эшелона по числу функциональных блоков представляют собой приблизительно половинки от топовых GPU. Вот вам еще один способ протестировать эффективность технологий, распараллеливающих вычислительную нагрузку между двумя GPU, — попытаться получить из двух половинок производительность, близкую к 100% результата топового процессора.

⇡#А оно нам надо?

Но попробуем найти в таком эксперименте и долю практической пользы. В теории тандем слабых видеокарт может стать более выгодной покупкой, чем один топовый адаптер. Старшими моделями AMD ныне являются бессменный Radeon HD 7970 и его разогнанный собрат HD 7970 GHz Edition. Среди продукции NVIDIA аналогичной парочкой можно считать GeForce GTX 680 и GTX 770. Ну а на роль их приблизительных половинок подходят Radeon HD 7790 и HD 7850 (для AMD), GTX 650 Ti BOOST и GTX 660 (для NVIDIA).

Сопоставим розничные цены этих моделей. Radeon HD 7790 со стандартным объемом памяти 1 Гбайт в московских интернет-магазинах можно купить за сумму от 4 100 рублей, HD 7850 2 Гбайт — за 4 800 рублей. В то же время Radeon HD 7970 продается по цене от 9 800 рублей, что лишь на 200 рублей дороже, чем пара HD 7850. Но вот HD 7970 GHz Edition уже трудно найти менее чем за 14 000 рублей.

Таким образом, CrossFireX на двух недорогих карточках AMD кажется сомнительной затеей хотя бы потому, что Radeon HD 7850, хоть и является половинкой HD 7970 по числу активных вычислительных блоков в GPU, существенно уступает последнему по тактовой частоте ядра и памяти. HD 7790 крутит процессор на частоте 1 ГГц, что отчасти компенсирует его более скромную конфигурацию по сравнению с HD 7850, но слабым местом HD 7790 является 128-битная шина памяти, а главное — её объем в 1 Гбайт, что обязательно скажется на производительности в тяжелых графических режимах (а именно для них мы и собираем такой тандем).

С точки зрения чистого эксперимента, не обремененного финансовыми соображениями, по конфигурации вычислительных блоков и частоты GPU совокупная мощь пары младших адаптеров AMD, способных работать в режиме CrossFireX (Radeon HD 7770 в расчет не берем, сборка из двух таких — это было бы совсем нелепо), немного не достает до флагманской отметки. Не будем забывать это обстоятельство, обсуждая результаты бенчмарков. Впрочем, в пользу пары HD 7850 играет 256-битная шина памяти — то, что NVIDIA не может предложить в этом ценовом сегменте.

| Основные компоненты | ||||

| GPU | Bonaire | Pitcairn Pro | Tahiti XT | Tahiti XT |

| Число транзисторов, млн | 2080 | 2800 | 4313 | 4313 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 1000/НД | 860/НД | 925/НД | 1000/1050 |

| Потоковые процессоры | 896 | 1024 | 2048 | 2048 |

| Текстурные блоки | 56 | 64 | 128 | 128 |

| ROP | 16 | 32 | 32 | 32 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 1024 | GDDR5, 2048 | GDDR5, 3072 | GDDR5, 3072 |

| Ширина шины памяти, бит | 128 | 256 | 384 | 384 |

| Тактовая частота памяти: реальная (эффективная), МГц | 1500 (6000) | 1200 (4800) | 1375 (5500) | 1500 (6000) |

| Интерфейс | PCI-Express 3.0 x16 | |||

| Вывод изображения | ||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 | 1 х DL DVI-I, 1 x HDMI 1.4a, 2 x Mini DisplayPort 1.2 | ||

| Макс. разрешение | VGA: 2048x1536, DVI: 2560x1600, HDMI: 4096х2160, DP: 4096х2160 | |||

| Типичная потребляемая мощность, Вт | 85 | 130 | 250 | 250+ |

| Средняя розничная цена, руб. | 4 100 | 4 800 | 9 800 | 14 000 |

Расклад цен среди видеокарт NVIDIA более благоприятен для сборки тандема из двух SKU небольшой производительности по сравнению с единственным мощным адаптером. GeForce GTX 650 Ti BOOST можно купить по цене начиная с 5 200 рублей, GeForce GTX 660 — за 5 800 рублей. Обе — с двумя гигабайтами набортной памяти. В то же время цены на GeForce GTX 680 и новоприбывший GTX 770, который является фактически обновленной версией GTX 680, начинаются с 13 000 рублей. По спецификациям GTX 650 Ti BOOST — самый младший графический ускоритель в ассортименте NVIDIA, поддерживающий SLI, — соответствует половинке GTX 680 (GTX 770) и даже располагает большим числом ROP, только работает на более низких частотах. GTX 660, при равной с GTX 650 Ti BOOST частоте, более плотно укомплектован ядрами CUDA и текстурными блоками. Обе модели обременяет относительно узкая 192-битная шина памяти.

| Основные компоненты | ||||

| GPU | GK106 | GK106 | GK104 | GK104 |

| Число транзисторов, млн | 2 540 | 2 540 | 3 540 | 3 540 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 980/1033 | 980/1033 | 1006/1058 | 1046/1085 |

| Потоковые процессоры | 768 | 960 | 1536 | 1536 |

| Текстурные блоки | 64 | 80 | 128 | 128 |

| ROP | 24 | 24 | 32 | 32 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 1024/2048 | GDDR5, 2048 | GDDR5, 2048 | GDDR5, 2048 |

| Ширина шины памяти, бит | 1502 (6008) | 1502 (6008) | 1502 (6008) | 1753 (7010) |

| Тактовая частота памяти: реальная (эффективная), МГц | 192 | 192 | 256 | 256 |

| Интерфейс | PCI-Express 3.0 x16 | |||

| Вывод изображения | ||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 | |||

| Макс. разрешение | - | - | - | - |

| Типичная потребляемая мощность, Вт | 140 | 140 | 195 | 230 |

| Средняя розничная цена, руб. | 5 200 | 5 800 | 13 000 | 13 000 |

⇡#Обманчивые гигабайты

Существенную проблему в любых конфигурациях с множественными GPU составляет объем памяти видеоадаптеров. Дело в том, что ОЗУ индивидуальных видеокарт не складывается в один большой массив. Вместо этого их содержимое дублируется. Таким образом, даже если совокупная вычислительная способность двух «обрезанных» GPU сопоставима с мощью единственного флагманского ядра, тандем располагает кадровым буфером в размере памяти одной карты. А тяжелые графические режимы, знаете ли, бывают чрезвычайно требовательными к объему памяти. Возьмем игры, известные своей жаждой дополнительных мегабайтов, которые мы используем в качестве бенчмарков. Metro 2033 при разрешении 2560х1440 с максимальными настройками оккупирует до 1,5 Гбайт RAM, Far Cry 3 — 1,7, а Crysis 3 — почти 2 Гбайт.

Ну а поскольку именно для таких игр и таких настроек мы и готовы прибегнуть к столь странному решению, как две относительно бюджетные карты в конфигурации SLI/CrossFireX, то видеоадаптеры с объемом RAM меньше 2 Гбайт нам подходят плохо. В этом плане немного больше повезло продуктам NVIDIA, поскольку даже GeForce GTX 650 Ti BOOST, согласно официальным спецификациям, поставляется в разновидности с 2 Гбайт памяти, не говоря уж о GTX 660. Кроме того, даже GTX 680 имеет не больше памяти (только для GTX 770 допустимы версии с 4 Гбайт GDDR 5).

Radeon HD 7790 задуман как адаптер исключительно с 1 Гбайт памяти, хотя партнеры AMD и производят модели с удвоенным кадровым буфером по собственной инициативе. Версия HD 7850 с 1 Гбайт памяти в связи с появлением HD 7790, напротив, официально прекратила существование. И главное, флагман-то, Radeon HD 7970 GHz Edition, комплектуется 3 Гбайт памяти — в полтора раза больше, чем у «середнячков» от AMD.

А вообще — прекратим гадать. Честное слово, производительность сборки двух геймерских видеокарт средней категории в SLI или CrossFireX трудно предсказать на основании голой теории. Нужно тестировать, и мы готовы к любым неожиданностям. Но прежде чем перейти к практической работе, обсудим еще один аспект нашего экзотического проекта — энергопотребление. Если исходить из типичной мощности адаптеров AMD, тандем HD 7850 не должен потреблять намного больше энергии, чем единственный Radeon HD 7970: 2х130 против 250 Вт соответственно. Сборка HD 7790 еще более экономична: это дважды по 85 Вт.

Сопоставимые по производительности карты NVIDIA более прожорливы. GeForce GTX 650 Ti BOOST и GTX 660 обладают одинаковым TDP — 140 Вт. В паре такие адаптеры намного превосходят GeForce GTX 680 (195 Вт) и даже GTX 770 (230 Вт).

⇡#Участники тестирования

Наша задача — собрать четыре двухпроцессорные конфигурации: на базе GeForce GTX 650 Ti BOOST и GeForce GTX 660, с одной стороны, и на Radeon HD 7790 и HD 7850 — с другой, а затем сравнить их производительность с производительностью мощных адаптеров на одном GPU.

- 2 x GeForce GTX 660 (980/6008 МГц, 2 Гбайт)

- 2 x GeForce GTX 650 Ti BOOST (980/6008 МГц, 2 Гбайт)

- 2 x Radeon HD 7850 (860/4800 МГц, 2 Гбайт)

- 2 x Radeon HD 7790 (1000/6000 МГц, 1 Гбайт)

А эти модели были выбраны в качестве конкурентов:

- AMD Radeon HD 7970 GHz Edition (1050/6000 МГц, 3 Гбайт)

- AMD Radeon HD 7970 (925/5500 МГц, 3 Гбайт)

- AMD Radeon HD 7950 (800/5000 МГц, 3 Гбайт)

- NVIDIA GeForce GTX 780 (863/6008 МГц, 3 Гбайт)

- NVIDIA GeForce GTX 770 (1046/7012 МГц, 2 Гбайт)

- NVIDIA GeForce GTX 680 (1006/6008 МГц, 2 Гбайт)

- NVIDIA GeForce GTX 670 (915/6008 МГц, 2 Гбайт)

⇡#Участники тестирования, подробно

Большинство из карт в многопроцессорных сборках предоставлены для тестирования партнерами NVIDIA, и отличаются от адаптеров референсного дизайна по тактовым частотам. Для чистоты исследования их пришлось привести к референсным спецификациям. Впрочем, проявляя уважение к труду производителей, ниже кратко перечислим достоинства каждого из участников тестирования.

- AMD Radeon HD 7850

- ASUS GeForce GTX 650 Ti BOOST DirectCU II OC (GTX650TIB-DC2OC-2GD5)

- ASUS Radeon HD 7790 DirectCU II OC (HD7790-DC2OC-1GD5)

- Gainward GeForce GTX 650 Ti BOOST 2GB Golden Sample (426018336-2876)

- GIGABYTE Radeon HD 7790 (GV-R779OC-1GD)

- MSI GeForce GTX 660 (N660 TF 2GD5/OC)

- ZOTAC GeForce GTX 660 (ZT-60901-10M)

ASUS GeForce GTX 650 Ti BOOST DirectCU II OC (GTX650TIB-DC2OC-2GD5)

ASUS прислала нам немного разогнанную версию GeForce GTX 650 Ti BOOST 2 Гбайт с базовой частотой ядра, увеличенной на 40 МГц по сравнению с референсной спецификацией. На плату установлена хорошо знакомая система охлаждения DirectCU II, которая включает тепловые трубки, напрямую контактирующие с кристаллом GPU. Отсюда и название DirectCU. Вот только, в отличие от более дорогих моделей, в кулере GTX 650 Ti BOOST теплотрубок всего две штуки, а не три.

Gainward GeForce GTX 650 Ti BOOST 2GB Golden Sample (426018336-2876)

Gainward также производит разогнанную версию GeForce GTX 650 Ti BOOST с тем отличием от реализации ASUS, что базовая частота GPU увеличена лишь на 26 МГц, зато есть прибавка в 100 МГц к результирующей частоте видеопамяти. Кулер видеокарты также принадлежит к открытому типу и содержит две медные теплотрубки.

MSI GeForce GTX 660 (N660 TF 2GD5/OC)

GeForce GTX 660 в исполнении MSI оснащен солидной системой охлаждения Twin Frozr III уже с тремя тепловыми трубками. Базовую тактовую частоту GPU производитель увеличил на 53 МГц относительно референсного значения, не коснувшись частоты видеопамяти.

ZOTAC GeForce GTX 660 (ZT-60901-10M)

Эта видеокарта уже засветилась на 3DNews в изначальном тестировании GeForce GTX 660. Имеется небольшой разгон графического процессора: с базовой частоты 980 до 993 МГц. Система охлаждения представляет собой конструкцию открытого типа с двумя тепловыми трубками и медной пластиной в основании.

AMD Radeon HD 7850

Это на сто процентов референсный видеоадаптер, предоставленный самой компанией AMD. Соответственно, частоты ядра и памяти с точностью до мегагерца соответствуют эталонным. В отличие от всех остальных участников тестирования, референсный Radeon HD 7850 оснащен турбинным кулером. Радиатор имеет медную подошву и пронизан тремя тепловыми трубками.

ASUS Radeon HD 7790 DirectCU II OC (HD7790-DC2OC-1GD5)

Оверклокерская версия Radeon HD 7790 от ASUS разогнана на 75 МГц по частоте процессора и на 400 МГц — по видеопамяти. В целом GPU производства AMD допускают больший заводской разгон по сравнению с аналогами от NVIDIA. Система охлаждения карты аналогична таковой у вышеописанного ASUS GeForce GTX 650 Ti BOOST DirectCU II OC. Это упрощенный вариант кулера DirectCU II с двумя тепловыми трубками, прижатыми к кристаллу GPU.

GIGABYTE Radeon HD 7790 (GV-R779OC-1GD)

Эта карточка по конфигурации похожа на Radeon HD 7990 от ASUS: GPU работает на такой же частоте 1075 МГц, а вот частота памяти оставлена на уровне стандартных 6000 МГц. Кулер представляет собой простейшую конструкцию, образованную цельным алюминиевым радиатором и большой вертушкой. Ни теплотрубками, ни дополнительной металлической подошвой радиатора адаптер GIGABYTE похвастаться не может.

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

3dnews.ru