Срок доставки товара в течении 1-3 дней !!!

|

|

История видеокарт начала нулевых: ATI vs Nvidia. Самая первая видеокарта

Видеокарта Википедия

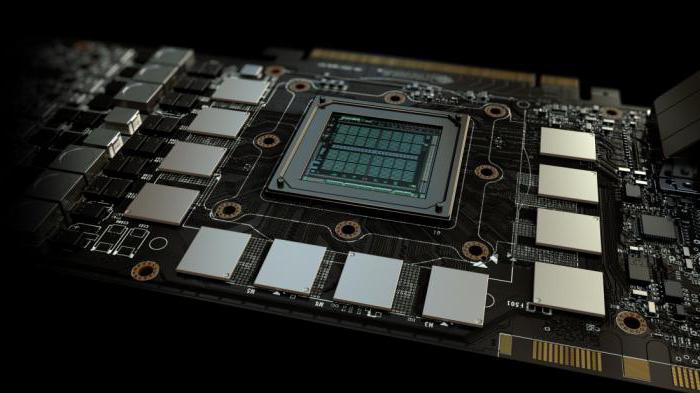

Nvidia GeForce 6600GT (производитель Gigabyte)Видеока́рта (также видеоада́птер, графический ада́птер, графи́ческая пла́та, графи́ческая ка́рта, графи́ческий ускори́тель) — устройство, преобразующее графический образ, хранящийся как содержимое памяти компьютера (или самого адаптера), в форму, пригодную для дальнейшего вывода на экран монитора. Первые мониторы, построенные на электронно-лучевых трубках, работали по телевизионному принципу сканирования экрана электронным лучом, и для отображения требовался видеосигнал, генерируемый видеокартой.

Однако эта базовая функция, оставаясь нужной и востребованной, ушла в тень, перестав определять уровень возможностей формирования изображения — качество видеосигнала (чёткость изображения) очень мало связано с ценой и техническим уровнем современной видеокарты. В первую очередь, сейчас под графическим адаптером понимают устройство с графическим процессором — графический ускоритель, который и занимается формированием самого графического образа. Современные видеокарты не ограничиваются простым выводом изображения, они имеют встроенный графический процессор, который может производить дополнительную обработку, снимая эту задачу с центрального процессора компьютера. Например, все современные видеокарты Nvidia и AMD (ATi) осуществляют рендеринг графического конвейера OpenGL и DirectX на аппаратном уровне. В последнее время также имеет место тенденция использовать вычислительные возможности графического процессора для решения неграфических задач.

Обычно видеокарта выполнена в виде печатной платы (плата расширения) и вставляется в разъём расширения, универсальный либо специализированный (AGP, PCI Express). Также широко распространены и встроенные (интегрированные) в системную плату видеокарты — как в виде отдельного чипа, так и в качестве составляющей части северного моста чипсета или ЦПУ; в этом случае устройство, строго говоря, не может быть названо видеокартой.

История создания[ | код]

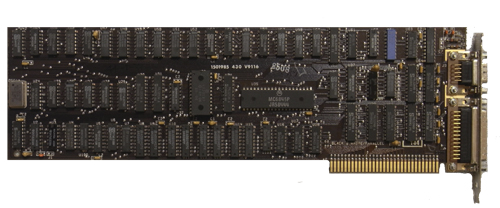

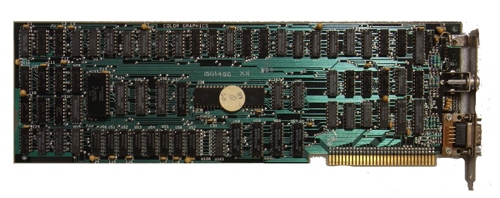

Одним из первых графических адаптеров для IBM PC стал MDA (Monochrome Display Adapter) в 1981 году. Он работал только в текстовом режиме с разрешением 80×25 символов (физически 720×350 точек) и поддерживал пять атрибутов текста: обычный, яркий, инверсный, подчёркнутый и мигающий. Никакой цветовой или графической информации он передавать не мог, и то, какого цвета будут буквы, определялось моделью использовавшегося монитора. Обычно они были белыми, янтарными или изумрудными на чёрном фоне. Фирма Hercules в 1982 году выпустила дальнейшее развитие адаптера MDA, видеоадаптер HGC (Hercules Graphics Controller — графический адаптер Геркулес), который имел

ru-wiki.ru

Представить современный компьютер без такого комплектующего как видеокарта просто невозможно. Что это такое, знает любой пользователь. Любители компьютерных игр и вовсе готовы отдать целое состояние за эту плату. Однако мало кто знает, с чего начиналась история развития видеокарт.А началось все в далеком 1981 году. Именно тогда был разработан первый видеоадаптер для компьютеров IBM, который был выполнен в виде отдельной платы. Назывался он MDA (Monochrome Display Adapter). Его основной задачей являлся вывод на экран текстовой информации. Графическими возможностями адаптер не обладал. Можно было лишь выбрать режим отображения символов: мигающий, обычный, подчеркнутый, инверсный и яркий.

Для научной работы этого вполне хватало, так как разрешение 720 на 350 пикселей давало четкий текст (80 на 25 символов). В том же году был выпущен адаптер CGA (Color Graphics Adapter). Он позволял работать уже с цветным изображением, так как символы могли быть представлены одним из шестнадцати оттенков (4 бита).

Дальнейшее развитие и совершенствование видеоадаптеров происходило за счет возрастания количества передаваемых цветов и увеличения разрешения. Переломным моментом в производстве стал 1987 год. В это время появляется видеоадаптер, положивший начало стандартам работы с графикой – VGA.

Адаптеры этого поколения имели разрешение 640*480 пикселей и могли поддерживать 256 цветов. Видеокарта 8514/А позволяла работать с разрешением 1024 на 768 точек и восьмибитовым цветом. Дальнейшим развитием стало появление стандарта SVGA, поддерживающего уже 65 536 цветов при разрешении 800 на 600 точек. Период с 1996 по 2001 год знаменателен борьбой за лидерство трех больших компаний в сфере производства видеокарт.

Первой была 3Dfx со своим Voodoo Graphics. Этот адаптер позволял получить разрешение 640*480 точек и цвет 16 бит, осуществлял поддержку DirectX и OpenGL, Однако значительной скоростью работы в этих режимах он не отличался.

Компанией ATI в середине 1996 года был выпущен адаптер 3D Rage II, который позволял использовать технологию Direct3D и поддержку DVD формата MPEG-2. Однако в режиме 3D данная модель не показывала выдающихся результатов.

Третьей компанией, занимающей лидирующие позиции до сегодняшнего дня, является nVIDIA. Первый её адаптер NV1 стал не самым удачным решением. А вот последовавший за ним NVIDIA Riva 128 был очень хорошим вариантом.

Начиная с 1999 года, обостряется конкуренция между ведущими компаниями. Появляются новые технологические решения. Так, в 2001 году свет увидел чип NV20 от nVIDIA, прекрасно поддерживающий шейдерную технологию стандарта DirectX 8.0. Компания ATI в ответ производит адаптер Radeon R200. У него была реализована поддержка нового формата шейдеров версии 1.4, а также способность чипа самостоятельно создавать сложные модели объектов.

Одной из последних значимых разработок в сфере производства видеокарт является GeForce GTX 680. Он позволяет выводить картинку на 4 монитора.

accross.su

История видеокарт начала нулевых: ATI vs Nvidia

Предыдущую статью мы закончили на банкротстве 3dfx и поднятии ATI. Теперь же мы поговорим о том, как боролись друг с другом Nvidia и ATI в начале 21 века.Nvidia NV15 — как NV10, только лучше NV15, вышедший в 2000 году, представлял собой улучшенный чип NV10: из-за перевода на более тонкий техпроцесс, 180 нм, получилось поднять частоту почти вдвое, до 200 МГц, а количество транзисторов до 25 млн. Про объединенную шейдерную архитектуру тогда еще никто не слышал, и чип включал в себя 4 пиксельных конвейера и 8 текстурных модулей (по 2 на конвейер). Также никуда не делась поддержка T&L, она была доработана, что в итоге привело к повышению производительности на 30% при отрисовке теней и геометрии. С поддержкой API почти ничего нового — Direct3D все также был 7, а OpenGL поддерживался чуть более новый — вплоть до 1.4.

Первой видеокартой на чипе стала GeForce 2 GTS (GigaTexel Shading), которая имела 32-64 МБ SGRAM памяти с частотой в 333 МГц, подключенной по 128-битной шине. Очень странно, что Nvidia в 2000 году решила использовать достаточно старую уже память, да и еще подключенную по узкой шине — именно память оказалась узким местом видеокарты, но все еще ее производительность была в среднем на 40% выше, чем у предшественницы — GeForce 256.

Пожалуй, именно с линейки GeForce 2 начался дикий зоопарк видеокарт от Nvidia: после выхода GTS была представлена уже ставшей стандартной урезанная видеокарта MX: она зачастую имела 64-битную шину, сниженные частоты ядра и памяти — в общем, low-сегмент. Дальше Nvidia представила топ — GeForce 2 Ultra (250 МГц чип, 460 МГц память). Через полгода появилась видеокарта Pro, которая отличалась от GTS лишь слегка разогнанной памятью — до 400 МГц. И еще через полгода появилась версия Ti (к слову — единственная, дожившая до наших дней) — она имела частоты чипа как у Ultra, а памяти — как у Pro. В итоге на рынке было одно явно слабое решение и четыре видеокарты, которые отличались от силы на 15% — крайне странное решение.

К слову, именно в линейке GeForce 2 Nvidia обращает внимание на рынок мобильных дискретных видеокарт — так появляется линейка Go, которая основана на чипе NV11. Он представляет из себя урезанный чип NV15 с тепловыделением всего 3 Вт — как раз для ноутбуков. Также не забыта линейка Quadro — для нее был разработан чип NV15GL.

ATI RV100 и R200 Как мы помним, в 2000 году ATI представила отличный чип R100, который позволил им встать на одну ступеньку с Nvidia. Разумеется, «красные» не стали останавливаться на достигнутом — сначала был выпущен чип RV200, который представлял собой R100, но на более тонком техпроцессе — 150 нм против 180, что позволило серьезно поднять частоты. Также видеокарты на этом чипе (Radeon 7500) стали комплектоваться уже 128 МБ памяти и конкурировали с GeForce 2 Ti.

Тогда же, увидев, что Nvidia делает мобильные решения, ATI решила заняться тем же и выпустила чип RV100, который является серьезно урезанным R100 — он и положил начало линейке Mobility Radeon.

Но нам интереснее посмотреть на новые решения — им стал чип R200, вышедший, к слову, одновременно с RV200 и тем самым вызвав путаницу. Однако новым его можно было назвать с натяжкой: кроме перевода на 150 нм техпроцесс, ATI добавила лишь несколько программных «фишек»: к примеру, Smoothvision — программируемое полноэкранное сглаживание, Smartshader — поддержка шейдеров версии 1.4.

С технической точки зрения чип имел 60 млн транзисторов с частотой до 275 МГц и схожую с NV15 структуру — 4 пиксельных конвейера и 8 текстурных модулей. Памяти было 64 МБ SDRAM, но позже появились решения и со 128 МБ. А вот с производительностью были все те же проблемы, что и сейчас: изначально видеокарта Radeon 8500 из-за кривых драйверов проигрывала своему прямому конкуренту, GeForce 3 Ti (о нем поговорим ниже), а потом, после «допиливания» драйверов — стала чуть его лучше при чуть более низкой цене. В общем, ситуация с годами не меняется, и AMD сейчас грешит тем же.

Nvidia NV20 — множество нововведений К 2001 году стало понятно, что выжимать из NV15 больше нечего. Поэтому Nvidia сделала новый чип, NV20 (который, при этом, не всегда был лучше NV15), где основной упор был сделан на память: как я уже писал выше, в линейке GeForce 2 как раз с ней была проблема — производительность видеокарт упиралась в маленькую пропускную способность памяти при выводе стандартного уже 32-битного цвета. В линейке GeForce 2 недостаток был исправлен, причем достаточно красиво — если раньше шина памяти была имела один 128-битный контроллер, то теперь стало 4 32-битных — эта технология называлась LMA (Lightspeed Memory Architecture). Плюсуя сюда поддержку новой памяти, SDRAM, можно было смело говорить, что проблема с низкой пропускной способностью была полностью решена.

Также было добавлено много других полезных вещей: так, появилась поддержка движка nFinite FX Engine, то есть видеокарты GeForce 3 поддерживали пиксельные и вершинные шейдеры, что позволило качественно улучшить спецэффекты; чип NV20 содержал 4 пиксельных конвейера, 1 вершинный и 8 текстурных блоков. Второй важной особенностью стала поддержка MSAA-сглаживания: как я уже писал раньше, оно давало схожий с SSAA эффект, но гораздо меньше нагружало видеокарту. Ну и третья важная особенность — видеокарты линейки GeForce 3 стали первыми с поддержкой Direct3D 8.

Видеокарт было выпущенно 3, причем Nvidia решила отказаться от кучи названий, что здорово. Зато появилась другая путаница: видеокарта GeForce 3 Ti 200, если смотреть на линейку GeForce 2, должна быть быстрее обычной GeForce 3. А вот на деле было наоборот: у Ti частоты чипа и памяти были 175/200 МГц, а у обычной — 200/230. Самой мощной была Ti 500 — она работала на частотах до 240/250 МГц и тем самым напрямую конкурировала с Radeon 8500. Но при этом из-за того, что у GeForce 2 Ultra частоты были выше, чем у GeForce 3, последняя зачастую оказывалась быстрее в играх, где нет сглаживания, из-за больших частот ядра. Но вот с сглаживанием старая видеокарта работала гораздо хуже, так что в новых играх GeForce 3 была быстрее.

Nvidia NV25 — перегоним ATI Выпуская чип NV20 Nvidia твердо думали, что они займут нишу топовых моделей. Но когда оказалось, что ATI Radeon 8500 оказалась в итоге лучше Ti 500, да и еще дешевле — Nvidia поняли, что нужно что-то менять, и быстренько выкатили новый чип NV25 в конце 2001, который был лишь слегка доработанным NV20: появилась поддержка вторых поколений LMA и nFinite FX, чип научился проводить аппаратное сглаживание.

С технической точки зрения чип был построен на том же 150 нм техпроцессе, имел 4 блока рендеринга, 8 текстурных блоков и 2 блока T&L. Объем памяти у видеокарт GeForce 4 достигал 128 МБ, а частоты чипов не поменялись со времен GeForce 3. В итоге младшая видеокарта GeForce 4 Ti 4200 таки обогнала Radeon 8500, так что свою цель Nvidia достигла.

В начале 2002 года Nvidia выпустила чип NV28. Единственное отличие от NV25 заключалось в том, что видеокарты теперь подключались по интерфейсу AGP x8.

Но самой интересной линейкой следовало назвать не Ti, а MX. Как мы помним, это были урезанные версии видеокарт, и линейка GeForce 4 MX исключением не стала: чип NV17, на которых эти видеокарты базировались, имел ровно вдвое меньше вычислительных блоков, чем NV25. Объем памяти составлял 64 МБ, а единственное серьезное урезание в сравнении с Ti было отсутствие поддержки пиксельных шейдеров. Также не было поддержки nFinite FX, что ограничивало версию Direct3D до 7ой, но все еще из-за неплохой производительности за небольшие деньги эти видеокарты очень охотно разбирали, ибо они не только справлялись с офисными задачами, но и позволяли комфортно играть в современные на тот момент игры. Увы — недолго музыка играла: уже буквально через пару лет все игры требовали поддержки пиксельных шейдеров, так что поиграть в них на 4 MX было уже нельзя.

ATI R300 — новый флагман С программной точки зрения в R300 не было добавлено почти ничего нового: только поддержка улучшенных методов сглаживания, третья версия HyperZ да новый алгоритм анизотропной фильтрации текстур.

Но вот с аппаратной точки зрения это был серьезный прорыв, причем этим же принципом AMD пользуется до сих пор. Он очень прост: не можешь задавить конкурента технологиями — задави количеством. Посудите сами — в 2002 году чип R300 имел аж 110 млн транзисторов: почти вдвое, чем у NV25. Пиксельных конвейеров стало 8 — вдвое больше, чем у R200. Шина памяти стала 256-битной, а принцип был схож с LMA: 4 контроллера, но не по 32, а по 64 бита, а самой памяти было 128 МБ. Частоты были задраны выше некуда — 325 МГц у чипа в случае с Radeon 9700 Pro. В общем — это был настоящий монстр, который с легкостью превосходил своего конкурента, GeForce 4 Ti 4600, на 15-20%. В итоге этот чип можно безоговорочно считать лучшим в 2002 году.

Nvidia NV30 — попытка выбиться в лидеры не удалась Видеокарты GeForce 4 вышли не то чтобы хорошими, но явно неплохими. Хотя то, что особой популярностью пользовалась именно урезанная серия MX, говорит о том, что лидерство на рынке Nvidia на тот момент упустила.

В чипе NV30 2003 года упор был сделан именно на введение новых технологий: так, это был первый чип с поддержкой Shader Model 2.0, количество пиксельных конвейеров выросло до 8, были улучшены алгоритмы сглаживания и фильтрации текстур. К тому же некоторые видеокарты на этом чипе стали поддерживать новейший по тем временам интерфейс PCI Express 1.0, то есть в теории видеокарту 2003-2004 года можно поставить в современный ПК и она заработает. Также видеокарты GeForce FX на базе этого чипа научились работать с DDR2, что в теории должно было решить проблему с медленной памятью. Однако, увы, не решило — всему виной узкая шина памяти, всего 128 бит. Вторая проблема — чип NV30 очень медленно проводил рассчеты с одинарной точностью. Nvidia призывала разработчиков игр использовать половинную, но это ни к чему не привело.

В результате с играми все было не очень хорошо — даже Valve решили не работать с шейдерами второй версии, и Half-Life 2 на GeForce FX работал на первой. Однако все же плюсы у этого чипа были — к примеру, он отлично работал с тенями, так что в Doom 3, где их много, производительность была не хуже конкурентов от ATI. Проблему с памятью Nvidia решила в чипе NV35, где единственное улучшение — это как раз поддержка 256-битной шины, так что видеокарта FX 5900 на этом чипе оказалась на уровне топа от ATI, Radeon 9800 Pro. Но, увы, вышли видеокарты на NV35 позже решений от ATI, да и всего через полгода появился новый, действительно классный чип NV40.

Но о нем и крайне популярной линейке видеокарт GeForce 6000, а также о возрождении SLI и объединении ATI c AMD, поговорим уже в следующей части статьи.

www.iguides.ru

Характеристики видеокарты

Видеокарта – один из основных компонентов компьютера. Она отвечает за обработку графики и вывод изображения на экран монитора. Поэтому при выборе видеокарты очень важно обращать внимание на ее характеристики. Поскольку именно от характеристик видеокарты зависит, сможет ли она удовлетворить все требования пользователя.

В данной статье мы рассмотрим основные характеристики современных видеокарт. А также расскажем о том, как использовать эту информацию для того чтобы не ошибиться при выборе видеокарты.

Графический процессор (чип)

Первое на что следует обратить внимание при выборе видеокарты это графический процессор. От модели графического процессора зависят все остальные характеристики видеокарты.

Компания NVIDIA называет свои графические процессоры следующим образом: GeForce GTX 123.

Где 123 – это числовое обозначение, которое указывает на положение данного графического чипа в линейке видеокарт от NVIDIA. Первая цифра (1) указывает на поколение видеокарты. На данный момент последним поколением видеокарт является GeForce GTX 7xx. Вторая (2) и третья (3) цифры указывают на положение данного графического чипа в линейке видеокарт текущего поколения. Чем больше цифры 2 и 3 тем более высокого уровня данная видеокарта. Таким образом, видеокарта GeForce GTX 780 производительней GeForce GTX 770, а GeForce GTX 770 мощнее, чем GeForce GTX 760.

Компания AMD использует очень похожую схему обозначения своих графических чипов. Чипы от компании AMD обозначаются следующим образом: Radeon HD1234. Где цифра 1 указывает на поколение графического чипа, а цифры 2, 3 и 4 указывают на положение чипа внутри текущего поколения.

Теперь рассмотрим реальные характеристики видеокарт.

Тактовая частота графического процессора

Тактовая частота графического процессора это одна из важнейших характеристик видеокарты. Как правило, тактовая частота графического процессора видеокарты указывается в мегагерцах (МГц), реже используются гигагерцы (ГГц). Чем выше тактовая частота, тем быстрее процессор обрабатывает информацию, а это непосредственно влияет на быстродействие видеокарты.

Необходимо отметить, что один и тот же графический процессор в различных видеокартах может работать на различных частотах. Так случается, потому что в некоторых моделях видеокарт используется заводской разгон.

Объем видеопамяти

Объем видеопамяти – это характеристика, на которую многие не опытные пользователи обращают слишком много внимания. Это происходит из-за не слишком честной рекламы, в которой делается упор в первую очередь на простую и всем понятную идею, о том, что чем больше памяти, тем быстрее работает устройство.

На самом деле, все совсем не так и на объем памяти в принципе можно даже не обращать внимания. Меньше чем нужно, для данной модели видеокарты, производитель не установит. А вот больше – устанавливают с удовольствием. Опять же, это делается для того чтобы привлечь внимание не опытных пользователей.

С другой стороны, если бюджет, выделенный на покупку видеокарты, позволяет, то можно спокойно покупать модель с большим объемом памяти. В любом случае, это точно не навредит.

Тип памяти

Тип памяти уже более весомая характеристика видеокарты. Сейчас в продаже можно найти видеокарты с такими типами видеопамяти: DDR3, GDDR3, GDDR4 и GDDR5. Что нужно знать о типах видеопамяти, так это то, что GDDR3 лучше, чем DDR3, GDDR4 лучше, чем GDDR3, а GDDR5 соответственно лучше, чем GDDR4.

На данный момент, в большинство современных видеокарт устанавливается память типа GDDR3 или GDDR5. Память GDDR3 используется в дешевых видеокартах, тогда как GDDR5 в видеокартах среднего и высокого уровня.

Частота видеопамяти памяти

Частота видеопамяти – это характеристика, которая влияет на скорость обмена данными между процессором и памятью. Естественно скорость обмена данными между процессором и памятью влияет на общую производительность устройства. Поэтому чем выше частота видеопамяти, тем лучше.

Разрядность шины памяти

Разрядность шины памяти – это еще одна характеристика, влияющая на скорость обмена данными между процессором и памятью. Сейчас в продаже можно найти видеокарты с разрядностью шины памяти: 32, 64, 128, 196, 256, 384, 512 и 768 бит.

Видеокарты с разрядностью шины памяти меньше 128 бит – это дешевые устройства для офисного использования. Видеокарты среднего уровня и выше оснащаются шиной с разрядностью от 128 бит.

Разъемы для подключения к монитору

Немаловажным параметром являются разъемы на задней панели видеокарты, предназначенные для подключения к монитору. В большинстве случаев для подключения к монитору используется разъем DVI. Такой тип подключения поддерживают большинство видеокарт и мониторов.

Но, если вы планируете подключать к компьютеру телевизор с помощью порта HDMI или проектор с помощью порта VGA, то необходимо убедиться, что выбранная видеокарта оснащена нужным вам портом.

comp-security.net

15 лет истории видеокарт в картинках

Начиная с середины 90-х, индустрия компьютерной 3D-графики, и, в частности, видеоадаптеров совершила гигантский скачок. Производительность решений для профессионалов, домашних пользователей и энтузиастов выросла в сотни раз. Мы получили доступ к развлечениям и компьютерным играм, о которых раньше можно было только мечтать. Наши зарубежные коллеги решили проследить историю устройств, без которых сегодня представить трехмерную графику на ПК практически невозможно. Речь, конечно же, идет о видеоадаптерах. 1995 год, модель S3 ViRGE, частота процессора: 66 МГц, DirectX 6, PCI: 1995 год, модель ATI Rage II, частота процессора: 25 – 60 МГц, частота памяти: 66 - 83 МГц, DirectX 5, PCI: 1996 год, модель 3dfx Voodoo1, частота процессора: 50 МГц, частота памяти: 50 МГц, DirectX 3, PCI: 1997 год, модель Riva 128 (NVIDIA NV3), частота процессора: 100 МГц, частота памяти: 100 МГц, DirectX 5, PCI/AGP: 1997 год, модель 3dfx Voodoo Rush, частота процессора: 50 МГц, частота памяти: 50 МГц, DirectX 5, PCI/AGP: 1998 год, модель Mystique G200, частота процессора: 85 МГц, частота памяти: 112 МГц, DirectX 6, AGP: 1998 год, модель Matrox G250, частота процессора: 85 МГц, частота памяти: 112 МГц, DirectX 6, AGP: 1998 год, модель 3dfx Voodoo2, частота процессора: 90 МГц, частота памяти: 90 МГц, DirectX 3, PCI/AGP: 1998 год, модель Riva TNT (NVIDIA NV4), частота процессора: 90 МГц, частота памяти: 110 МГц, DirectX 6, PCI/AGP: 1999 год, модель ATI Rage Fury MAXX, частота процессора: 125 МГц, частота памяти: 143 МГц, DirectX 7, AGP: 2000 год, модель Matrox G450, частота процессора: 125 МГц, частота памяти: 166 МГц, DirectX 6, PCI/AGP: 2000 год, модель 3dfx Voodoo5 5500, частота процессора: 166 МГц, частота памяти: 166 МГц, DirectX 6, PCI/AGP: 2000 год, модель NVIDIA GeForce 2 GTS, частота процессора: 200 МГц, частота памяти: 333 МГц, DirectX 7, AGP: 2001 год, модель ATI Radeon 7500, частота процессора: 290 МГц, частота памяти: 230 МГц, DirectX 7, PCI/AGP: 2003 год, модель NVIDIA GeForce 4 Ti4800, частота процессора: 300 МГц, частота памяти: 650 МГц, DirectX 8, AGP: 2004 год, модель ATI Radeon X850 XT Platinum, частота процессора: 540 МГц, частота памяти: 590 МГц, DirectX 9, AGP/PCI-E: 2004 год, модель XG41 Volari V5, частота процессора: 350 МГц, частота памяти: 350 МГц, DirectX 9, AGP: 2004 год, модель NVIDIA GeForce 6800 Ultra Extreme, частота процессора: 450 МГц, частота памяти: 1200 МГц, DirectX 9, PCI-E: 2005 год, модель NVIDIA GeForce 7800 GTX, частота процессора: 430 МГц, частота памяти: 1200 МГц, DirectX 9, PCI-E: 2006 год, модель ATI Radeon X1950 XTX, частота процессора: 650 МГц, частота памяти: 1000 МГц, DirectX 9, PCI-E: 2006 год, модель NVIDIA GeForce 7950 GX2, частота процессора: 500 МГц, частота памяти: 1200 МГц, DirectX 9, PCI-E: 2006 год, модель NVIDIA GeForce 8800 GTX, частота процессора: 575 МГц, частота памяти: 1800 МГц, DirectX 10, PCI-E: 2007 год, модель ATI Radeon HD 3870 X2, частота процессора: 825 МГц, частота памяти: 900 МГц, DirectX 10.1, PCI-E: 2008 год, модель ATI Radeon HD 4850 X2, частота процессора: 650 МГц, частота памяти: 993 МГц, DirectX 10.1, PCI-E: 2009 год, модель NVIDIA GeForce GTX 275, частота процессора: 633 МГц, частота памяти: 2268 МГц, DirectX 10, PCI-E: 2009 год, модель NVIDIA GeForce GTX 295, частота процессора: 576 МГц, частота памяти: 1998 МГц, DirectX 10, PCI-E: Материалы по теме: - XFX Radeon HD 4890 - первое тестирование нового GPU AMD RV790; - Великое противостояние продолжается. Обзор NVIDIA GeForce GTX 275; - Обзор ASUS EAh5850 Matrix. Добро пожаловать в матрицу!.3dnews.ru

Самые необычные видеокарты за всю историю компьютеров — часть №4

Да-да, это уже четвертая статья в цикле. Признаюсь — когда я его начинал, то думал, что материала хватит на две, максимум три статьи. Однако желание производителей произвести продукт, при виде которого люди скажут «вау», настолько велико, что мы продолжаем этот цикл, ибо материала хватило на еще одну статью (а может, и не одну).

Colorful GeForce GTX 680 iGame С виду в названии нет ничего странного, да и компания не особо известная. Но, как мы помним, обычно именно они нас радуют самыми необычными продуктами, и тут так и есть — это GTX 680 с тепловыделением в 200 Вт и... пассивным охлаждением: Мы привыкли видеть, что бюджетные «интернет-затычки» типа GT 1030 зачастую охлаждаются пассивно, ибо их тепловыделение не превышает 25-30 Вт. Но чтобы охладить такого монстра Colorful пришлось задействовать аж два гигантских радиатора по обе стороны печатной платы, и то, для того, чтобы держать температуры в норме, приходилось использовать ее в хорошо вентилируемом корпусе с несколькими дополнительными вентиляторами, так что те, кто брал ее ради тишины, вряд ли ее получал. Но в любом случае это хороший пример того, что даже топовую видеокарту можно охладить пассивно.

ASUS EAX1300PRO Silent Мы все привыкли, что чип на видеокарте располагается на лицевой стороне. И, как вы уже поняли, нашлась компания, причем не какой-то нонейм, а ASUS, которая расположила чип... на задней стороне платы: Зачем? По их задумке, эта видеокарта должна была охлаждаться пассивно (ибо это «затычка» ATi X1300), а для лучшего охлаждения используется обдув вентилятором от процессорного кулера. Идея, конечно, хорошая, только ASUS не учли одно — такой воздух уже будет теплым, так что такое «охлаждение» вполне себе стало нагревом, и от такой идеи быстро отказались.

MSI Geminium-Go Это даже не видеокарта — это шасси, для установки двух MXM-видеокарт: Зачем? Ответ прост — ради удобства: посудите сами, это шасси в каком-то смысле вечное: изначально на выставке CES 2006 оно было представлено с двумя мобильными GT 6600. Однако сейчас можно без труда найти MXM-видеокарты и 900ой линейки — то есть как только вам перестает хватать графической производительности, вы просто убираете старые видеокарты и вставляете в шасси новые. Такой апгрейд стоит существенно дешевле покупки новой видеокарты, да и любые проблемы с GPU (отвал чипа и т.д.) опять же решаются обычной заменой одной из видеокарт, а не дорогостоящим ремонтом.

Однако в массы такое шасси не пошло. Почему? Гадать можно долго, но, скорее всего, это банально было невыгодно производителям, так как серьезно снизило бы продажи новых видеокарт.

S3 Graphics Chrome 540 GTX В предыдущей статье я писал, что в середине нулевых компания S3, которую все помнили по 90-ым годам, когда она выпустила первую популярную 3D-видеокарту, решила снова выйти на рынок видеокарт с линейкой Chrome, однако провалилась. Однако на этом ее история не закончилась — в 2009 году, то есть не так давно, компания снова вышла на рынок видеокарт, и самое топовое из представленных решений называлось Chrome 540 GTX: Видеокарта имела 256 МБ памяти и поддержку DirectX 10, и позиционировалась как конкурент Nvidia GF 8600 или ATi Radeon HD 4350 — она выдавала схожий с ними результат в 3Dmark06, а стоила даже дешевле. Но, увы, опять не взлетела — конечно, паритет с крупными игроками на рынке в синтетических тестах это хорошо, но вот в играх опять же было все как бог на душу положит: часть игр, особенно старых, шла неплохо, но вот новые тайлы с поддержкой DX10 зачастую артефачили и тормозили. Допилить драйвера S3 так и не смогла, так что очередная линейка видеокарт от них провалилась.

ATi Radeon 7000 PCI Dual Видеокарта вышла в 2014-2015 годах, и купить ее можно было на AliExpress (ну еще бы, где же еще можно найти такую дичь). Думаете, это видеокарта с двумя чипами из линейки AMD HD 7000? Неа, не угадали — чипа тут действительно два, только это... RV100, вышедший в 2000 году. И чтобы добить тех, кто случайно натыкался на этот продукт в интернете — в нем четыре HDMI, а для подключения используется шина PCI: Стоп-стоп-стоп, скажете вы, какие два чипа 2000 года от «красных» на одной плате, да и еще поддержка HDMI, когда сам стандарт HDMI появился только в 2002 году, а CrossFire еще двумя годами позже? Все просто — чипы и не умели работать вместе, для их работы использовался разветвитель шины PCI, и в GPU-Z отображается только один чип. А что касается HDMI — он фейковый: на самом деле это VGA, распаянный под HDMI, и для подключения мониторов используется кабель HDMI - D-SUB. Причем распайка и кабеля такие, что они работают только с данной видеокартой: при подключении или к видеокарте, или к кабелям, другой техники, вы, скорее всего, ее сломаете.

Возникает вопрос — зачем такая дичь? Все просто — для тех, у кого есть старый ПК, у которого нет AGP или PCIe, но при этом нужно подключить четыре монитора (к примеру, промышленный ПК). Для них эта видеокарта — просто находка, тем более что стоит она на Ali сущие копейки.

HIS X1600 Pro Dual В самой первой части статьи я писал про видеокарту MSI X800, которая имела с двух сторон платы разные интерфейсы — AGP и PCIe. В середине нулевых, когда как раз совершался переход с первого интерфейса на второй, это имело смысл. В видеокарте от MSI разработчики решили не заморачиваться с разъемами для подключения мониторов — просто сделали их на гибком шлейфе. Но вот компания HIS пошла дальше, и на Computex 2006 представила видеокарту X1600, у которой не только с двух сторон были разные интерфейсы, но и видеовыходы также были с разных сторон и дублировались:

Выглядело это, конечно, очень странно, но было гораздо удобнее гибких кабелей. К счастью, после окончательного перехода на PCIe больше такого никто не выпускал.

PowerColor Devil 13 Dual Core R9 290X Казалось бы — что в этой видеокарте странного? Ну да, двухчиповый монстр, с массивной системой охлаждения, занимает три слота, весит под 2 кг — это вполне обычно для топовых видеокарт современности. Но все становится понятно, если посмотреть на торец — там... четыре коннектора 8 pin для питания: Чтобы было понятнее — через слот PCIe может передаваться до 75 Вт, по одному 8 pin — до 150. То есть в сумме получается аж 675 Вт — зачастую это больше потребления всего топового современного ПК, а тут столько нужно одной видеокарте. При этом рекомендуемые производителем блоки питания в 1 КВт это далеко не роскошь — это, пожалуй, необходимость для нормальной работы такой графики. Воистину — это самая «жрущая» флагманская видеокарта современности.

На этом мы пока что заканчиваем цикл самых необычных видеокарт — да, «странные» видеокарты у меня подошли к концу. Но, в будущем, если я найду материала на еще одну статью, то, конечно, цикл продолжится.

www.iguides.ru