Обзор видеокарт nvidia: Сравнение видеокарт GeForce RTX и GTX

Содержание

Видеокарты | Лаборатория | Overclockers.ru

Все статьи

ASUS

Видеокарты

Процессоры

Материнские платы

Охлаждение

Периферия

Программное обеспечение

Игры

FAQ

Память

Блоки питания

Корпуса

Всё про…

Накопители HDD

Мониторы

Институт оверклокинга

Сетевое оборудование

Накопители SSD

Мобильные устройства

Смартфоны

Планшеты

Ноутбуки

Руководства

События

Сайт

ATI

параметры

Radeon 8500-9250

Radeon 9500-9600-9800SE

Radeon 9700-9800

Radeon X300-X600

Radeon X700

Radeon X800-X850

Radeon X1300

Radeon X1600

Radeon X1800

Radeon X1900

Radeon HD 2400

Radeon HD 2600

Radeon HD 2900

Radeon HD 3800

Radeon HD 4800

Radeon HD 4600

Radeon HD 4700

Radeon HD 5800

Radeon HD 5700

Radeon HD 5900

Radeon HD 5600

Radeon HD 5400

Radeon HD 3200

Radeon HD 6800

Radeon HD 6900

Radeon HD 6700

Radeon HD 6600

Radeon HD 7900

Radeon HD 7700

Radeon HD 7800

Radeon R9 280X

Radeon R9 270X

Radeon R7 260X

Radeon R9 290/290X

Radeon R9 390X

Radeon R7 370

Radeon R9 390

Radeon R9 Fury X

Radeon R9 380

Radeon R9 Fury

Radeon R7 360

Radeon R9 Nano

Radeon R9 380X

Radeon RX 480

Radeon RX 470

Radeon RX 460

Radeon RX 580

Radeon RX 550

Radeon RX 570

Radeon RX Vega 64

Radeon RX 560

Radeon RX Vega 56

Radeon RX 6800

Radeon RX 6700

Radeon RX 6600

NVIDIA

параметры

GeForce MX

GeForce 3

GeForce 4

GeForce FX

GeForce 6

GeForce 7

GeForce 8

GeForce 9

GeForce GTX

GeForce GTS

GeForce GT

GeForce GTX 680

GeForce GTX 690

GeForce 600

GeForce 700

GeForce 980

GeForce 970

GeForce 960

GeForce GTX Titan X

GeForce 980 Ti

GeForce 950

GeForce GTX 1080

GeForce GTX 1070

GeForce GTX 1060

GeForce GTX 1050 Ti

GeForce GTX 1050

Titan X (Pascal)

GeForce GTX 1080 Ti

GeForce GT 1030

GeForce GTX 1070 Ti

GeForce RTX 2080 Ti

GeForce RTX 2080

GeForce RTX 2070

GeForce RTX 2060

GeForce GTX 1660 Ti

GeForce GTX 1660

GeForce RTX 3080

GeForce RTX 3090

GeForce RTX 3070

GeForce RTX 3060 Ti

GeForce RTX 3060

GeForce RTX 3080 Ti

GeForce RTX 3070 Ti

GeForce RTX 4090

GeForce RTX 4080

По производителю

параметры

Abit

Albatron

ASUS

Chaintech

Gainward

Gigabyte

Leadtek

MSI

Palit

PowerColor (Tul)

Prolink

Sapphire

Sparkle

SUMA

Другие

HIS

XFX

BFG

Zotac

Sysconn

Point of View

Интерфейс

параметры

AGP

PCI Express

Андрей Понкратов

23 февраля 2023

GeForce RTX 4070 Ti Suprim X – это крутая видеокарта премиум-класса, оснащенная мощной системой охлаждения и реализованной по максимуму подсистемой питания.

Андрей Понкратов

17 февраля 2023

GeForce RTX 4080 Gaming X Trio обеспечивает высокую производительность и тихую работу в 4K, а в меньшем разрешении позволяет играть на максимуме.

Андрей Понкратов

9 февраля 2023

Новинка MSI – это производительная, мощная и тихая видеокарта, основанная на графическом процессоре AD102.

Андрей Понкратов

22 ноября 2022

На тест в лабораторию прибыла новинка MSI – настоящий флагман, который способен обеспечить высокую производительность во всех современных играх.

Дмитрий Олегович

10 июня 2022

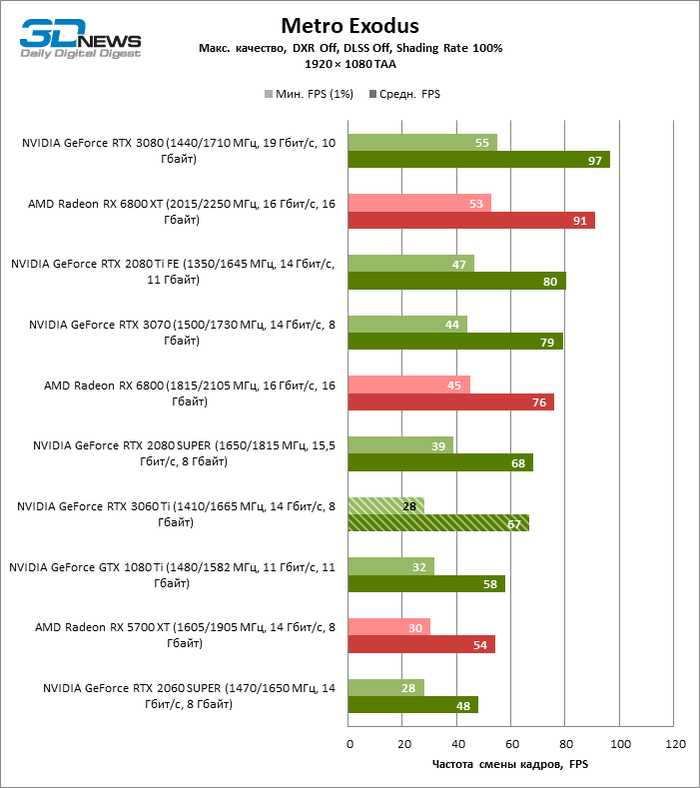

Тестирование видеокарты Radeon RX 6800 XT и еще пяти графических ускорителей в разрешениях 1920 х 1080, 2560 х 1440, 3840 х 2160 и двух режимах работы.

Дмитрий Олегович

1 июня 2022

Тестирование видеокарты Radeon RX 6800 и еще пяти графических ускорителей в разрешениях 1920 х 1080, 2560 х 1440, 3840 х 2160 и двух режимах работы.

Дмитрий Олегович

27 мая 2022

Тестирование видеокарты Radeon RX 6700 ХТ и еще пяти графических ускорителей в разрешениях 1920 х 1080, 2560 х 1440, 3440 х 1440 и двух режимах работы.

Дмитрий Олегович

22 мая 2022

Тестирование видеокарты Radeon RX 6600 ХТ и еще пяти графических ускорителей в разрешениях 1920 х 1080, 2560 х 1440, 3440 х 1440 и двух режимах работы.

Дмитрий Олегович

18 мая 2022

Тестирование видеокарты Radeon RX 6600 и еще пяти графических ускорителей в разрешениях 1920 х 1080, 2560 х 1080, 2560 х 1440 и двух режимах работы.

Максим Романов

12 мая 2022

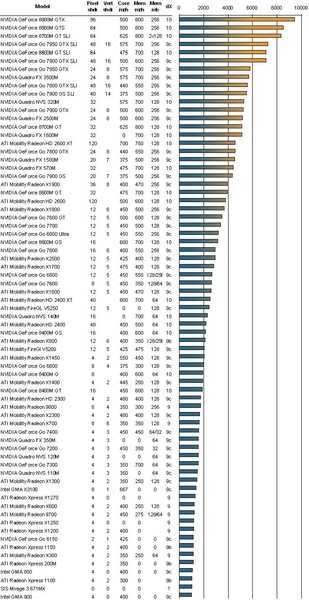

Выбор PCI видеокарты для ретро-платформы на базе Windows XP: шесть поколений моделей, процессорозависимость, частота системной шины и другие характеристики, которые позволят определить победителя.

Дмитрий Олегович

27 марта 2022

Тестирование двух конфигураций ПК в двух режимах работы, разрешении 1920 x 1080 и восьми играх.

Дмитрий Олегович

25 марта 2022

Тестирование видеокарт NVIDIA GeForce RTX 2070 Super и AMD Radeon RX 5700 ХТ в связке с процессором Core i7-11700КF с в разрешениях 1920 х 1080, 2560 х 1080 и 2560 х 1440, двух режимах работы и восьми играх.

Александр Андерсон

24 марта 2022

Модель MSI принадлежит к тому редкому племени бюджетных графических ускорителей, которые заслуживают внимания.

Дмитрий Олегович

20 марта 2022

Чем выше разрешение, тем сильнее снижается производительность. И по этому показателю мы выясним, насколько влияет объем на производительность графических ускорителей.

Дмитрий Олегович

18 марта 2022

Тестирование видеокарт NVIDIA GeForce RTX 2060 Super и AMD Radeon RX 5700 в связке с процессором Core i7-11700КF с в разрешениях 1920 х 1080, 2560 х 1080 и 2560 х 1440, двух режимах работы и восьми играх.

Александр Андерсон

10 марта 2022

Новый ускоритель является промежуточным звеном между двумя флагманами и призван закрыть брешь между ними не только по производительности, но и цене.

Дмитрий Олегович

9 марта 2022

Тестирование двух конфигураций ПК в двух режимах работы, разрешении 1920 x 1080 и восьми играх.

Андрей Понкратов

8 марта 2022

Новинка серии The Ultimate Force, основанная на Navi 24 – отличная тихая видеокарта для онлайн-игр и нетребовательных игр, которая сделана на совесть.

Дмитрий Олегович

7 марта 2022

Тест NVIDIA GeForce RTX 3060, GeForce RTX 2060, GeForce GTX 1070 и AMD Radeon RX 5600 XT в разрешениях 1920 x 1080, 2560 х 1080 и 2560 х 1440, двух режимах и восьми играх.

Дмитрий Олегович

2 марта 2022

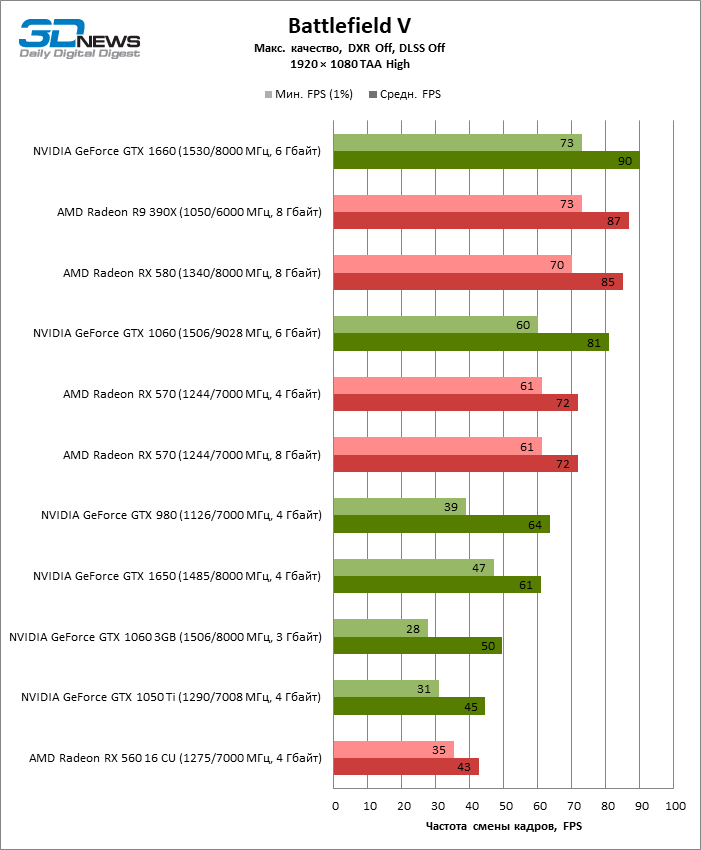

Тест 20 (от Radeon RX 5500 XT до Radeon RX 5700 XT, от GeForce GTX 1650 до GeForce RTX 3080) графических ускорителей в восьми играх и трех разрешениях.

за что следует доплатить? GECID.com.

::>Видеокарты

>2022

> Сравнение четырех видеокарт GeForce RTX 3060 от GIGABYTE: за что следует доплатить?

28-10-2022

В одном из предыдущих обзоров, там где мы выбирали оптимальный процессор Intel для GeForce RTX 3060, мы оговорились, что намеренно берем не самую дешевую версию видеокарты, чтобы тише и холоднее, а буст-частоты выше. То есть только по внешнему виду и некоторым характеристикам, плюс пара комментариев от зрителей, мы решили, что чуть более дорогая видеокарта серии Gaming значительно лучше модели из серии EAGLE. Действительно ли это так? А если да, то насколько?

То есть только по внешнему виду и некоторым характеристикам, плюс пара комментариев от зрителей, мы решили, что чуть более дорогая видеокарта серии Gaming значительно лучше модели из серии EAGLE. Действительно ли это так? А если да, то насколько?

К тому же, обе эти видеокарты мы еще не вернули. Почему бы не сравнить? Более того, для полноты картины попросили у Telemart.ua еще две версии RTX 3060 в исполнении GIGABYTE – VISION и AORUS ELITE.

Поэтому благодарим TELEMART за возможность делать разные тесты и напоминаем, здесь есть много комплектующих, периферии, сетевого оборудования и готовых ПК на разный вкус и кошелек. А недавно появилась возможность обновиться по принципу Trade-In – сдать уже не нужное железо и получить скидку на новое оборудование до 99%.

Почему RTX 3060 – оптимальный выбор?

Прежде чем знакомиться с видеокартами, напомним вообще о характеристиках и возможностях GeForce RTX 3060. Почему видеокарты на этом чипе сейчас так популярны?

По сравнению с младшими RTX 3050 видеокарты на GeForce RTX 3060 значительно мощнее благодаря почти на треть большему количеству CUDA ядер и других рабочих блоков – текстурных, растеризованных, RT ядер второго поколения и тензорных третьего. Также здесь в полтора раза шире шина видеопамяти, которой 12 ГБ против 8-ми. Это, кстати, запас на будущее. Плюс еще и зависимости от скорости интерфейса PCI-E почти нет, потому что у RTX 3060 полноценные 16 линий, а у RTX 3050 всего 8. Благодаря этому старшая без проблем тянет все в 1080p на максималках и даже в 1440p, если разумно подойти к настройкам графики и заручиться поддержкой DLSS.

Также здесь в полтора раза шире шина видеопамяти, которой 12 ГБ против 8-ми. Это, кстати, запас на будущее. Плюс еще и зависимости от скорости интерфейса PCI-E почти нет, потому что у RTX 3060 полноценные 16 линий, а у RTX 3050 всего 8. Благодаря этому старшая без проблем тянет все в 1080p на максималках и даже в 1440p, если разумно подойти к настройкам графики и заручиться поддержкой DLSS.

Что касается старшей RTX 3060 Тi, то обычная RTX 3060, конечно, проигрывает, потому что имеет на треть меньше CUDA ядер и других блоков, да еще работает с более узкой шины видеопамяти – 192 против 256 бит. Но у Тi версии, которая позиционируется уже под Quad HD, всего 8 ГБ памяти и стоит она дороже.

Чтобы не быть голословными, мы взяли уже собранную для предварительных тестов систему из GIGABYTE GeForce RTX 3060 Gaming OC и попробовали на ней и поработать, и поиграть.

К примеру, графический адаптер значительно ускоряет монтаж видео даже в 4К, как сам процесс с предварительным просмотром, так и финальный рендер, что хорошо видно по загрузке GPU на мониторинге, а также по скорости работы программы. Такое же ускорение можно получить и в других графических и видеоредакторах, и профессиональных приложениях.

Такое же ускорение можно получить и в других графических и видеоредакторах, и профессиональных приложениях.

Кстати, здесь напомним, что у NVIDIA есть драйверы Studio, оптимизированные для тех, кто за компьютером в первую очередь работает, а не играется.

Если же ПК в первую очередь игровой, то стандартные драйверы обновляются довольно часто для улучшения поддержки новых игр, в которые добавляется в том числе фирменных технологий, например, DLSS или NVIDIA Reflex, а также оптимизации производительности в старых хитах.

Например, берем киберспортивную CS:GO для простоты на карте «Nuke» против ботов. Что у Full HD, что у Quad HD даже с максимальными настройками играть комфортно со средним fps за триста в первом случае и под триста во втором. На высокогерцовых мониторах будет то что нужно!

Или вот давайте в Dota 2 посмотрим трансляцию матча с максимальными настройками. Вновь в обоих случаях, то есть в 1080p и 1440p видеокарта обеспечивает комфортный гейсплей. Так, как всегда в этой игре, в начале матча есть немного подтупливаний, пока игра не закэшит все что нужно, а дальше никаких проблем, даже очень редкие события переваливают за сотню.

Так, как всегда в этой игре, в начале матча есть немного подтупливаний, пока игра не закэшит все что нужно, а дальше никаких проблем, даже очень редкие события переваливают за сотню.

Даже в более тяжелой и жадной к ресурсам СoD: Warzone с максимальными настройками графики нет нареканий к плавности видеоряда в самых популярных разрешениях. Даже небольших подлагиваний при езде на транспорте в этот раз не было.

То есть и простые популярные, и даже ресурсоемкие состязательные игры на RTX 3060 идут без проблем. Что касается тяжелых ААА-проектов, то посмотрим не на них уже в сравнительной части.

На чем тестировали?

Прежде, чем переходить к более близкому знакомству с видеокартами, осталось лишь напомнить конфиг системы, в которой мы их протестировали.

В основу системы легла доступная материнская плата GIGABYTE B660M GAMING DDR4.

Процессор взяли 6-ядерный 12-поточный Intel Core i5-12600 с рабочими частотами в диапазоне 3,3 – 4,6 ГГц.

Процессор достаточно горячий, поэтому охлаждали его немаленьким кулером Arctic Freezer 34 eSports DUO Black/Red.

Оперативной памяти установили 32 ГБ двумя модулями DDR4-3200 GOODRAM IRDM X Black.

Операционную систему и прочее установили на SSD GOODRAM IRDM M.2 на 512ГБ.

Источником питания выступил GIGABYTE P850GM 850W, которого хватило с запасом.

А разместились все эти компоненты в корпусе DeepCool MATREXX 40 Tempered Glass.

Подробнее о видеокартах

Сразу скажем, что все модели в названии имеют уточнение rev.2.0. Это означает, что в них встроена защита от майнинга – карты для этого не подходят. А вот работа и игры – пожалуйста!

И еще один момент – непосредственно печатные платы практически одинаковые. Особенно у трех младших, у которых 6 фаз стабилизатора питают GPU, а еще 2 – память. Итого 8 фаз. Несколько отличается здесь AORUS ELITE. У нее питание обеспечивается по схеме 8+2, то есть на две больше, что должно обеспечить более высокие частоты – проверим немного позже.

Несколько отличается здесь AORUS ELITE. У нее питание обеспечивается по схеме 8+2, то есть на две больше, что должно обеспечить более высокие частоты – проверим немного позже.

В основном карты отличаются системами охлаждения, к ним и переходим.

Самая молодая и доступная карта из протестированных – GIGABYTE GeForce RTX 3060 EAGLE OC 12G (rev.2.0). И только она несет на себе два вентилятора. Они имеют диаметр 100 мм и вращаются в разные стороны для создания более сильного потока воздуха, а лопасти имеют рифления для его лучшего распределения.

Длина видеокарты небольшая – всего 242 мм. Она занимает два слота расширения. Дополнительное питание – 8 pin.

Самое интересное – заявленная Boost-частота – 1807 МГц, в то время как у эталонной карты – 1777 МГц. Три семерки запомнить легко – дальше будем сравнивать.

Есть даже немного подсветки RGB Fusion 2.0 – светящаяся надпись EAGLE, то есть «Орел» в переводе.

У GIGABYTE GeForce RTX 3060 Gaming OC 12G (rev. 2.0) также двухслотовая система охлаждения, но оснащена уже тремя вентиляторами по 80 мм каждый.

2.0) также двухслотовая система охлаждения, но оснащена уже тремя вентиляторами по 80 мм каждый.

Радиатор пронизывают три тепловые трубки, с таким же прямым контактом к чипу для лучшей съемки тепла. Требование к питанию аналогично предыдущей карте – блок на 550 Вт и один дополнительный разъем на 8 pin. Длина карты, конечно, больше – 282 мм.

Частота GPU на 30 МГц выше предыдущей – 1837 МГц. Немного подсветки также есть – светящийся логотип «GIGABYTE».

Расположение, кстати, лучше – на торце ее лучше видно через прозрачную боковую панель корпуса.

Далее практически полная копия Gaming – модель GIGABYTE GeForce RTX 3060 VISION OC 12G (rev.2.0). Также три 80 мм вертушки, три тепловые трубки и частота – 1837 МГц. Даже по размерам почти один в один. Разница – пара миллиметров.

Главная же фишка, как вы поняли – дизайн в светлом исполнении. Если собирается система в аналогичном оформлении, такая карточка впишется на ура.

И, в конце концов, AORUS GeForce RTX 3060 ELITE 12G (rev.2.0). Ее система охлаждения – самая большая из всех. Она более толстая, занимает примерно 3 слота расширения, а по длине достигает почти 30 см. К GPU прижимаются 5 тепловых трубок.

Главная фишка кулера – круговая подсветка вентиляторов. Возможно, поэтому производитель рекомендует использовать блок питания на 100 Вт более мощный – 650 Вт, а кроме 8-контактного дополнительного питания понадобится еще один 6-контактный разъем.

Заявленная частота GPU на 30 МГц выше чем у других карт – 1867 МГц.

Кроме того, стоит отметить, что у всех карточек частично продувается бэкплейт. Это окошко позволяет более эффективно выбрасывать горячий воздух за пределы радиатора.

Нагрев и частоты в стресс-тесте

А теперь сравним системы охлаждения в тяжелых условиях. Все карты прогревались под максимальной нагрузкой стресс-тестом FurMark.

Очевидно, тяжелее всего в данном сценарии оказалось 2-вентиляторный 3060 EAGLE. Температура GPU повышалась до 75.5°C, а самая горячая точка, которую поймали датчики, составила почти 91°C. Кулер при этом работал на 94% от своей максимальной скорости. Однако EAGLE на время взяла самую высокую частоту GPU – 1942 МГц. Сможет ли она приблизиться к ней в играх? Узнаем чуть позже.

Температура GPU повышалась до 75.5°C, а самая горячая точка, которую поймали датчики, составила почти 91°C. Кулер при этом работал на 94% от своей максимальной скорости. Однако EAGLE на время взяла самую высокую частоту GPU – 1942 МГц. Сможет ли она приблизиться к ней в играх? Узнаем чуть позже.

Версия VISION обдувается более эффективно. Температура – 71,2°C, а Hot Spot – 83,4°C. При этом у вертушек меньшего диаметра более высокая скорость, они разгонялись на дополнительные 460 об/мин по сравнению с EAGLE. И для них это всего 80% от максимума. Зафиксированный потолок частоты – 1890 МГц.

RTX 3060 Gaming OC показала оптимальное соотношение температуры и процентной нагрузки системы охлаждения среди 4-х модификаций. Разогрев GPU уже ниже психологической отметки в 70°C, а кулеры работают на 77% своих возможностей. Максимальная частота GPU – 1867 МГц.

И, наконец, AORUS RTX 3060 ELITE удалось показать самый холодный результат – 67,4°C, при Hot Spot – 77,6°C. Для этого система охлаждения в пике раскручивалась до 90% своих возможностей, что в цифрах — 2118 об/мин.

Для этого система охлаждения в пике раскручивалась до 90% своих возможностей, что в цифрах — 2118 об/мин.

|

|

GPU

|

Hot Spot

|

Fan (Max)

|

GPU Clock (Max)

|

Mem Clock

|

|

AORUS RTX 3060 ELITE

|

67,4℃

|

77,6℃

|

2118 RPM (90%)

|

1875 MHz

|

1875 MHz

|

|

RTX 3060 Gaming OC

|

68,9℃

|

79,7℃

|

2234 RPM (77%)

|

1867 MHz

|

1875 MHz

|

|

RTX 3060 VISION OC

|

71,2℃

|

83,4℃

|

2360 RPM (80%)

|

1890 MHz

|

1875 MHz

|

|

RTX 3060 EAGLE OC

|

75,5℃

|

90,8℃

|

1903 RPM (94%)

|

1942 MHz

|

1875 MHz

|

Итого, финальная сводка результатов выглядит так. Можно сказать, что стрессовую нагрузку карты переносят одинаково хорошо, сохраняя температуры в норме, ведь потолок для RTX 3060 – 93°С. Если раздавать места – золото у AORUS ELITE, серебро у Gaming, а бронза достается Vision. EAGLE выигрывает в категории «компактность» – она лучше станет в маленький корпус. Что касается шума, то в нашей системе у всех он примерно одинаков – сравнительно невысокий. По субъективным ощущениям — EAGLE и Gaming немного тише остальных.

Можно сказать, что стрессовую нагрузку карты переносят одинаково хорошо, сохраняя температуры в норме, ведь потолок для RTX 3060 – 93°С. Если раздавать места – золото у AORUS ELITE, серебро у Gaming, а бронза достается Vision. EAGLE выигрывает в категории «компактность» – она лучше станет в маленький корпус. Что касается шума, то в нашей системе у всех он примерно одинаков – сравнительно невысокий. По субъективным ощущениям — EAGLE и Gaming немного тише остальных.

Сравним четыре RTX 3060

На что способны наши участницы под максимальной нагрузкой, мы уже узнали, теперь оценим, какую производительность они дают в рабочей и игровой нагрузке.

У Blender 3-вентиляторные модификации практически идентичны. Они обгоняют EAGLE в среднем на 3-4%.

А вот бенчмарк V-Ray построил более наглядную лесенку. AORUS обходит самую молодую модификацию уже на 7-12%. В свою очередь Gaming и VISION находятся посредине – с преимуществом 3-4% над EAGLE.

У 3DMark Time Spy 2-вентиляторная EAGLE вероятно не принимала настолько высокие частоты, как у стресс-теста, что и поставило ее чуть ниже версии Gaming. Понятно, что в общем-то здесь разница исчисляется плюс-минус одним процентом. Самый высокий результат у AORUS – она обошла младшую на 2,5% по показателю Graphics Score.

Понятно, что в общем-то здесь разница исчисляется плюс-минус одним процентом. Самый высокий результат у AORUS – она обошла младшую на 2,5% по показателю Graphics Score.

В целом понятно, что для рабочих задач принципиальной разницы нет – все RTX 3060 крутые и хорошо оптимизированные под популярные программы. Но если искать лучший вариант на этом GPU – выбор AORUS Elite. Оптимальными же будут VISION или Gaming, а замыкающий список – EAGLE.

А теперь основное блюдо этого обзора – сравнение в играх. Удастся ли нащупать между картами ощутимую разницу? Какие в реальных играх температуры и частоты? Узнаем на примере 9 сценариев с разным разрешением и настройками графики.

Начинаем с Cyberpunk 2077 в разрешении 1080p и на ультранастройках. Пока что без лучей и DLSS. У всех карт разница в пределах погрешности измерений. Все держат отличную частоту GPU в районе 1900 МГц с лихвой. Это высшее значение в стресс-тесте. Лучшей была Vision – ее частоты стабильно высокие, что и вылилось в 3-4% преимущества над 2-вентиляторным Eagle.

Обращая внимание на соотношение шума и температур к скорости, побеждает Gaming. Она на 5°C холоднее и немного тише, чем Vision.

Включение чудодейственной технологии DLSS в режиме «качество» увеличивает частоту кадров на 30 с лишним процентов! На треть! Без заметного проседания в детализации. Теперь карточки стабильно держат частоту выше 1950 МГц, только EAGLE зацепилась за 1920 МГц, что обеспечило ей на 4% меньшую среднюю частоту, чем у AORUS. Кстати, референсная Boost-частота для RTX 3060 – 1777 МГц.

Продолжаем нащупывать баланс картинки и производительности — включаем ультратрассировку лучей, а DLSS переводим в режим «Производительность». В таком сценарии лучше справилась модель AORUS – единственная взяла 2025 МГц, еще и при самой низкой температуре. На втором месте в этом плане оказалась Gaming, у нее тоже 66°C, хорошая частота в 1972 МГц и 60 fps в среднем.

За счет технологии DLSS в режиме «производительность» можно получить такой же плавный и стабильный геймплей в разрешении 1440p. Пока без Ray Tracing. На первом месте снова AORUS. Например, она на 7°C холоднее EAGLE и на 7% обходит ее по очень редким событиям. Снова золотой серединой выглядит Gaming – вторая по температуре и скорости, а в хвосте – двухвентиляторный EAGLE.

Пока без Ray Tracing. На первом месте снова AORUS. Например, она на 7°C холоднее EAGLE и на 7% обходит ее по очень редким событиям. Снова золотой серединой выглядит Gaming – вторая по температуре и скорости, а в хвосте – двухвентиляторный EAGLE.

И заканчиваем с Cyberpunk 2077 в разрешении 1440p, ультра-лучами и DLSS в режиме «Производительность». Планка средней частоты спускается до 43-45 к/с. Можно сказать, что такой режим вполне комфортен для прохождения. В этом сценарии побеждает VISION, поскольку почти железобетонно держит частоту 1965 МГц. Например, она на 5-9% обошла самую молодую карточку. Второе место между собой делят модели Gaming и Aorus, показывая чуть меньшую частоту, но зато более комфортные температуры.

Переходим ко второй игре – Dying Light 2. Первый этап в разрешении Full HD с максимальными настройками графики, которые называются High, и без технологии DLSS. Снова видим, что какой-то сакральной разницы нет, карточки отличаются на 1-2 к/с, что без мониторинга не почувствовать. По связке температура-частота GPU победила модель Gaming – 69°C и около 1935 МГц. Например, у компактной EAGLE – 77°C и частота чуть ниже 1900 МГц.

По связке температура-частота GPU победила модель Gaming – 69°C и около 1935 МГц. Например, у компактной EAGLE – 77°C и частота чуть ниже 1900 МГц.

С включением трассировки лучей высокого качества и DLSS в режиме Performance сохраняем практически такую же плавность геймплея с незначительной потерей резкости на отдельных текстурах. Градация между картами особо не изменилась. Только VISION выделилась более стабильной частотой, что дало ей 1-2 кадра преимущества над другими.

Переход к разрешению Quad HD. Настройки по-прежнему максимальны, кроме DLSS в режиме Качество и пока без лучей. По-видимому, здесь победителем можно назвать RTX 3060 Gaming OC, поскольку при минимальной температуре в 69°C она показала почти максимальный фреймрейт. Vision у нее обычно отгрызла 2% по средней частоте, но и на те же 2°C оказалась горячей.

И заканчиваем в 1440p с качественной трассировкой лучей. Частота просела примерно на 30%, но благодаря чудодейственной DLSS в режиме «производительности» все равно удалось сохранить достаточно плавный геймплей. По температурам и частотам все по-прежнему: Vision выигрывает 1 fps, а Gaming и AORUS холоднее на 3°C; EAGLE как обычно – на 8 пунктов горячее.

По температурам и частотам все по-прежнему: Vision выигрывает 1 fps, а Gaming и AORUS холоднее на 3°C; EAGLE как обычно – на 8 пунктов горячее.

Выводы

Все видеокарты показали отличную производительность за счет частот около 1900 МГц и выше для GPU RTX 3060, который сейчас едва ли не лучший для рабочих задач и игр с трассировкой лучей по своей стоимости. Даже в 1440p, если включить магическую технологию DLSS. Но за счет разных систем охлаждения – отличия все же есть.

2-вентиляторная GIGABYTE GeForce RTX 3060 EAGLE OC 12G (rev.2.0) временами на 7-9°C горячая чем самые холодные Gaming и AORUS. И до 4-9% слабее их по частоте кадров в некоторых сценариях. При плохом охлаждении корпуса эта разница может еще немного увеличиться. С другой стороны, EAGLE лучше совместима с тесными системными корпусами и самая дешевая.

С другой стороны, EAGLE лучше совместима с тесными системными корпусами и самая дешевая.

GIGABYTE GeForce RTX 3060 Gaming OC 12G (rev.2.0) – выглядит как золотая середина среди всех 4-х по показателям цена/возможности и скорость/температура. Сейчас она всего на 800-1000 грн дороже 2-вентиляторной. При этом под максимальной нагрузкой используется всего 77% скорости вентиляторов против 94% у младшей. Этот запас можно конвертировать в лучшую температуру или в небольшой разгон. Уровень шума у нее тоже ниже других, по субъективным ощущениям.

Модель GIGABYTE GeForce RTX 3060 VISION OC 12G (rev.2.0) в среднем на 1-2% быстрее Gaming, но на пару градусов горячее и немного громче. Цена плюс-минус такая же. Итак, ее сильная сторона – светлый дизайн под такие же компоненты системы.

Что касается AORUS GeForce RTX 3060 ELITE 12G (rev.2.0), то технически она холодная, выигрывает у Gaming 1-2°C. Благодаря этому держит немного выше частоты, иногда даже рубеж 2000 МГц пересекает, что обеспечивает стабильный бонус в 1-2 кадра. Но, по всей вероятности, большинство не захочет переплачивать именно за это. А вот за крутую подсветку, если в корпусе имеется прозрачная боковина – вполне вероятно.

Благодаря этому держит немного выше частоты, иногда даже рубеж 2000 МГц пересекает, что обеспечивает стабильный бонус в 1-2 кадра. Но, по всей вероятности, большинство не захочет переплачивать именно за это. А вот за крутую подсветку, если в корпусе имеется прозрачная боковина – вполне вероятно.

Автор: Денис Козиолек

NVIDIA представила первые видеокарты GeForce RTX 40 (обновление 2)

Осень обещает быть жаркой на новинки, помимо процессоров AMD Ryzen 7000 и Intel Raptor Lake, NVIDIA представила первые подробности видеокарт GeForce RTX 40. Анонс оказался необычным, поскольку конференция GPU Technologies Conference или GTC посвящена профессиональным и серверным решением. Но в этом году она стала площадкой для представления игровых новинок.

По предыдущим утечкам название архитектуры и модельные номера были известны, позднее они были подтверждены маркетинговой кампанией. Видеокарты GeForce RTX 40 базируются на архитектуре Lovelace, названной в честь Ады Лавлейс, британского математика.

Перейдем сразу к наиболее важным фактам. Сегодня представлены две видеокарты GeForce RTX 4080 и GeForce RTX 4090, причем GeForce RTX 4080 будет доступна в двух вариантах, которые отличаются конфигурацией памяти и числом функциональных блоков, несмотря на одинаковое название. Ниже представлены технические спецификации, а «белые пятна» мы планируем закрыть в ближайшие часы.

| GeForce RTX 4080 12 GB | GeForce RTX 4080 16 GB | GeForce RTX 4090 | |

| GPU | AD104 | AD103 | AD102 |

| Число транзисторов | — | — | 76 млрд. |

| Техпроцесс | 4 нм | 4 нм | 4 нм |

| Площадь кристалла | — | — | 608,3 мм² |

| Число FP32 ALU | 7. 680 680 | 9.728 | 16.384 |

| Число INT32 ALU | — | — | — |

| Число SM | 60 | 76 | 128 |

| Ядра Tensor | 240 | 304 | 512 |

| Ядра RT | 60 | 76 | 128 |

| Базовая частота | 2.310 МГц | 2.210 МГц | 2.230 МГц |

| Частота Boost | 2.610 МГц | 2.505 МГц | 2.520 МГц |

| Емкость памяти | 12 GB | 16 GB | 24 GB |

| Тип памяти | GDDR6X | GDDR6X | GDDR6X |

| Ширина шины памяти | 192 бит | 256 бит | 384 бит |

| Частота памяти | — | — | — |

| Пропускная способность памяти | 504 Гбайт/с | 720 Гбайт/с | 1. 008 Гбайт/с 008 Гбайт/с |

| TDP | 285 Вт | 325 Вт | 450 Вт |

| Макс. TDP | 366 Вт | 516 Вт | 660 Вт |

| Цена | 1.099 евро | 1.469 евро | 1.949 евро |

Флагманская видеокарта GeForce RTX 4090 использует GPU AD102 со 128 блоками SM, что эквивалентно 16.384 блокам FP32. Пока неизвестно, какое именно число блоков INT32, ядер RT и Tensor присутствует в каждом SM. В любом случае, ядра RT и Tensor перешли на новые версии, поэтому эффективность должна быть намного выше предшественников.

Видеокарта GeForce RTX 4090 оснащается 24 Гбайт видеопамяти GDDR6X с подключением по 384-битной шине. Пропускная способность памяти – около 1 Тбайт/с. Тепловой пакет видеокарты TGP (Total Graphics Power) увеличился до 450 Вт, причем в пике он может достигать 660 Вт. Видеокарты GeForce RTX 4090 поступят в продажу уже 12 октября по цене 1. 940 евро.

940 евро.

| Потоковые процессоры | VRAM | Цена | |

| GeForce RTX 3070 | 5.888 | 8 Гбайт 256 бит / 448 Гбайт/с | от 42.000 ₽ |

| GeForce RTX 4080 12 Гбайт | 7.680 | 12 Гбайт 192 бит / 504 Гбайт/с | 1.099 евро |

| GeForce RTX 3080 | 8.704 | 10 Гбайт 320 бит / 760 Гбайт/с | от 69.500 ₽ |

| GeForce RTX 4080 16 Гбайт | 9.728 | 16 Гбайт 256 бит / 720 Гбайт/с | 1.469 евро |

| GeForce RTX 3090 | 10.496 | 24 Гбайт 384 бит / 936 Гбайт/с | от 112.000 ₽ |

| GeForce RTX 4090 | 16. 384 384 | 24 Гбайт 384 бит / 1.008 Гбайт/с | 1.949 евро |

Выше мы сравнили GeForce RTX 4090 с предшественницей GeForce RTX 3090. Конечно, следует учитывать цену. Видеокарта GeForce RTX 3090 стартовала с €1.499, сегодня ее можно приобрести от 112.000 ₽. Прирост производительности RTX 4090 вполне может компенсировать увеличение цены до €1.949, хотя планка почти €2.000 остается довольно высокой для видеокарты.

GeForce RTX 4080 16 GB можно рассматривать как преемницу GeForce RTX 3080. Но и здесь NVIDIA удваивает цену до €1.469. GeForce RTX 3080 можно приобрести от 69.500 ₽. Покупатель получит на 12% больше функциональных блоков, но также и на 6 Гбайт больше видеопамяти, хотя и с менее скоростным подключением.

Видеокарту GeForce RTX 4080 на 12 Гбайт можно назвать преемницей GeForce RTX 3070, которая сегодня продается в рознице от 42.000 ₽. Доплата и здесь весьма существенная. По приросту производительности что-либо сказать сложно. Интерфейс памяти здесь уже, но объем на 50% больше. А из-за более высокой тактовой частоты и пропускная способность выше.

Интерфейс памяти здесь уже, но объем на 50% больше. А из-за более высокой тактовой частоты и пропускная способность выше.

GeForce RTX 4080 в двух вариантах

А вот в случае видеокарты GeForce RTX 4080 следует быть внимательным. Представлены две модели, которые отличаются по числу функциональных блоков. У более мощной GeForce RTX 4080 их на 25% больше. Кроме того, емкость памяти достигает 16 Гбайт вместо 12 Гбайт. Последняя подключена по более широкому интерфейсу, поэтому и пропускная способность выше: 720 Гбайт/с у 16-Гбайт варианта и 504 Гбайт/с у младшей версии с 12 Гбайт. Энергопотребление составляет 285 или 325 Вт, цена — €1.469 или €1.099. Обе видеокарты GeForce RTX 4080 будут продаваться с ноября.

Общая черта всех представленных сегодня видеокарт GeForce RTX 40 – подключение через PCI Express 4.0. На видеокартах Founders Edition всегда используется разъем дополнительного питания 12VHPWR. Пока можно сказать одно: видеокарты Founders Edition очень похожи на нынешнюю линейку GeForce RTX 30. Дизайн системы охлаждения и внешний вид были почти полностью унаследованы. Что касается видеовыходов, доступны 3x DisplayPort 1.4 и 1x HDMI 2.1. Для всех представленных видеокарт следует отметить поддержку двойного кодировщика AV1. Напомним, что кодирование AV1 до сих пор было козырем Intel с поколением Alchemist, но теперь предложение перестало быть уникальным – еще до выхода самих видеокарт.

Дизайн системы охлаждения и внешний вид были почти полностью унаследованы. Что касается видеовыходов, доступны 3x DisplayPort 1.4 и 1x HDMI 2.1. Для всех представленных видеокарт следует отметить поддержку двойного кодировщика AV1. Напомним, что кодирование AV1 до сих пор было козырем Intel с поколением Alchemist, но теперь предложение перестало быть уникальным – еще до выхода самих видеокарт.

Не совсем понятно решение NVIDIA по анонсу двух видеокарт GeForce RTX 4080. Возможно, NVIDIA пытается сократить ассортимент продуктов, но видеокарты существенно различаются. Все три новых модели GeForce RTX 40 превосходят нынешнюю линейку по производительности. Но в ближайшие месяцы NVIDIA наверняка представит и «младшие» видеокарты.

Первые тесты

Конечно, NVIDIA предоставила первые тесты, в которых сравнила новые видеокарты с предшественницами.

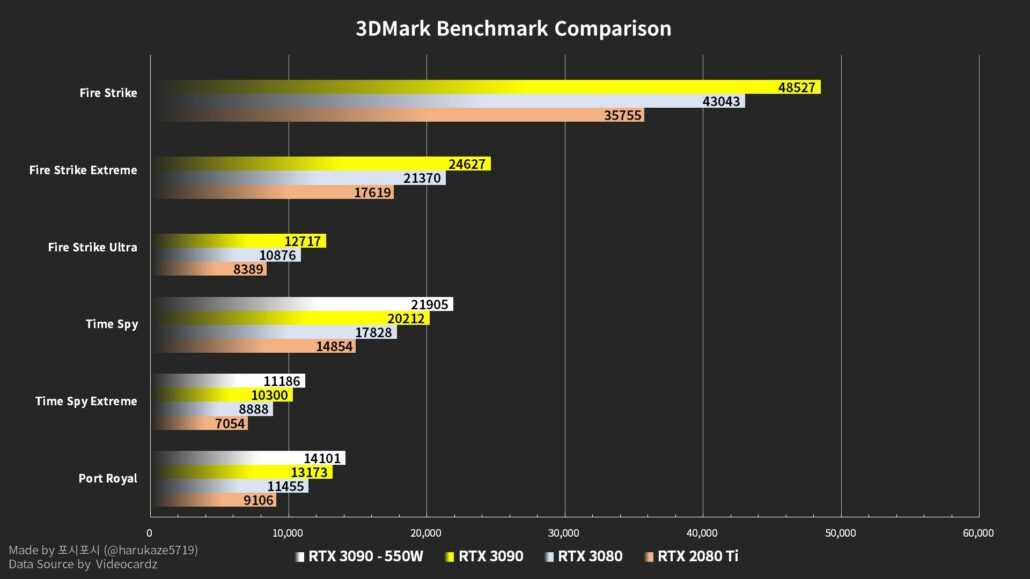

Видеокарты GeForce RTX 4080 с 16 и 12 Гбайт видеопамяти быстрее GeForce RTX 3080 Ti в два-четыре раза, в зависимости от теста. GeForce RTX 4090 будет работать в два раза быстрее GeForce RTX 3090 Ti, если верить NVIDIA. Кроме того, новые видеокарты работают в два раза эффективнее.

GeForce RTX 4090 будет работать в два раза быстрее GeForce RTX 3090 Ti, если верить NVIDIA. Кроме того, новые видеокарты работают в два раза эффективнее.

Впрочем, в приведенных тестах используется не чистая растеризация, а DLSS, что сказывается на производительности. У новых видеокарт производительность DLSS намного выше.

Вкратце об архитектуре Ada Lovelace

NVIDIA привела не так много подробностей, лишь вкратце упомянув архитектуру Ada Lovelace. GPU производятся на мощностях TSMC по 4-нм техпроцессу. В самой крупной конфигурации (AD102) GPU оснащается 76 млрд. транзисторов.

По сравнению с предшественниками, чипы GeForce RTX 40 иначе располагаются по кривой производительности на ватт. NVIDIA заявляет о фактическом удвоении производительности при прежнем энергопотреблении. График справа показывает, что NVIDIA с архитектурой Ampere не собиралась преодолевать планку энергопотребления 350 Вт. Но с видеокартой GeForce RTX 3090 Ti данный уровень был преодолен, затем уже начинается GeForce RTX 4090. Как можно видеть по кривой, чипы Ada Lovelace могут очень эффективно работать на уровнях от 150 до 250 Вт. Но соответствующие бюджетные видеокарты сегодня представлены не были.

Но с видеокартой GeForce RTX 3090 Ti данный уровень был преодолен, затем уже начинается GeForce RTX 4090. Как можно видеть по кривой, чипы Ada Lovelace могут очень эффективно работать на уровнях от 150 до 250 Вт. Но соответствующие бюджетные видеокарты сегодня представлены не были.

С новой архитектурой NVIDIA оптимизировала вычисления, которые теперь выполняются более эффективно.

Технология Shader Execution Reordering (SER) позволяет объединять вычисления в конвейере, чтобы вычислительные блоки были всегда максимально нагружены. Производительность потоковых процессоров при этом увеличивается до двух раз, что приводит к повышению fps в играх до 25%.

Ядра RT третьего поколения

Третье поколение ядер RT в архитектуре Ada получило в два раза более высокую пропускную способность вычислительных блоков по сравнению с предшественниками, что увеличивает производительность по расчетам трассировки лучей в 2,8x. В случае GeForce RTX 4090 теоретическая производительность увеличилась до 191 RT TFLOPS по сравнению с 78 RT TFLOPS для GeForce RTX 3090 Ti.

Кроме того, третье поколение ядер RT получило такие функции, как Opacity Micro-Map Engines и Micro-Mesh Engines. Они представляют собой новые выделенные аппаратные блоки для ускорения особо требовательных вычислений трассировки лучей.

Здесь мы бы хотели более подробно остановиться на Opacity Micro-Maps и Displaced Micro-Meshes.

Opacity Micro-Maps представляют собой оптимизацию расчета трассировки лучей. Трассировка лучей не очень хорошо справляется с некоторыми объектами, например, листвой и растительностью. Лучи могут отражаться в бессчетных направлениях между листьями и ветвями, поэтому подобные объекты значительно осложняют трассировку. Третье поколение ядер RT может использовать Opacity Micro-Maps для присвоения статуса прозрачности подобным элементам, которые могут быть непрозрачными, прозрачными или неизвестными.

Для сложных объектов ранее трассировка лучей не использовалась или применялась в облегченном виде. Opacity Micro-Maps должны учитывать подобные объекты в будущем.

Ядра RT третьего поколения генерируют Displaced Micro-Meshes (DMM). Дерево BVH (bounding volume hierarchies), которое используется для трассировки лучей, будет строиться до 10 раз быстрее и потреблять в 20 раз меньше видеопамяти. NVIDIA описывает DMM следующим образом: «DMM – это новые примитивы, которые представляют собой структурированную сетку микро-треугольников, и ядра RT третьего поколения могут обрабатывать их в родном режиме. Что уменьшает требования к объему памяти при рендеринге сложной геометрии, которая использует только простые треугольники».

Четвертое поколение ядер Tensor и DLSS 3

Технология Deep Learning Super Sampling тоже получила обновление до третьей версией. Здесь используется 4-е поколение ядер Tensor, которое получило различные оптимизации. Например, новые ядра Tensor обеспечивают в пять раз более высокую пропускную способность вычислений FP8.

Для DLSS 3 используются так называемые ускорители Optical Flow. Они вычисляют пиксельные данные движения из последовательных кадров, используя нейросеть DLSS.

Они вычисляют пиксельные данные движения из последовательных кадров, используя нейросеть DLSS.

Альтернативные дизайны дополняют Founders Edition

NVIDIA выпустит видеокарты Founders Edition только на GeForce RTX 4090 и GeForce RTX 3080 16 GB. Видеокарты GeForce RTX 4080 12 GB выйдут только в альтернативных дизайнах от партнеров.

Все партнеры NVIDIA уже представили свои дизайны видеокарт, в том числе ASUS, Colorful, Gainward, Galaxy, Gigabyte, Inno3D, MSI, Palit, PNY и Zotac. Мы рассмотрим эти видеокарты в отдельной новости. Цены пока неизвестны.

Обновление: информация с Editors Day

NVIDIA на виртуальном мероприятии Editors Day опубликовала много дополнительной информации о новых видеокартах. Конечно, мы подготовили довольно детальную новость к анонсу GeForce RTX 4090, но в ней недоставало некоторых подробностей, что мы исправляем.

NVIDIA опубликовала диаграмму AD102 GPU и упомянула максимальный уровень расширения. Полная конфигурация AD102 GPU будет содержать до 18.432 вычислительных блоков FP32, 144 ядра RT и 576 ядер Tensor. Но NVIDIA пока не реализовала полный вариант ни на одной видеокарте, будь то GeForce RTX 4090 или RTX 6000 Ada Generation или L40.

Полная конфигурация AD102 GPU будет содержать до 18.432 вычислительных блоков FP32, 144 ядра RT и 576 ядер Tensor. Но NVIDIA пока не реализовала полный вариант ни на одной видеокарте, будь то GeForce RTX 4090 или RTX 6000 Ada Generation или L40.

Как и предполагалось, удвоения ROP не произошло. С архитектурой Ampere они мигрировали в Raster Engine, там и продолжают оставаться. У каждого Raster Engine имеются два раздела ROP, содержащие по восемь ROP. Остальная структура во многом идентична Ampere – за исключением числа SM и наличия ядер Tensor четвертого поколения и ядер RT третьего поколения.

Каждый SM содержит 64 вычислительных блоков FP32 и еще 64, способных выполнять вычисления FP32 или INT32. Кэш L1 по-прежнему составляет 128 кбайт.

Между тем NVIDIA раскрыла размер кэша L2. На полном AD102 GPU кэш L2 имеет емкость 98.304 кбайт, то есть почти 100 Мбайт. В степени расширения GeForce RTX 4090 GPU оснащен кэшем L2 емкостью 73.728 кбайт. Информации о чипе AD103 на видеокарте GeForce RTX 4080 с 16 GB или AD104 на GeForce RTX 4080 с 12 GB пока нет.

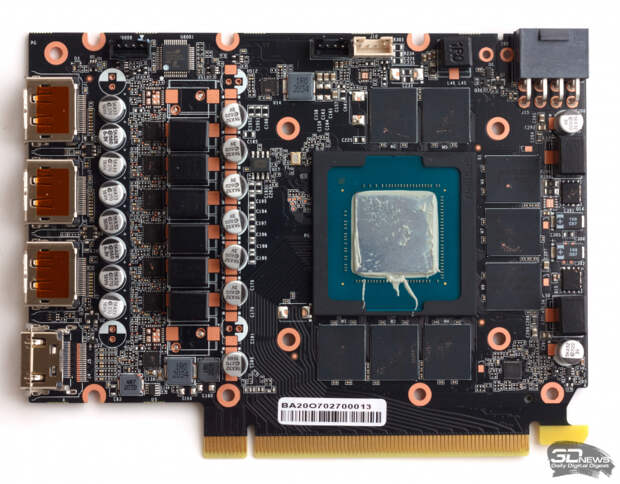

В другой презентации NVIDIA показала PCB видеокарты GeForce RTX 4090, которая оснащена системой питания с 23 фазами. 20 фаз отвечают за питание GPU, еще три – памяти. Управление системой питания было оптимизировано, чтобы избежать сильных пиков тока и напряжения. Хотя спецификация ATX 3.0 предусматривает большие пики, чем раньше.

Кулер видеокарт Founders Edition тоже был пересмотрен, теперь в него устанавливаются более крупные вентиляторы. Они увеличивают воздушный поток на 20% и улучшают охлаждение. Использованная память GDDR6X от Micron более экономична из-за нового техпроцесса, что позволило уменьшить температуры памяти на 10 °C.

В ближайшие дни мы подробно рассмотрим все инновации и подготовим обзорный материал к выходу GeForce RTX 4090.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).

Мы рекомендуем ознакомиться с нашим руководством по выбору видеокарты для разных бюджетов.

40-я серия видеокарт от Nvidia. Беглый обзор новинки. MultiMart

Развитие технологий способно существенно преобразить современный мир. Яркий тому пример видеокарты 40-серии от Nvidia, которые были презентованы в конце сентября этого года. В серию включены две основных модели: 4090 (в продаже с октября) и 4080 (в продаже с ноября).

По заявлению производителя использование новой архитектуры Ada Lovelace позволяет увеличить производительность практически вчетверо, а внедрение искусственного интеллекта повысить зрелищность игр и ускорить рабочие процессы. Технология Reflex оптимизирует и перераспределяет нагрузку между центральным и графическим процессором, повышая быстродействие. Внешне карты выглядят довольно массивными. Преимущественно на базе сороковой серии они будут занимать 3-4 слота, но есть и исключения с подключением к двум портам.

Как изменится производительность если купить видеокарту Nvidia

Карты сороковой серии позволяют создавать игровой мир с трассировкой лучей, высокой детализацией в высоком разрешении. При этом производительность повышена в 2-4 раза. Увеличению скорости способствует не только новая архитектура, но еще и использование DLSS 3, которая, по сути, является комбинацией трех отдельных технологий. В результате скорость отклика сокращена до 10 миллисекунд.

При этом производительность повышена в 2-4 раза. Увеличению скорости способствует не только новая архитектура, но еще и использование DLSS 3, которая, по сути, является комбинацией трех отдельных технологий. В результате скорость отклика сокращена до 10 миллисекунд.

Протестировать новую графику пользователи могут уже сейчас – выход режима Ray Tracing: Overdrive Mode наглядно демонстрирует прирост производительности при грамотном использовании настроек в играх и программах. Для доступа к расширенному функционалу потребуется обновить драйвера.

Во время работы с графическими программами сороковая видеокарта позволяет сократить время рендеринга вдвое, а также увеличить скорость экспорта видеоконтента. За счет аппаратного ускорения снижен битрейд без потери качества изображения.

Повышение скорости обновления кадров стало возможным благодаря использованию обновленного ускорителя оптических потоков, который передает информацию о движении пикселей в DLSS, генерирующего дополнительные кадры между первым и вторым за 5 мс и улучшающий изображение-оригинал. В результате количество кадров увеличивается, изображение в движении приобретает дополнительную четкость. Однако в некоторых случаях наблюдается замыливание фона из-за задержки, необходимой ИИ для создания допкадра.

В результате количество кадров увеличивается, изображение в движении приобретает дополнительную четкость. Однако в некоторых случаях наблюдается замыливание фона из-за задержки, необходимой ИИ для создания допкадра.

Два энкодера AV1 повышают качество видео при снижении нагрузки за счет оптимизации конвейеров кодирования OBS как во время звонков, так и при ведении стримов. В программах видеомонтажа его работа заметна по сокращению времени обработки вдвое при использовании соответствующих плагинов Voukoder и Jianying.

Дополнительно были усовершенствован базовый функционал. Теперь можно создавать видео с разрешением 8К, быстро накладывать эффекты, устранять фоновые шумы. При этом сама Ada повышает скорость трассировки в реальном времени и производительность на этапе интерактивного трассирования пути.

Система охлаждения с родными кулерами довольно эффективна и работает тихо, под нагрузкой может быстро понизить температуру. Теплосъемная площадка при этом контактирует как с памятью, так и с чипами, что позволяет расположить их с одной стороны, повысив эффективность, а не как в предыдущих версиях с двух сторон.

Ada Lovelace и цены на видеокарты Nvidia

Относительно высокая стоимость новинки, а это на данный момент около 1600 долларов для серии 4090 и порядка 900-1200 долларов для серии 4080, обусловлена использованием новых технологий, в том числе нового техпроцесса. При этом насколько рекомендованная стоимость будет отличаться от реальной остается только догадываться.

В результате внедрения новых разработок и увеличения количества транзисторов до 76 млрд при использовании техпроцесса TSMC 4N архитектуру Ada Lovelace можно назвать одной из передовых. Ведь реальную конкуренцию ей могут составить только новинки от AMD в Radeon RX 7900.

Также графический процессор поддерживает DLSS 3.0 и производительность до 90 Тфлопс, используя тензорные и RT-ядра. При этом RT-ядра (третье поколение) были разработаны специально для ресурсоемких процессов трассировки на микросетке, а тензорные FP8 (4 поколение) отвечают за искусственный интеллект и увеличение пропускной способности.

Какую видеокарту купить в Минске: 4090 или 4080

GeForce RTX 4090 – это:

- 24 Гб памяти в формате GDDR6X,

- разрешение 4К с высокой частотой смены кадров,

- полная трассировка лучей,

- высокий уровень точности и реализма,

- повышение производительности в 2 раза по сравнению с 3090 Ti,

- увеличение скорости рендеринга в 2 раза.

GeForce RTX 4080 – это:

- 16 Гб памяти в формате GDDR6X,

- экономия до 10% энергии,

- повышение производительности в 2 раза по сравнению с 3080 Ti,

- многозадачность и рендеринг видео в формате 12К.

Основные различия между двумя моделями заключаются в количестве ядер (16 384 в 4090 и 9728 в 4080), тактовая частота с ускорением отличается на 0,01 Гц, а базовая на 0,02 в пользу 4090. При этом 4090 оснащают 24 Гб памяти против 16 у 4080, а разрядность шины составляет соответственно 384 и 256 бит. Все это сказывается по производительности, что наглядно показывают тесты и дает разницу порядка 30 процентов.

Все это сказывается по производительности, что наглядно показывают тесты и дает разницу порядка 30 процентов.

Минусы и проблемные места

Физический размер и вес довольно существенны. Так, длина составляет 304 мм, а, значит, карта поместится далеко не в каждый корпус, вес – около 4 кг. При этом сам производитель рекомендует использовать для 4090 блок питания на 850 Вт, а для 4080 на 750 Вт, т.к прогнозируемое энергопотребление составляет 450 и 320 Вт. Под нагрузкой потребление может увеличиться до 500 Вт, а при разгоне до 670-800 Вт.

Поэтому блок питания лучше выбирать с запасом, а также возможностью подключения 4 коннекторов питания. Подключение может быть прямое кабелем PCIe Gen 5 для новых моделей блоков со стандартом ATX 3.0 и через фирменный переходник, который под нагрузкой может плавиться или перегорать.

На начальном этапе отслеживаются проблемы с оптимизацией. Так, при включении DLSS 3 некоторые игры вылетают. Принцип ее работы заключен в дорисовке кадра, когда процессор не может сделать это самостоятельно, хотя это и не может повлиять на скорость, которая так важна в соревновательных играх. Повысить частоту смены кадров на 4К до 240 Гц невозможно из-за отсутствия порта DisplayPort 2.0. или 2.1. Скорость в данном случае будет ограничивать сам монитор.

Повысить частоту смены кадров на 4К до 240 Гц невозможно из-за отсутствия порта DisplayPort 2.0. или 2.1. Скорость в данном случае будет ограничивать сам монитор.

Выводы

В целом прирост производительности 40 серии весьма впечатляет, хотя в реальности далеко не всегда он необходим. Мощностей видеокарт хватает для работы с видео, графикой и сокращения времени рейдеринга вдвое, а также запуска самых свежих геймерских новинок на ультранастройках. Качество изображения при соответствующей настройке действительно впечатляет, делая игровой процесс захватывающим и увлекательным.

обзор видеокарты, дата выхода, цена и характеристики

Видеокарта GeForce RTX 4090 была анонсирована 20 сентября 2022 года, а уже 12 октября первые партии поступили на полки магазинов. Этот невероятно мощный адаптер выдает такую производительность, что любые игры на максимальных настройках на нем просто летают. Действительно ли это пугающе большая видеокарта, сколько стоит RTX 4090 и другие важные вопросы касательно новинки — в нашем материале.

Основные характеристики

Видеокарта Nvidia GeForce rtx 4090 основана на архитектуре Ada Lovelace, благодаря чему отличается высокой мощностью и производительностью. По заверениям самой Nvidia, устройства на этой архитектуре в разы мощнее предшественников на Ampere, хотя они появились лишь в 2020 году.

Также у видеокарты огромное количество CUDA-ядер — целых 16 384 штук. Частота основного графического чипа может плавать между 2,23 и 2,52 ГГц, а количество быстрой видеопамяти GDDR6X составляет астрономические 24 ГБ.

Но впечатляющими получились не только технические характеристики, но также и удивительные для rtx 4090 размеры (340×150×75 мм) и питание. Видеокарта занимает целых четыре блока на материнской плате, а потребляет 450 Ватт — когда-то блоки питания с такими показателями считались чрезмерными для самых мощных компьютеров.

Тесты в играх

Разумеется, с такими показателями видеокарта rtx 4090 не могла плохо показать себя в тестах игр. Свой обзор ртх 4090 выпустил уже каждый уважающий себя техноблогер, так что информации о работе карты сейчас предостаточно.

Свой обзор ртх 4090 выпустил уже каждый уважающий себя техноблогер, так что информации о работе карты сейчас предостаточно.

Так, например, RTX 4090 — это первая видеокарта, которая в принципе смогла выдать 60 кадров в секунду (fps) в Cyberpunk 2077 на высоких настройках графики и с настоящим разрешением 4K. Более того, в тестировании TechSpot средний показатель составил целых 83 fps, серьезно оторвавшись от предыдущего лидера в лице прошлого флагмана RTX 3090 Ti.

В других тестах также никто не смог сравниться с видеокартой, причем в более высоком разрешении разрыв был сильнее. Так, например, в 1440p RTX 4090 обогнала предыдущие флагманы на 44-45%, а в 4K — уже на 59 и 71% соответственно. Временами разница между RTX 4090 и предыдущей самой мощной видеокартой Nvidia RTX 3090 Ti была практически двукратной:

- Watch Dogs: Legion в 4К и на очень высоких настройках: в среднем 141 fps у RTX 4090 и 88 fps у 3090 Ti;

- Horizon Zero Dawn в 4K и на ультра-настройках: в среднем 157 fps у RTX 4090 и 102 fps у 3090 Ti;

- Far Cry 6 в 4K и на ультра-настройках: в среднем 164 fps у RTX 4090 и 109 fps у 3090 Ti;

- Forza Horizon 5 в 4K и на экстремальных настройках: в среднем 147 fps у RTX 4090 и 94 fps у 3090 Ti.

После таких грандиозных показателей должно быть понятно, чем обусловлена ртх 4090 цена — ведь это первая видеокарта, способная тянуть все современные игры на максимальных настройках в высочайшем разрешении.

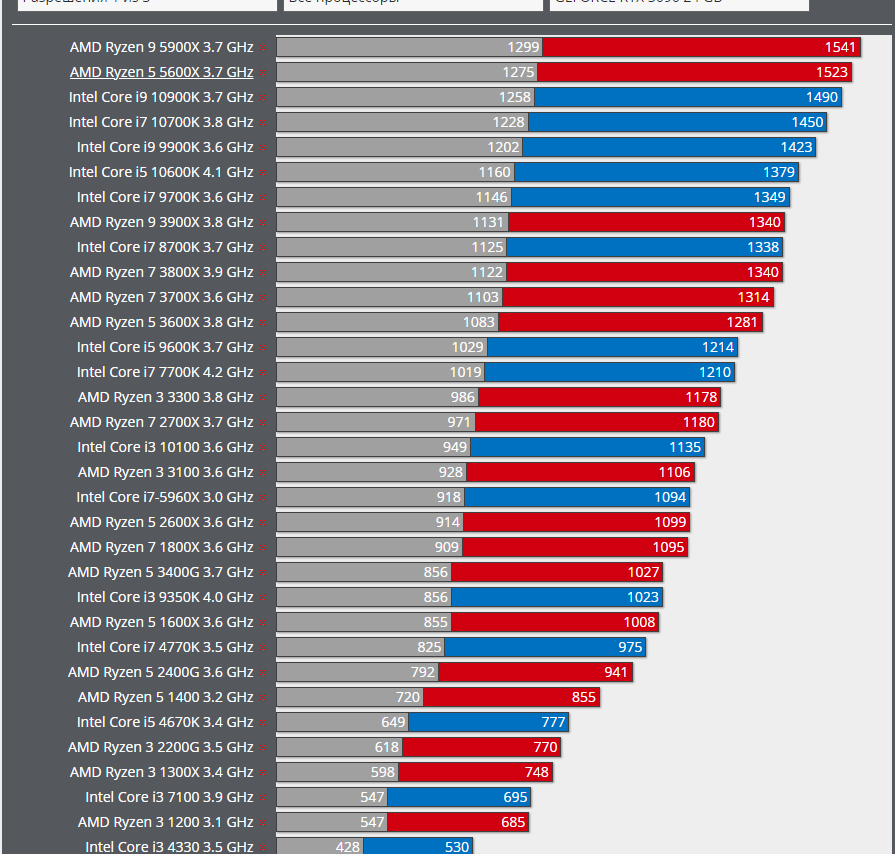

При этом в 1080p разница между графическими ускорителями не такая большая. Эксперты уверены, что проблема в современных процессорах — они становятся «бутылочным горлышком», поскольку не способны справляться со своей работой настолько же эффективно, как и RTX 4090. Несмотря на огромный задел на будущее, покупать новинку в разрешении Full HD не стоит — достаточно взглянуть на средние показатели среди топовых видеокарт.

DLSS 3.0

Еще одна отличительная особенность видеокарт от Nvidia — технология DLSS. Эта собственная разработка компании позволяет улучшить производительность за счет достраивания изображения с помощью нейронных сетей. Проще говоря, видеокарта обрабатывает картинку в более низком разрешении и делает это более быстро, а нейронные сети доводят изображение до нужной кондиции.

Новую версию DLSS 3.0 смогут опробовать только обладатели видеокарт серии RTX 40xx, и показатели RTX 4090 в играх с использованием этой технологии вырастают в два раза.

Так, например, видеокарта ртх 4090 в Cyberpunk 2077 со включенным на «ультра» рейтрейсингом в 4K и с максимальными настройками графики выдает 45 fps, а с DLSS 3.0 — 160. В свежей Marvel’s Spider-Man этот показатель при аналогичных настройках с применением технологии вырастает со 107 fps до 215.

Учитывая, что поддержку DLSS внедряют практически во все новинки, у RTX 4090 огромный запас на будущее, и ее владельцы еще долгие годы смогут играть во все новые игры на максимальных настройках в высочайшем разрешении.

Энергопотребление и нагрев

Однако отвечая себе на вопрос «сколько стоит ртх 4090», стоит помнить и о том, какое у rtx 4090 питание. Уже упомянутое энергопотребление в 450 Ватт встанет в копеечку и при покупке блока питания, и в счете за электричество, ведь при игре на максимальных настройках в Cyberpunk 2077 видеокарта действительно забирает порядка 405-415 Ватт.

Также стоит учитывать и то, что при высоких нагрузках карта заметно греется. Специалисты Digital Foundry зафиксировали максимальную температуру в 83 градуса внутри закрытого корпуса ПК — температура помещения в это время составляла 21 градус, тактовая частота чипа была порядка 2730 МГц, а среднее энергопотребление было около 410 Ватт.

Вывод

Подытоживая наш краткий обзор geforce rtx 4090, можно сказать, что это самая мощная игровая видеокарта на данный момент. Она способна запустить любые игры в 4K разрешении на максимальных настройках и выдать достойный fps, и сможет это делать ближайшие годы. Несмотря на огромное потребление энергии, карта все равно высокоэнергоэффективна в сравнении со своей производительностью. Так что приобретая RTX 4090, любой геймер будет обеспечен отличной графикой на годы вперед.

Присылайте нам свои обзоры техники и получайте до 1000 бонусов на карту «Эльдорадости»!

обзор характеристик и тесты производительности в играх

Видеокарта RTX A3000 Mobile была выпущена компанией NVIDIA. Видеокарта построена на архитектуре Ampere с кодовым названием GA104.

Видеокарта построена на архитектуре Ampere с кодовым названием GA104.

Частота ядра — 1080 MHz. Частота ядра в режиме Boost — 1560 MHz. Скорость текстурирования — 199.7 GTexel/s. Количество шейдерных процессоров — 4096. Технологический процесс — 8 nm. Количество транзисторов — 17400 million. Энергопотребление (TDP) — 130 Watt.

Тип памяти: GDDR6. Максимальный размер памяти — 6 GB. Ширина шины памяти — 192 bit. Частота памяти — 1500 MHz (12 Gbps effective). Пропускная способность памяти — 288 GB/s.

Бенчмарки

| PassMark G2D Mark |

|

| ||||

| PassMark G3D Mark |

|

| ||||

GFXBench 4. 0 0Car Chase Offscreen |

|

| ||||

| GFXBench 4.0 Car Chase Offscreen |

|

| ||||

| GFXBench 4.0 Manhattan |

|

| ||||

GFXBench 4. 0 0Manhattan |

|

| ||||

| GFXBench 4.0 T-Rex |

|

| ||||

| GFXBench 4.0 T-Rex |

|

| ||||

| Geekbench OpenCL |

|

|

| Название | Значение |

|---|---|

| PassMark — G2D Mark | 473 |

| PassMark — G3D Mark | 12640 |

| GFXBench 4.0 — Car Chase Offscreen | 20429 Frames |

GFXBench 4. 0 — Car Chase Offscreen 0 — Car Chase Offscreen | 20429.000 Fps |

| GFXBench 4.0 — Manhattan | 3710 Frames |

| GFXBench 4.0 — Manhattan | 3710.000 Fps |

| GFXBench 4.0 — T-Rex | 3356 Frames |

| GFXBench 4.0 — T-Rex | 3356.000 Fps |

| Geekbench — OpenCL | 80148 |

Характеристики

| Архитектура | Ampere |

| Кодовое имя | GA104 |

| Место в рейтинге | 129 |

| Частота ядра в режиме Boost | 1560 MHz |

| Частота ядра | 1080 MHz |

| Технологический процесс | 8 nm |

| Peak Double Precision (FP64) Performance | 199. 7 GFLOPS (1:64) 7 GFLOPS (1:64) |

| Peak Half Precision (FP16) Performance | 12.78 TFLOPS (1:1) |

| Peak Single Precision (FP32) Performance | 12.78 TFLOPS |

| Количество шейдерных процессоров | 4096 |

| Pixel fill rate | 99.84 GPixel/s |

| Скорость текстурирования | 199.7 GTexel/s |

| Энергопотребление (TDP) | 130 Watt |

| Количество транзисторов | 17400 million |

|

| |

| Видеоразъёмы | No outputs |

| Интерфейс | PCIe 4. 0 x16 0 x16 |

| Дополнительные разъемы питания | None |

| DirectX | 12.2 |

| OpenCL | 3.0 |

| OpenGL | 4.6 |

| Shader Model | 6.6 |

| Vulkan | |

| Максимальный размер памяти | 6 GB |

| Пропускная способность памяти | 288 GB/s |

| Ширина шины памяти | 192 bit |

| Частота памяти | 1500 MHz (12 Gbps effective) |

| Тип памяти | GDDR6 |

Навигация

Выберите видеокарту

Сравнение видеокарт

Сравнение NVIDIA RTX A3000 Mobile с другими видеокартами

NVIDIA

RTX A3000 Mobile

vs

AMD

Radeon PRO WX 9100

NVIDIA

RTX A3000 Mobile

vs

NVIDIA

Tesla V100 PCIe 32 GB

NVIDIA

RTX A3000 Mobile

vs

AMD

Radeon RX 580X

NVIDIA

RTX A3000 Mobile

vs

NVIDIA

GeForce RTX 2070 Max-Q

NVIDIA

RTX A3000 Mobile

vs

NVIDIA

Quadro RTX 4000

NVIDIA

RTX A3000 Mobile

vs

AMD

Radeon Pro Vega 64X

Обзоры видеокарт Nvidia | PCMag

Редакторы PCMag самостоятельно выбирают и рецензируют продукты. Если вы покупаете по партнерским ссылкам, мы можем получать комиссионные, которые помогают поддерживать наше тестирование.

Если вы покупаете по партнерским ссылкам, мы можем получать комиссионные, которые помогают поддерживать наше тестирование.

Популярные бренды видеокарт

Все видеокарты

Последние обзоры видеокарт Nvidia

Nvidia GeForce RTX 4070 Ti обладает высокой производительностью, и это может быть отличная видеокарта… но только если цена будет подходящей.

$999,99

в B&H Фото Видео

(Открывается в новом окне)

04.01.2023

К

Майкл Джастин Аллен Секстон

GeForce RTX 4080 Founders Edition от Nvidia отлично подходит для игр в разрешении 4K, но эта гигантская видеокарта находится в сложном ценовом сегменте: геймеры, мотивированные потратить столько денег, скорее всего, перейдут на еще более быструю RTX 4090. технический триумф и карта, с которой нужно считаться.

1199,99 долларов США

по лучшей цене

(Открывается в новом окне)

15.11.2022

К

Майкл Джастин Аллен Секстон

4. 0

0

Выбор редакции

Огромная GeForce RTX 4090 Founders Edition от Nvidia — невероятно мощный дебют архитектуры «Ады Лавлейс». Единственный вопрос: вам действительно нужна такая мощность?

2389,00 долларов США

на Амазонке

(Открывается в новом окне)

11.10.2022

К

Майкл Джастин Аллен Секстон

Если вам нужна одна из самых быстрых видеокарт в мире, а стоимость не имеет значения, Nvidia GeForce RTX 3090 Founders Edition — прекрасный выбор. Но если деньги вообще имеют значение, другие графические процессоры GeForce RTX являются лучшим выбором.

1498,88 долларов США

на Амазонке

(Открывается в новом окне)

09.08.2022

К

Майкл Джастин Аллен Секстон

Zotac GeForce RTX 3080 Ti AMP HoloBlack лидирует в чартах по производительности игровой графики, но его цена второго ипотечного уровня пугает даже до того, как инфляция на рынке графических процессоров в 2021 году ударит по нему.

1799,99 долларов США

в Ньюэгг

(Открывается в новом окне)

14. 06.2021

06.2021

К

Крис Стобинг

4.0

Выбор редакции

GeForce RTX 3070 Ti Founders Edition от Nvidia — это надежное обновление оригинальной RTX 3070 и разумный вариант для умеренной игры в разрешении 4K. Его более высокая цена противопоставляет его Radeon RX 6800, который временами превосходит его, но в конечном итоге карта GeForce побеждает.

599,99 долларов США

по лучшей цене

(Открывается в новом окне)

09.06.2021

К

Крис Стобинг

GeForce RTX 3080 Ti Founders Edition от Nvidia — еще одно потрясающее дополнение к линейке RTX 30 Series Founders и настоящий монстр для игр в разрешении 4K. Просто будьте готовы заплатить несоразмерную надбавку по сравнению с RTX 3080 за дополнительную мощность.

1349,98 долларов США

на Амазонке

(Открывается в новом окне)

02.06.2021

К

Крис Стобинг

Подходящая для игр с разрешением 1080p и 1440p версия EVGA XC Black Gaming 12G для GeForce RTX 3060 является способной производительностью, хотя собственная RTX 3060 Ti от Nvidia превосходит ее по стоимости.

$579,00

на Амазонке

(Открывается в новом окне)

25.02.2021

К

Крис Стобинг

4,5

Выбор редакции

Если вам нужно лучшее сочетание цены, производительности и возможностей для игр с разрешением 4K и 1440p, GeForce RTX 3060 Ti Founders Edition от Nvidia может сравниться только с ее родным братом RTX 3070. Эта карта имеет цену в 399 долларов и обеспечивает большую ценность.

469,99 долларов США

на Амазонке

(Открывается в новом окне)

01.12.2020

К

Крис Стобинг

5,0

Выбор редакции

Прекрасно спроектированная видеокарта RTX 3070 Founders Edition от Nvidia, ставшая продолжением своего убийцы GeForce RTX 3080, является практически идеальной видеокартой. Геймеры, стремящиеся к играм с высоким разрешением, высокой частотой обновления 1440p или 4K, найдут здесь лучший на сегодняшний день движок по соотношению цена-качество.

579,99 долларов США

на Амазонке

(Открывается в новом окне)

27. 10.2020

10.2020

К

Крис Стобинг

Одна из версий Asus для убийственной RTX 3080, TUF Gaming GeForce RTX 3080 OC с тремя вентиляторами и длинной по сравнению с уникальной схемой охлаждения RTX 3080 Founders Edition. Это солидный спидстер, но он не может превзойти собственные усилия Nvidia на стандартных скоростях.

749,99 долларов США

в Ньюэгг

(Открывается в новом окне)

15.10.2020

К

Крис Стобинг

На первый взгляд, GeForce RTX 3080 Gaming X Trio 10G от MSI — это самая быстрая сторонняя версия RTX 3080, которую мы когда-либо видели, но ее титанический корпус и чрезмерные (тройные!) требования к разъему блока питания требуют от покупателей дополнительного внимания. .

759,99 долларов США

в Ньюэгг

(Открывается в новом окне)

15.10.2020

К

Крис Стобинг

4,5

Выбор редакции

Если вы являетесь нынешним (или начинающим) игроком в 4K, свирепая, революционная видеокарта Nvidia GeForce RTX 3080 — единственная, на которую стоит обратить внимание.

1103,99 долларов США

на Амазонке

(Открывается в новом окне)

16.09.2020

К

Крис Стобинг

4.0

Выбор редакции

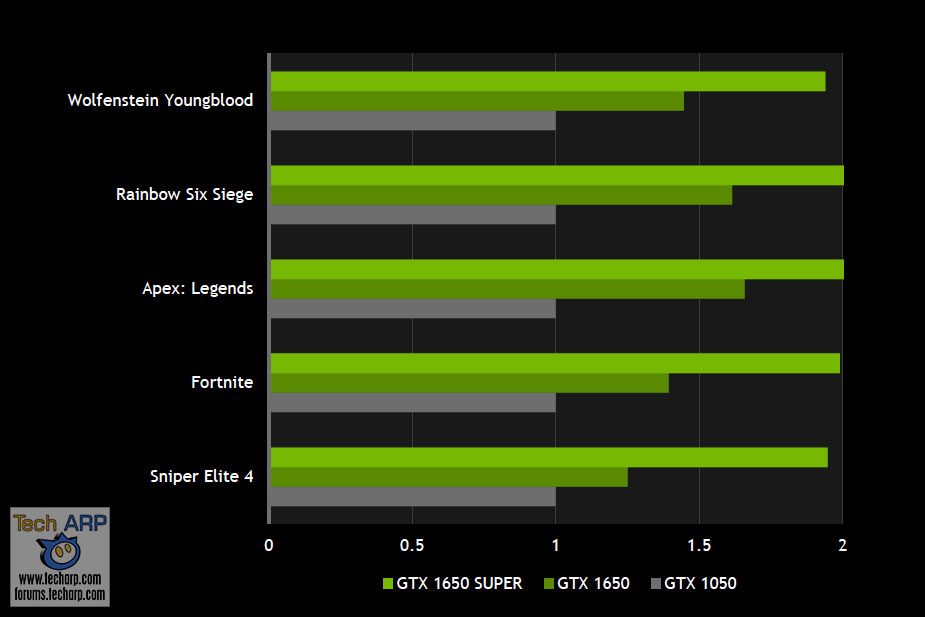

Мощный GeForce GTX 1650 Super Twin Fan от Zotac заметно лучше, чем не-Super GTX 1650 и надежная версия этого основного графического процессора. Это дает геймерам с ограниченным бюджетом 1080p лучший вариант по сравнению с конкурирующими картами AMD в той же ценовой категории.

$172,99

на Амазонке

(Открывается в новом окне)

12.12.2019

К

Крис Стобинг

4.0

Выбор редакции

Если вы откладывали покупку основной видеокарты для игр с разрешением 1080p, GeForce GTX 1660 Super может стать для вас поводом для покупки: это надежно играющая и популярная по цене промежуточная точка между GTX 1660 и GTX. 1660 Ти.

239,99 долларов США

на Амазонке

(Открывается в новом окне)

29.10.2019

К

Крис Стобинг

Он не обеспечивает такого скачка производительности, как другие карты Nvidia RTX Super, но GeForce RTX 2080 Super — это мощная игровая видеокарта 4K, которая лучше оригинала, сохраняя при этом свою цену.

$849,95

на Амазонке

(Открывается в новом окне)

23.07.2019

К

Крис Стобинг

4,5

Выбор редакции

Обладая производительностью, близкой к RTX 2080, и аналогичными характеристиками, видеокарта Nvidia GeForce RTX 2070 Super идеально подходит для надежной игры в разрешении 4K с частотой 60 Гц и игрового процесса с высокой частотой обновления при разрешении 1440p. Это убийственная карта за деньги.

699,99 долларов США

на Амазонке

(Открывается в новом окне)

02.07.2019

К

Крис Стобинг

GeForce RTX 2060 Super от Nvidia находится на тонкой грани между видеокартой, созданной для киберспорта, и картой для игр AAA, и обеспечивает стабильную производительность с каждой стороны, где это наиболее важно.

799,99 долларов США

на Амазонке

(Открывается в новом окне)

02.07.2019

К

Крис Стобинг

GeForce GTX 1650 XLR8 Gaming Overclocked Edition от PNY — приемлемая компактная видеокарта для игр с разрешением 1080p, но цена должна значительно снизиться.

2200,26 долларов США

на Амазонке

(Открывается в новом окне)

30.04.2019

К

Крис Стобинг

Новейший графический процессор Nvidia для массового рынка, GeForce GTX 1660, предназначен для геймеров, которым требуется стабильная производительность со скоростью более 60 кадров в секунду в играх AAA с разрешением 1080p и даже более высокая частота кадров для киберспортивных игр. Версия Gigabyte OC хорошо справляется с этими задачами.

289,99 долларов США

на Амазонке

(Открывается в новом окне)

14.03.2019

К

Крис Стобинг

Реклама

Nvidia GeForce RTX 4090 Обзор: Королева замка

Когда вы покупаете по ссылкам на нашем сайте, мы можем получать партнерскую комиссию. Вот как это работает.

Выбор редакции

(Изображение: © Tom’s Hardware)

Аппаратный вердикт Тома

RTX 4090 отличается технологичностью и производительностью, легко превосходя предложения предыдущего поколения. Благодаря значительным усовершенствованиям всего основного оборудования и значительно более высоким тактовым частотам, а также перспективным технологиям, таким как DLSS 3, новая планка была установлена очень высоко — с такой же высокой ценой.

Благодаря значительным усовершенствованиям всего основного оборудования и значительно более высоким тактовым частотам, а также перспективным технологиям, таким как DLSS 3, новая планка была установлена очень высоко — с такой же высокой ценой.

ЛУЧШИЕ ПРЕДЛОЖЕНИЯ СЕГОДНЯ

Плюсы

- +

Самый быстрый графический процессор, в настоящее время доступный

- +

Основные архитектурные улучшения

- +

DLSS 3 Адреса CPU CPU.

Минусы

- —

Экстремальная цена и мощность

- —

Ограниченное усиление при разрешении 1440p и ниже

- —

Внедрение DLSS 3 потребует времени

- —

Нам нужно увидеть AMD RDNA 3

- —

Неизбежный RTX 4090 Ti вырисовывается

Почему вы можете доверять Tom’s Hardware

Наши эксперты-рецензенты часами тестируют и сравнивают продукты и услуги, чтобы вы могли выбрать лучшее для себя. Узнайте больше о том, как мы тестируем.

Рекламный поезд Nvidia GeForce RTX 4090 создавался большую часть 2022 года. После более чем года экстремальных цен и нехватки графических процессоров генеральный директор Дженсен Хуанг сообщил, что ключевых деталей в GTC 2022 по цене, которая наверняка заставит многих вскрикнуть от отчаяния. 1599 долларов за топ-предложение от архитектуры Ады Лавлейс от Nvidia ? На самом деле, это всего на 100 долларов больше, чем у RTX 3090 при запуске, и если карта сможет приблизиться к заявлениям Nvidia о 2-4-кратном повышении производительности по сравнению с RTX 3090 Ti, несомненно, найдутся люди, готовые заплатить. RTX 4090 теперь находится на вершине в иерархии тестов GPU , по крайней мере, в 1440p и 4K. Для тех, кто ищет самый быстрый графический процессор, не говоря уже о цене, он теперь входит в число лучшие видеокарты .

Это не значит, что RTX 4090 представляет собой хорошее значение , хотя это может быть немного субъективно. Глядя только на FPS, обеспечиваемый различными графическими процессорами на потраченный доллар, он занимает последнее место среди 68 графических процессоров за последнее десятилетие.

За исключением того, что наш стандартный рейтинг использует сверхпроизводительность 1080p, и 4090 определенно не является картой, предназначенной для превосходства в 1080p. На самом деле, это так быстро, что узкие места процессора все еще вызывают беспокойство даже при игре в разрешении 1440p Ultra. Посмотрите на производительность 4K и учтите трассировку лучей, и вы можете утверждать, что это, возможно, один из лучших значений — понимаете, что мы имеем в виду, говоря, что значение является субъективным?

За исключением того, что наш стандартный рейтинг использует сверхпроизводительность 1080p, и 4090 определенно не является картой, предназначенной для превосходства в 1080p. На самом деле, это так быстро, что узкие места процессора все еще вызывают беспокойство даже при игре в разрешении 1440p Ultra. Посмотрите на производительность 4K и учтите трассировку лучей, и вы можете утверждать, что это, возможно, один из лучших значений — понимаете, что мы имеем в виду, говоря, что значение является субъективным?Опять же, вы дорого заплатите за привилегию владеть картой RTX 4090, поскольку базовая модель RTX 4090 Founders Edition стоит 1599 долларов, а партнерские карты могут поднять цену до 1999 долларов. Но для тех, кто хочет лучшего, или для тех, у кого достаточно глубокие карманы, чтобы 2000 долларов не были большой проблемой, это карта, которую вы захотите получить прямо сейчас, и мы были бы удивлены, увидев, что что-то превзойдет ее в этом поколении. , если не считать будущей RTX 4090 Ти.

Swipe to scroll horizontally

Current Top-Tier GPU Specifications Graphics Card RTX 4090 RTX 3090 Ti RTX 3090 RTX 3080 Ti RX 6950 XT Arc A770 16GB Архитектура AD102 GA102 GA102 GA102 GA102 GA102 GA102 GA102 .2)

608.4 628.4 628.4 628.4 519 406 SMs / CUs / Xe-Cores 128 84 82 80 80 32 GPU Shaders 16384 10752 10496 10240 5120 4096 Tensor Cores 512 336 328 320 N/A 512 Ray Tracing «Cores» 128 84 82 80 80 32 Boost Clock (MHz) 2520 1860 1695 1665 2310 2100 VRAM Speed (Gbps) 21 21 19.  5

519 18 17.5 VRAM (GB) 24 24 24 12 16 16 VRAM Bus Width 384 384 384 384 256 256 L2 / Infinity Cache 72 6 6 6 128 16 ROPs 176 112 112 112 128 128 TMUs 512 336 328 320 320 256 TFLOPS FP32 82.  6

640 35.6 34.1 23.7 17.2 TFLOPS FP16 (FP8/INT8) 661 (1321) 160 (320) 142 (285) 136 (273) 47.4 138 (275) Bandwidth (GBps) 1008 1008 936 912 576 560 TDP (watts) 450 450 350 350 335 225 Дата запуска Октябрь 2022 МАР 2022 SEP 2020 Jun 2021 May 202281 jun 2021 May 202281 jun 2021 May 202281 $ 2021 .  9

9$1,999 $1,499 $1,199 $1,099 $349 Here’s a look at the who’s who of the extreme performance graphics card world, with the fastest cards from Nvidia, AMD, and now Intel. Очевидно, что Intel Arc A770 конкурирует на совершенно другом игровом поле, но все же интересно показать, как он выглядит на бумаге.

Мы собираемся просто отослать вас к нашему глубокому архитектурному погружению Nvidia Ada Lovelace , если вы хотите узнать обо всех новых технологиях и изменениях, внесенных в серию RTX 40. Приведенная выше таблица характеристик говорит многое из того, что вам нужно знать. Количество транзисторов увеличилось почти втрое по сравнению с Ampere; количество ядер у RTX 4090 на 52% выше, чем у RTX 3090 Ti; Тактовые частоты графического процессора на 35% выше, а память GDDR6X? Он по-прежнему в основном не изменился, за исключением того, что теперь кэш L2 увеличен в 12 раз, чтобы GPU не запрашивал данные из памяти так часто.

На бумаге это дает RTX 4090 чуть более чем вдвое превышает вычислительную производительность RTX 3090 Ti, и определенно есть рабочие нагрузки, при которых вы увидите именно такой прирост. Но под капотом есть и другие изменения, которые могут еще больше увеличить разрыв.

Трассировке лучей снова уделяется большое внимание, а три новые технологии — переупорядочивание выполнения шейдеров (SER), микрокарты непрозрачности (OMM) и смещенные микросетки (DMM) — предлагают потенциальные улучшения. Однако они также требуют, чтобы их использовали разработчики, а это означает, что существующие игры и движки от этого не выиграют.

Рабочие нагрузки глубокого обучения и искусственного интеллекта также ждут масштабные улучшения. Ada включает в себя Transformer Engine FP8 от Hopper h200 , а также поддержку формата чисел FP8. Это означает удвоение вычислительной мощности на ядро Tensor для алгоритмов, которые могут использовать FP8 вместо FP16, и до четырех раз большую вычислительную мощность по сравнению с 3090 Ti.

Один из алгоритмов, который может использовать новые ядра Tensor вместе с улучшенным ускорителем оптического потока (OFA), — это DLSS 3. Фактически, Для DLSS 3 требуется видеокарта RTX 40-й серии , поэтому более ранние карты RTX не будут работать. Что делает DLSS 3? Он берет текущий и ранее обработанные кадры и создает дополнительный промежуточный кадр, чтобы заполнить пробел. В некоторых случаях он может почти удвоить производительность по сравнению с DLSS 2. Мы более подробно рассмотрим DLSS 3 позже в этом обзоре.

С профессиональной точки зрения, особенно для тех, кто интересуется глубоким обучением, вы можете легко оправдать стоимость RTX 4090 — время — деньги, а удвоение или учетверение пропускной способности определенно сэкономит время. Создатели контента найдут для себя много интересного, и это быстрое и простое обновление с 3090 или 3090 Ti на 4090. Мы также рассмотрим производительность ProViz.

А как же геймеры? В отличие от RTX 3090 и 3090 Ti, Nvidia не говорит о том, что RTX 4090 предназначена для профессионалов.

Да, для таких людей он отлично подойдет, но он также является частью семейства GeForce, и Nvidia не сдерживает своих заявлений о производительности в играх и сравнений. Возможно, виноваты последние два года майнинга криптовалюты, хотя майнинг на GPU теперь убыточен , так что, по крайней мере, геймерам не придется драться с майнерами за карты в этом раунде.

Да, для таких людей он отлично подойдет, но он также является частью семейства GeForce, и Nvidia не сдерживает своих заявлений о производительности в играх и сравнений. Возможно, виноваты последние два года майнинга криптовалюты, хотя майнинг на GPU теперь убыточен , так что, по крайней мере, геймерам не придется драться с майнерами за карты в этом раунде.- MORE: Best Graphics Cards

- MORE: GPU Benchmarks and Hierarchy

- MORE: All Graphics Content

- Nvidia RTX 4090 at Amazon for $1,889.67

Nvidia RTX 4090: Сравнение цен

15 отзывов покупателей Amazon (открывается в новой вкладке)

☆☆☆☆☆

(открывается в новой вкладке)

(открывается в новой вкладке)0003

$ 1,709,99

(Opensen in New Tab)

Просмотр (Opens in New Tab)

(Opens in New Tab)

(Opens In New Tab)

$ 1 889,67

(Opens In New)

667

(Opens in new)

667

(Opens In New)

667.

(открывается в новой вкладке)

(открывается в новой вкладке)(открывается в новой вкладке)

(открывается в новой вкладке)

(открывается в новой вкладке)

2 129,99 $

(открывается в новой вкладке)

вкладка)

Вид (открывается в новой вкладке)

Цена со скидкой

(открывается в новой вкладке)

(открывается в новой вкладке)

2 499,99 $

(открывается в новой вкладке)

2 130 $

(открывается в новой вкладке 3)

Цена снижена

на базе

- 1

Текущая страница:

Встречайте Nvidia GeForce RTX 4090Следующая страница Nvidia GeForce RTX 4090 Founders Edition

Джарред Уолтон — старший редактор Tom’s Hardware, специализирующийся на GPU.

Он работает техническим журналистом с 2004 года, пишет для AnandTech, Maximum PC и PC Gamer. От первых «3D-замедлителей» S3 Virge до современных графических процессоров — Джарред следит за всеми последними графическими тенденциями и всегда задает вопросы о производительности игр.

Он работает техническим журналистом с 2004 года, пишет для AnandTech, Maximum PC и PC Gamer. От первых «3D-замедлителей» S3 Virge до современных графических процессоров — Джарред следит за всеми последними графическими тенденциями и всегда задает вопросы о производительности игр.Обзор

Nvidia GeForce RTX 4070 Ti: дорогой графический процессор класса 70

При покупке по ссылкам на нашем сайте мы можем получать партнерскую комиссию. Вот как это работает.

(Изображение: © Tom’s Hardware)

Аппаратный вердикт Тома

RTX 4070 Ti знаменует собой третью запись в обзоре Ады Лавлейс, снижая цену входа до почти приемлемых 799 долларов. Исходная производительность в основном на уровне RTX 3090, но с вдвое меньшей памятью и более низким энергопотреблением, в то время как DLSS 3 надеется сделать картину производительности немного более радужной.

Плюсы

- +

Большой прыжок в производительности поколений

- +

Очень эффективная видеокарта

- +

DLSS 3 мая.

И все же, доказывающая полезной

И все же, доказывающая полезной - +

Good Ray Tracing Hardware

- +

Good Ray Tracing Hardware

7

7

- —

- +

Good Ray TrageWare

- +

.

Минусы- —

Большой скачок в цене

- —

DLSS 3 увеличивает задержку

- —

Бесполезный 16-контактный разъем питания

Почему вы можете доверять Tom’s Hardware