1000 geforce: Видеокарты GeForce GTX 10

3DNews Технологии и рынок IT. Новости разработка и производство электроники NVIDIA планирует Самое интересное в обзорах 12.04.2016 [09:00], Алексей Степин Не столь давно мы публиковали таблицу, содержавшую предположительные характеристики новых игровых карт NVIDIA на базе архитектуры Pascal. Таблица эта, по мнению большинства наших сотрудников и читателей, больше всего походила на плохо сделанную подделку, поскольку автор не учёл, что одновременная реализация абсолютно разных интерфейсов памяти в одном ядре если и не невозможна, то весьма затруднена и абсолютно невыгодна никому. Всё ближе Computex и всё точнее и подробнее становятся данные, проскальзывающие то тут, то там. На этот раз стало известно, что NVIDIA разработала два эталонных дизайна для серии GeForce GTX 1000. В эту серию войдут, как известно, GeForce GTX 1080 — будущий флагман, который переймёт знамя лидера у GeForce GTX 980 Ti, и более «народный» GeForce GTX 1070. Оба они будут использовать чип GP104 в различных конфигурациях: по ряду версий старшая модель получит 2048 полностью активных процессоров CUDA, а младшая — 1664 таких процессора, по аналогии с GeForce GTX 970. Это утверждение не точно: во-первых, вполне возможно, что активных ядер у GeForce GTX 1070 будет больше — главное, чтобы не повторилась история с конфигурацией видеопамяти GeForce GTX 970, а во-вторых, некоторые источники полагают, что ядер CUDA в GP104 будет 2560. В этом случае возможны варианты с 2560 и 2048 активными ядрами соответственно. Чипы будут маркироваться как GP104-400 и GP104-200. GP104: по разным оценкам от 290 до 310 квадратных миллиметров. Рядом новая память Samsung В чём же различие и зачем NVIDIA два эталонных дизайна печатной платы для одного графического ядра? Дело в том, что обе карты получат 256-битную шину памяти, а для старшей модели это определённо шаг назад в сравнении с GeForce GTX 980 Ti и её 384-битной шиной. Конфигурация одного потокового мультипроцессора (SM) Pascal GP100: 6/10/64 Но от нехватки производительности решения на базе GP104 страдать не будут. Архитектура Pascal была очень сильно переработана и усовершенствована по сравнению с Maxwell. Каждое ядро CUDA стало более мощным за счёт перехода на более тонкий техпроцесс, и благодаря ему же тактовые частоты в новой архитектуре удалось поднять на 33 %. Предположительно, кожухи систем охлаждения новых карт NVIDIA Единственное, что можно утверждать сейчас — GeForce GTX 1070 станет настоящей звездой продаж: при производительности уровня GeForce GTX 980 Ti он будет существенно дешевле и доступнее для рядового любителя игр. Но за кошелёк потенциального покупателя ему придётся побороться с решениями AMD на базе ядра Polaris 10, а ведь существует мнение, что как минимум в одной из своих реализаций Polaris 10 превзойдет GeForce GTX 980 Ti. Остаётся только дождаться появления всех этих карт в нашей тестовой лаборатории — битва за корону лучшего 3D-ускорителя нового поколения обещает быть весьма захватывающей. Источники: Если вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER. Материалы по теме Постоянный URL: https://3dnews.ru/931328 Рубрики: Теги: ← В |

Оптимизация современных видеокарт Nvidia на примере GeForce RTX 2080 и 2080 Super — Железо на DTF

Минус 30% энергопотребления с 5% ростом производительности, а также небольшой опрос в конце материала

17 844

просмотров

В мае 2016 Nvidia представила публике GTX 1000 серию видео ускорителей с одним из самых высоких показателей производительности в расчете на энергопотребление. Произошло это в том числе благодаря использованию новой системы регулирования частоты/напряжения — Curve — кривая частот-напряжений, или в простонародье — «курва». И начиная с 1000 серии у пользователя появилась в распоряжении гибкая система настройки видеокарты относительно возможности ее элементной базы и удачливости кремния в кристаллах графического процессора и памяти.

Произошло это в том числе благодаря использованию новой системы регулирования частоты/напряжения — Curve — кривая частот-напряжений, или в простонародье — «курва». И начиная с 1000 серии у пользователя появилась в распоряжении гибкая система настройки видеокарты относительно возможности ее элементной базы и удачливости кремния в кристаллах графического процессора и памяти.

В данном материале я поведаю читателю, что это за «курва» такая? Как она позволяет гибко настраивать работу видеокарты под различные условия ее эксплуатации? Каким образом происходит процесс настройки с различными подводными камнями? И конечно же какой результат от всего этого пользователь может получить?

Оглавление

- Подопытные

- Понимание основ

- Настройка частоты/напряжения чипа

- Настройка памяти

- Тестирование

- Настройка системы охлаждения

- Опрос

Подопытные: железо и программное обеспечение

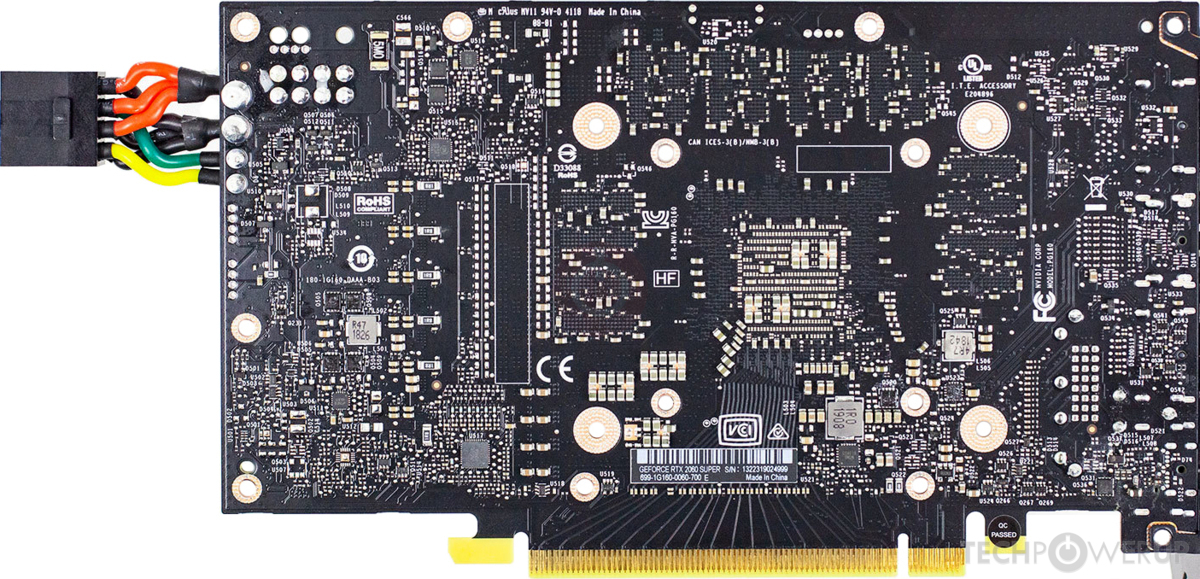

В качестве подопытных я буду использовать видеокарты 8GB GeForce RTX 2080 Super от Asus в исполнении Strix и 8GB GeForce RTX 2080 Palit JetStream — оба ускорителя с качественными элементной базой и СО, но первый на чипе из более отборной серии.

ПО для настройки, проверки и тестирования:

- MSI Afterburner — основная программа, через которую буду осуществлять все манипуляции. Мощный комбайн, позволяющий управлять работой видеокарты, через RTSS выводить в оверлей различную информацию, делать скриншоты, записывать видео, через Kombustor запускать различные тесты для проверки производительности и стабильности и многое другое. Аналог EVGA Precision X обладает меньшим функционалом, потому нравится мне много меньше.

- GPU-Z — небольшое ПО, по желанию запускающееся без установки и позволяющее просматривать информацию о видеокарте, снимать информацию с ее датчиков, и читать параметры bios.

- 3DMark — тесты производительности и стресс тесты видео компонента ПК и мобильных устройств.

- Unigine Superposition — еще одно средство для тестирования графической производительности в нескольких режимах качества.

- Metro Exodus Enchanced Edition — обновленная версия игры, бенчмарк которой позволяет комплексно задействовать современный GPU от Nvidia: блоки растеризации, трассировки и тензорные ядра.

Используйте для проверки другие программы и игры, которыми чаще всего нагружаете свой видео адаптер, и в которых хотите исследовать изменением производительности.

Понимание основ

Кроме очевидных вещей в виде остальных компонентов ПК и элементной базы самого видеоускорителя его производительность в основном зависит от предела энергопотребления и качества кристаллов GPU и памяти. Чем более дорогого модельного класса видеокарта (Dual < Gaming Pro < JetStream < GameRock на примере RTX 2000 от Palit), тем более отборные чипы в нее попадают и тем более дорогие компоненты подсистемы питания и системы охлаждения у нее оказываются. От всего этого напрямую зависит предел энергопотребления и curve — тот самый график частот/напряжений, который и поможет нам полноценно настроить видеокарту (открывается сочетанием Ctrl+F в активном окне Afterburner).

MSI Afterburner с открытым Curve Editor

При работе именно такой принцип устройства современных ускорителей Nvidia (как и AMD с RX 5000 серии) помогает им при неизменном пределе энергопотребления и переменной нагрузке динамически управлять напряжением, поступающим на GPU. Регулируя напряжение, изменяется и привязанную к нему частоту, достигая в любом момент времени максимальной для чипа производительности. Потому что на замену 2 режимам частоты/напряжения пришли 40 значений у GTX 1000 серии и 64 у GTX 1600 и RTX 2000/3000 серий в диапазоне от 700 до 1093 мВ.

Регулируя напряжение, изменяется и привязанную к нему частоту, достигая в любом момент времени максимальной для чипа производительности. Потому что на замену 2 режимам частоты/напряжения пришли 40 значений у GTX 1000 серии и 64 у GTX 1600 и RTX 2000/3000 серий в диапазоне от 700 до 1093 мВ.

Чем более дорогой адаптер, тем выше по частотам его curve настроена из коробки. Например у RTX 2080 в исполнении Dual или JetStream напряжению 1000 мВ соответствует 1815 МГц частота, у Gaming Pro это будет уже 1845 МГц, у Super JetStream — 1965 МГц, у GameRock Premium — 1980 МГц. Но корреляция качества кристалла с ценой модели не абсолютна. В моей практике попадались очень удачные чипы в среднеценовых моделях, как и наоборот — чипы в топовых моделях, работающие практически на пределе своего частотного запаса. Ведь при отборе главное, чтобы чип проходил все тесты при зашитой производителем curve. Плюс нельзя забывать, что в режиме из коробки современные видеокарты для настольного ПК функционируют в диапазоне напряжений 900-1050 мВ, что однозначно не свидетельствует о потенциале при меньших напряжениях, где GPU зачастую показывает большую эффективность частоты/напряжения. По итогу всего моего опыта могу заключить, что чаще всего это диапазон 750-850 мВ.

По итогу всего моего опыта могу заключить, что чаще всего это диапазон 750-850 мВ.

У видеопамяти к сожалению программно менять можно лишь частоту. Напряжение меняется самостоятельно в зависимости от параметров, зашитых в bios карты. Конечно за счет изменения программы микроконтроллера, управляющего питанием памяти, или набора резисторов можно изменить поступающее напряжение, но даже после недавнего слива Nvidia не все разбирающиеся специалисты сервисных центров успешно таким балуются.

Относительно разгона или даунвольта видеокарт на просторах интернета чаще рекомендуют для ускорения процесса пользоваться стандартным ползунком частоты чипа или устанавливать единую ровную планку частоты в Сurve Editor. Пользоваться единым регулятором частоты я не рекомендую, если стоит задача не просто разогнать видеоадаптер, но комплексно его настроить в том числе с уменьшение энергопотребления и нагрева с изменениями в ту или иную сторону его производительности. Ровную же планку частоты я не настраиваю, потому что в таком случае мы отбираем у чипа его сильную сторону в лице curve. Так мы не даем GPU в слабо нагруженных режимах использовать большие напряжения и соответственно частоту до достижения предела энергопотребления.

Так мы не даем GPU в слабо нагруженных режимах использовать большие напряжения и соответственно частоту до достижения предела энергопотребления.

Настройка частоты/напряжения чипа

- Устанавливаем и запускаем Afterburner.

- Активируем параметры на скриншоте.

- Повышаем лимиты температуры и энергопотребления, чтобы они нам меньше мешали.

- Включаем скорость вентиляторов на максимум, чтобы убрать или хотя-бы снизить влияние температурной корректировки (об этом ниже), удерживая последнюю в пределах 50-55°С.

- Сохраните настройки в 1 пресет, чтобы было проще к ним возвращаться.

- Чтобы не было дополнительного ограничения производительности, отключаем принудительную настройку вертикальной синхронизации и быстрого отклика в Панели управления Nvidia, если они у вас активированы например для корректной работы VRR (Variable Refresh Rate).

- Запускаем OS Scanner, даем Afternurner самостоятельно найти в меру безопасные частоты для четырех напряжений GPU и на их основе построить новую curve.

- Сохраните настройки во второй пресет.

В данном случае примерно на 90% результат по GPU закончен. Остальные 10% придется настроить вручную, но перед этим стоит осветить некоторую информацию:

- Частоты чипа меняются шагами в 12,5 МГц у GTX 1000 серии и 15 МГц у GTX 1600 — RTX 3000 серий.

- Максимальное напряжение чипа, доступное для настройки с повышением предела напряжения — 1093 мВ. Использовать его можно только через Сurve Editor, потому что в стандартную curve зашивается максимум 1050 мВ, доступное без увеличения предела напряжения. В LN2 биосах для экстремального разгона, распространяемых среди оверклокеров, доступно 1200 мВ.

- При превышении температуры 50-60°С по чипу (параметр зашит в биос) начинается сброс частоты чипа относительно настроенной в curve.

По одному шагу на каждые 5-6°С роста температуры. При приближении используемого напряжения к своему пределу сброс может происходить по 2 шага. Например настроенная в Сurve Editor при 50°С температуры по чипу 1950 МГц частота при напряжении 1000 мВ в момент75°С эксплуатации карты может легко превратиться в 1860-1890 МГц (-3-4 шага частоты).

По одному шагу на каждые 5-6°С роста температуры. При приближении используемого напряжения к своему пределу сброс может происходить по 2 шага. Например настроенная в Сurve Editor при 50°С температуры по чипу 1950 МГц частота при напряжении 1000 мВ в момент75°С эксплуатации карты может легко превратиться в 1860-1890 МГц (-3-4 шага частоты). - В биос карты зашит минимальный предел используемого ею напряжения при автоматической регулировке curve. У Asus Strix — это 775 мВ, а у Palit JetStream — 712 мВ. Вручную можно зафиксировать и меньшие напряжения.

- Ускорители в ноутбуках для большей энергоэффективности используют меньшие напряжения по сравнению с десктопными. Для расширения доступных пределов Curve Editor в папке Afterburner в файле MSIAfterburner. cfg найдите и измените по своему усмотрению параметры VFCurveEditor.

Итак, ручная настройка:

- Открываем Curve Editor.

- Запускаем GPU-Z и переключаемся на вкладку сенсоров.

- Устанавливаем и запускаем 3DMark. Настраиваем и запускаем тест FireStrike в оконном режиме. Нам понадобиться циклический прогон первого графического теста. Судя по моей практики он быстрее прочих и на более ранних этапах отсеивает нестабильные сочетания частот/напряжений. Вместо него можно использовать бесплатный Unigine Heaven, но по моему опыту он справляется с этой задачей чуть хуже.

Для классических настольных GPU нужно донастроить частоты для напряжений выше 1000 мВ, которые os scanner обычно качественно до предела напряжения не подбирает.

- Нажимаем на точку, соответствующую 1000mV, нажимаем L на клавиатуре, чтобы заблокировать используемое напряжение (тут можно найти информацию по всем горячим клавишам для взаимодействия c Curve Editor).

- Сдвигаем настроенную частоту мышкой или клавишами со стрелками вверх на один шаг. Двигаем по 3-4 точки, если одна не поддается.

- Применяем настройку и тестируем стабильность в течении 1 минуты в запущенном тесте.

- Иногда при указании минимального напряжения драйвер все равно может начать использовать большее или решит понизить на несколько шагов частоту в виду температурной корректировки. В таком случае снижаем и снова повышаем частоту нужного напряжения.

- Повторяем процедуру, пока в окне теста не начнут появляться артефакты (примеры ниже), или он не вылетит с перезапуском или без драйвера.

- В этот момент выключаем тест, снижаем частоту минимум на 4 шага назад для реализации большей стабильности во всех используемых приложениях, применяем настройку и сохраняем пресет.

- Повторяем тоже самое для 1050 и 1093 мВ напряжений.

- Не забудьте почаще сохранять пресет, чтобы в случае сбоя легко откатиться до последней успешной настройки.

- После нахождения всех частот, достраиваем смежные частоты согласно предыдущей части кривой, применяем настройку и сохраняем пресет.

Также можете попробовать вручную аналогичным образом найти частоты для других напряжений (700-1000 мВ). Но чаще всего os scanner уже справляется с этим эффективно, находя первую нестабильную частоту и отступая от нее 4-5 шагов для большей безопасности. Не гонитесь за каждым шагом: чем выше частота, тем шаг в процентном соотношении прироста будет значить меньше.

Для мобильных GPU тем же способом настройте напряжения ниже 700 мВ, разблокировав их видимость в Curve Editor по инструкции выше.

Так выглядели у меня процесс настройки на 4K экране и полученные в итоге результаты кривой:

После настройки чипа настоятельно советую прогнать тесты стабильности Firestrike, TimeSpy и Port Royal на ограничениях энергопотребления в 60, 80, 100% и максимальном значении, чтобы по максимуму проверить стабильность всех частот. Это конечно займет какое-то время, но вернется вам максимальной уверенностью в стабильности настройки.

Настройка памяти

- Переключаемся на первый пресет, чтобы отсечь влияние от настройки чипа

- Запускаем второй графический тест Firestrike в циклическом режиме.

- Опускаем скорость работы системы охлаждения карты и компьютера, дав прогреться памяти до 80°С, или Hotspot до 85-90°С, если датчика температуры памяти у видеоускорителя нет.

- Прибавляем по 100 МГц частоты памяти ползунком и тестируем аналогично по минуте, сохраняемся и продолжаем, пока не начнут появляться артефакты. Чаще всего это будет артефакт «шахматная доска» или halo.

- После появления артефактов снижаем частоту памяти минимум на 300 МГц для большей стабильности.

Не стоит спешить с процессом и прибавлять по 200-300 МГц, потому что сильный переразгон памяти чаще приводит ни к вылету приложения или драйвера, а к зависанию компьютера. Кстати артефакт «шахматная доска» в первые несколько раз смены фазы теста в момент черного экрана не свидетельствует о нестабильности результата.

Проверьте стабильность разгона путем запуска одного из тестов стабильности 3DMark (пары раз будет достаточно) или майнингом.

Разгоняя частоту памяти, мы повышаем ее общую пропускную способность (ПСП или Memory Bandwidth), что не всегда является узким местом для видеоадаптера. Поэтому обязательно протестируйте рациональность использования разгона в режимах без упора в предел энергопотребления и с ним. Второй вариант требуется, потому что память в разгоне начинает потреблять больше, тем самым немного отнимая доступную энергию у чипа, снижая используемые им частоты. Такие результаты получились у одной из моих испытуемых:

Как видите, даже с 200W ограничением энергопотребления прирост от разгона памяти достигает 2,9%, что свидетельствует о его целесообразности. Но это ~ 500 ГБ/сек ПСП. 600 ГБ/сек ПСП у RTX 3070 Ti и 750 ГБ/сек ПСП у RTX 3080 среднестатистически не требуют разгона, а частоты 900-1000 ГБ/сек ПСП у RTX 3080 Ti — 3090 Ti можно даже немного снизить, дав GPU больше разгуляться. В любом случае обязательно проверяйте это в часто используемых графических нагрузках.

Тестирование

Смысл разгона подсистемы памяти мы уже выяснили, пришла пора проверить к чему привел весь спектр наших манипуляций. Для этого я протестирую видеокарту с настроенной Curve и памятью в различных режимах ограничения энергопотребления при зафиксированных оборотах вентиляторов с уровнем шума 35 дБ на расстоянии 30 см от системного блока — отчетливо слышимый в ночное время, но совершенно меня не раздражающий относительно тихий шум (фоновый уровень шума ночью в моей местности составляет 25-28 дБ). Некоторые интернет издания использую шумовые уровни 32-33 дБ и 35-36 дБ как границы условной бесшумности и условного комфорта.

Для этого я протестирую видеокарту с настроенной Curve и памятью в различных режимах ограничения энергопотребления при зафиксированных оборотах вентиляторов с уровнем шума 35 дБ на расстоянии 30 см от системного блока — отчетливо слышимый в ночное время, но совершенно меня не раздражающий относительно тихий шум (фоновый уровень шума ночью в моей местности составляет 25-28 дБ). Некоторые интернет издания использую шумовые уровни 32-33 дБ и 35-36 дБ как границы условной бесшумности и условного комфорта.

Для достижения 35 дБ обороты вентиляторов на GeForce RTX 2080 Super Asus Strix были настроены на 1800 об/мин, а у RTX 2080 Palit JetStream на 1400 об/мин. Скорость остальных вентиляторов системного блока также была зафиксирована, чтобы не превышать указанный шумовой порог.

Используемый в тесте системный блок:

- Материнская плата: AsRock Z370 Fatal1ty MITX/ac

- Процессор: Intel Core i7 [email protected],9 ГГц (4,5 ГГц кэш)

- Оперативная память: 32GB 3700 МГц 16-18-18-38-1T + настроены вторичные и третичные тайминги (~60 ГБ/с, 42 нс)

- Накопитель: 1TB A-Data XPG Gammix S11 Pro

- Корпус: Thermaltake V21

- Блок питания: Chieftec SFX-500GD-C 500W 80+ Gold

- Охлаждение: ID-Cooling SE-224-XT White радиатор + Arctic P12 PWM PST вентилятор на процессоре и 2 аналогичных вентилятора спереди на вдув и 1 сзади на выдув.

Для тестов я буду использовать специализированные бенчмарки 3DMark FireStrike, Time Spy и Port Royal, Superposition в режимах 1080p Medium и 8K Optimized для симуляции легкой мультиплеерной и максимальной синглплеерной нагрузок и встроенный бенчмарк игры Metro Exodus Enchanced Edition, который использует все технологии современных видеокарт Nvidia.

Изменение производительности RTX 2080 Super относительно состояния из коробки

При сохранении уровня энергопотребления (250 Вт) мы смогли повысить производительность видеокарты в среднем на 3,3% (5,2% максимум), при увеличении предела на 20% — на 4,6% в среднем и 7,3% максимум. В следствии высоко настроенной curve из коробки у нас не получилось достигнуть серьезных результатов в разгоне, впрочем за счет большего частотного запаса на меньших напряжениях мы смогли снизить энергопотребление ускорителя на 20% не потеряв производительности и на 30% со средней 2,3% потерей (-3,5% максимум). -40% и особенно -50% приводят к более серьезному падению производительности. И, если 40% снижение лимита с 10% снижением производительности (-3,3% минимум) еще имеет смысл использовать для мультиплеерных баталий в современных проектах, особенно в VRR 120-165 Гц режиме, то 50% урезание лимита со средним 32% падением производительности стоит задействовать лишь для графически нетребовательных синглплеерных игр прошлых лет или легких мультиплеерных проектов. Столь серьезное падение производительности происходит в следствии невозможности ускорителя использовать в автоматическом режиме напряжения ниже 775 мВ и следующего за этим чрезмерного снижения частоты.

-40% и особенно -50% приводят к более серьезному падению производительности. И, если 40% снижение лимита с 10% снижением производительности (-3,3% минимум) еще имеет смысл использовать для мультиплеерных баталий в современных проектах, особенно в VRR 120-165 Гц режиме, то 50% урезание лимита со средним 32% падением производительности стоит задействовать лишь для графически нетребовательных синглплеерных игр прошлых лет или легких мультиплеерных проектов. Столь серьезное падение производительности происходит в следствии невозможности ускорителя использовать в автоматическом режиме напряжения ниже 775 мВ и следующего за этим чрезмерного снижения частоты.

Изменение производительности RTX 2080 относительно состояния из коробки

Ситуация с GeForce RTX 2080 от Palit складывается куда интересней. По причине не столь высоко настроенной Curve из коробки получается достигнуть более впечатляющего среднего 9,2% прироста производительности (+12,6% максимального), которое правда не получается улучшить за счет увеличения предела энергопотребления на 20%, потому что в и в рамках 250 Вт практически весь диапазон напряжений чипом уже используется. Но и увеличение эффективности энергопотребления проходит лучше, ведь даже при 50% снижении лимита (6,5% среднее и 11% максимальное снижение производительности) минимальный предел напряжения оказывается не достигнутым и для функционирования используются частоты из диапазона наиболее эффективных. Но и у этого ускорителя наиболее интересным я считаю режим -30% лимита энергопотребления с 3% приростом средней и 5% приростом максимальной производительности.

Но и увеличение эффективности энергопотребления проходит лучше, ведь даже при 50% снижении лимита (6,5% среднее и 11% максимальное снижение производительности) минимальный предел напряжения оказывается не достигнутым и для функционирования используются частоты из диапазона наиболее эффективных. Но и у этого ускорителя наиболее интересным я считаю режим -30% лимита энергопотребления с 3% приростом средней и 5% приростом максимальной производительности.

Теперь измерим температуры узлов ускорителей в различных режимах энергопотребления за счет цикличного прогона теста Superposition в течении 10 минут. Замеры проводились во время недавней августовской жары (30°С), поэтому в более приемлемых температурных условиях (20°С) результаты были бы еще лучше.

Полученные данные позволяет лучше понять причины столь низкого падения производительности при достаточно серьезных ограничениях энергопотребления: при 150-175 Вт (от -30 до -50%) потреблении температура чипа даже у более горячей Asus Strix достигает максимум 60°С, поэтому падение частоты чипа в результате температурной коррекции происходит лишь на 1 шаг (15 МГц), и то редко по причине используемых в этом режиме 850-900 мВ напряжениях (1845-1935 МГц), лежащих далеко от максимального предела напряжения чипа. При дефолтных 250 Вт RTX 2080 прогревается уже до 71°С, а RTX 2080 Super до 78°С. В совокупности с близкими к пороговому напряжениями 1000-1050 мВ это приводит к 5-6 шагам снижения частоты до 1935-1980МГц с настроенной Curve и 1890-1950 МГц с дефолтной. Как видите, это не сильно отличается от частот, используемых чипом с настроенной Curve и -30% лимитом, поэтому и такое небольшое среднее 2,3% падение производительности при высоком выигрыше в энергопотреблении и тепловыделении.

При дефолтных 250 Вт RTX 2080 прогревается уже до 71°С, а RTX 2080 Super до 78°С. В совокупности с близкими к пороговому напряжениями 1000-1050 мВ это приводит к 5-6 шагам снижения частоты до 1935-1980МГц с настроенной Curve и 1890-1950 МГц с дефолтной. Как видите, это не сильно отличается от частот, используемых чипом с настроенной Curve и -30% лимитом, поэтому и такое небольшое среднее 2,3% падение производительности при высоком выигрыше в энергопотреблении и тепловыделении.

Безусловно, при использовании водяной системы охлаждения с рационально подобранной мощностью, можно избавиться от роста температур выше 55°С, соответственно избавившись от температурной коррекции, и получив дополнительные 4-5% производительности. Ускорив работу вентиляторов и немного снизив нагрев, также можно добиться некоторого прироста. Но стоит ли игра свеч каждый решит для себя сам.

Настройка системы охлаждения

Это последняя манипуляция, доводящая настройку комфорта использования ускорителя до конца. И тут два пути: настроить вентиляторы на постоянную скорость работы или на переменную в зависимости от температуры. Я предпочитаю второй режим, чтобы снизить частоту и температурную дельту циклов нагрева-охлаждения чипа для продления срока его службы. Конечно в идеале стоило бы использовать функцию остановки вентиляторов из коробки, но к сожалению она не всегда функционирует корректно и не совместима с ручным профилем: из коробки температура остановки вентиляторов ниже температуры старта, чтобы избежать постоянного включения/отключения при длительной задержке температуры на одном значении, и в ручную аналогичным образом ее настроить не представляется возможным ввиду функциональных ограничений.

И тут два пути: настроить вентиляторы на постоянную скорость работы или на переменную в зависимости от температуры. Я предпочитаю второй режим, чтобы снизить частоту и температурную дельту циклов нагрева-охлаждения чипа для продления срока его службы. Конечно в идеале стоило бы использовать функцию остановки вентиляторов из коробки, но к сожалению она не всегда функционирует корректно и не совместима с ручным профилем: из коробки температура остановки вентиляторов ниже температуры старта, чтобы избежать постоянного включения/отключения при длительной задержке температуры на одном значении, и в ручную аналогичным образом ее настроить не представляется возможным ввиду функциональных ограничений.

Работу вентиляторов на постоянной скорости можно настроить через основное окно Afterburner, переменная же скорость настраивается в окне настроек Afterburner на вкладке «Кулер»:

Настроенная кривая скорости видеокарты RTX 2080 Palit Jetstream, не позволяющая ей увеличивать температуру выше 60°С при -30% лимите энергопотребления.

- Исходя из предпочитаемого лимита энергопотребления и шума, установим требуемую скорость работы вентиляторов при предпочитаемой температуре путем прогона любого высоконагруженного теста (например Superposition 8K Optimized) в течении времени требуемого для прогрева компонентов ускорителя и уравновешивания температур на постоянном уровне (10-20 мин).

- Снизим скорость вентиляторов до минимально возможного уровня. Запуская различные программы без серьезной графической нагрузки (браузеры, лаунчеры, офисные приложения и т. д.) обратим внимание, до какой температуры прогревается видеокарта?

- Зайдем в настройки кривой кулера.

- Настроим минимально возможный нижний уровень работы вентилятора до установленного во втором шаге значения температуры c небольшим запасом в +2-3°С. У меня этот параметр чаще всего настроен на значения 45-50°С.

- Настроим максимальное значение скорости и температуры, найденные при первом шаге с небольшим запасом в 3-5% по скорости.

- Смежные значения построим по гиперболической кривой, чтобы снизить заметность изменения шума работы вентиляторов, если скоростной промежуток работы окажется сильно выше температурного. Оставшуюся правую часть кривой постройте по большим значениям лимита энергопотребления, если будете их использовать.

- Сохраните настройки.

Такими нехитрыми способами повышаем частоту чипа и памяти, увеличивая эффективность используемого напряжения, ограничиваем энергопотребление и настраиваем тишину работы системы охлаждение, ограничивая температурную коррекцию, и в итоге получаем тихую, энергоэффективную и производительную карту. Так можно настроить любую современную видеокарту Nvidia, сбалансировав ее слабые аспекты, на которых решил сэкономить производитель, не забывая конечно ее обслуживать, если это позволяет гарантия.

Теперь и новую 4000 серию с ее ожидаемым высоким энергопотреблением можно не бояться. Уже интересно пощупать и узнать, получится ли аналогично GeForce RTX 3080 Ti и 3090 скинуть им добрую сотню ватт без потери производительности.

P.S. Если графические приложения внезапно закрываются или вылетают, не забывайте проверять «Просмотр событий» («Журналы Windows» — «Система») на предмет упоминания перезапущенного драйвера — это прямой сигнал, что настройку видеокарты стоит подкорректировать.

Опрос

Следующей статьей от меня будет небольшой туториал по наиболее качественному просмотру видео контента на ПК с HDR, Dolby Vision, Dolby Atmos и прочими плюшками на обыкновенном оборудовании для массового зрителя с наглядными сравнения «было/стало». Но о чем писать дальше я пока не решил, поэтому собственно опрос:

Содержание скрыто

Показать

серия GeForce 1000 | Видеокарты

WinFast RTX 3070 AI BLOWER 8G REV B

NVIDIA Ampere GPU/1500 МГц базовая частота/1725 МГц Boost частота

WinFast RTX 4070 Ti HURRICANE частота 12G MHz A5 Love2Dalace GPU/NVIDIA

MHZ Boost Clock

WinFast RTX 4080 Ураган 16G

NVIDIA ADA LOVELACE GPU/2205 МГц. часы

часы

WinFast RTX 3060 TI ураган White Edition 8G

NVIDIA AMPERE GPU/1410 МГц базовые часы/1665 МГц. Уравновешивание

Winfast RTX 3050 Ураган белый отпуск 8G

NVIDIA AMPERE GPU/1552 MHS/1552 MHZ/1552 MHS/1552 MHS/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ/1552 MHZ. частота

WinFast RTX 3050 CLASSIC 8G

NVIDIA Ampere GPU/1552 МГц базовая частота/1777 МГц Boost частота

WinFast RTX 3080 HURRICANE 12G

частота Boost/9010 МГц Boost 610 МГц GPU/120004

WinFast RTX 2060 Hurricane 12G Rev B

Графический процессор NVIDIA Turing/базовая частота 1470 МГц/тактовая частота Boost 1650 МГц

WinFast RTX 3060 CLASSIC 12G REV B тактовая частота

Базовая частота 7 МГц/

NVIDIA Amper0e GPU

Winfast GT 730

Kepler GPU/902 МГц базовые часы

WinFast RTX 3070 TI ураган 8G

NVIDIA AMPERE GPU/1575 МГц.0004

NVIDIA AMPERE GPU/1365 МГц базовые часы/1665 МГц -часы

WinFast RTX 3060 Classic 12G REV A

NVIDIA AMPER

Графический процессор NVIDIA Ampere/1320 МГц базовая частота/1777 МГц Boost частота

WinFast RTX 3070 AI BLOWER 8G REV A

Графический процессор NVIDIA Ampere/1500 МГц базовая частота/1725 МГц Boost частота

NVIDIA AMPERE GPU/1410 МГц. AMPERE GPU/1500 МГц базовые часы/1725 МГц. Ураган 9,0004

AMPERE GPU/1500 МГц базовые часы/1725 МГц. Ураган 9,0004

Winfast RTX 3080 Ураган 10G

NVIDIA AMPERE GPU/1440 МГц.5 МГц Базовая частота/1695 МГц Boost-тактовая частота

WinFast GTX 1650 D6 LP 4G

Графический процессор NVIDIA Turing/1410 МГц базовая частота/1590 МГц Boost-тактовая частота

WinFast GTX 1650 D6 Base1 4G

MHz/GPU1 NVIDIA Turing1

частота/1590 МГц Boost частота

WinFast RTX 2060 SUPER CLASSIC 8G Rev B

NVIDIA Turing GPU/1470 МГц базовая частота/1650 МГц Boost частота

WinFast GTX 1660 SUPER 5 MHz/GPU 0 Turing1

Тактовая частота 1785 МГц

WinFast GTX 1660 Super Hurricane 6G

NVIDIA TURING GPU/1530 МГц базовые часы/1785 МГц. Увеличение часы

WinFast GTX 1660 Super Classic 485 MH

NVIDIA Turing GPU/1530 MHZ BAST/1785 MH -BAST -BAST/1785 MH -BAST 4000 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MHZ4 MH

WinFast RTX 2080 SUPER CLASSIC 8G

NVIDIA Turing GPU/1650 МГц базовая частота/1815 МГц Boost частота

WinFast RTX 2070 SUPER CLASSIC 8G

NVIDIA Turing GPU/1605 МГц Boost частота/1770004

WinFast RTX 2060 SUPER CLASSIC 8G Rev A

Графический процессор NVIDIA Turing/базовая частота 1470 МГц/тактовая частота Boost 1650 МГц

WinFast RTX 2080 SUPER HURRICANE тактовая частота 8G

Базовая частота 6 МГц/Графический процессор Turing8

WinFast RTX 2070 SUPER HURRICANE 8G

GPU NVIDIA Turing/базовая частота 1605 МГц/тактовая частота Boost 1815 МГц

WinFast RTX 2060 SUPER HURRICANE 8G Rev A

MPU Turing/1815 GPU

GPU5 МГц Boost clock

WinFast RTX 2060 CLASSIC 6G Rev B

NVIDIA Turing GPU/1365 MHz Base clock/1680 MHz Boost clock

WinFast RTX 2060 Hurricane 6G Rev B Base 5 MHz/Turing3 GPU

1770 МГц Boost-тактовая частота

WinFast GTX1650 D5 4G

NVIDIA Turing GPU/1485 МГц базовая частота/1665 МГц Boost-тактовая частота

WinFast GTX 1660 CLASSIC 6G

МГц GPU

Turing08 GPU0004

WinFast GTX 1660 TI ураган 6G

NVIDIA TURNGE GPU/1500 МГц базовые часы/1815 МГц. Увеличение часы

Увеличение часы

Win -Fast Gtx 1660 Classic 6G

NVIDIA Turing GPU/1500 MHZ Class Classe 6G

9000 29000 29000 29000 29000.

WinFast RTX 2060 Hurricane 6G Rev A

Графический процессор NVIDIA Turing/1365 МГц базовая частота/1770 МГц Boost частота

WinFast RTX 2060 CLASSIC 6G Rev A0004

WinFast RTX 2070 Ураган 8G

NVIDIA TURING GPU/1410 МГц базовые часы/1710 МГц Буст.

WinFast RTX 2080 Ti Hurricane 11G.0002

WinFast RTX 2080 Ураган 8G

NVIDIA TURING GPU/1515 МГц.

Pascal GPU / 1607 МГц базовая частота / 1683 МГц Boost частота

WinFast GTX 1070 Ti 8G

Pascal GPU / 1607 МГц базовая частота / 1683 МГц Boost частота

Rev0 GTX 9 Ti 4G 10500003 Pascal GPU / 1290 МГц базовые часы / 1392 МГц -часы

WinFast GTX 1050 2G REV B

Pascal GPU / 1354 МГц. частота

WinFast GTX 1080 Ti HURRICANE OC 11G

Pascal GPU / 1544 МГц базовая частота / 1657 МГц Boost частота

WinFast GTX 1080 Ti 11G частота

9080 МГц Boost 8 GPU 8 Pascal0004

WinFast GTX 1080 TI Founders Edition 11G

Pascal GPU / 1480 МГц / 1582 МГц. Pascal GPU / 1607 МГц базовая частота / 1733 МГц Boost частота

Pascal GPU / 1607 МГц базовая частота / 1733 МГц Boost частота

WinFast GTX 1050 2G

Pascal GPU / 1354 МГц базовая частота / 1455 МГц Boost частота

WinFast GTX 1050 / GPU 3 Pascal 4G 900 9000Базовые часы 0 МГц / 1392 МГц. Ураганные часы

WinFast GTX 1060 Ураган OC 6G

Pascal GPU / 1531 МГц. WinFast GTX 1080 HURRICANE OC 8G

Pascal GPU / 1670 МГц базовая частота / 1809 МГц Boost частота

WinFast GTX 1070 HURRICANE OC 8G

Pascal GPU / 1569 МГц Boost частота / 1759M0004

WinFast GTX 1080 Основатели издания 8G

Pascal GPU / 1607 МГц базовые часы / 1733 МГц. Буст. Графический процессор Kepler / базовая частота 902 МГц

GTX 1080 и GTX 1070 прибудут в мае и июне

Райан Смит 7 мая 2016 г.

234 Комментарии

|

234 Комментарии

Анонсирована серия GTX 1000: Pascal и «GP104»GeForce GTX 1080 и GTX 1070: скоро в продаже

После многих месяцев спекуляций и немалых ожиданий сегодня вечером на мероприятии в Остине, штат Техас, NVIDIA объявила о следующем поколении видеокарт GeForce, серии GeForce 1000. Благодаря новой архитектуре Pascal и 16-нм техпроцессу TSMC FinFET NVIDIA обещает, что серия 1000 установит новую высокую планку производительности и эффективности, а также предложит набор новых функций, которые еще больше отличат ее от предшественников.

Благодаря новой архитектуре Pascal и 16-нм техпроцессу TSMC FinFET NVIDIA обещает, что серия 1000 установит новую высокую планку производительности и эффективности, а также предложит набор новых функций, которые еще больше отличат ее от предшественников.

Первыми двумя выпущенными картами будут высококлассные карты NVIDIA, GTX 1080 и GTX 1070. Помимо шуток, 1080p являются прямыми преемниками того, что сейчас является схемой именования продуктов NVIDIA с 2010 года, с GTX 1080. представляет их новую высококлассную карту, в то время как GTX 1070 — более дешевая карта, предназначенная для энтузиастов. Эти карты будут выпущены в следующем месяце, GTX 1080 появится на рынке 27 мая года , а GTX 1070 — двумя неделями позже, 10 июня.0368-й . Они будут стоить 599 и 379 долларов соответственно.

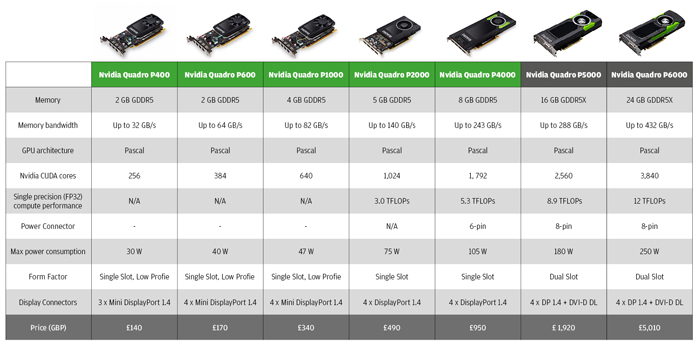

| Сравнение характеристик графических процессоров NVIDIA | ||||||

| ГТХ 1080 | ГТХ 1070 | ГТХ 980 | GTX 780 | |||

| Ядра CUDA | 2560 | (меньше) | 2048 | 2304 | ||

| Текстурные блоки | 160? | (Сколько?) | 128 | 192 | ||

| РОП | 64 | (Хороший вопрос) | 64 | 48 | ||

| Частота ядра | 1607 МГц | (медленнее) | 1126 МГц | 863 МГц | ||

| Повышенная частота | 1733 МГц | (снова) | 1216 МГц | 900 МГц | ||

| Терафлопс (FMA) | 9 терафлопс | 6,5 терафлопс | 5 терафлопов | 4. 1 терафлопс 1 терафлопс | ||

| Часы памяти | 10 Гбит/с GDDR5X | ГДДР5 | 7 Гбит/с GDDR5 | 6 Гбит/с GDDR5 | ||

| Ширина шины памяти | 256-битный | ? | 256-битный | 256-битный | ||

| Видеопамять | 8 ГБ | 8 ГБ | 4 ГБ | 3 ГБ | ||

| FP64 | ? | ? | 1/32 FP32 | 1/24 FP32 | ||

| Расчетная мощность | 180 Вт | ? | 165 Вт | 250 Вт | ||

| ГП | «ГП104» | «ГП104» | ГМ204 | ГК110 | ||

| Количество транзисторов | 7. 2Б 2Б | 7.2Б | 5.2Б | 7.1Б | ||

| Производственный процесс | TSMC 16нм | TSMC 16нм | TSMC 28нм | TSMC 28нм | ||

| Дата запуска | 27.05.2016 | 10.06.2016 | 18.09.2014 | 23.05.2013 | ||

| Стартовая цена | MSRP: 599 долларов США Основатели 699 долларов США | Рекомендуемая производителем розничная цена: 379 долларов США Основатели: 449 долларов США | $549 | $649 | ||

Архитектура Pascal и «GP104»

Несмотря на то, что публичная презентация NVIDIA сегодня вечером не была подробной технической презентацией — и поэтому есть еще ряд пробелов, которые нужно заполнить позже — у нас все еще есть куча информация для погружения. Прежде всего, давайте поговорим о графическом процессоре. NVIDIA не использует название графического процессора, но в своей презентации они подтвердили, что он имеет 7,2-битные транзисторы, и, таким образом, ясно дали понять, что это новый графический процессор Pascal, а не урезанная версия 15,3-битного транзистора GP100. На данный момент я предполагаю, что это GP104 — в соответствии с традиционной схемой именования NVIDIA — но это требует подтверждения.

Прежде всего, давайте поговорим о графическом процессоре. NVIDIA не использует название графического процессора, но в своей презентации они подтвердили, что он имеет 7,2-битные транзисторы, и, таким образом, ясно дали понять, что это новый графический процессор Pascal, а не урезанная версия 15,3-битного транзистора GP100. На данный момент я предполагаю, что это GP104 — в соответствии с традиционной схемой именования NVIDIA — но это требует подтверждения.

GP104, как и следовало ожидать, производится давним партнером TSMC по их 16-нм процессу FinFET, что делает его первым потребительским графическим процессором, построенным на 14/16-нм техпроцессах, который выйдет на улицы в конце этого месяца. . Само собой разумеется, что индустрия графических процессоров застряла на 28-нм техпроцессе гораздо дольше, чем обычно — от GK104 до GP104 будет 4 года и 2 месяца — так что это долгожданная возможность перейти к процессу с меньшими функциями и пожинать плоды мощности и производительности. выгоды, которые влечет за собой.

выгоды, которые влечет за собой.

В настоящее время мы не знаем размер кристалла GP104, но с меньшим количеством транзисторов, чем у GP100, можно с уверенностью сказать, что этот размер кристалла соответствует предыдущим первым запускаемым графическим процессорам 104, таким как GK104 и GF104, которые были 294мм2 и 332мм2 соответственно. GM204, для сравнения, был более крупным графическим процессором, появившимся позже в процессе 28-нм техпроцесса. Это означает, что NVIDIA потратила часть своих 16-нанометровых сбережений на уменьшение размера кристалла по сравнению с GM204. 16-нанометровый техпроцесс все еще находится на относительно ранней стадии развития, и, в отличие от Tesla P100, где клиенты будут платить очень высокую цену за ранний доступ к менее производительному чипу, в потребительских компонентах NVIDIA должна быть более консервативной. В связи с этим в настоящее время неясно, является ли GP104 в GTX 1080 полностью включенным графическим процессором GP104, хотя традиционно так оно и было.

Pascal — это, конечно, не только 16-нм архитектура NVIDIA, но и их преемник Maxwell. Из предыдущего анонса NVIDIA Tesla P100 мы знаем, что компания решила уделить особое внимание эффективности CUDA Core с Pascal, повысив пропускную способность архитектуры, а не добавив значительное количество дополнительных ядер CUDA. В результате, как и в случае с предыдущими архитектурными изменениями, сравнение ядер с ядрами будет затруднительным из-за того, что GP104 на практике достигает более высокого процента своей теоретической пропускной способности. Я все еще жду более подробной технической информации о GP104 и того, были ли перенесены некоторые улучшения, такие как увеличенный регистровый файл. В противном случае NVIDIA продвигает двукратное увеличение эффективности Pascal по сравнению с Maxwell для игровых целей.

Помимо двукратного повышения эффективности — и того, как NVIDIA достигает заявленного трехкратного повышения эффективности по сравнению с GTX Titan X — в Pascal реализованы некоторые новые функции, которые разработчики могут использовать для повышения производительности. Ключевым среди них является технология Simultaneous Multi-Projection, которая позволяет Pascal создавать до 16 окон просмотра. NVIDIA продвигает эту технологию как особенно подходящую для более эффективной реализации коррекции искажений объектива VR (Lends Matched Shading) и рендеринга одной и той же сцены дважды в VR — по одному разу для каждого глаза — за один проход (Single Pass Stereo), наряду с более легкая коррекция искажений при использовании установки с несколькими мониторами.

Ключевым среди них является технология Simultaneous Multi-Projection, которая позволяет Pascal создавать до 16 окон просмотра. NVIDIA продвигает эту технологию как особенно подходящую для более эффективной реализации коррекции искажений объектива VR (Lends Matched Shading) и рендеринга одной и той же сцены дважды в VR — по одному разу для каждого глаза — за один проход (Single Pass Stereo), наряду с более легкая коррекция искажений при использовании установки с несколькими мониторами.

По правде говоря, в настоящее время я не знаю, чем одновременная мультипроекция отличается от ранее анонсированных функций NVIDIA для Maxwell: мультипроекционное ускорение и затенение с несколькими разрешениями. Описание NVIDIA SMP очень похоже на это, как и основные алгоритмические настройки перепроецирования геометрии и затенения разных частей кадра при разных разрешениях.

Последняя новая функция уровня графического процессора на картах GP104 и новых картах серии GTX 1000 — GPU Boost 3. 0. Информация об этом ограничена, но NVIDIA заявляет, что поддерживает более продвинутые функции разгона, чем те, которые были представлены за последние пару лет с помощью GPU Boost 2.0.

0. Информация об этом ограничена, но NVIDIA заявляет, что поддерживает более продвинутые функции разгона, чем те, которые были представлены за последние пару лет с помощью GPU Boost 2.0.

Между тем, с точки зрения функциональности, NVIDIA подтвердила, что карты GP104 будут поддерживать уровень функций DirectX FL12_1. Хотя FL12_1 допускает несколько уровней определенных подфункций, в настоящее время неясно, поддерживает ли Pascal более высокие уровни этих функций. Что касается дисплея, контроллер дисплея GP104 будет поддерживать более новые стандарты DisplayPort 1.3 и 1.4. Официально карты называются «DisplayPort 1.2 Certified, DisplayPort 1.3/1.4 Ready», различие заключается в том, что последняя в настоящее время не сертифицирована, хотя я подозреваю, что сам процесс сертификации DP 1.3/1.4 может быть еще не готов.

Переходя от графического процессора к памяти, в то время как GP100 был первым графическим процессором NVIDIA с поддержкой HBM2, GP104 станет первым графическим процессором с поддержкой GDDR5X. Обновленная версия стандарта GDDR5, первоначально анонсированная Micron и недавно одобренная JEDEC, GDDR5X использует технологию для повышения пропускной способности памяти. На базовом уровне GDDR5X увеличивает общую емкость шины памяти за счет перехода от двойной перекачки (DDR) к четырехкратной перекачке (QDR), сочетая это изменение с большей предварительной выборкой памяти для подачи на более быструю шину памяти, избегая при этом более болезненное/сложное увеличение тактовой частоты ядра памяти.

Обновленная версия стандарта GDDR5, первоначально анонсированная Micron и недавно одобренная JEDEC, GDDR5X использует технологию для повышения пропускной способности памяти. На базовом уровне GDDR5X увеличивает общую емкость шины памяти за счет перехода от двойной перекачки (DDR) к четырехкратной перекачке (QDR), сочетая это изменение с большей предварительной выборкой памяти для подачи на более быструю шину памяти, избегая при этом более болезненное/сложное увеличение тактовой частоты ядра памяти.

GDDR5X позволит NVIDIA (и другим поставщикам) увеличить пропускную способность памяти, следуя более традиционным схемам памяти в стиле GDDR5, а не более сложным конструкциям, таким как HBM. В то же время это также позволяет одному графическому процессору легко поддерживать более новый стандарт памяти и старый стандарт GDDR5 одновременно, поскольку последний в течение некоторого времени останется более дешевой технологией памяти. NVIDIA будет эффективно использовать эту функцию, позволяя GTX 1080 работать с GDDR5X, а GTX 1070 будет работать с GDDR5.

Поэтому для GeForce GTX 1080 будет использована плата, рассчитанная на установку памяти GDDR5X, что ориентировочно даст новинке пропускную способность в районе 320‒384 Гбайт/с. А вот GeForce GTX 1070, который и был запечатлён на недавно появившихся в сети снимках рядом с новейшей памятью Samsung, способной работать на эквивалентной частоте 8 ГГц, будет довольствоваться обычной, но очень быстрой — 256 Гбайт/с совокупно — GDDR5. Иными словами, AMD пока удаётся сохранить лавры первопроходца, впервые применившего в коммерческом изделии многослойную память типа HBM. Что касается объёма, то, похоже, в обоих случаях он будет составлять 8 Гбайт.

Поэтому для GeForce GTX 1080 будет использована плата, рассчитанная на установку памяти GDDR5X, что ориентировочно даст новинке пропускную способность в районе 320‒384 Гбайт/с. А вот GeForce GTX 1070, который и был запечатлён на недавно появившихся в сети снимках рядом с новейшей памятью Samsung, способной работать на эквивалентной частоте 8 ГГц, будет довольствоваться обычной, но очень быстрой — 256 Гбайт/с совокупно — GDDR5. Иными словами, AMD пока удаётся сохранить лавры первопроходца, впервые применившего в коммерческом изделии многослойную память типа HBM. Что касается объёма, то, похоже, в обоих случаях он будет составлять 8 Гбайт. Возвращаясь к оценке числа процессоров CUDA: GP100 имеет 6 кластеров по 10 блоков SM, каждый из которых содержит 64 ядра CUDA. GP104 примерно вдвое меньше. Если предположить, что пропорции сохранены, то получается всего 1920 ядер CUDA. Этого явно мало. Либо в GP104 имеется 4 кластера (2560 ядер), либо используются другие пропорции, например, 8 блоков SM на кластер, что с четырьмя кластерами даёт 2048 ядер CUDA. Увы, точной информацией на этот счёт мы пока не располагаем.

Возвращаясь к оценке числа процессоров CUDA: GP100 имеет 6 кластеров по 10 блоков SM, каждый из которых содержит 64 ядра CUDA. GP104 примерно вдвое меньше. Если предположить, что пропорции сохранены, то получается всего 1920 ядер CUDA. Этого явно мало. Либо в GP104 имеется 4 кластера (2560 ядер), либо используются другие пропорции, например, 8 блоков SM на кластер, что с четырьмя кластерами даёт 2048 ядер CUDA. Увы, точной информацией на этот счёт мы пока не располагаем.

По одному шагу на каждые 5-6°С роста температуры. При приближении используемого напряжения к своему пределу сброс может происходить по 2 шага. Например настроенная в Сurve Editor при 50°С температуры по чипу 1950 МГц частота при напряжении 1000 мВ в момент75°С эксплуатации карты может легко превратиться в 1860-1890 МГц (-3-4 шага частоты).

По одному шагу на каждые 5-6°С роста температуры. При приближении используемого напряжения к своему пределу сброс может происходить по 2 шага. Например настроенная в Сurve Editor при 50°С температуры по чипу 1950 МГц частота при напряжении 1000 мВ в момент75°С эксплуатации карты может легко превратиться в 1860-1890 МГц (-3-4 шага частоты).

![Как сбросить настройки на ноутбуке асус до заводских: [Игровой ноутбук/десктоп] MyASUS Введение в заводские настройки восстановления (ASUS Recovery) | Официальная служба поддержки](https://dilios.ru/wp-content/themes/dilios.ru/assets/front/img/thumb-medium-empty.png)