Radeon vs geforce: AMD vs Nvidia — Reviewed

Содержание

Radeon или Geforce — какая из видеокарт лучше?

Содержание

- Из истории AMD и Nvidia

- Разница между Radeon и Geforce

- Оптимизация под видеокарты

Игровое сообщество уже не первый год спорит о том, какая из видеокарт лучше — Radeon или Geforce. Одна часть геймеров уверена, что компания Nvidia (производит карты под маркой Geforce) лучше всех, другие же игроки отдают предпочтение AMD (видеокарты Radeon – их детище).

Скажем сразу, хороших и плохих в этом вопросе нет, каждая компания имеет долгую историю и авторитет в компьютерном мире, их задача делать качественные видеокарты, которые бы удовлетворяли потребности геймеров, просто эти компании выбрали различные пути развития, сделав ставки на разные технологии.

Из истории AMD и Nvidia

Многие удивятся, но компания AMD существует на 25 лет больше, чем их конкуренты – Nvidia, хотя мне лично всегда казалось что наоборот. Однако именно «Нвидиа» захватила роль флагмана в производстве видеокарт, в конце 90-х – начале 2000-х годов почти каждый компьютер был оснащен картой Geforce, цены на них были умеренные, а производительность из года в год быстро росла.

Но монополист недолго оставался «на коне», компания ATI начала планомерное наступление на рынок видеоадаптеров. Продукция этой фирмы была очень качественной и производительной, а цена меньше, чем у конкурента. В связи с этим ATI и их Radeon-ы отвоевали свое место на рынке. В 2007 году ATI купила корпорация AMD, вследствие чего Radeon стали выпускаться под этой маркой.

Есть сведения, что операционная система Linux «дружит» лучше с картами Geforce, а компьютеры от Apple также ее используют из-за ее стабильности в связке с другими компонентами. Однако это сомнительные минусы, ведь кто использует Linux для игр – очень малый процент геймеров, обладателей компьютеров на Mac OS также не очень много в наших краях.

Разница между Radeon и Geforce

Radeon и Geforce имеют некоторые различия в структурах своих графических процессорах, а также некоторые уникальные технологии. Например, «Джифорс» обладает PhysX – технологией, которая значительно «оживляет» картинку в играх благодаря обилию частиц, которые перемещаются по всем законам физики. Если игра поддерживает данную функцию, то взрывы, осколки, пыль, поведение жидкостей и т.д. в ней будет смотреться намного эффектней.

Если игра поддерживает данную функцию, то взрывы, осколки, пыль, поведение жидкостей и т.д. в ней будет смотреться намного эффектней.

Также Geforce славится технологией CUDA, которая позволяет использовать графический процессор для вычислений (данная функция больше подходит не геймерам, а программистам, дизайнерам и т.д.). В целом, Nvidia использует еще множество разработок, например, 3D vision (позволяет получить эффект 3D) и многие другие «помельче», на которых мы не будем останавливаться.

Компания AMD также имеет ряд разработок в своем арсенале, например, Mantle, которая позволяет упростить процесс оптимизации игр для разработчиков (уже появились игровые тесты, которые демонстрируют более высокую производительность игр с применением Mantle).

Оптимизация под видеокарты

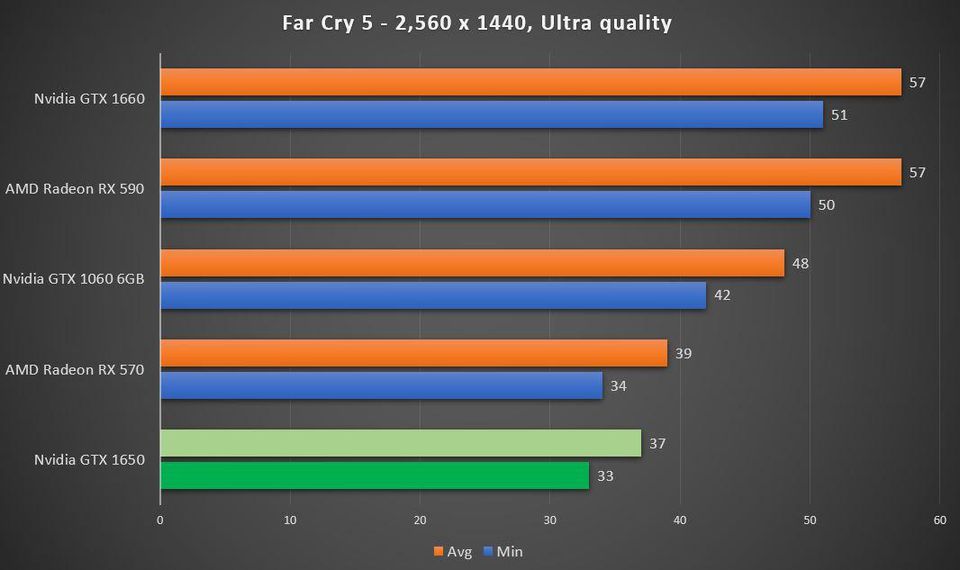

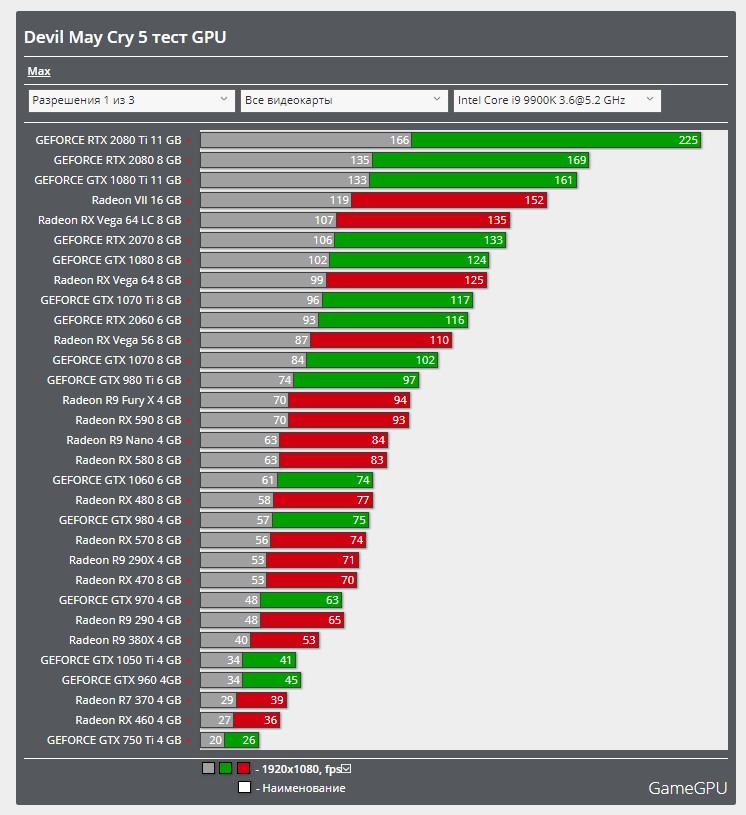

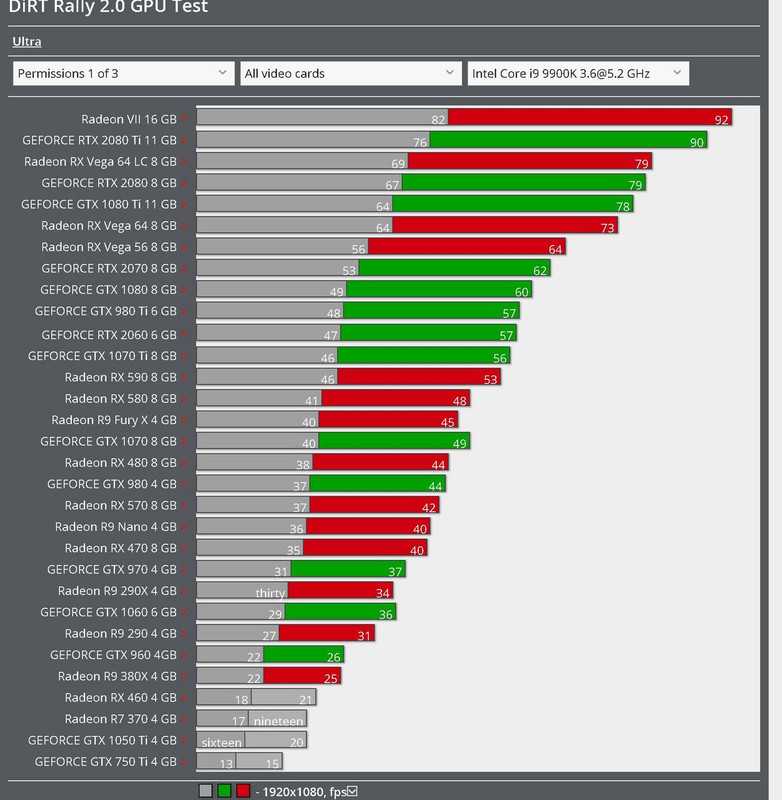

Стоит понимать, что обе компании могут похвастаться мощными видеокартами, однако немалое значение имеют и разработчики игр. Одна игра может быть больше оптимизирована под карты Radeon, а другая под Geforce. Т.е. игра может идти без тормозов на не очень мощной Radeon, но при этом тормозить на довольно производительной Geforce. Однако в большинстве своем разработчики стремятся к «равноправию», чтобы их игра прекрасно шла на всех видеокартах.

Т.е. игра может идти без тормозов на не очень мощной Radeon, но при этом тормозить на довольно производительной Geforce. Однако в большинстве своем разработчики стремятся к «равноправию», чтобы их игра прекрасно шла на всех видеокартах.

Вывод

В целом, можно подвести итог – нельзя сказать определенно, что лучше – Radeon или Geforce, это как выбрать между Ламборджини и Феррари, обе машины по-своему хороши. Вторая позволит вам получить более реалистичную разрушаемость (но не все игры поддерживают эту технологию), однако стоит дороже своего конкурента. Первая имеет чуть более низкую стоимость, но при этом не уступает в производительности своему оппоненту (но не имеет поддержки PhysX).

Если вы выбираете новую видеокарту, но в игры играть не собираетесь, то не мучайтесь в выборе и берите то, что больше нравится, разницы вы не почувствуете. Разница между этими видеокартами не так уж и велика, кто-то использует Джифорс уже много лет, поэтому не желает переходить на Радеон, кому-то больше нравится продукция AMD за ее более низкую стоимость, каждый находит для себя какое-то определенное преимущество. Точного совета в данном вопросе дать нельзя, тут, скорее, роль играют субъективные факторы, если вы готовы чуть-чуть переплатит, то можете покупать продукцию Nvidia, если же деньги для вас важны, то берите видеокарту от AMD.

Точного совета в данном вопросе дать нельзя, тут, скорее, роль играют субъективные факторы, если вы готовы чуть-чуть переплатит, то можете покупать продукцию Nvidia, если же деньги для вас важны, то берите видеокарту от AMD.

AMD против Nvidia — Обзор

Графические карты Nvidia годами уверенно лидировали по сравнению с картами AMD, но линейка AMD Radeon RX 6000-й серии поставила два бренда в такое соревнование, как никогда раньше. Оба производителя постоянно добавляют новые функции и обновляют свою графическую архитектуру в своих картах, чтобы поддерживать конкуренцию, но ключевые функции Nvidia, такие как трассировка лучей и суперсэмплинг, существуют уже давно, тогда как AMD лидирует по частоте кадров (на данный момент). В конечном итоге вам придется решить, предпочитаете ли вы лучшую частоту кадров или лучшую трассировку лучей.

Если вы человек, проигнорируйте это поле

Введите адрес электронной почты:

Что бы вы добавили в свой гардероб, если бы у вас было немного лишних денег? Мы раздаем две подарочные карты Nordstrom на 250 долларов, так что давайте выясним. Участвуйте, чтобы выиграть до 30 сентября 2022 года.

Участвуйте, чтобы выиграть до 30 сентября 2022 года.

Производительность

Авторы и права: Blender Foundation

Качество графики будет просто впечатляющим.

Когда дело доходит до чистой производительности, и AMD, и Nvidia производят потрясающие видеокарты. Для игр с разрешением 1080p вы не ошибетесь с любой компанией. Например, Nvidia RTX 3060 или AMD RX 6600 XT среднего уровня обеспечивают более 60 кадров в секунду независимо от игры. Например, используя Cyberpunk 2077 , игра с высокими требованиями к графике, настроенная на предустановку ультраграфики в этом разрешении, обеспечивает 65 кадров в секунду с RTX 3060 и 70 кадров в секунду с RX 6600 XT.

Игры с разрешением 1440p на сверхвысокой графике немного сложнее для графических карт, но карта верхнего среднего уровня даст вам около 60 кадров в секунду в Cyberpunk 2077 . Nvidia RTX 3070 показывает 62 кадра в секунду, а AMD RX 6700 XT — 56 кадров в секунду. Конечно, уменьшение графической предустановки даст вам более высокую частоту кадров./data/COD4_max_1280_A.png)

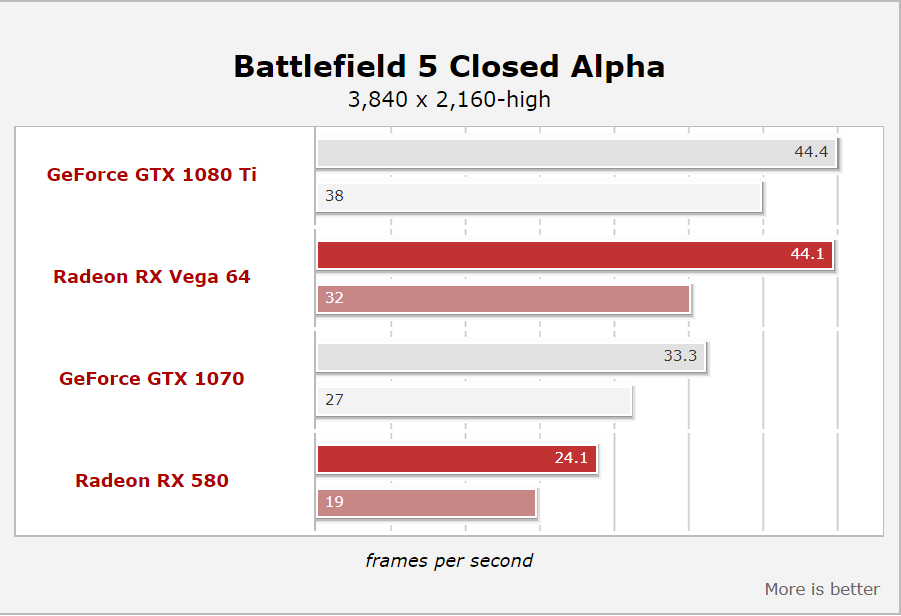

По производительности 4K и трассировки лучей Nvidia заметно опережает AMD. Давайте сначала посмотрим на производительность 4K; с предустановленной ультраграфикой Nvidia RTX 3080 запускает Cyberpunk 2077 со скоростью 40 кадров в секунду, а RTX 3070 — со скоростью 30 кадров в секунду. Между тем, AMD RX 6800 XT (эквивалент 3080) работает со скоростью 37 кадров в секунду, а RX 6700 XT — 25 кадров в секунду.

При ультраграфике 1080p с ультра предустановленной трассировкой лучей RTX 3080 работает со скоростью 58 кадров в секунду, RTX 3070 — 44 кадра в секунду, RX 6800 XT — 38 кадров в секунду, а RX 6700 XT — 23 кадра в секунду.

Если вас интересует производительность видеокарты помимо игр, Nvidia и здесь выигрывает. На его картах есть место, предназначенное для кодирования и декодирования мультимедиа, и это аппаратное ускорение повышает производительность мультимедийных задач, таких как производство видео или онлайн-потоковая передача. AMD полагается на кодирование и декодирование прошивки.

AMD и Nvidia близки, когда дело доходит до игр с разрешением 1080p и 1440p, но Nvidia является явным победителем в играх с 4K и трассировкой лучей.

Наш выбор: Nvidia

Особенности

Авторы и права: Nvidia

Battlefield V с трассировкой лучей Nvidia.

AMD и Nvidia по-разному подходят к функциям программного обеспечения. В то время как AMD стремится создавать программное обеспечение, которое работает на всех устройствах, Nvidia стремится заблокировать свое программное обеспечение в проприетарных системах. Тем не менее, они очень близки по широте предлагаемых функций.

Наиболее заметными улучшениями AMD являются FidelityFX Super Resolution (FSR) и FreeSync. С помощью алгоритмов искусственного интеллекта FSR увеличивает разрешение изображения или повышает резкость изображений с более низким разрешением, а затем увеличивает их, вместо того чтобы изначально отображать изображения с более высоким разрешением. Это приводит к гораздо более высокой частоте кадров в игре. Например, частота кадров RX 6800 XT в Cyberpunk 2077 при ультра настройках графики 4K подскочила с 37 кадров в секунду до 91 кадра в секунду.

Например, частота кадров RX 6800 XT в Cyberpunk 2077 при ультра настройках графики 4K подскочила с 37 кадров в секунду до 91 кадра в секунду.

У Nvidia есть похожая технология, которую она называет Deep Learning Super Sampling (DLSS). Он существует дольше, чем FSR, и, по нашему опыту, DLSS постоянно создает изображения с увеличенным масштабом, которые выглядят более точно по сравнению с исходным изображением, чем FSR, но прирост частоты кадров не такой экстремальный, как с FSR. RTX 3080, например, запускает Cyberpunk 2077 с ультраграфическими настройками 4K с включенным DLSS со скоростью 58 кадров в секунду (средний прирост 18 кадров в секунду).

Однако для трассировки лучей DLSS от Nvidia опережает FSR от AMD. При ультраграфике 1080p с включенной трассировкой лучей в Cyberpunk 2077 FSR увеличивает частоту кадров AMD RX 6800 XT с 38 до 74 кадров в секунду, а DLSS увеличивает частоту кадров Nvidia RTX 3080 с 58 до 101 кадра в секунду.

FreeSync от AMD помогает согласовать частоту кадров видеокарты с частотой кадров вашего монитора. (Это похоже на собственную версию Variable Refresh Rate (VRR) от AMD.) G-Sync от Nvidia делает то же самое. Определяющим фактором здесь является то, поддерживает ли ваш монитор или телевизор G-Sync или FreeSync, но в наши дни мониторы и телевизоры обычно поддерживают и то, и другое.

(Это похоже на собственную версию Variable Refresh Rate (VRR) от AMD.) G-Sync от Nvidia делает то же самое. Определяющим фактором здесь является то, поддерживает ли ваш монитор или телевизор G-Sync или FreeSync, но в наши дни мониторы и телевизоры обычно поддерживают и то, и другое.

Что касается некоторых других функций, если у вас есть графический процессор Nvidia, вы можете использовать GeForce Experience для потоковой передачи игр или для удаленного воспроизведения игр на потоковой коробке Nvidia Shield (вы можете использовать стороннее программное обеспечение для потоковой передачи на другие устройства). Карты Radeon имеют аналогичное программное обеспечение под названием AMD Link, которое включает поддержку многопользовательских игр и удаленную игру на нескольких устройствах.

И Nvidia, и AMD имеют функцию подавления фонового шума микрофона, если вы много говорите, но обе они конкурируют с Microsoft, Discord и Google.

AMD объединяет все свои функции в одно оверлейное меню, но Nvidia решила разделить свои функции на несколько программ и меню. Если вам нужен оптимизированный опыт, AMD будет иметь разрешение, HDR, FSR, частоту обновления и другие настройки в одном месте.

Если вам нужен оптимизированный опыт, AMD будет иметь разрешение, HDR, FSR, частоту обновления и другие настройки в одном месте.

Наш выбор: AMD

Совместимость

Авторы и права: Обзор / Адриен Рамирез

AMD обычно лидирует по частоте кадров, но Nvidia лидирует по трассировке лучей.

И AMD, и Nvidia хорошо справляются с проблемами совместимости и производительностью игр. Невозможно объявить победителя — оба драйвера видеокарты ломаются и ломаются по мере обновления и исправления программного обеспечения. Однако, хотя оба производителя графических процессоров выпускают последовательные обновления прошивки, разработчики программного обеспечения не отдают приоритет обоим производителям.

Поскольку видеокартами Nvidia владеют больше людей, чем видеокартами AMD, разработчики программного обеспечения, скорее всего, в первую очередь сосредоточатся на производительности видеокарт Nvidia. Для большинства программ это не вызывает проблем, но важно проверить совместимость конкретного программного обеспечения в приложениях, критически важных для вашей производительности. (По нашему опыту тестирования графических карт мы столкнулись с некоторыми проблемами с драйверами AMD, в зависимости от тестируемой карты, в то время как драйверы Nvidia не доставили нам проблем во время тестирования.)

(По нашему опыту тестирования графических карт мы столкнулись с некоторыми проблемами с драйверами AMD, в зависимости от тестируемой карты, в то время как драйверы Nvidia не доставили нам проблем во время тестирования.)

Кроме того, профессиональное 3D-программное обеспечение, такое как 3DSMax и Maya, в настоящее время поддерживает больше карт Nvidia, чем карт AMD. Например, в Autodesk Maya 2023 многие карты Nvidia GeForce RTX и GTX работали при тестировании, но этого нельзя сказать о картах серии Radeon RX 6000. (Обратите внимание, что это не означает, что они не работают с Maya . Это просто означает, что они не были протестированы Autodesk).

Для повседневного использования разница между поддержкой AMD и Nvidia наиболее заметна в трассировке лучей. Приложения, поддерживающие трассировку лучей, обычно лучше оптимизированы для драйверов Nvidia, чем для драйверов AMD. Все реже встречаются игры с трассировкой лучей, которые поддерживают только карты Nvidia, но карты AMD по-прежнему кажутся второстепенными. В сочетании с худшей производительностью трассировки лучей AMD в целом, Nvidia является очевидным выбором для энтузиастов трассировки лучей.

В сочетании с худшей производительностью трассировки лучей AMD в целом, Nvidia является очевидным выбором для энтузиастов трассировки лучей.

Наш выбор: Nvidia

Цена

Кредит: Обзор / Джоанна Нелиус

Если для вас важна максимально возможная частота кадров, выбирайте AMD.

Если сравнивать частоту кадров на доллар, AMD выигрывает; если вы не планируете использовать трассировку лучей и не планируете заниматься чем-либо помимо игр, у AMD есть лучшее значение в зависимости от

Например, RTX 3070 получает на 10 кадров в секунду больше, чем RX 6700 XT с Cyberpunk 2077 (ультра 1080p, без трассировки лучей), но он также примерно на 100 долларов дороже, чем RX 6700 XT, и на 0,50 доллара дороже за кадр. Десять кадров — это тоже такая небольшая разница, особенно если учесть, насколько карты AMD могут увеличить частоту кадров при включенном FSR. Вы можете получить RX 6700 XT от 400 до 500 долларов, в то время как вам придется заплатить от 500 до 600 долларов за RTX 3070. (В настоящее время карты AMD нередко продаются по розничной цене.)

(В настоящее время карты AMD нередко продаются по розничной цене.)

Для карт высокого класса: AMD немного дешевле. RTX 3090 Ti, как мы видели, стоили всего 1100 долларов, а RX 6950 XT — всего 935 долларов на Amazon. Между тем, RTX 3080 стоит около 740 долларов, а RX 6800 XT — около 600 долларов на Amazon — это на 1,38 доллара дешевле за кадр в Cyberpunk 2077 с разрешением 1080p Ultra без трассировки лучей.

Что касается бюджета, RTX 3050 стоит всего 300 долларов, а RX 6600 — всего 260 долларов, или на 1,77 доллара дешевле за кадр.

В настоящее время лучшая карта AMD — это RX 6650 XT за 350 долларов (4,45 доллара за кадр), а лучшая карта Nvidia — Founder’s Edition RTX 3060 Ti за 400 долларов (4,70 доллара за кадр).

Наш выбор: AMD

И победителем становится…

Авторы и права: Обзор / Джоанна Нелиус

Если для вас важна максимально возможная частота кадров, выбирайте AMD.

И Nvidia, и AMD делают отличные видеокарты, но Nvidia по-прежнему лидирует.

Если вы заботитесь о трассировке лучей, потоковой передаче, производстве видео или профессиональных приложениях, видеокарты Nvidia — лучший выбор. Производительность трассировки лучей его карт намного выше, чем у AMD, и больше карт Nvidia совместимы с программным обеспечением для 3D-моделирования, чем карты AMD. Однако, если вас не интересует трассировка лучей и вы просто хотите увеличить частоту кадров, AMD предложит лучшую производительность по той же цене.

Разница между Nvidia и AMD намного меньше, чем раньше. AMD имеет лучший пользовательский интерфейс и постоянно добавляет новые функции и обновления для повышения производительности и соответствия набору функций Nvidia. Оба производителя поддерживают синхронизацию мониторов, масштабирование, трассировку лучей, онлайн-трансляции и шумоподавление.

Реализация указанных функций у Nvidia более плавная, но большинству из нас эти функции изначально не нужны. Если вы хотите сэкономить немного денег, карты AMD имеют больше смысла, и вам следует больше думать о том, какой уровень карты вам нужен, а не о том, какого производителя вы выберете.

Для игр с разрешением 1080p Nvidia RTX 3060 и AMD RX 6600 XT — отличный выбор. Для игр с разрешением 1440p стоит перейти на Nvidia RTX 3070 или AMD RX 6700 XT. Если вы планируете повысить частоту кадров 4K или воспользоваться преимуществами трассировки лучей, RTX 3080 стоит потраченных денег. AMD RX 6900 XT может справиться с играми в разрешении 4K, но с трассировкой лучей у него будет гораздо хуже, и он не сэкономит вам много денег по сравнению с аналогичными картами Nvidia.

Вы также должны следить за RTX 3090 и 3090 Ti, которые были замечены всего за 1100 долларов и, вероятно, будут продолжать падать в цене (эта RTX 3080 Ti стоит всего 740 долларов, что на 40 долларов больше, чем базовая RTX 3080).

Сопутствующий контент

Эксперты по продуктам Reviewed позаботятся обо всем, что вам нужно для совершения покупок. Подпишитесь на Reviewed на Facebook, Twitter, Instagram, TikTok или Flipboard, чтобы узнавать о последних предложениях, обзорах продуктов и многом другом.

Цены были точными на момент публикации этой статьи, но со временем могут измениться.

AMD против NVIDIA — какой производитель графического процессора лучше? [Руководство]

Война между двумя титанами индустрии графических процессоров только что возобновилась. Дебаты между AMD и NVIDIA какое-то время могли быть односторонними, но теперь AMD наверстывает упущенное и готова сделать попытку занять трон.

Эта война GPU восходит к 1990-м годам . Хотя AMD имеет гораздо более длинную историю в области технологий, NVIDIA в последнее время доминирует в этой области и гораздо более успешна в финансовом отношении, будучи оценена примерно в два раза дороже.

Стоит иметь в виду, что AMD выделяет большой процент своих ресурсов на процессоры , уделяя им меньше внимания графическим процессорам, чем NVIDIA.

Однако в мире технологий история редко рассматривается; мало кого волнует, что AMD существует с 1950-х годов. Сегодня рынок графических процессоров превратился в ситуацию NVIDIA против AMD . Прокрутите вниз, чтобы найти лучший выбор для вас.

Сегодня рынок графических процессоров превратился в ситуацию NVIDIA против AMD . Прокрутите вниз, чтобы найти лучший выбор для вас.

Table of ContentsShow

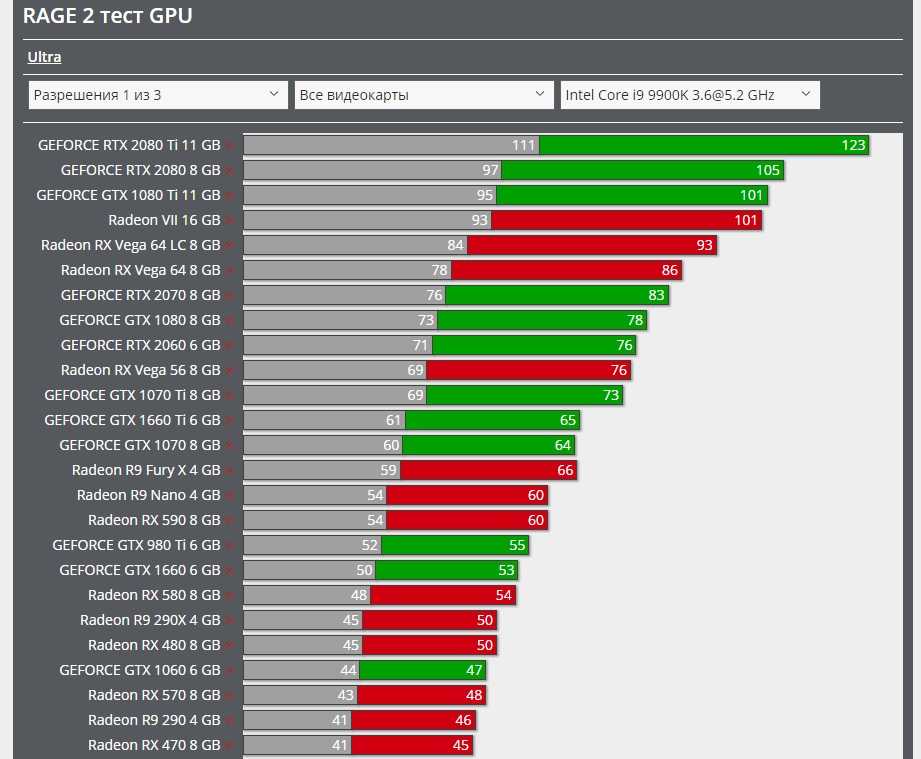

AMD против NVIDIA: производительность

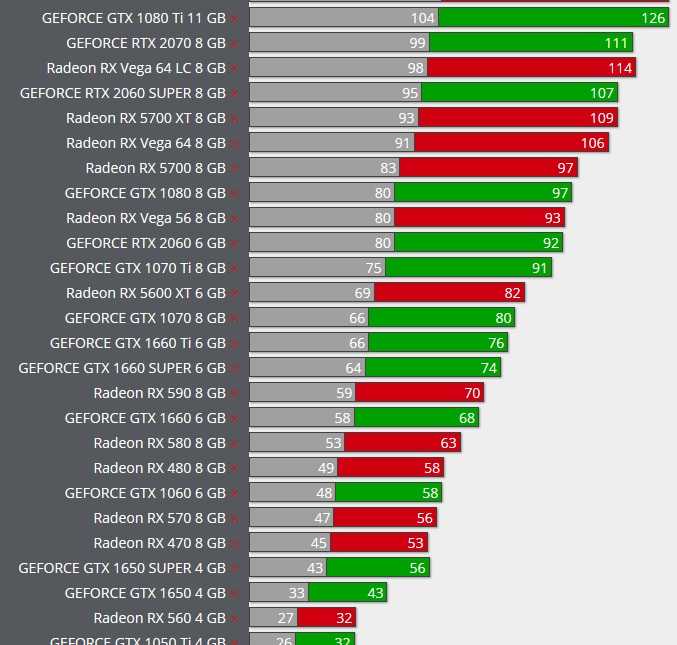

Если вы планируете получить новый GPU , вам, вероятно, будет интересно узнать о потенциальной производительности каждой карты. Достижение 60 кадров в секунду кажется минимальным в современном игровом мире, и хороший графический процессор является ключом к достижению этой производительности.

Тем не менее, сборка нового ПК и обеспечение наилучшей игровой производительности — это не только получение лучшего графического процессора. Также важно знать, что ЦП и ОЗУ должны быть на одном уровне с графическим процессором, чтобы избежать узких мест.

Существует три основных классификации графических процессоров , , каждая из которых представляет отдельную часть рынка. Это бюджетного класса или бюджетного класса , среднего класса или среднего класса и высокого класса .

Это бюджетного класса или бюджетного класса , среднего класса или среднего класса и высокого класса .

Каждая из этих категорий выгодна по-своему, поэтому справедливо сравнивать AMD и NVIDIA для каждой из них.

Бюджетные карты

В этой категории мы рассмотрим RX 5500 XT и GTX 1660 , поскольку они, вероятно, являются лучшими бюджетными картами, которые AMD и NVIDIA могут предложить в ценовом диапазоне $200 .

Они обе являются хорошими представителями предыдущих флагманских технологий соответствующих производителей (RDNA от AMD и Turing от NVIDIA) и на самом деле неплохо сочетаются друг с другом.

Причина, по которой мы не говорим о RDNA 2 и Ampere , заключается в том, что в этой ценовой категории нет бюджетных карт.

В то время как RX 5500 XT предлагает лучшие базовая тактовая частота при 1685 МГц по сравнению с GTX 1660 1530 МГц, NVIDIA мудро использовала это в своих интересах и предложила лучшую тактовую частоту при 1785 МГц, что выше игровой частоты AMD при 1737 МГц.

Хотя вы вряд ли заметите разницу, интересно, как это соревнование распространилось даже на мельчайшие детали.

AMD еще раз демонстрирует свои возможности с 8 ГБ оперативной памяти GDDR6 , которая определенно лучше, чем NVIDIA 6 ГБ GDDR5 . Он также имеет более высокую пропускную способность памяти и больший объем кэш-памяти L2, но, как вы уже могли догадаться, NVIDIA потребляет меньше энергии для GTX 1660. царит безраздельно. Несмотря на ранее упомянутые характеристики в пользу AMD и хотя она потребляет меньше энергии, NVIDIA в конечном итоге работает лучше.

Поскольку геймеров гораздо меньше интересует энергопотребление, чем производительность, NVIDIA является победителем в этой категории.

Mid-Range

В этой категории мы рассмотрим AMD RX 6700 XT и NVIDIA RTX 3060 Ti, , так как это два отличных варианта, которые представляют набег соответствующих компаний на GPU среднего уровня.

Битва на этом уровне намного интереснее, так как карты в средней категории не так равномерно подобраны, как раньше.

Консенсус среди бенчмаркеров ясен: RX 6700 XT просто лучшая карта . RTX 3060 Ti имеет сопоставимую производительность и еще больше сокращает разрыв в разрешении 1440p, но в целом 6700 XT просто даст вам больше FPS.

Однако одним из самых важных вопросов здесь является цена . RTX 3060 Ti значительно дешевле — 399 долларов , а RX 6700 XT — 479 долларов . Это приводит к нашему следующему вопросу: какая карта имеет лучшую ценность?

Сомнительно, стоит ли вообще сравнивать эти карты, но на данный момент это лучшие карты среднего уровня от каждого производителя.

Дело в том, что производительность RTX 3060 Ti соответствует ценовому уровню, по которому она предлагается, что можно сказать и о RX 6700 XT. Несмотря на разницу в цене, RX 6700 XT лучше карты , что является победой для AMD.

High-End

Здесь все становится немного сложнее. Это связано с тем, что до выпуска серии RX 6000 AMD не предлагала ничего, что могло бы конкурировать с NVIDIA, поэтому NVIDIA имеет огромное преимущество в этой области .

Тем не менее, мы все еще можем сравнить карты AMD и NVIDIA, но сначала нам нужно поговорить о слоне в комнате .

В своих последних поколениях обе компании выпустили отличные карты для энтузиастов. Хотя AMD RX 6900 XT стоит всего на 200 долларов больше, чем high-end RTX 3080 от NVIDIA, и можно утверждать, что они должны быть в той же группе, мы сравним RX 6800 XT с RTX 3080.

Эти цены перевернуты по сравнению со средним диапазоном, поскольку карта NVIDIA RTX 3080 является более дорогой. Разница в цене на 50 долларов с , вероятно, не кажется большой, когда вы тратите 650-700 долларов, но что делает его особенно интересным, так это производительность.

В целом, RX 6800 XT — лучшая карта с точки зрения производительности растеризации.

Тем не менее, RTX 3080 работает лучше в отделе трассировки лучей , что не следует упускать из виду. Эта технология все еще относительно нова, но она существует достаточно долго, чтобы ожидать большего от AMD.

Вы все еще можете отдать им должное, поскольку это их первая попытка, но факт остается фактом: не работал так же хорошо, как NVIDIA . Тем не менее, будущие обновления драйверов и лучшая оптимизация игр, ориентированных на AMD , должны привести к повышению производительности.

Трассировка лучей по-прежнему встречается на рынке относительно редко, включая удивительную новую функцию от NVIDIA: DLSS. Эта функция может значительно повысить производительность при минимальном снижении визуального качества.

В конце концов, было бы несправедливо ставить балл NVIDIA, учитывая, что в огромном проценте игр еще не используется трассировка лучей или DLSS. Итак, этот момент принадлежит AMD.

Общий балл: AMD 2 – NVIDIA 1

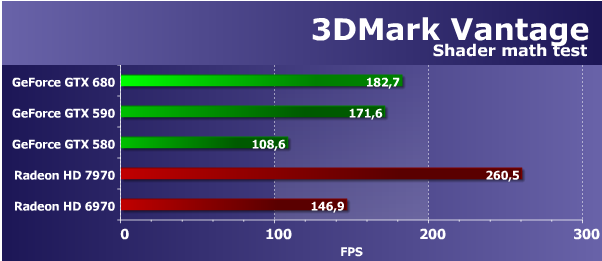

AMD против NVIDIA: Характеристики

Хотя функции могут показаться менее важными, чем фактические характеристики, они являются важной частью того, что делает хороший GPU. AMD и NVIDIA предлагают аналогичные графические процессоры с точки зрения аппаратного обеспечения и цены, но дьявол кроется в деталях или, в данном случае, в функциях.

AMD и NVIDIA предлагают аналогичные графические процессоры с точки зрения аппаратного обеспечения и цены, но дьявол кроется в деталях или, в данном случае, в функциях.

Трассировка лучей

Если есть о чем поговорить, так это об этом. Хотя трассировка лучей не является обязательным требованием для хорошей производительности графического процессора, она имеет явное значение, предлагая более качественные и реалистичные визуальные эффекты .

Что такое трассировка лучей?

Помимо технических пояснений, трассировка лучей — это метод рендеринга , который позволяет более точно отображать освещение за счет учета таких переменных, как материалы объектов и то, как свет отражается от них.

Трассировка лучей присуждается NVIDIA, поскольку они первыми реализовали ее в своих графических процессорах. С появлением Big Navi у AMD есть шанс проявить себя в этом отношении. До сих пор серия RX 6000 работала достаточно хорошо, но все же не так хорошо, как лучшая от NVIDIA.

NVIDIA использует технологию трассировки лучей с 2000-х годов, представив ее миру в 2018 году. Этот шаг подчеркнул их доминирование на рынке графических процессоров, и AMD еще предстоит полностью оправиться от него.

Следующее поколение игровых консолей Playstation 5 и Xbox Series X не позволит своим именам ассоциироваться с чем-то меньшим, чем топ-оф-лайн. AMD очень откровенно заявила о своем намерении внедрить трассировку лучей в свои следующие графические процессоры.

В то время как с введением трассировки лучей для AMD все выглядит многообещающе, точка здесь должна перейти к рыночному новатору NVIDIA .

Затенение с переменной скоростью

VRS — это технология, впервые представленная на рынке NVIDIA , которая нашла свое лучшее применение в VR . По сути, он вычисляет, какие кадры в вашем поле зрения будут полностью затенены или даже отрисованы вообще. Это значительно снижает нагрузку на GPU, перенаправляя эту дополнительную энергию на более полезные дела.

По сути, он вычисляет, какие кадры в вашем поле зрения будут полностью затенены или даже отрисованы вообще. Это значительно снижает нагрузку на GPU, перенаправляя эту дополнительную энергию на более полезные дела.

Наибольшее внимание при затенении уделяется тому, на что больше всего смотрит игрок.

AMD до сих пор не внедрила эту технологию в свои графические процессоры, но ходят слухи, что она будет представлена в их линейке RDNA 2, поскольку AMD подала заявку на патент на VRS еще в начале 2019 года..

Также ходили разговоры о том, что совершенствует технологию отслеживания взгляда и использует ее для дальнейшего улучшения VRS, что звучит как научно-фантастическая идея.

Поскольку мы смогли увидеть эту крутую технологию в действии на стороне NVIDIA, она также заслуживает этого балла.

Суперсэмплинг для глубокого обучения

Разработанный как еще один способ повысить эффективность графического процессора, DLSS является новаторской технологией. Его можно даже считать опережающим свое время из-за процесса, необходимого для полного использования его преимуществ.

Его можно даже считать опережающим свое время из-за процесса, необходимого для полного использования его преимуществ.

Самая большая проблема заключается в том, что разработчики игр должны включать поддержку DLSS при создании игры. Чтобы игрок увидел улучшение, его необходимо отправить в NVIDIA, которая затем позволяет ИИ запустить игру, проанализировать изображения и автоматически масштабировать их до более высокого разрешения .

Изначально тот факт, что NVIDIA берет на себя тяжелую работу, был одним из самых больших недостатков DLSS. Процесс не был так оптимизирован, как хотелось бы, и в результате DLSS выглядел скорее интересной идеей, чем эффективной технологией.

С появлением архитектуры NVIDIA Ampere этот процесс был упрощен, и мы, безусловно, ожидаем дальнейших улучшений.

G-Sync по сравнению с FreeSync

Это технологии адаптивной синхронизации NVIDIA и AMD, предназначенные для устранения разрывов экрана во время игры. Разрыв экрана возникает, когда выходная мощность графического процессора не соответствует частоте обновления дисплея.

Разрыв экрана возникает, когда выходная мощность графического процессора не соответствует частоте обновления дисплея.

Связь между графическим процессором и монитором в основном работает следующим образом: если монитор обновляется с частотой 60 Гц, от графического процессора требуется отправить 60 кадров (то же самое для 120 Гц, 144 Гц и т. д.).

Проблема обычно возникает, когда графический процессор не может создать требуемые кадры, что приводит к разрыву экрана .

Технология адаптивной синхронизации позволяет графическому процессору эффективно изменять частоту обновления монитора в зависимости от количества производимых кадров.

Если игра падает до 40 кадров в секунду, графический процессор ограничивает частоту обновления монитора 40 Гц. Однако это не делает игру более плавной; это просто предотвращает разрыв экрана.

В не столь отдаленном прошлом решение для этого было основано на программном обеспечении, в первую очередь с помощью VSync , но оно постепенно заменяется более новыми технологиями.

G-Sync — это решение NVIDIA для разрыва экрана, которое вызвало некоторую критику. NVIDIA первой поэкспериментировала с технологией адаптивной синхронизации и использовала ее в своих интересах, хотя и с некоторыми требованиями к оборудованию. Мониторы должны быть совместимы с G-Sync, и, хотя это не указано конкретно, это влечет за собой дополнительную0037 Цена от 100 до 300 долларов .

Для запуска G-Sync мониторам требуется проприетарный модуль масштабирования NVIDIA G-Sync , что означает, что все они будут иметь одинаковые экранные меню и параметры.

Это самое большое преимущество AMD FreeSync : использование стандарта Adaptive Sync, встроенного в спецификацию DisplayPort 1.2a, позволяет производителям выбирать любой более дешевый масштабатор.

Тем не менее, у G-Sync есть лучший способ обработки GPU, производящего слишком много кадров. это будет зафиксируйте верхний предел частоты кадров графического процессора на уровне монитора. FreeSync, когда внутриигровая VSync отключена, позволяет графическому процессору создавать дополнительные кадры. Это может привести к разрыву экрана, но также снижает задержку ввода.

FreeSync, когда внутриигровая VSync отключена, позволяет графическому процессору создавать дополнительные кадры. Это может привести к разрыву экрана, но также снижает задержку ввода.

Самая большая проблема , которая разделяет сообщество, заключается в том, что не все карты NVIDIA работают с мониторами FreeSync, так же как не все карты AMD будут работать с мониторами G-Sync. Это устраняется, но факт остается фактом: вам нужно будет проверить, будет ли ваш монитор правильно работать с вашим графическим процессором.

Хотя у обеих сторон есть свои плюсы и минусы, когда дело доходит до технологии адаптивной синхронизации, тот факт, что FreeSync более доступен, — это то, что в конечном итоге приносит AMD очко.

Общий балл: 3 AMD – NVIDIA 4

AMD против NVIDIA: драйверы и ПО

Дело в том, что хорошее железо требует хорошего ПО. Драйверы — это программы, управляющие взаимодействием определенного устройства (например, графического процессора) с ЦП. Это позволяет программному обеспечению использовать оборудование, которым оно управляет, в меру своих возможностей без необходимости контролировать каждый аспект работы этой конкретной части.

Это позволяет программному обеспечению использовать оборудование, которым оно управляет, в меру своих возможностей без необходимости контролировать каждый аспект работы этой конкретной части.

Как упоминалось ранее, Серия AMD RX 5000 с треском провалилась при запуске, из-за проблем с драйверами, создающих черных экранов и сбоев . К сожалению, эта проблема сохраняется, несмотря на то, что новые драйверы пытаются ее исправить.

Проблемы NVIDIA одинаково проблематичны, поскольку они часто меньше и, следовательно, их труднее идентифицировать.

AMD значительно улучшила возможности своих драйверов благодаря ежегодным обновлениям Radeon Adrenalin . Версия 2020 года якобы предлагает впечатляющее улучшение на 12% по сравнению с версией 2019 года.

AMD также прилагает сознательные усилия для упрощения и использует только одну часть программного обеспечения для обновления своих драйверов. Они следовали графику не реже одного раза в месяц с крупными выпусками.

Они следовали графику не реже одного раза в месяц с крупными выпусками.

Самой большой неудачей для AMD являются постоянные проблемы с их продуктами, на устранение которых уходит много времени.

График обновления драйверов NVIDIA состоит из двух разных приложений для управления их оборудованием. Их NVIDIA Панель управления позволяет настраивать такие аспекты, как настройки 3D и разрешение экрана. GeForce Experience отвечает за оптимизацию игр, обновления драйверов и дополнительные функции.

Панель управления NVIDIA не претерпела изменений UX или UI более десяти лет . Дизайн устарел, и иногда может быть невероятно медленным .

GeForce Experience, в целом, звучит как отличная идея, но это не то, на что надеялись пользователи. Пользователи должен войти в систему, чтобы использовать доступные функции, такие как автоматическое обновление драйверов, запись, счетчик FPS и т. д. Для многих GE считается вредоносным ПО.

д. Для многих GE считается вредоносным ПО.

Для сравнения, Radeon Software намного быстрее, гораздо более интуитивно понятен, не требует учетной записи и предоставляет другие полезные функции, такие как Radeon Chill, Radeon Boost, ручной и автоматический разгон, пониженное напряжение, ручная кривая вентилятора и многое другое.

В конце концов, несмотря на то, что у AMD есть свои недостатки, эффективная простота, с которой работает ее программное обеспечение, приносит им балл в этой категории.

Общий балл: AMD 4 – NVIDIA 4

AMD против NVIDIA: энергопотребление и эффективность

Когда AMD представила Navi и объявила о своей ставке на 7-нанометровый техпроцесс TSMC 507 903 , они, вероятно, подумали, что это потрясающе 507 903 % на ватт производительности устранит разрыв в эффективности.

К сожалению, это было не так: Navi не превзошла даже старые графические процессоры NVIDIA, построенные на 12-нм узле последнего поколения TSMC.

Будущее для AMD выглядит ярче, поскольку ее карты RDNA 2 смогли обеспечить еще одно 50-процентное обновление по сравнению с RDNA .

Это не совсем черно-белое изображение. В экстремальном диапазоне производительности NVIDIA RTX 3090 потребляет много энергии, и только RX 6900 XT приближается к .

Можно было бы сказать, что RX 6800 XT потребляет меньше энергии, чем RTX 3090, но это полностью игнорировало бы тот факт, что последний просто лучше GPU.

Переключается в среднем диапазоне, где RTX 3070 работает лучше, но лишь с небольшим отрывом. Этот отрыв такой же с точки зрения общей производительности, поэтому мы не можем назвать это победой NVIDIA.

На данный момент NVIDIA просто лучше работает в бюджетной категории, и здесь не о чем спорить. Обе компании готовят свои бюджетные карты для своего последнего поколения, поэтому этот раздел может нуждаться в обновлении в ближайшее время.

NVIDIA немного опережает AMD по показателю производительности на ватт в своих последних поколениях, а также в нескольких предыдущих поколениях. Хотя AMD догоняет, ее должна беспокоить эффективность NVIDIA в использовании литографии предыдущего поколения.

Хотя AMD догоняет, ее должна беспокоить эффективность NVIDIA в использовании литографии предыдущего поколения.

Общий балл: AMD 4 – NVIDIA 5

AMD против NVIDIA: стоимость в долларах

Несмотря на то, что большинство геймеров ищут в своих графических процессорах высочайшую производительность, необходимо учитывать и цену . Как обсуждалось ранее, есть три основные категории как по цене, так и по производительности.

NVIDIA имеет явное преимущество в экстремальном ценовом диапазоне с точки зрения производительности, но этот разрыв постепенно сокращается, поскольку AMD RX 6900 XT приближается к RTX 309.0 , будучи на целых 500 долларов дешевле .

Если мы опустимся на уровень ниже, где RX 6800 XT на 50 долларов дешевле, чем RTX 3080 , будет разумно утверждать, что это лучший вариант.

Тем не менее, из-за лучшей производительности трассировки лучей RTX 3080 , трудно прямо сказать, что лучше. Из-за разницы в цене допустим, что AMD имеет небольшое преимущество в этой ценовой категории.

Из-за разницы в цене допустим, что AMD имеет небольшое преимущество в этой ценовой категории.

Спускаясь дальше к среднему ценовому диапазону, мы получаем гораздо более ясную картину. Хотя RX 6800 дороже, чем RTX 3070, она также является лучшей картой, и ее стоимость составляет оправдано .

Однако, поскольку вопрос здесь заключается в стоимости в долларах, мы считаем, что обе карты работают соответственно своей цене, поэтому мы будем называть это ничьей.

Хотя сравнения в основном кажутся равнозначными, производительность на доллар в пользу AMD, поэтому на этот раз они добились успеха. Имейте в виду, что было близким совпадением с .

И победителем становится…

При сумме баллов от 5 до 5, нет лучшего производителя карт . Конечно, дебаты AMD против NVIDIA носят субъективный характер, и вы не должны слепо покупать карту какой-либо компании.

Общий совет, прежде чем инвестировать в компонент для ПК, заключается в том, чтобы узнать свои требования и бюджет.