Графический чип: Что такое графический процессор и как он работает

Содержание

Что такое графический процессор и как он работает

На что мы смотрим в первую очередь, выбирая себе смартфон? Если на минутку отвлечься от стоимости, то в первую очередь мы, конечно, выбираем размер экрана. Затем нас интересует камера, объем оперативной, количество ядер и частота работы процессора. И тут все просто: чем больше, тем лучше, а чем меньше, тем, соответственно, хуже. Однако в современных устройствах используется еще и графический процессор, он же GPU. Что это такое, как он работает и почему про него важно знать, мы расскажем ниже.

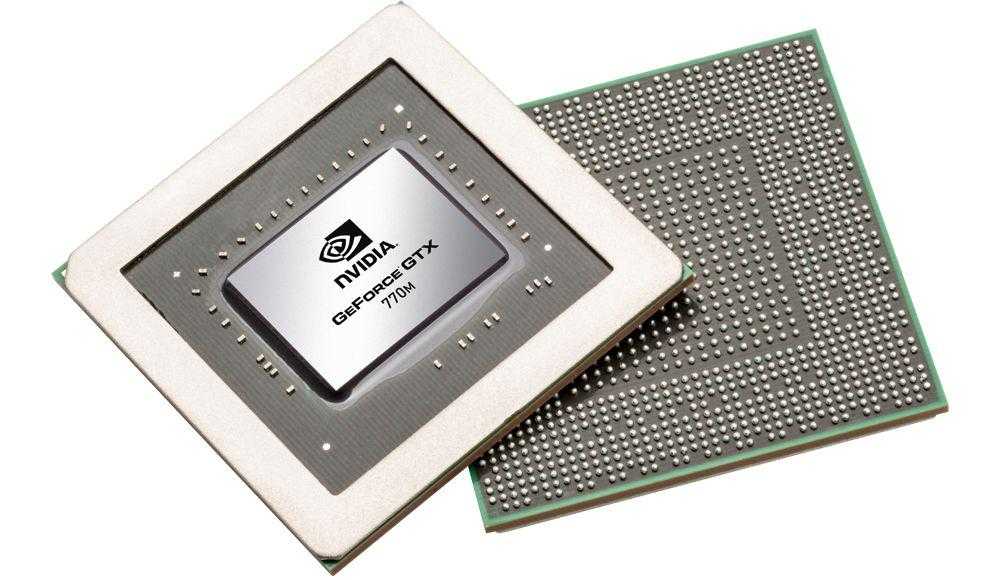

GPU (Graphics Processing Unit) — это процессор, предназначенный исключительно для операций по обработке графики и вычислений с плавающей точкой. Он в первую очередь существует для того, чтобы облегчить работу основного процессора, когда дело касается ресурсоемких игр или приложений с 3D-графикой. Когда вы играете в какую-либо игру, GPU отвечает за создание графики, цветов и текстур, в то время как CPU может заняться искусственным интеллектом или расчетами механики игры.

Архитектура графического процессора не сильно отличается от архитектуры CPU, однако она более оптимизирована для эффективной работы с графикой. Если заставить графический процессор заниматься любыми другими расчетами, он покажет себя с худшей стороны.

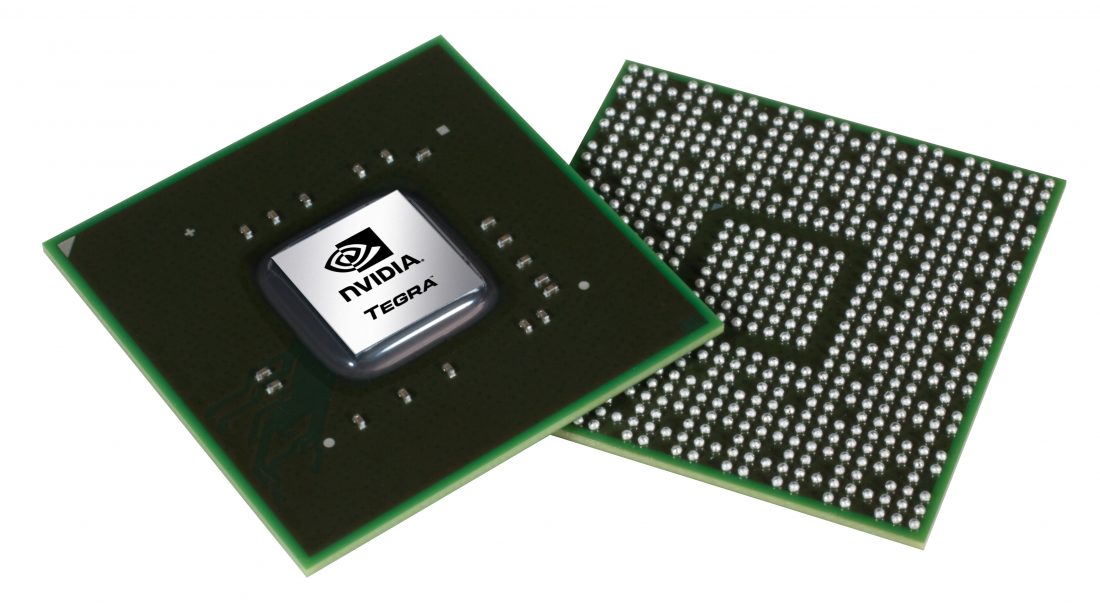

Видеокарты, которые подключаются отдельно и работают на высоких мощностях, существуют только в ноутбуках и настольных компьютерах. Если мы говорим об Android-устройствах, то мы говорим об интегрированной графике и том, что мы называем SoC (System-on-a-Chip). К примеру, в процессоре Snapdragon 810 интегрирован графический процессор Adreno 430. Память, которую он использует для своей работы, это системная память, в то время как для видеокарт в настольных ПК выделяется доступная только им память. Правда, существуют и гибридные чипы.

В то время как процессор с несколькими ядрами работает на высоких скоростях, графический процессор имеет много процессорных ядер, работающих на низких скоростях и занимающихся лишь вычислением вершин и пикселей. Обработка вершин в основном крутится вокруг системы координат. GPU обрабатывает геометрические задачи, создавая трехмерное пространство на экране и позволяя объектам перемещаться в нем.

Обработка вершин в основном крутится вокруг системы координат. GPU обрабатывает геометрические задачи, создавая трехмерное пространство на экране и позволяя объектам перемещаться в нем.

Обработка пикселей является более сложным процессом, требующим большой вычислительной мощности. В этот момент графический процессор накладывает различные слои, применяет эффекты, делает все для создания сложных текстур и реалистичной графики. После того как оба процесса будут обработаны, результат переносится на экран вашего смартфона или планшета. Все это происходит миллионы раз в секунду, пока вы играете в какую-нибудь игру.

Конечно же, этот рассказ о работе GPU является весьма поверхностным, но его достаточно для того, чтобы составить правильное общее представление и суметь поддержать разговор с товарищами или продавцом электроники либо понять — почему ваше устройство так сильно нагрелось во время игры. Позднее мы обязательно обсудим преимущества тех или иных GPU в работе с конкретными играми и задачами.

По материалам AndroidPit

- Теги

- Мобильные процессоры

- Мобильные технологии

- Новичкам в Android

Лонгриды для вас

Не устанавливается Сбербанк Онлайн на Андроид. Что делать

Несмотря на то что Сбербанк Онлайн на Android по-прежнему доступен для загрузки, в отличие от iOS, это не значит, что у пользователей мобильной ОС от Google нет с ним никаких проблем. У кого-то приложение попросту вылетает, у кого-то не обновляется, а у кого-то — что, пожалуй, хуже всего — в принципе не устанавливается. Смартфон исправно загружает APK-файл банковского клиента и даже начинает установку, но в какой-то момент выдаёт ошибку с текстом «Приложение не установлено». В чём причина такого поведения и как с ним бороться, поговорим в этой статье.

Читать далее

Как посмотреть пароли в Гугл Хром

С каждым днем количество различных логинов и паролей в нашем использовании только увеличивается. Требования к ним у сайтов и приложений все больше ужесточаются. Уже недостаточно просто придумать длинный пароль. Необходимо, чтобы он содержал большие буквы и различные символы. Ну и про длину, естественно, никто не забывает. Чтобы самим не придумывать подобные сложные сочетания знаков, на выручку приходят встроенные в систему менеджеры паролей, предлагающие оптимальные варианты, которые практически невозможно подобрать.

Требования к ним у сайтов и приложений все больше ужесточаются. Уже недостаточно просто придумать длинный пароль. Необходимо, чтобы он содержал большие буквы и различные символы. Ну и про длину, естественно, никто не забывает. Чтобы самим не придумывать подобные сложные сочетания знаков, на выручку приходят встроенные в систему менеджеры паролей, предлагающие оптимальные варианты, которые практически невозможно подобрать.

Читать далее

Черно-белый экран на телефоне Android: как включить и как выключить

Производители смартфонов соревнуются в том, чей экран поддерживает больше цветов. Кто-то заявляет 6 миллионов оттенков, а кто-то — более миллиарда. А что, если экран в одночасье станет черно-белым? У многих людей это вызовет раздражение, ведь мы любим наблюдать за окружающим миром во всех красках. В то же время найдутся и те, кто попытается разобраться, как сделать черно-белый экран, так как монохром кажется им, например, более безопасным для глаз. Сегодняшний материал для обеих категорий людей. И для тех, кто не знает, что делать, если экран черно-белый, и для тех, кто хочет сделать его таковым.

Сегодняшний материал для обеих категорий людей. И для тех, кто не знает, что делать, если экран черно-белый, и для тех, кто хочет сделать его таковым.

Читать далее

Новый комментарий

Новости партнеров

Это ж неспроста. Почему Apple сокращает выпуск iPhone

Как получить карту иностранного банка в России онлайн. Она работает с Apple Pay и стоит 10 долларов

Как подключить Сбербанк к СБПэй и платить Айфоном по NFC без Apple Pay. Это реально

Спасибо процессорам M-серии. Наконец на Mac стали выходить крутые игры

Новый графический чип обошелся Nvidia в $3 млрд

Цифровизация

Электроника

Техника

Маркет

|

Поделиться

Nvidia представила ряд новых технологий в области машинного обучения, ИИ и «облаков», а также анонсировала новые направления сотрудничества с Toyota и SAP. Разработка чипа Volta GV100 в новой архитектуре обошлась компании в $3млрд.

Разработка чипа Volta GV100 в новой архитектуре обошлась компании в $3млрд.

Новое поколение производительной графики

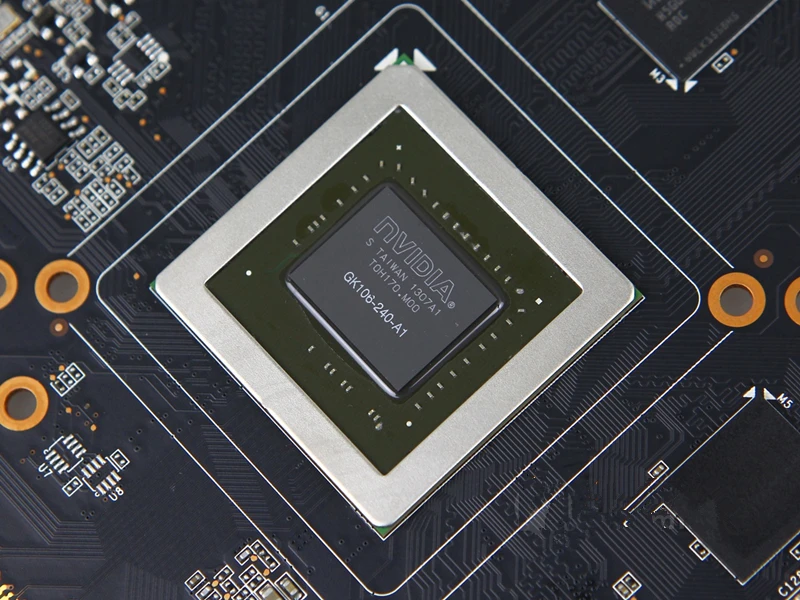

Nvidia в рамках конференции GTC 2017 анонсировала новое поколение графической архитектуры Volta, первый графический процессор Volta GV100 на его основе, а также первый графический ускоритель на этом чипе – Tesla V100, предназначенный для работы в составе производительных дата-центров.

По словам Дженсена Хуанга (Jen-Hsun Huang), представившего новую архитектуру, разработка чипа обошлась компании примерно в $3 млрд. Новый чип содержит более 5000 потоковых процессоров, новые исполнительные блоки Tensor для увеличения производительности в матричных вычислениях. Процессор Volta GV100 также обладает кеш-памятью первого и второго уровней, текстурными блоками, контроллером VRAM, системным интерфейсом и по 8 блоков Tensor на мультипроцессорный кластер (SM), в сумме 672 блоков.

Как отметил в своем выступлении Дженсен Хуанг, архитектура Nvidia Volta призвана стать катализатором новой волны достижений в области искусственного интеллекта и высокопроизводительных вычислений. Первый процессор на базе Volta – GPU Tesla V100, разработан специально для дата-центров и обеспечивает высокую скорость и масштабируемость обучения и взаимодействия глубоких нейронных сетей, а также ускоряет высокопроизводительные и графические вычисления.

Первый процессор на базе Volta – GPU Tesla V100, разработан специально для дата-центров и обеспечивает высокую скорость и масштабируемость обучения и взаимодействия глубоких нейронных сетей, а также ускоряет высокопроизводительные и графические вычисления.

Подробности о новой архитектуре

Volta представляет собой седьмое поколение графических архитектур Nvidia. По данным компании, чип обеспечивает производительность задачах в глубокого обучения, эквивалентную производительности 100 современных процессоров.

Дженсен Хуанг, глава Nvidia, представляет процессор Volta

Пиковая производительность Volta в 5 раз выше предыдущей архитектуры Nvidia Pascal и в 15 раз выше производительности представленной два года назад архитектуры Nvidia Maxwell. По данным компании, темпы роста производительности графических архитектур Nvidia вчетверо больше того, что предсказывал закон Мура.

Новый процессор содержит порядка 21,1 млрд транзисторов, площадь его кристалла составляет 815 кв. мм.

мм.

Выпуском графических процессоров Nvidia GV100 займется тайваньский производственный холдинг TSMC. Чипы будут производиться по технологическому процессу FFN с соблюдением норм 12-нм.

В Nvidia планируют, что архитектура Volta станет новым стандартом высокопроизводительных вычислений. Благодаря объединению ядер CUDA и нового ядра Volta Tensor в унифицированной архитектуре, один сервер на базе GPU Tesla V100 сможет заменить сотни центральных процессоров в высокопроизводительных вычислениях. Матричные вычисления в блоках Tensor увеличивают производительность нового ядра в задачах машинного обучения до 120 Тфлопс, быстродействие GV100 в вычислениях с точностью FP32 составляет 15 Тфлопс, FP64 7,5 Тфлопс.

Список ключевых технологий GPU Tesla V100, которые позволили преодолеть 100-терафлопсный рубеж в задачах глубокого обучения, включает специализированные ядра Tensor, созданные для ускорения работы искусственного интеллекта. Оснащенный 640 ядрами Tensor, процессор V100 обеспечивает производительность 120 терафлопс в глубоком обучении, что эквивалентно производительности 100 CPU.

Интерфейс NVLink поднимает на новый уровень скорость взаимодействия между графическими и центральным процессорами, вдвое увеличивая пропускную способность по сравнению с предыдущим поколением NVLink.

Графическая память HBM2 DRAM с производительностью до 900 ГБ/с, разработанная совместно с Samsung, увеличивает полосу пропускания на 50% по сравнению с предыдущим поколением. Ядро Volta GV100 взаимодействует с буферной памятью HBM2 по 4096-битной шине.

Тактовая частота ядра Volta GV100 составляет 1455 МГц. Энергопотребление ускорителя Tesla V100 не превышает 300 Вт, что практически сравнимо с показателями ускорителя предыдущей архитектуры Tesla P100.

В рамках анонса также было представлено программное обеспечение с оптимизацией под архитектуру Volta, включая CUDA, cuDNN и TensorRT.

Новые суперкомпьютеры DGX на базе Volta

Вместе с новой архитектурой Nvidia также представила обновленную линейку суперкомпьютеров с искусственным интеллектом DGX AI. Системы построены на GPU Nvidia Tesla V100 и используют полностью оптимизированное для задач ИИ программное обеспечение.

Системы построены на GPU Nvidia Tesla V100 и используют полностью оптимизированное для задач ИИ программное обеспечение.

Производительность такой системы втрое выше, чем у предыдущего поколения DGX, и соответствует мощности примерно 800 CPU в рамках всего одной системы.

Платформа Nvidia GPU Cloud

Дроны, роботы и VR: какие инновации востребованы в металлургии

Инновации для промышленности

Новая Nvidia GPU Cloud (NGC) представляет собой облачную платформу с удобным удаленным доступом для разработчиков — с помощью ПК, системы DGX или облака, к полноценному набору инструментов внедрения ИИ.

Благодаря NGC, разработчики смогут получать доступ к новейшим оптимизированным фреймворкам и передовым ускорителям.

Nvidia и сотрудничество с Toyota

На GTC 2017 также было объявлено о сотрудничестве Nvidia и Toyota.

Искусственный интеллект помог сохранить редкий язык

Инновации для промышленности

Toyota планирует начать внедрение автомобильной вычислительной платформы с поддержкой искусственного интеллекта Nvidia DRIVE PX в системы автономного вождения, запланированные к выводу на рынок в течение ближайших лет.

Команды инженеров обеих компаний уже работают над созданием программного обеспечения на ИИ-платформе Nvidia, которое позволит лучше понимать огромные объемы данных, получаемых с автомобильных датчиков, и автономно справляться с широким спектром ситуаций на дороге.

Для того чтобы справляться с задачами подобного уровня вычислительной сложности, в прототипах автомобилей зачастую используют мощные компьютеры, которые занимают весь багажник. Платформа Nvidia DRIVE PX на базе процессора нового поколения Xavier помещается в руке, обеспечивая при этом до 30 млрд операций глубокого обучения в секунду.

Проект SAP Brand Impact

На конференции был представлен проект SAP Brand Impact на базе решений Nvidia для глубокого обучения. Проект обеспечивает измерение атрибутов бренда – например, логотипов, практически в реальном времени.

Эффективный анализ видеоконтента стал возможен благодаря использованию для анализа глубоких нейросетей, обученных на Nvidia DGX-1 и TensorRT.

«С такими партнерами как Nvidia, наши возможности безграничны, — отметил CIO SAP Юрген Мюллер (Juergen Mueller). – Новые приложения, беспрецедентная производительность с нынешних приложениях и простой доступ к сервисам машинного обучения обеспечит вам высокий уровень интеллекта вашего собственного предприятия».

О конференции GTC 2017

Ежегодная конференция Nvidia по GPU-технологиям – GPU Technology Conference (GTC), проходит на этой неделе в Сан-Хосе, Калифорния.

В конференции принимают участие порядка 7000 специалистов, для которых будет представлено около 600 технических сессий, 150 стендов, 310 сессий по искусственному интеллекту и 67 лабораторий по технологиям глубокого обучения (Deep Learning).

- Как выполнять указ президента №250 «О дополнительных мерах информационной безопасности»

Владимир Бахур

Графический процессор (GPU)

Что такое графический процессор (GPU)?

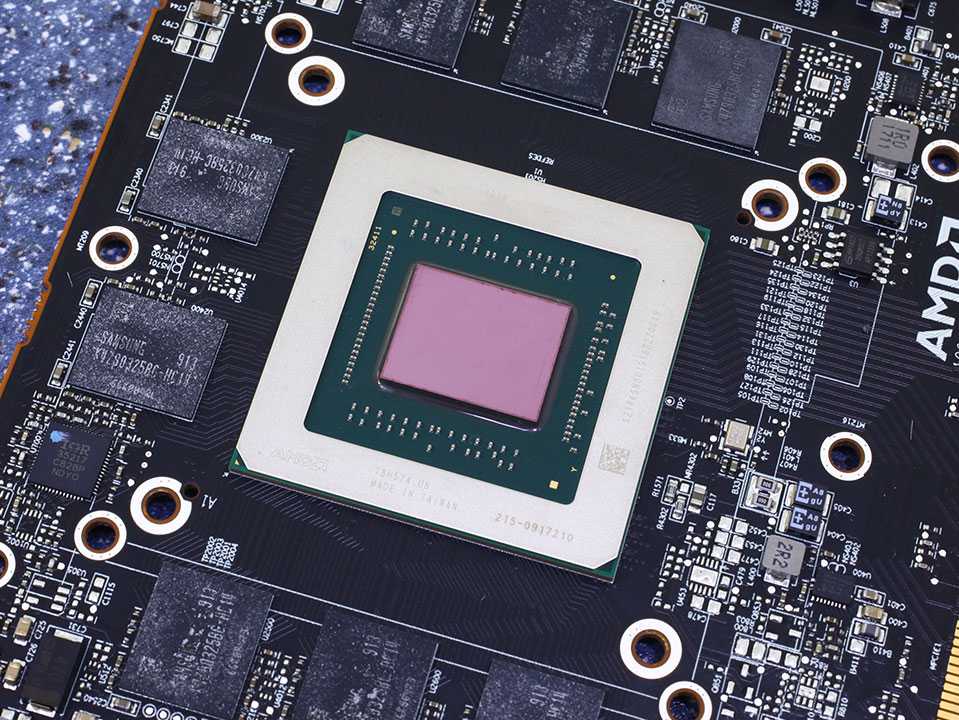

Графический процессор (GPU) — это микросхема или электронная схема, способная отображать графику на электронном устройстве. Графический процессор был представлен на более широком рынке в 1999 году и наиболее известен своим использованием для обеспечения плавной графики, которую потребители ожидают от современных видео и игр.

Графический процессор был представлен на более широком рынке в 1999 году и наиболее известен своим использованием для обеспечения плавной графики, которую потребители ожидают от современных видео и игр.

Ключевые выводы

- Термин «графический процессор» (GPU) относится к микросхеме или электронной схеме, способной воспроизводить графику для отображения на электронном устройстве.

- Термин «GPU» часто используется как синоним «видеокарты», хотя это разные понятия.

- Хотя графические процессоры изначально были популярны среди любителей видеомонтажа и компьютерных игр, быстрый рост криптовалюты создал для них новый рынок. Графические процессоры

- , впервые представленные широкому рынку в 1999 году, пожалуй, наиболее известны тем, что обеспечивают плавную графику, которую потребители ожидают от современных видео и видеоигр.

- В последнее время наблюдается нехватка графических процессоров из-за их применения в майнинге криптовалют.

Принцип работы графического процессора (GPU)

Графика в видео и gs состоит из многоугольных координат, которые преобразуются в растровые изображения — процесс, называемый «рендеринг», — а затем в сигналы, которые отображаются на экране. Это преобразование требует, чтобы графический процессор (GPU) имел большую вычислительную мощность, что также делает GPU полезными в машинном обучении, искусственном интеллекте и других задачах, требующих большого количества сложных и сложных вычислений.

Это преобразование требует, чтобы графический процессор (GPU) имел большую вычислительную мощность, что также делает GPU полезными в машинном обучении, искусственном интеллекте и других задачах, требующих большого количества сложных и сложных вычислений.

История графического процессора (GPU)

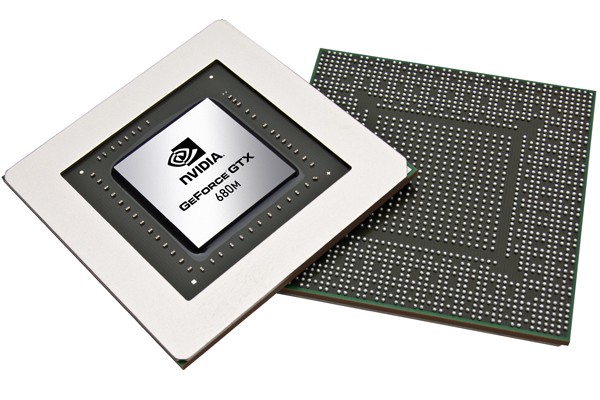

В 1999 году Nvidia представила Geforce 256, первый широко доступный графический процессор. Nvidia определила графический процессор как «однокристальный процессор со встроенными механизмами преобразования, освещения, настройки/отсечения треугольников и рендеринга, способный обрабатывать не менее 10 миллионов полигонов в секунду». GeForce 256 улучшила технологию других процессоров, оптимизировав производительность 3D-игр.

Хотя Nvidia по-прежнему лидирует на рынке графических процессоров, технология значительно улучшилась. В 2000-х Nvidia выпустила свой GeForce 8800 GTX, скорость заполнения текстурами которого достигает колоссальных 36,8 миллиардов в секунду.

Сегодня графические процессоры снова стали популярными. Их использование было распространено на новые отрасли благодаря появлению искусственного интеллекта и криптовалют. Графические процессоры также сыграли роль в расширении доступа к высококачественным играм в виртуальной реальности.

Их использование было распространено на новые отрасли благодаря появлению искусственного интеллекта и криптовалют. Графические процессоры также сыграли роль в расширении доступа к высококачественным играм в виртуальной реальности.

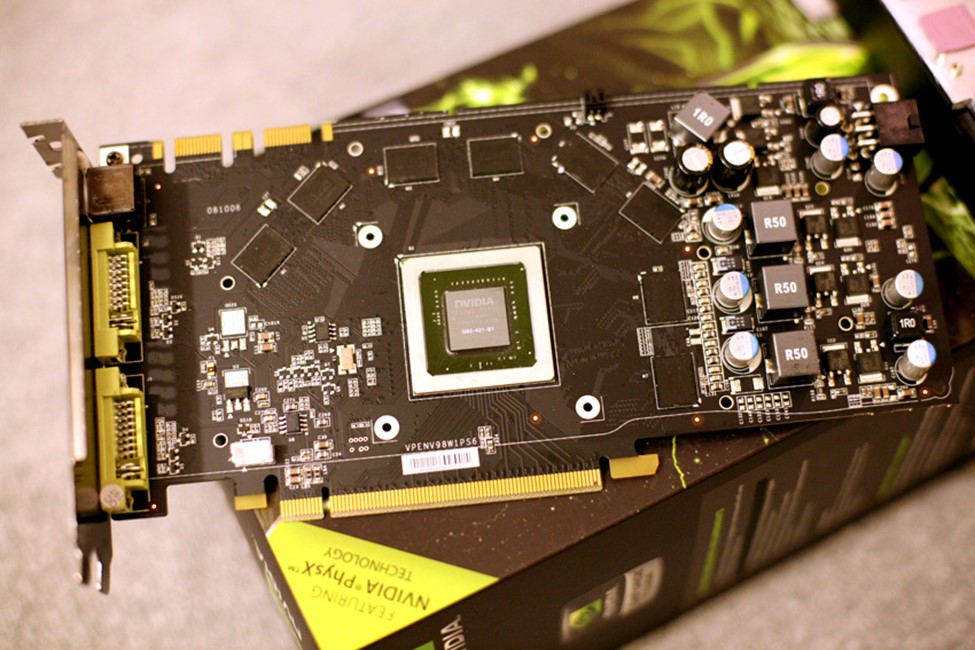

GPU против ЦП

До появления графических процессоров в конце 1990-х за рендеринг графики отвечал центральный процессор (ЦП). При использовании вместе с ЦП графический процессор может повысить производительность компьютера, взяв на себя некоторые ресурсоемкие функции, такие как рендеринг, от ЦП. Это увеличивает скорость обработки приложений, поскольку графический процессор может выполнять множество вычислений одновременно. Этот сдвиг также позволил разработать более совершенное и ресурсоемкое программное обеспечение.

Обработка данных в GPU или CPU осуществляется ядрами. Чем больше ядер у процессора, тем быстрее (и потенциально эффективнее) компьютер может выполнять задачи. Графические процессоры используют тысячи ядер для параллельной обработки задач. Параллельная структура графического процессора отличается от структуры центрального процессора, который использует меньше ядер для последовательной обработки задач. ЦП может выполнять вычисления быстрее, чем ГП, что делает его лучше для выполнения основных задач.

Параллельная структура графического процессора отличается от структуры центрального процессора, который использует меньше ядер для последовательной обработки задач. ЦП может выполнять вычисления быстрее, чем ГП, что делает его лучше для выполнения основных задач.

Особые указания

Термин «GPU» часто используется как синоним «видеокарты», хотя это разные понятия. Графическая карта — это аппаратное обеспечение, содержащее один или несколько графических процессоров, дочернюю плату и другие электронные компоненты, обеспечивающие работу графической карты.

Однако графический процессор может быть встроен в материнскую плату или находится на дочерней плате графической карты. Первоначально компьютеры высокого класса были единственными, оснащенными видеокартами. Сегодня большинство настольных компьютеров обычно используют отдельную графическую карту с графическим процессором для повышения производительности, а не полагаются на графический процессор, встроенный в материнскую плату.

Графические процессоры и майнинг криптовалюты

В то время как графические процессоры изначально были популярны среди энтузиастов видеомонтажа и компьютерных игр, быстрый рост криптовалют создал новый рынок. Это связано с тем, что для майнинга криптовалюты требуются тысячи вычислений для добавления транзакций в блокчейн, что может быть выгодно при наличии доступа к графическому процессору и недорогому источнику электроэнергии.

В последние годы два известных производителя видеокарт, Nvidia Corp. (NVDA) и Advanced Micro Devices Inc. (AMD), добились быстрого роста продаж и доходов в результате майнинга криптовалюты.

Побочным эффектом этого стало разочарование клиентов, не занимающихся добычей полезных ископаемых, которые увидели рост цен и сокращение предложения. В результате розничные продавцы иногда ограничивали количество видеокарт, которые мог купить один человек. В то время как майнеры более популярных криптовалют, таких как биткойн, перешли на использование специализированных и более экономичных наборов микросхем, называемых специализированными интегральными схемами (ASIC), графические процессоры по-прежнему используются для майнинга менее известных валют.

Рост популярности криптовалют вызвал массовую нехватку графических процессоров. В отчете Verge подсчитано, что графические процессоры продаются в два-три раза дороже их розничной цены на таких сайтах, как eBay.

Примеры компаний GPU

Advanced Micro Devices (AMD) и Nvidia (NVDA) — два крупнейших имени на рынке графических процессоров. Давайте посмотрим на обе компании ниже.

Современные микроустройства (AMD)

AMD является одним из самых надежных производителей графических карт. Производитель начинал как стартап в Силиконовой долине в 1969 и разрабатывает продукты для высокопроизводительных вычислений и визуализации. AMD вышла на рынок графических процессоров в 2006 году, когда приобрела ведущего производителя видеокарт ATI. С тех пор AMD и Nvidia стали доминирующими игроками на рынке графических процессоров. По состоянию на май 2021 года рыночная капитализация AMD составляет 97,3 миллиарда долларов. AMD поставила более 500 миллионов графических процессоров с 2013 года и контролирует 17% доли рынка графических процессоров.

AMD уделяет основное внимание на рынке графических процессоров играм для ПК и является фаворитом среди геймеров во всем мире.

Нвидиа (НВДА)

Nvidia была самой первой компанией, представившей в мире графические процессоры в 1999 году. Первый графический процессор в истории был известен как Geforce 256. 1999 был также годом, когда Nvidia провела первичное публичное размещение акций (IPO) по цене 12 долларов за акцию. По состоянию на май 2021 года акции торгуются около 645 долларов за акцию.

Nvidia имеет рыночную капитализацию в 404,8 миллиарда долларов и контролирует 13% доли рынка графических процессоров.

Nvidia имеет значительный охват на рынке передовых графических процессоров. Согласно веб-сайту Nvidia, «восемь из 10 лучших суперкомпьютеров мира теперь используют графические процессоры NVIDIA, сеть InfiniBand или и то, и другое. NVIDIA поддерживает 346 систем из общего числа TOP500 в последнем списке».

Собственный суперкомпьютер Nvidia под названием Selene занимает пятое место в мире и является самым быстрым промышленным суперкомпьютером в мире.

Часто задаваемые вопросы о графическом процессоре (GPU)

В чем разница между GPU и VGA?

В то время как GPU – это микросхема или электронная схема, способная использоваться для рендеринга графики для отображения на электронном устройстве, разъем VGA или видеографического массива – это физическое устройство, используемое для передачи видеосигналов и вывода компьютерного видео.

Как разогнать GPU?

Перед разгоном убедитесь, что вы тщательно очистили свое устройство и установили все обновления и исправления ошибок в своем программном обеспечении. Благодаря обновлениям в технологиях разгон стал довольно простым. Просто установите программное обеспечение, такое как Afterburner, и дайте системе работать. После завершения установки запустите игровой тест, чтобы протестировать новое программное обеспечение.

Что такое масштабирование GPU?

Масштабирование графического процессора — это функция, которая позволяет пользователям настраивать соотношение сторон игры в зависимости от разрешения своего монитора. Некоторые пользователи считают, что регулировка соотношения сторон еще больше улучшит качество изображения на дисплее.

Некоторые пользователи считают, что регулировка соотношения сторон еще больше улучшит качество изображения на дисплее.

404: Страница не найдена

Страница, которую вы пытались открыть по этому адресу, похоже, не существует. Обычно это результат плохой или устаревшей ссылки. Мы приносим свои извинения за доставленные неудобства.

Что я могу сделать сейчас?

Если вы впервые посещаете TechTarget, добро пожаловать! Извините за обстоятельства, при которых мы встречаемся. Вот куда вы можете пойти отсюда:

Поиск

- Узнайте последние новости.

- Наша домашняя страница содержит последнюю информацию о виртуальном рабочем столе.

- Наша страница «О нас» содержит дополнительную информацию о сайте, на котором вы находитесь, SearchVirtualDesktop.

- Если вам нужно, свяжитесь с нами, мы будем рады услышать от вас.

Просмотр по категории

SearchEnterpriseDesktop

-

Как Microsoft Loop повлияет на службу Microsoft 365Хотя Microsoft Loop еще не общедоступен, Microsoft опубликовала подробную информацию о том, как Loop может соединять пользователей и проекты.

..

.. -

В последнем обновлении Windows 11 добавлен проводник с вкладкамиПоследнее обновление Windows 11 предлагает проводник с вкладками для изменения порядка файлов и переключения между папками. ОС тоже…

-

7 шагов, чтобы исправить черный экран в Windows 11Черный экран может быть признаком нескольких проблем с рабочим столом Windows 11. Зная, где искать источник проблемы…

SearchCloudComputing

-

Проверьте себя по основам облачных вычисленийЧтобы понять технологию, лучше всего начать с основ. Пройдите этот краткий тест по облачным вычислениям, чтобы оценить свои знания о …

-

С помощью этого руководства настройте базовый рабочий процесс AWS BatchAWS Batch позволяет разработчикам запускать тысячи пакетов в AWS. Следуйте этому руководству, чтобы настроить этот сервис, создать свой собственный.

..

..