Срок доставки товара в течении 1-3 дней !!!

|

|

Названа самая востребованная видеокарта в России. Самая первая видеокарта в мире

Самые первые устройства в цифровом мире - Блоги

«Прадеды» некоторых компьютерных компонентов и устройств, которые сегодня воспринимаются нами как само собой разумеющееся.

Первый в мире ноутбук

В 1979 году был создан компьютер, который можно назвать прародителем ноутбуков. Устройство, названное GRiD Compass 1101, было разработано инженерами из Кремниевой долины Биллом Могриджем (Bill Moggridge), Гленом Эденсом (Glen Edens), Дейвом Полсеном и бывшим сотрудником Xerox PARC Джоном Эленби (John Ellenby). По ряду причин, в продажу GRiD Compass поступил лишь в апреле 1982 года, и ему пришлось конкурировать со вторым в истории ноутбуком Osborne 1. GRiD Compass (продажная цена 8150$), изначально разработанный как гражданское коммерческое устройство, использовался NASA в космических шаттлах, а также военными.

Несмотря на свой ноутбучный форм-фактор, GRiD Compass 1101 не имел встроенной батареи и работал только от сети.

Некоторые технические характеристики:Процессор: Intel 8086, 8МгцОЗУ: 256 кбПамять: 384 кб энергонезависимой пузырьковой памятиЭкран: 6-дюймовый электролюминесцентный (ELD, предшественник LED) графический с разрешением 320х240 пикселей (невероятная инновация в то время!)Связь: порт RS-232, порт GPIB (General Purpose Interface Bus), встроенный модем 1,2 кбит/секОС: проприетарная GRiD OSМасса: 4,87 кг (мобильные компьютеры того времени весили в 2-3 раза больше!)Корпус: магниевый сплав

Первый в мире накопитель на жёстких дисках

13 сентября 1956 года IBM анонсировала первый в мире накопитель на жёстких дисках: IBM 350. Он являлся составной частью механического компьютера IBM 305 RAMAC. Внешне накопитель (язык не поворачивается называть это «винчестером») представляет собой цилиндрическую тумбу по пояс человека, а общая высота шкафа-корпуса составляла 172 см. Сама тумба являлась шпинделем с массивом из 50 металлических дисков диаметром 610 мм. Каждый диск содержал 100 кластеров по 100 дорожек, скорость вращения составляла 1200 об/мин. Модуль с двумя головками перемещался вверх/вниз вдоль колонны дисков. Ёмкость каждого накопителя составляла колоссальные по тем временам 3,75 мегабайта. Скорость передачи данных достигала 8800 знаков/сек.

Самая первая USB-флешка

Сегодня это настолько же привычный аксессуар, как брелок для ключей. Современные компактные флешки дёшевы, продаются едва ли не на каждом углу, а по ёмкости давно стали обыденностью модели на 64 Гб. Однако начиналось всё 15 декабря 2000 года, когда в продажу поступил самый первый коммерческий USB-накопитель DiskOnKey, он же ThumbDrive, разработанный компанией M-Systems.

Ёмкость первой модели DiskOnKey составляла 8 Мб, что более чем в 5 раз превышало ёмкость 3-дюймовых дискет, бывших в то время стандартными переносными накопителями. Скорость записи данных была примерно в 10 раз выше.

Самая первая цифровая камера

Первый прототип полностью цифровой фотокамеры, в которой поток света, прошедший через оптическую систему, регистрируется массивом из светочувствительных элементов, был изготовлен в декабре 1975 года инженером компании Eastman Kodak Стивом Сэссоном (Steve Sasson).

Камера делала чёрно-белые снимки с разрешением 0,01 Мп. Вес камеры составлял 3,6 кг, в качестве хранилища информации использовалась магнитофонная кассета. Процесс записи оцифрованного снимка на кассету занимал 23 секунды, для просмотра полученного изображения нужно было установить кассету в специальное считывающее устройство, которое выводило NTSC-сигнал на телевизор.

Эта камера была исключительно экспериментальной и не предназначалась для последующей коммерциализации. Первой же полностью цифровой фотокамерой, поступившей в продажу, стала DS-X от Fuji, выпущенная в декабре 1989 года и имевшая разрешение 0,4 Мп.

Эта камера записывала снимки на flash-карту и поставлялась в комплекте с плеером для просмотра изображений. Стоимость комплекта составляла 20 000$.

Первый 5-дюймовый жесткий диск

Seagate произвел свой первый 5-дюймовый жесткий диск в 1980 году. С этого времени компоненты памяти начинают напоминать те, которые мы имеем сейчас, однако есть и нюансы. Скажем, в том же году IBM выпустила первый винчестер емкостью 1 Гб он весил 550 кг.

Самая первая компьютерная мышь

Была представлена 9 декабря 1968 года Дугласом Энгельбартом.

Стоит только отметить, что патент на манипулятор типа «мышь» был получен лишь в 1970 году. В то же время,первый более-менее полноценный компьютер, выпущенный в продажу с таким манипулятором, появился в 1981году. Это был Xerox 8010 SIS. Конечно, мышь уже была заключена не в деревянный брусок, и выглядела более современно.

Первая в мире видеокарта

Такое электронное устройство, как видеокарта берет свое начало с созданного в 1981 году специалистами компании IBM монохромного видеоадаптера (MDA), выполненного в виде отдельной платы и обеспечивавшего разрешение 720 на 350 пикселей. Адаптер MDA не обладал графическими возможностями и предназначался только для обработки текстовой информации (хотя имел несколько режимов ее воспроизведения).

www.playground.ru

История видеокарт. Часть 1 — Игры Mail.Ru

Как рождались и умирали компании и технологии. От S3 Graphics 86C911 до GeForce 3 и Voodoo5

Эта статья опубликована в разделе «Премиум». Что это такое и какие преимущества дает премиум-статус, читайте здесь. Премиальные статьи публикуются не вместо, а в дополнение к бесплатным. Оплатить можно не только деньгами, но и бонусными баллами.

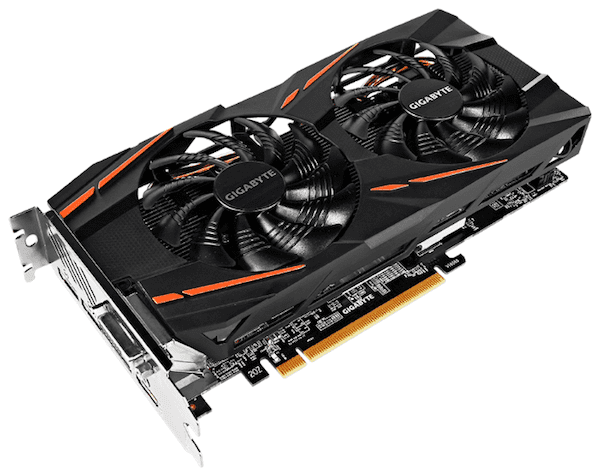

В компьютерном железе сильно развита система наследования: что-то сделали, оно стало популярным и сколько бы устаревшей технология не была, еще много лет она будет аукаться всему миру. Не так давно NVIDIA провела презентацию, на которой впервые показала новое поколение видеоускорителей на базе архитектуры Volta, а в июне или июле выйдет AMD RX Vega — семейство высокопроизводительных видеокарт, которые смогут конкурировать с «зелеными» флагманами.

К чему я это? Да к тому, что как только речь заходит об архитектуре, рассказать об изменениях в ней, не касаясь прошлых продуктов, становится очень сложно. Порой железо несет в себе темное наследие неудачных решений прошлого, а полностью осознавать всю величину изменений (и влияние всяких legacy-костылей) очень тяжело — приходится отматывать время все дальше и дальше. И некоторые вещи в современных видеокартах тянутся аж от истоков трехмерной графики в играх. Так что начнем издалека.

Современный 3D

Если вы посмотрите на видеоролики или геймплей того же Battlefield 1 на максимальной графике — у вас челюсть отвиснет. Потрясающе реалистичные взрывы, сложная анимация лиц, имитация погодных условий, физика, все-все-все — и наше с вами железо показывает эти красоты много раз в секунду. Топовые ПК вываливают на экран почти 500 млн точек за секунду (3840*2160*60 = 497 664 000), а ведь за каждой точкой изображения стоят расчеты, притом непростые.

С чего все начиналось

Не будем уходить во времена совсем дремучие, когда видеоадаптер мог отображать разве что буквы да точки на черно-белом (а затем и цветном) экране. В 1983 году Intel iSBX 275, типичная плата для вывода информации на дисплей, стоила $1000 (в пересчете на 2017-й — $2500) и могла выводить «умопомрачительную» картинку 256х256 точек с 8 цветами или монохромную, но 512х512. Об ускорении 3D-расчетов и речи не шло, тогда проблема была в самом выводе информации.

За точку отсчета можно взять 1989 год — выход на рынок первого 2D-ускорителя S3 Graphics 86C911. 1 Мб видеопамяти, поддержка разрешения 800х600 и 16-битного цвета. Можно сказать, эта железка открыла PC-миру комфортную работу с графикой, а компьютер перестал быть скучным: на таком железе уже можно было более-менее работать с графикой. Началась первая гонка графического железа: очень скоро вышли модели с 24-битным цветом (его мы используем до сих пор), спустя год появились и 32-битные системы с поддержкой альфа-канала (прозрачности).

За рынок 2D-ускорителей сражались S3, ATI, Matrox, Cirrus Logic, Trident и другие компании, а продолжалось это веселье до января 1992 года, когда компания Silicon Graphics Inc. (SGI) выпустила первый в мире открытый API для работы с 2D и 3D графикой — OpenGL 1.0.

Софт решил вопрос железа

Хитрость заключалась в том, что SGI уже имела неплохие проприетарные наработки в этой области, в первую очередь нацеленные на рынок профессионального ПО и UNIX-систем, и на горизонте уже начали появляться конкуренты со своими API. На тот момент идея отвязать обработку графики от остального программного кода была инновационной и, открыв свои спецификации, SGI попросту торпедировала разработку чужих графических библиотек. Большие корпорации не понимали, зачем платить за разработку нового ПО, когда было уже работающее, открытое и не привязанное к вендору: проще было найти подходящее железо.

Уловка сработала, и OpenGL быстро распространился не только на профессиональный софт, но и на игры.

А что было до OpenGL? По-настоящему трехмерных игр, использующих современные технологии, попросту не существовало. Wolfenstein 3D, игра, подарившая миру жанр шутера от первого лица, использовала код на ассемблере/C и упрощенную трассировку лучей, разворачивающую двухмерный лабиринт в псевдо-3D, а все враги и объекты были обычными спрайтами — двухмерными картинками с набором состояний, через которые и реализовывалась анимация.

Подобный подход работал с удивительной для тех времен скоростью и позволял выводить настоящие трехмерные казематы, которые на самом деле не сильно отличались от уровней Pac-Man. Игра легко вычисляла видимые и невидимые (перекрытые другими стенами) поверхности, могла оценить по длине луча расстояние до стены и соответствующим образом исказить отображаемую текстуру, выполняя базовое текстурирование и моделирование мира одном флаконе.

Подобные хитрости использовались во многих играх того времени: других вариантов адекватно отобразить достаточно сложные 3D-объекты просто не было. Написание платформозависимого, но быстрого кода, использование двухмерных элементов везде, где возможно и всяческие уловки позволяли добиться динамичного геймплея и неплохой картинки, не прибегая к аппаратному ускорению. И продолжалось это аж до самого 1996 года.

Первые спецэффекты

Достаточно простой в визуальном плане Wolfenstein 3D уже содержал первые наметки на применение спецэффектов.

Конечно, они были реализованы грубо, в виде перемещающихся по экрану двухмерных спрайтов: свет от каждой люстры был всего-навсего текстурой на полу. Куда интереснее было смотреть на первый DOOM, вышедший в 1993. Он оставался все таким же псевдотрехмерным: в игре были лифты, ступени, подъемы и спуски, в том числе интерактивные, но на самом деле уровень был плоский, и вы не найдете ни одного места в игре, где одна комната располагалась бы над другой. Куда важнее была проработка артов и первые зачатки динамического освещения. Выстрелы освещали вспышками окружающее пространство. В зависимости от окружения и уровня менялась тональность тех или иных объектов.

Еще дальше эффекты освещения ушли в DOOM 2 (1994): там вы могли встретить по-настоящему темные комнаты, которые менялись при открытии двери в освещенное пространство и на мгновение подсвечивались при выстрелах. В остальном же даже продвинутый 2.5D-движок Duke Nukem 3D в 1996 году использовал примерно те же спецэффекты: спрайтовые арты там, где они выглядели лучше, простенькие 3D-модели в мире, базовое освещение и затенение. Вместе с тем в Duke Nukem была куда более продвинутая схему отрисовки уровней, что позволило разработчикам создать вагонетки, лифты, разрушаемые стены и другие новшества, которые были невозможны в играх id Software того времени.

К будущему наперегонки

Представьте себе рынок консолей лет десять назад: есть Nintendo с ее странными штуками, сравнительно свежие PS3 и Xbox 360, уходящие на покой PS2 и первый Xbox. А еще PC со старыми карточками на DirectX 9 и новым поколением железа с поддержкой DirectX 10. У всех разная архитектура, вычислительные возможности, инструменты разработки. В 90-е весь этот бардак творился на одном только рынке 3D-ускорителей и их API, которые требовалось учитывать при разработке игр и софта!

У S3 был S3d, SGL использовала PowerVR (живая и поныне, кстати, но в мобильниках), NVIDIA — собственную nvlib, ATI — C interface и так далее. Да, отдельные реализации (или их элементы) были хороши и имели уникальные фичи, которых не было у конкурентов. Аппаратный антиалиасинг (сглаживание), поддержка высоких разрешений и полноцветной картинки у всех были реализованы по-своему, что выливалось в соответствующие проблемы для разработки софта.

При таком-то зоопарке конкурирующих технологий ни о каком активном развитии индустрии и речи идти не могло. С одной стороны, агрессивная конкуренция и борьба за рынок, с другой — давление открытых технологий в лице OpenGL и потихоньку растущего детища Microsoft. Неудивительно, что проприетарные и завязанные на конкретную железку варианты начали потихоньку умирать, а их создатели — уступать интеллектуальные права на разработку своим конкурентам.

OpenGL и DirectX

Войну OpenGL негласно объявила компания Microsoft, не в последнюю очередь этому способствовал выход Windows 95.

Вот суть проблемы вкратце. DOS позволяла общаться с железом напрямую, что, учитывая мощности железа тех времен было удобно для разработчиков игр. Неудобство доставляли вышеописанные зоопарки из железа и софта. В Windows 95 общение с железом прибрала к рукам система: да, интерфейс и удобство решали, но производительность графических операций сильно упала, а терять рынок игр (плавно переползавших с 16-битных консолей на ПК) не хотелось. Так родился DirectX. Простенький, несуразный, во многом отстающий в развитии от других API, но зато свой и родной.

А на OpenGL редмондцы, что называется забили и особо не парились над ее внедрением в Windows: основной идеей было переманивание пользователей профессиональных САПР, необходимый минимум для работы софта реализовали, а остальное Microsoft не волновало. Масла в огонь подлил отказ в лицензировании мини-драйвера OpenGL для Windows 95. SGI, создатель OpenGL, отчаиваться не стала и выпустила полный драйвер, который позволял не только производить растеризацию, но и работать с базовыми 3D-функциями: трансформацией и освещением, чего у DirectX не было.

Спустя несколько месяцев случился фэйл: вышли первые видеокарты с аппаратной реализацией некоторых трехмерных функций, которые с самого начала были заложены в OpenGL 1.0 — а DirectX умел только 2D-ускорение. Такое положение дел не устраивало создателей Windows, и те быстро нашли финансовые ресурсы и подходящую для покупки компанию. Ей оказалась RenderMorphics, а программный продукт Reality Labs API стал ядром для Direct3D. Кое-какие наработки были включены из совместного с 3Dfx проекта Talisman, который применялся в Glide API и DirectX для вывода текстур по частям. Все вместе это худо-бедно, но работало: производительность 3D в играх под Windows вплотную приблизилась к написанию нативного кода, который использовался в DOS.

Проблем у DirectX хватало: отставание от OpenGL по части фич вылилось в спешку при разработке и интеграции, в результате разработчикам игр пришлось терпеть отвратительные инструменты для разработки, нечитабельный код и всякого рода глюки.

OpenGL изначально имел преимущество: рабочие станции и куча софта отлично работали с имеющимися технологиями, да и некоторые разработчики успешно применяли новую библиотеку для отрисовки. id Software и Джон Кармак встали на сторону OpenGL: Direct3D был назван «несуразным мусором», все игры от id выходили с поддержкой открытых технологий.

Первые ласточки современного 3D

Первая видеокарта в современной интерпретации была выпущена компанией ATI на рубеже 1994-1995-х и называлась Mach64. Она соединяла в себе устройство вывода картинки на дисплей и аппаратный декодер видеосигнала. В зависимости от версии видеокарта имела 2 или 4 Мб памяти. Оценивать ее с точки зрения сегодняшних спецификаций сложно: у нее не было шейдерных процессоров (поскольку самого понятия шейдеров еще не было), а многие аппаратно-ускоренные операции заключались в быстрых преобразованиях над двумя участками памяти. Но и этого было достаточно: Windows 3.1 и Windows 95 на ней буквально летали.

В ответ выстрелили сразу несколько продуктов конкурентов. GLINT 300SX от 3DLabs поддерживала OpenGL-рендеринг, имела 1 Мб видеопамяти для операций над вершинами и текстурами и еще 1 Мб в качестве кадрового буфера: в него попадали уже отрисованные части изображения. S3 выпустила OEM-чипы Trio64 и Trio32 с набором уникальных возможностей, но главной архитектурной особенностью была объединенная память, распределением которой можно было управлять из приложения. В мае 1995 года вышла первая видеокарта от NVIDIA — NV1. NVIDIA с самого начала ориентировалась на возможности OpenGL, поэтому их карточка была одной из передовых: поддерживала мультитекстурирование (которое, правда, не поддерживалось DirectX, да и многими другими видеокартами тоже, поэтому почти нигде не применялось), работала на запредельных для того времени скоростях и вообще была крутой… Если бы не одно «но».

При создании NV1 разработчики ориентировались на трансформирование квадратных текстурных кусочков, собирая из них трехмерную модель. Это решение понятнее для человека, который пишет игровой движок: мы привыкли оперировать с прямоугольниками, нам так проще, и разработчики ориентировались на эту особенность восприятия. Проблемы начинаются, когда ваш условный прямоугольник начинает изгибаться не по одной оси, превращаясь в трапецию для стороннего наблюдателя, а сразу по двум. Он делится на две базовые фигуры: треугольники, которые могут быть наклонены друг относительно друга.

На рендеринг таких примитивов и был ориентирован Direct3D от Microsoft, а NVIDIA попросту не поддерживала такой режим. Так NV1 стала лучшей карточкой на рынке для никого: потрясающие железные возможности попросту не использовались софтом, а обертка над Direct3D, написанная чуть позже NVIDIA, работала не так хорошо, как нативные решения от конкурентов. В итоге на NV1 можно было играть только в порты игр с Sega Saturn через специальную плату-переходник.

К концу 1995 года ATI выпустила Mach64 GT с чипом 3D RAGE. Она также не полностью реализовывала функциональность Direct3D и имела некоторые проблемы с драйверами под Windows 95, но общее качество работы было лучше, чем у враппера NVIDIA, к тому же Mach64 GT умела воспроизводить видео MPEG-1. Спустя девять месяцев появилась Rage II, исправляющая все косяки предшественника и поддерживающая MPEG-2: игры на ней работали неплохо, но 2 Мб видеопамяти на тот момент было уже недостаточно.

Вслед за Rage II на рынок вышло еще несколько продуктов, и одной из самых интересных карт была Rendition Vérité V1000.

Для 1995 года она действительно была прорывной: RISC-процессор, использовавшийся в качестве универсального GPU, работал над 3D-операциями и выдавал команды для блока растеризации, который умел и 3D рендерить, и 2D ускорять. Именно на базе возможностей V1000 тестировалась работа Direct3D и DirectX 5.0 в самой Microsoft. Существовали и другие интересные карточки, но все они меркнут по сравнению со взошедшей звездой PC-гейминга. Гонка производительности закончилась, едва успев начаться: видеокарта Voodoo от 3Dfx при всем своем несовершенстве стала настоящим проклятием для S3, NVIDIA и ATI.

Прорыв в графике: применение OpenGL в играх

Quake от id Software стал одной из первых полноценных трехмерных игр, в которых не только мир имел три измерения, а все остальное было представлено спрайтами. И уж точно Quake был первым полностью трехмерным шутером с видом от первого лица. Вы могли играть как с софтверным рендерингом, который был визуально четче (хотя по текущим меркам и выглядит как хоррор-ретекстур Minecraft), либо использовать OpenGL, если ваша видеокарта позволяла такую роскошь: фильтрация текстур и улучшенные спецэффекты были к вашим услугам.

Первые наметки динамического освещения, покадрово анимированные 3D-модели (именно поэтому Quake и Quake 2 кажутся такими дерганными), использование аппаратного ускорения… В общем, прорыв по всем фронтам. Больше спецэффектов можно было увидеть разве что в Need for Speed 2 и Need for Speed 3, вышедших через год и два спустя: там добавились первые отражения на кузовах автомобилей и имитация работающих фар в ночных гонках.

Магия Voodoo

Технически 3Dfx Voodoo был именно 3D-ускорителем, а не видеокартой: выводить изображение на дисплей не умел, требовал отдельный видеоадаптер. Но это не помешало перевернуть рынок буквально за один год.

Представьте: до 1996 около 50% на рынке занимали видеоускорители S3, а спустя год почти в 80% новых компьютеров стояла графика от 3Dfx. В чем секрет столь ошеломительного успеха? 3Dfx Voodoo один из первых реализовал современный подход к отрисовке кадра, который применяется до сих пор и называется «отсроченный рендеринг».

Как вы уже знаете, для бесперебойной и быстрой работы в современных видеокартах используется уйма технологий-обманок, которые всеми силами стараются выдавить из себя результат, близкий к физически правильному, задействуя минимум ресурсов: честные расчеты слишком дороги.

А самая большая экономия ресурсов достигается, когда ничего не делаешь, и для вычислительной техники середины 90-х это было как нельзя кстати. Компания VideoLogic изобрела такой процесс отрисовки, который устранял необходимость в огромном Z-буфере для определения видимости того или иного пикселя. Все, что было скрыто от глаз наблюдателя, отсекалось на этапе построения геометрии, и текстуры наносились только на полученную усеченную картинку, а не на весь кадр даже там, где пользователь ничего не увидит. Voodoo работала именно по такой схеме, и это маленькое улучшение позволило разбить всех конкурентов в пух и прах: в 3D-операциях еще целый год никто не мог ничего противопоставить магии Voodoo. Динамичные игры воспроизводились так круто, как никогда раньше:

Собственный софт

Единственным живым конкурентом для OpenGL и DirectX стал фирменный Glide API от 3Dfx, который позволял переложить многие операции на фирменный ускоритель. Во многом он был похож на OpenGL, от которого и произошел, но содержал крайне ограниченный набор инструментов: размещение треугольников, заполнение их текстурами, отрисовка готового кадра. Этот минимум, в отличие от многообразия функций «больших библиотек» удалось реализовать аппаратно, и игры с поддержкой Glide щеголяли сглаженными текстурами, новыми на тот момент спецэффектами, связанными с динамическим освещением некоторых объектов и стабильно высоким FPS.

Вот так ограничения, разумная простота и возможность ее реализации в железе сделали Voodoo доминирующей 3D-картой на рынке. По большому счету, именно монструозность библиотеки OpenGL с ее сотнями различных вызовов API (половину из которых использовали раз в сто лет), а также медлительность консорциума-разработчика привели к доминированию Glide и DirectX на PC-платформе.

Ответы от ATI и NVIDIA

Конкуренты старались поспевать за дерзким новичком и в чем-то даже преуспели, но каждая видеокарта не-Voodoo была в то время экзотикой, так как все знали: хочешь крутые игры на PC — бери «Вуду», а если финансы позволяют — второй «Пентиум» к ней.

Да, топовая ATI 3D Rage была мощнее, чем Voodoo в 3D-режиме, так как использовала новую на тот момент шину AGP с двумя линиями и имела на борту 8 Мб видеопамяти, умела применять сглаживание к граням, аппаратно фильтровать текстуры, встроенный сопроцессор для операций с плавающей точкой и даже имела встроенный видеодекодер MPEG2 для DVD. За эту сумму качеств ее нежно любили профессионалы, и OEM-продажи для сборщиков рабочих станций стали спасением ATI.

Правда, это требовало современную материнскую плату, и не каждый мог позволить себе такой апгрейд. К тому же куда более дешевая версия со старым интерфейсом PCI и 2/4 Мб видеопамяти, увы, не дотягивала до конкурента, и народ все также брал Voodoo для игр.

«Зеленые» не стали повторять своих ошибок с Microsoft и тщательно ознакомились со спецификациями Direct3D. Новая видеокарта от NVIDIA называлась Real-time IntercATIve Video and AnimATIon Accelerator или попросту RIVA, а для красоты добавили цифру 128 (у ATI было 64!). Она умела работать с треугольными полигонами и понимала Direct3D «из коробки» (хотя NVIDIA и были приверженцами OpenGL в то время). Тесное сотрудничество с Texas Instruments позволило создать чипы на базе передового 350-нм техпроцесса, да еще и отбраковывать неудачные экземпляры перед установкой на плату. К концу 1997 года RIVA 128 и ее производные позволили NVIDIA занять около 20% рынка и натурально спасли компанию, которую некоторые расценивали как готовую к поглощению более успешными игроками.

Voodoo2 и Scan-Line Interleaving

Выход второго поколения успешного 3D-ускорителя не заставил себя ждать. Несмотря на некоторые недостатки (низкое рабочее разрешение плюс дизеринг 16-битного цвета в трехмерном режиме) и унаследованные от первой Voodoo архитектурные особенности (вторая версия по-прежнему не была видеокартой в полной мере) железку ожидал коммерческий успех. Отдел маркетинга 3Dfx сумел обратить почти все недостатки в достоинства. Связка из Voodoo2 и сравнительно недорогого, но качественного 2D легко уделывала интегрированные одноплатные решения конкурентов, которые работали хуже либо в одном из режимов, либо сразу в обоих.

Видели монструозные сборки с водянкой, 2-3-4 видеокартами, подсветкой и всем таким? Выглядит красиво, стоит безумно дорого. А началось все это в далеком 1998-м, когда 3Dfx представила технологию SLI (Scan-Line Interleaving, чередование строк). Два 3D-ускорителя Voodoo2 (одинаковых или специальный комплект из материнской плюс дочерней плат, соединенных внутренним шлейфом) работали как единое целое, рисуя четные/нечетные строки изображения и соединяя их в одну большую картинку перед выводом на монитор. К сожалению, о внутренней красоте ПК тогда мало заботились, и красивых фото из прошлого не будет: бутерброд из 3D-ускорителей и видеоплаты выглядел примерно так:

Подобная связка натурально удваивала производительность в трехмерном режиме (не то что современные AMD Crossfire или SLI от NVIDIA) и позволяла достичь более высоких разрешений. Обычные Voodoo поддерживали картинку 800х600 с 16-битным цветом, пара таких карт уже могла работать с 1024х768. Стоила такая сборка от $1900 до $2500. Еще ~$1500 пришлось бы выложить за остальное компьютерное железо.

Для сравнения: в 1998-м ~$1000 долларов стоила Nokia 8110 (та самая, из «Матрицы»), за $2500 можно было взять вполне живую «Волгу» или дачный домик с участком в ~100-120 км от Санкт-Петербурга, а за $4000 стать крутым владельцем пусть и б/у, но иномарки:

Минусом SLI стал первый в истории CPU Bottleneck: процессор попросту не успевал загружать видеокарты работой, так что связки из Voodoo2 в SLI некоторые использовали по 5 лет, меняя остальное оборудование.

Скелетная анимация

Игры получали более высокое разрешение текстур, улучшенные спецэффекты взрывов и освещения, более сложные, наполненные деталями модели — в общем, все сводилось к количественному росту разрешения и детализации (но не качественному). И многое было суждено изменить одной игре. Half-Life в 1998 году поражал вниманием к деталям, новаторским геймплеем, кат-сценами на движке игры и неотрывным повествованием с видом от первого лица.

Главное, что там было с точки зрения графики — скелетная анимация. Внутри каждой модели был своеобразный скелет из костей, и группы полигонов на руках, ногах, туловище и так далее были привязаны к костям. Больше не требовалось создавать отдельные виды моделей для каждого из состояний, можно было анимировать основу, а полигоны сами следовали за ней. Именно поэтому первая «Халфа» выглядела так свежо и необычно: движения персонажей и их поведение были «как в кино». По крайней мере, для того времени.

Sony PlayStation

Не удивляйтесь, что мы вспомнили первую «Плойку» только к 1997-1998 годам. Да, она вышла еще в конце 1994-го, но реально популярной стала к 1997 году, с выходом Gran Turismo и Final Fantasy VII.

Обе показывали неплохую для того времени графику, и именно на этих играх разработчики полностью научились задействовать возможности железа PS1, а ведь оно было весьма скромным: 33 МГц процессор в паре с 2 Мб оперативной памяти и 66 МГц видеоконтроллер с 1 Мб видеопамяти, который мог обрабатывать до 180 тыс. полигонов в секунду.

С точки зрения той же Voodoo железо было полным шлаком, но у разработчиков были инструменты с прямым доступом к процессору, памяти и видеоядру, а, значит, движок игры мог использовать все доступные ресурсы, ведь прослойки в лице операционной системы у консоли не было.

Первые три-четыре года жизни консоли графика и производительность игр были ограничены не аппаратными возможностями, а мастерством и опытом разработчиков: то же отсечение невидимых полигонов, которое обеспечило Voodoo прорывную производительность, здесь закладывалось на этапе создания игрового движка, а не в само железо. Да, создавать игры было сложнее, чем на ПК, но и железо продержалось десять лет: последняя игра на PS1 (FIFA 2005) вышла в конце 2004 года, хоть и с упрощенной графикой. В конце концов решал геймплей, а не нажористый графон.

Закат эпохи 3Dfx

«А где 3Dfx сейчас, если она была так успешна?» — спросите вы. Поглощена компанией NVIDIA. Одна стратегическая ошибка или, скорее, неудача, пара-тройка тактических просчетов — и лидер индустрии достается своему более успешному конкуренту.

С выходом Voodoo3 компания 3Dfx решила, что она перестанет кормить ОЕМ-производителей, как делала раньше, и будет заниматься разработкой, созданием и продажей видеокарт сама. Для этого был приобретен производитель железа STB Systems, чьи заводы находились в Мексике. Конкурировать по качеству и ценам с азиатскими производителями-партнерами NVIDIA (которая все также OEM’ила и не стеснялась этого) не вышло по ряду причин. И дело даже не в банальной стоимости производства.

NVIDIA выиграла эту войну за счет ушлых маркетологов, грамотного планирования и… бюджетных карточек. Да, флагманский Voodoo3 было тяжело побить в играх, но его производитель абсолютно честно указывал на коробке характеристики работы видеокарты — 16-битный цвет в трехмерном режиме, максимальное разрешение дисплея 2048х1536, максимальный размер текстур 256х256 точек. У стоявшей рядом на полке RIVA TNT2 имелась поддержка текстур 2048х2048 и 32-битный режим работы в 3D. И покупатели повелись на цифры: им было плевать, что Voodoo работает быстрее, а игры, способные использовать преимущества RIVA TNT2 можно было пересчитать по пальцам одной руки.

У 3Dfx попросту нечем было заткнуть средний сегмент! Архитектура чипов Voodoo изначально выстрелила за счет двух блоков текстурирования: видеокарта работала быстрее конкурентов в примитивных операциях, а API Glide, нежно любимый некоторыми разработчиками динамичных игр, позволял творить настоящие чудеса. Это была не консольная производительность в вычислениях и близость к железу, но что-то около того. Удешевленные Voodoo2 в первую очередь лишались второго блока текстурирования, что выглядело так себе на бумаге и еще хуже в игровой производительности, при этом себестоимость производства падала не так уж и сильно. В результате карточка была плоха по балансу производительности и цены, не пользовалась спросом и бросала тень на свою старшую сестру. В Voodoo3 обрезать карту не стали, разные версии отличались в первую очередь тактовыми частотами и объемами памяти.

Если флагман мог потягаться с продуктами конкурентов, то его ослабленные варианты были не так хороши, а финальным аккордом, добившим менеджмент компании (да и кучу других конкурентов) стал внезапный выход GeForce 256, первой настоящей и полноценной видеокарты во второй половине 1999-го.

Последний из могикан

Еще одной видеокартой, способствовавшей свержению 3Dfx с вершин игровой графики стала Matrox G400. Несмотря на то что это была не последняя карточка от Matrox и сама компания продержалась на рынке видеоускорителей аж до 2003 года, именно G400 была последней успешной картой. И на то был ряд причин, как архитектурных, так и финансовых.

Во-первых, это видеокарта была пионером поддержки полноценного бамп-маппинга: он добавлял текстурам объема и рельефа практически бесплатно для производительности. Во-вторых, G400 мог работать с двумя мониторами, как с одним большим, что ценилось некоторыми игроками и профессионалами. В-третьих, Matrox ревностно относились к качеству аналогового тракта и ЦАП’ов, и G400 долгое время (вплоть до выхода GeForce 4) был эталоном по части четкости и скорости отображения информации. Не обошлось и без минусов: платы первого поколения не поддерживали в полной мере AGP x4, работая только с двумя линиями передачи данных. Кроме того, производительность драйверов в OpenGL режиме из-за политики Microsoft была ужасной: по сути, все OpenGL вызовы на лету оборачивались в функции Direct3D, что не лучшим образом отражалось на скорости работы. Полноценный OpenGL-драйвер вышел только через год после начала продаж.

Тем не менее вплоть до выхода GeForce 256 производительность карточки в 2D и Direct3D режимах была на уровне топовых решений конкурентов: Matrox G400 успешно противостоял 3Dfx Voodoo3, NVIDIA RIVA TNT2 Ultra и ATI RAGE 128 Pro. Каждая из видеокарт была в чем-то лучше остальных, из-за чего 1999 год был достаточно напряженным для потребителей, ведь выбирать было из чего. Первая показывала лучшие результаты в тех играх, которые поддерживали низкоуровневый API Glide, вторая была признанной королевой OpenGL, а Rage 128 Pro хоть и был не так быстр, но и стоил меньше и уверенно прописался в среднем сегменте.

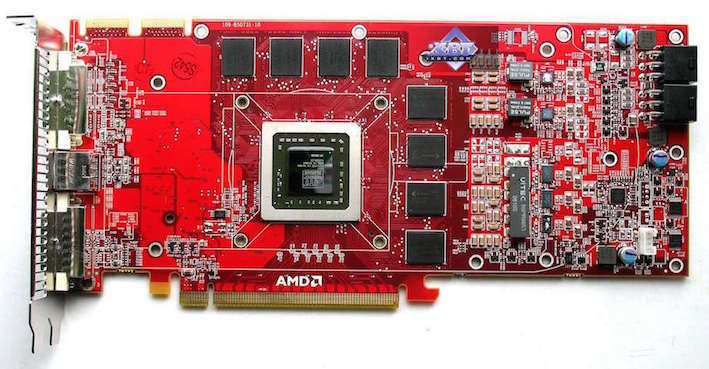

Настоящий GPU

GeForce 256 можно считать одним из родителей концепции видеокарт, продержавшейся следующие пять-шесть лет, аж до конца эпохи железа DirectX 9.0c и начала DirectX 10. Это была первая видеокарта, полностью обеспечивающая ваш компьютер всем необходимым для работы с графикой. Она имела полностью аппаратный блок T&L (трансформации и освещения), на 90% снимающий с CPU нагрузку по расчету геометрии. Видеоролик с презентацией возможностей GeForce 256 захватывал дух в свое время:

С виду ничего сложного? Дело в том, что до GeForce 256 геометрией занимался центральный процессор, и эта трава отбирала все ресурсы CPU. Сама же видеокарта использовала интегрированную структуру: 2D и 3D операции выполнял один чип, впервые использовалась память типа DDR, которая была распаяна непосредственно на плате и обеспечивала быстрый доступ к необходимым ресурсам. Поддержка мультитекстурирования и пиксельных конвейеров давала высокую производительность и потрясающие спецэффекты.

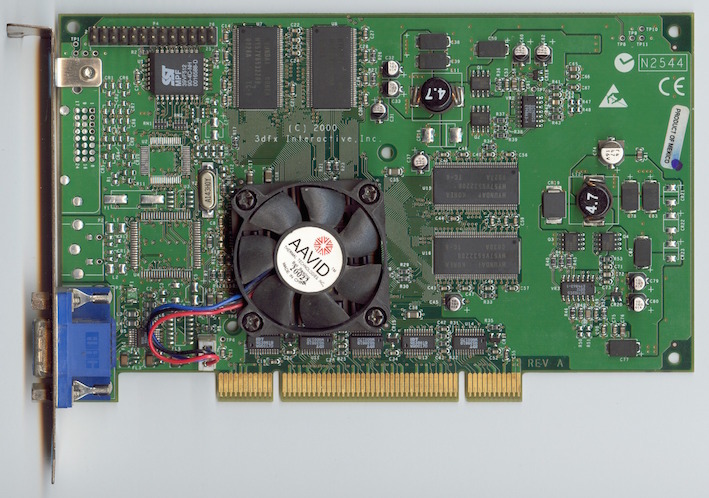

Ответить 3Dfx было нечем: денег на столь быструю и качественную разработку параллельно с внедрением продуктов в производство не хватало, бюджетный сектор поделили ATI и NVIDIA, вытеснив почти всех конкурентов, а топовые карточки значительно уступали в производительности флагманам «красных» и «зеленых». Voodoo4 и Voodoo5 не смогли спасти компанию: на рынок они попали слишком поздно, проигрывали конкурентам в производительности, цены из-за политики «сами производим, сами продаем» были высоки, чипы довольно часто выходили из строя, а разработать что-нибудь уровня первой Voodoo в 3Dfx не успели, хотя работы в этом направлении и велись.

Была запущена процедура банкротства, все активы и большая часть кадров (работавших над новым поколением GPU, который так и не увидел свет) досталась NVIDIA, а разработчики, ответственные за создание технологии SLI и сопутствующей обвязки, ушли в ATI.

Архитектура следующего десятилетия

Из всех разработчиков видеооборудования к 2001 году в живых остались S3 (правда, уже в составе VIA), 3Dlabs и Matrox, ушедшие в производство специфического железа для рабочих станций, а также NVIDIA, ATI и SiS, занимавшихся десктопной графикой. Остальные компании если и присутствовали на рынке, то либо лицензировали чужие разработки, либо довольствовались low-end-сегментом и рабочими станциями на экзотических ОС.

Выход GeForce 3 окончательно определил общий дизайн GPU: геометрический T&L процессор с собственным кэшем, блок текстурирования, шейдерный блок, блок растеризации, кадровый буфер и сравнительно большой объем внутренней памяти для хранения и обработки моделей и текстур. Но обо всем этом в следующей серии.

games.mail.ru

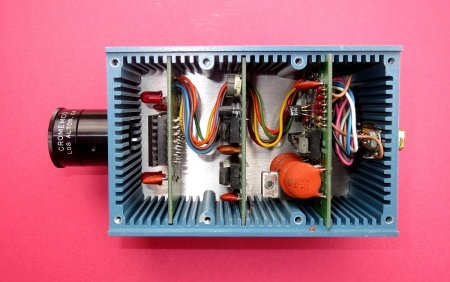

Cromemco Dazzler - первая в мире "цветная" видеокарта

Современную картинку на экране монитора невозможно представить в черно-белом. Цвета – вот что делает нашу жизнь ярче, придает ей смысл. Чем больше красок, тем лучше восприятие. Но в далёких 1970-х годах, компьютерные инженеры только улыбались при ответе на вопрос «А когда уже он будет цветным?».Что же позволяет отображать на наших с вами мониторах цветные графические объекты? Видеокарта, или как её еще называют «графический адаптер». Она может быть как в виде отдельного чипа, так и интегрированной (встроенной) в системную плату вашего ПК.

Рынок компьютерной техники огромен, и это можно сказать без преувеличения. Производителей видеокарт большое количество, но основными же принято считать (согласно статистическим данным по объемам продаж) всего три: nVidia, Intel, AMD. Совокупная чистая прибыль этих трёх компаний около 2 млрд. американских долларов в год. Серьезная цифра, не правда ли?

Но кем же являются главные персонажи в этой «цветовой игре»? Кому удалось создать первую в мире «цветную» видеокарту? Все началось в далеком 1975 году, когда Роджеру Мелену в руки попал свежий выпуск журнала Popular Electronics. На страницах этого печатного издания студент из Стэнфордского университета увидел рекламу микропроцессора Альтаир 8800, разработанного компанией MITS. После не длительных размышлений Роджер позвонил по указанному на странице номеру телефона и совершил заказ этого персонального компьютера. Кстати, цена на Альтаир 8800 составляла всего 397 долларов, что по меркам 1970-х годов считалось сущим пустяком (как для компьютера).В одном из интервью Мелен сообщил, что совершал покупку микропроцессора не для себя, а для своего друга Гарри Гарланда. Но разработкой дополнений для «машины» парни занимались вдвоем. Начали они с видео-дигайзера «Циклоп» (устройство для ввода графической информации), который конструктивно был схожим с современными видеокамерами.

Все началось в далеком 1975 году, когда Роджеру Мелену в руки попал свежий выпуск журнала Popular Electronics. На страницах этого печатного издания студент из Стэнфордского университета увидел рекламу микропроцессора Альтаир 8800, разработанного компанией MITS. После не длительных размышлений Роджер позвонил по указанному на странице номеру телефона и совершил заказ этого персонального компьютера. Кстати, цена на Альтаир 8800 составляла всего 397 долларов, что по меркам 1970-х годов считалось сущим пустяком (как для компьютера).В одном из интервью Мелен сообщил, что совершал покупку микропроцессора не для себя, а для своего друга Гарри Гарланда. Но разработкой дополнений для «машины» парни занимались вдвоем. Начали они с видео-дигайзера «Циклоп» (устройство для ввода графической информации), который конструктивно был схожим с современными видеокамерами.  Затем последовала кропотливая работа над созданием прототипа Cromemco Dazzler – первая в мире «цветная» видеокарта. Изначально она использовалась только для микрокомпьютера S-100 bus.

Затем последовала кропотливая работа над созданием прототипа Cromemco Dazzler – первая в мире «цветная» видеокарта. Изначально она использовалась только для микрокомпьютера S-100 bus. Успех был ошеломляющим. Спрос на созданную ими видеокарту рос с неимоверной скоростью. Но на этом Роджер и Гарри не остановились. В 1979 году они завершили усовершенствование своей графической карты. Модификация получила название Super Dazzler. Более производительная, нежели её предшественница. Super Dazzler имела возможность отображать до 4096 цветов, чем заинтересовала телевизионщиков и военных США, которые активно покупали и внедряли новинку. Также у Роджера и Гарри появились заказы из КНР.

Успех был ошеломляющим. Спрос на созданную ими видеокарту рос с неимоверной скоростью. Но на этом Роджер и Гарри не остановились. В 1979 году они завершили усовершенствование своей графической карты. Модификация получила название Super Dazzler. Более производительная, нежели её предшественница. Super Dazzler имела возможность отображать до 4096 цветов, чем заинтересовала телевизионщиков и военных США, которые активно покупали и внедряли новинку. Также у Роджера и Гарри появились заказы из КНР.Парни из стэнфордского университета зарегистрировали свою компанию, которая называлась Cromemco. Роджер и Гарри были равноправными её владельцами до 1986 года. За 1983 году Cromemco удалось достигнуть прибыли в размере 55 миллионов долларов, а штаб насчитывал 500 сотрудников. После таких финансовых показателей Компанией заинтересовали крупных участников рынка ИТ-технологий, а в период с 1985 по 1986 годов все активы Cromemco перешли к Dynatech Corporation (сумма сделки не разглашается).

Тот вклад, который сделали Роджер Мелен и Гарри Гарланд несопоставим ни с чем, а их творение навсегда останется в истории компьютерной техники.

vgtk.ru

Развитие видеокарт в 2000-х годах

Продолжая историю развития видеокарт из предыдущей — статьи, видеоадаптеры 2000-х годов.

VSA-100 и новое поколение Voodoo

Чипсет VSA-100 (Voodoo Scalable Architecture — масштабируемая архитектура Voodoo) был выпущен компанией 3dfx в июне 2000 года. Первой видеокартой, использовавшей данный чип (VSA-100х2) стала Voodoo5 5500. Изготовленная по 250-нм техпроцессу, с 14 миллионами транзисторов. Объем памяти SDRAM доходил до 64 Мб, с 128-битной шиной. Частота графического процессора и памяти составляла 166 МГц. Впервые в видеокартах Voodoo поддерживался 32-битный цвет в 3D, а также текстуры с высоким разрешением 2048x2048 точек. Для сжатия применялись алгоритмы FXT1 и DXTC. Особенностью Voodoo5 5500 была высокая производительность при использовании сглаживания.

Видеокарта выпускалась с разными интерфейсами, такими, как AGP, PCI и т.д. Также была доступна версия под Macintosh, имеющая два разъема (DVI и VGA).

Осенью того же года 3dfx выпустила Voodoo4 4500 с объемом памяти 32 Мб, использовавшей один чип VSA-100. Модель оказалась довольно медленной и значительно уступала GeForce 2 MX и Radeon SDR.

Компания 3Dfx анонсировала выход производительной видеокарты Voodoo5 6000 на 4-х чипах VSA-100 и с 128 Мб памяти. Но окончательно реализовать проект так и не удалось — серьезные финансовые трудности обанкротили 3Dfx.

GeForce 2

В 2000-2001 годах компания NVIDIA выпустила серию видеокарт GeForce 2 (GTS, Ultra, Pro, MX и т. д.). У этих видеоадаптеров было 256-битное ядро — одно из самых производительных ядер того времени.

Базовой моделью стала GeForce 2 GTS (GigaTexel Shading), кодовое имя NV15. Данная видеокарта была изготовлена по 180-нм техпроцессу и содержала 25 миллионов транзисторов. Объем памяти DDR SGRAM составлял 32 Мб или 64 Мб с частотой 200 МГц и 128-битной шиной. У адаптера имелось 4 пиксельных конвейера. NV15 включала в себя полную поддержку DirectX 7, OpenGL 1.2, как и аппаратную обработку геометрии и освещения (T&L).

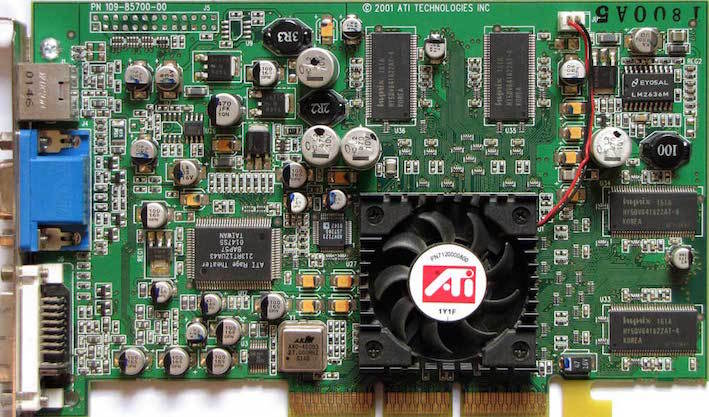

Radeon DDR и SDR

Компания ATI не отставала от прогресса и в 2000 году выпустила процессор Radeon R100 (изначально назывался Rage 6). Он изготавливался по 180-нм техпроцессу и поддерживал технологию ATI HyperZ.

На основе R100 вышли видеокарты Radeon DDR и SDR.

Radeon DDR выпускался с объемом видеопамяти 32 Мб или 64 Мб. Частоты ядра и памяти составляли 183 МГц, использовалась 128-битная шина. В роли интерфейса выступал AGP 4x. У видеокарты было 2 пиксельных конвейера.

Упрощенная версия SDR отличалась от Radeon DDR типом используемой памяти и пониженными частотами (166 МГц). Объем памяти у Radeon SDR предоставлялся только на 32 Мб.

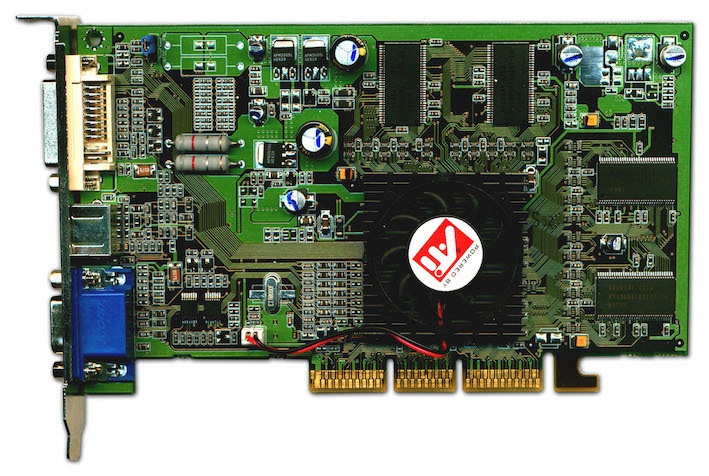

Radeon 8500 и Radeon 7500

В 2001 году на базе RV200 вышли два чипа Radeon 8500 и Radeon 7500.

В Radeon 8500 были собраны новейшие наработки ATI, он оказался очень быстрым. Изготавливался по 150-нм техпроцессу, содержал 60 миллионов транзисторов. Частоты ядра и памяти составляли 275 МГц. Использовалась 128-битная шина. Объем памяти DDR SDRAM предлагался в двух вариантах: 64 Мб и 128 Мб. Пиксельных конвейеров было 4.

Radeon 7500 изготавливался по тому же 150-нм техпроцессу, но с 30 миллионами транзисторов. Ядро работало на частоте 290 МГц, а память на 230 МГц. Пиксельных конвейеров было 2.

GeForce 3

В 2001 году вышли графические процессоры GeForce 3 с кодовым названием NV20. Процессор выпускался по 150-нм техпроцессу. Объем памяти предлагался на 64 Мб и на 128 Мб. Шина была 128-битной и состояла из четырех 32-битных контроллеров. Ядро работало на частоте 200 МГц, а память на частоте 230 МГц. Пиксельных конвейеров насчитывалось 4. Производительность составляла 800 миллиардов операций/сек. Пропускная способность памяти была 7,36 Гб/с

Устройство поддерживало nFinite FX Engine, позволяющие создавать огромное количество различных спецэффектов. Была улучшенная архитектура памяти LMA (Lightspeed Memory Architecture).

Линейка видеокарт состояла из модификаций GeForce 3, GeForce 3 Ti 200 и Ti 500. Они отличались по тактовой частоте, производительности и пропускной способности памяти.

У GeForce 3 Ti 200: 175 МГц ядро, 200 МГц память; 700 миллиардов операций/сек; 6,4 Гб/с пропускная способность.

У GeForce 3 Ti 500: 240 МГц ядро и 250 МГц память; 960 миллиардов операций/сек; 8,0 Гб/с пропускная способность.

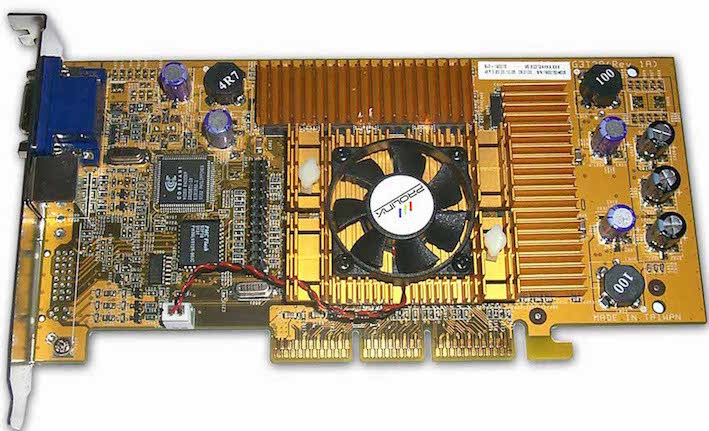

GeForce 4

Следующей видеокартой компании NVIDIA стала GeForce 4, которая вышла в 2002 году. C таким названием выпускались два типа графических карт: высокопроизводительные Ti (Titanium) и бюджетные MX.

Линейка GeForce 4 Ti была представлена моделями Ti 4400, Ti 4600, и Ti 4200. Видеокарты отличались тактовыми частотами ядра и памяти. Объем видеопамяти составлял 128 Мб (у Ti 4200 предлагался вариант и на 64 Мб). В Titanium использовался 128-битный 4-канальный контроллер памяти с LightSpeed Memory Architecture II, насчитывалось 4 блока рендеринга, 8 текстурных блоков, 2 T&L, имелась подсистема сглаживания Accuview и шейдерный движок nFiniteFX II, обеспечивающий полную поддержку DirectX 8.1 и OpenGL 1.3. Модель GeForce 4 Ti 4200 была самой распространенной за счет высокой производительности по приемлемой цене.

GeForce 4 MX наследовали архитектуру GeForce 2 (с повышенным быстродействием). Они базировались на чипе NV17, изготовленного по 150-нм техпроцессу и состоящего из 27 миллионов транзисторов. Объем видеопамяти составлял 64 Мб. У графического процессора было 2 блока рендеринга, 4 текстурных, 1 блок T&L, 128-битный 2-канальный контроллер памяти с LightSpeed Memory Architecture II. Чип также обладал подсистемой сглаживания Accuview.

Radeon 9700 Pro

Летом 2002 года ATI выпустила чип R300, который изготавливался по 150-нм техпроцессу и содержал около 110 миллионов транзисторов. У него было 8 пиксельных конвейеров. Также чип поддерживал улучшенные методы сглаживания.

На базе R300 вышла видеокарта Radeon 9700 с тактовыми частотами ядра 325 МГц и памяти 310 МГц. Объем памяти составлял 128 Мб. Шина памяти была 256-битная DDR.

В начале 2003 года Radeon 9700 сменила видеокарта Radeon 9800. Новые решения были построены на чипе R350, с увеличением тактовых частот и доработкой шейдерных блоков, контроллера памяти.

GeForce FX

GeForce FX — пятое поколение графических процессоров, разработанных и выпущенных компанией NVIDIA с конца 2002 до 2004 годов. Одна из первых видеокарт серии GeForce FX обладала улучшенными методами сглаживания и анизотропной фильтрации. Она поддерживала вершинные и пиксельные шейдеры версии 2.0. Благодаря 64-битному и 128-битному представлению цвета, повысилось качество ярких изображений. Чип NV30 был изготовлен по 130-нм техпроцессу и работал с шиной на 128-бит AGP 8x, поддерживая память DDR2.

GeForce FX была представлена в разных модификациях: еntry-level (5200, 5300, 5500), mid-range (5600, 5700, 5750), high-end (5800, 5900, 5950), еnthusiast (5800 Ultra, 5900 Ultra, 5950 Ultra). Использовалась шина на 126-бит и на 256-бит.

На базе NV30 было создано топовое устройство нового поколения — видеокарта GeForce FX 5800. Объем видеопамяти достигал 256 Мб, частота ядра — 400 МГц, а памяти — 800 МГц. В 5800 Ultra частота ядра повысилась до 500 МГц, а памяти — до 1000 МГц. Первые карты на основе NV30 оснащались инновационной системой охлаждения.

GeForce 6 Series

Развитие видеокарт активно продолжалось и в 2004 году вышел следующий продукт компании — GeForce 6 Series (кодовое название NV40).

Чип NV40 производился также по 130-нм техпроцессу, что не помешало ему стать более экономичным. Модификация пиксельных конвейеров дала возможность обрабатывать до 16 пикселей за такт. Всего было 16 пиксельных конвейеров. Видеокарты поддерживали пиксельные и вершинные шейдеры версии 3.0, технологию UltraShadow (прорисовка теней). Кроме этого, GeForce 6 Series с помощью технологии PureVideo декодировали видео форматов H.264, VC-1 и MPEG-2. NV40 работал через 256-битную шину, при этом использовались очень быстрые модули памяти типа GDDR3.

Одна из первых моделей, видеокарта GeForce 6800 была весьма производительной и тянула самые новые игры того времени. Она работала как через интерфейс AGP, так и через шину PCI Express. Частота ядра составляла 325 МГц, а частота памяти была 700 МГц. Объем памяти доходил 256 Мб или 512 Мб.

Radeon X800 XT

Компания ATI находилась в более выгодном положении. В 2004 году компания представила 130-нм чип R420 (усовершенствованная версия R300). Пиксельные конвейеры были разделены на четыре блока по четыре конвейера в каждом (в сумме 16 пиксельных конвейеров). Увеличилось до 6 количество вершинных конвейеров. Поскольку R420 не поддерживал работу шейдеров третьего поколения, он работал с обновленной технологией HyperZ HD.

Самая мощная и производительная видеокарта новой линейки Radeon была X800 XT. Карта оснащалась памятью типа GDDR3 объёмом 256 Mб и разрядностью шины 256-бит. Частота работы достигала 520 МГц по ядру и 560 МГц по памяти. Radeon X800 XT продавались в двух исполнениях: AGP и PCI Express. Помимо обычной версии существовал Radeon X800 XT Platinum Edition, обладающий более высокими частотами чипа и памяти.

GeForce 7800 GTX

В 2005 году вышел чип G70, который лег в основу видеокарт серии GeForce 7800. Количество транзисторов увеличилось до 302 миллионов.

Вдвое увеличилось количество пиксельных конвейеров — до 24 штук. В каждый конвейер были добавлены дополнительные блоки ALU, отвечающие за обработку наиболее популярных пиксельных шейдеров. Таким образом возросла производительность чипа в играх, делающих упор на производительность пиксельных процессоров.

GeForce 7800 GTX стала первой видеокартой на базе G70. Частота ядра составляла 430 МГц, памяти — 600 МГц. Использовалась быстрая GDDR3, а также 256-битная шина. Объем памяти составлял 256 Мб или 512 Мб. GeForce 7800 GTX работала исключительно через интерфейс PCI Express х16, который окончательно начал вытеснять устаревающий AGP.

GeForce 7950 GX2

Событием 2006 года для компании NVIDIA стал выпуск первой двухчиповой видеокарты GeForce 7950, созданной по 90-нм техпроцессу.Nvidia 7950 GX2 имела по одному чипу G71 на каждой из плат. Ядра видеокарты работали на частоте 500 МГц, память — на частоте 600 МГц. Объем видеопамяти типа GDDR3 составлял 1 Гб (по 512 Мб на каждый чип), шина 256-бит.

В новой карте было оптимизировано энергопотребление и доработана система охлаждения. Выпуск 7950 GX2 стал началом развития технологии Quad SLI, позволяющей одновременно использовать мощности нескольких видеокарт для обработки трёхмерного изображения.

Radeon X1800 XT, X1900

На базе R520 была разработана видеокарта Radeon X1800 XT. Карта оснащалась памятью типа GDDR3 объемом 256 Мб или 512 Mб, работающей на частоте 750 МГц. Использовалась 256-битная шина.

Видеокарты Radeon X1800 XT недолго пробыли на рынке. Вскоре им на смену пришли адаптеры серии Radeon X1900 XTХ на базе чипа R580. Процессором полностью поддерживались на аппаратном уровне спецификации SM 3.0 (DirectX 9.0c) и HDR-блендинг в формате FP16 с возможностью совместного использования MSAA. В новом чипе было увеличено количество пиксельных конвейеров — до 48. Частоты ядра составляла 650 МГц, а памяти — 775 МГц.

Еще через полгода вышел чип R580+ с новым контроллером памяти, работающий со стандартом GDDR4. Частота памяти была увеличена до 2000 МГц, при этом шина оставалась 256-битной. Основные характеристики чипа остались прежними: 48 пиксельных конвейеров, 16 текстурных и 8 вершинных конвейеров. Частота ядра составляла 625 МГц, памяти было больше — 900 МГц.

GeForce 8800 GTX

В 2006 году на базе процессора G80 было выпущено несколько видеокарт, самой мощной из которых являлась GeForce 8800 GTX. G80 был одним из самых сложных существующих чипом того времени. Он выпускался по 90-нм техпроцессу и содержал 681 миллион транзисторов. Ядро работало на частоте 575 МГц, память — на частоте 900 МГц. Частота унифицированных шейдерных блоков составляла 1350 МГц. У GeForce 8800 GTX было 768 Мб видеопамяти GDDR3, а ширина шины составляла 384-бит. Поддерживались новые методы сглаживания, которые позволили блокам ROP работать с HDR-светом в режиме MSAA (Multisample anti-aliasing). Получила развитие технология PureVideo.

Архитектура GeForce 8800 GTX оказалась особенно эффективной и на протяжении нескольких лет являлась одной из самых быстрых видеокарт.

Radeon HD2900 XT, HD 3870 и HD 3850

В 2007 года была представлена флагманская видеокарта Radeon HD2900 XT на базе чипа R600. Частота ядра видеокарты составляла 740 МГц, памяти GDDR4 — 825 МГц. Использовалась 512-битная шина памяти. Объем видеопамяти достигал 512 Мб и 1 Гб.

Более успешной разработкой вышел процессор RV670, выпущенный в том же году. Архитектурой он почти не отличался от предшественника, но изготавливался по 55-нм техпроцессу и с шиной памяти 256-бит. Появилась поддержка DirectX 10.1 и Shader Model 4.1. На базе процессора производились видеокарты Radeon HD 3870 (частота ядра 775 МГц, памяти 1125 МГц) и Radeon HD 3850 (частота ядра 670 МГц, памяти 828 МГц) с объемом видеопамяти 256 Мб и 512 Мб и шиной 256-бит.

GeForce 9800

Чип G92 лег в основу GeForce 9800 GTX — одной из самых быстрых и доступных видеокарт. Он изготавливался по 65-нм техпроцессу. Частота ядра составляла 675 МГц, частота памяти — 1100 МГц, а шина — 256-бит. Объем памяти предлагался в двух вариантах: на 512 Мб и на 1 Гб. Чуть позже появилась модель GTX+, которая отличалась 55-нм техпроцессом и частотой ядра — 738 МГц.

В данной линейке также появилась очередная двухчиповая видеокарта GeForce 9800 GX2. Каждый из процессоров имел спецификации, как у GeForce 8800 GTS 512 Мб, только с разными частотами.

GeForce GTX 280 и GTX 260

В 2008 году компания NVIDIA выпустила чип GT200, который использовался в видеокартах GeForce GTX 280 и GTX 260. Чип производился по 65-нм техпроцессу и содержал 1,4 миллиарда транзисторов, обладал 32 ROP и 80 текстурными блоками. Шина памяти увеличилась до 512-бит. Также была добавлена поддержка физического движка PhysX и платформы CUDA. Частота ядра видеокарты составляла 602 МГц, а памяти типа GDDR3 — 1107 МГц.

В видеокарте GeForce GTX 260 использовалась шина GDDR3 448-бит. Частота ядра достигала 576 МГц, а памяти — 999 МГц.

Radeon HD 4870

Старшая видеокарта новой линейки получила название Radeon HD 4870. Частота ядра составляла 750 МГц, а память работала на эффективной частоте 3600 МГц. С новой линейкой видеокарт компания продолжила свою новую политику выпуска устройств, которые могли успешно конкурировать в Middle-End-сегменте. Так, Radeon HD 4870 стал достойным конкурентом видеокарты GeForce GTX 260. А место лидера линейки HD 4000 вскоре заняло очередное двухчиповое решение Radeon HD 4870X2. Сама архитектура видеокарты соответствовала таковой у Radeon HD 3870X2, не считая наличия интерфейса Sideport, напрямую связывающего два ядра для наиболее быстрого обмена информацией.

GeForce GTX 480

В 2010 году NVIDIA представила GF100 с архитектурой Fermi, который лег в основу видеокарты GeForce GTX 480. GF100 производился по 40-нм техпроцессу и получил 512 потоковых процессоров. Частота ядра была 700 МГц, а памяти — 1848 МГц. Ширина шины составила 384-бит. Объем видеопамяти GDDR5 достигал 1,5 Гб.

Чипом GF100 поддерживались DirectX 11 и Shader Model 5.0, а также новая технология NVIDIA Surround, позволяющая развернуть приложения на три экрана, создавая тем самым эффект полного погружения.

Чипы Cypress и Cayman

Компания AMD выпустила 40-нм чип Cypress. Разработчики компании решили поменять подход и не использовать исключительно буквенно-цифровые значения. Поколению чипов начали присваивать собственные имена. Сам принцип архитектуры Cypress продолжал идеи RV770, но дизайн был переработан. Вдвое увеличилось количество потоковых процессоров, текстурных модулей и блоков ROP. Появилась поддержка DirectX 11 и Shader Model 5.0. В Cypress появились новые методы сжатия текстур, которые позволили разработчикам использовать большие по объему текстуры. Также AMD представила новую технологию Eyefinity, полным аналогом которой позже стала технология NVIDIA Surround.

Чип Cypress был реализован в серии видеокарт Radeon HD 5000. Вскоре AMD выпустила и двухчиповое решение Radeon HD 5970. В целом Cypress оказался очень успешным.

Серия видеокарт Radeon HD 6000, выпущенная в конце 2010 года, была призвана конкурировать с акселераторами GeForce GTX 500. В основе графических адаптеров лежал чип Cayman. В нем применялась немного другая архитектура VLIW4. Количество потоковых процессоров составляло 1536 штук. Возросло количество текстурных модулей — их стало 96. Также Cayman умел работать с новым алгоритмом сглаживания Enhanced Quality AA. Ширина шины памяти чипа составляла 256-бит. Видеокарты использовали GDDR5-память.

GeForce GTX 680

Начиная с 2011 года NVIDIA выпустила поколение графических ускорителей. Одной из примечательных моделей была видеокарта GeForce GTX 680, основанная на чипе GK104, производившемуся по 28-нм техпроцессу. Частота работы ядра 1006 МГц, частота работы памяти 6008 МГц, шина 256-бит GDDR5.

В 2013 года компания представила чип GK110, на котором основываются флагманские видеокарты GeForce GTX 780 и GeForce GTX Titan. Использовалась шина 384-бит GDDR5, а объем памяти повысился до 6 Гб.

Автор: ua-hosting.company

Источник

www.pvsm.ru

История 3D-ускорителей и видеокарт 1990-ых годов

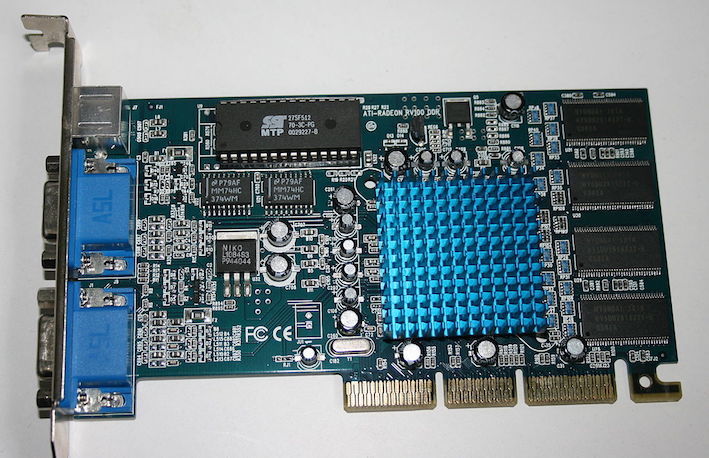

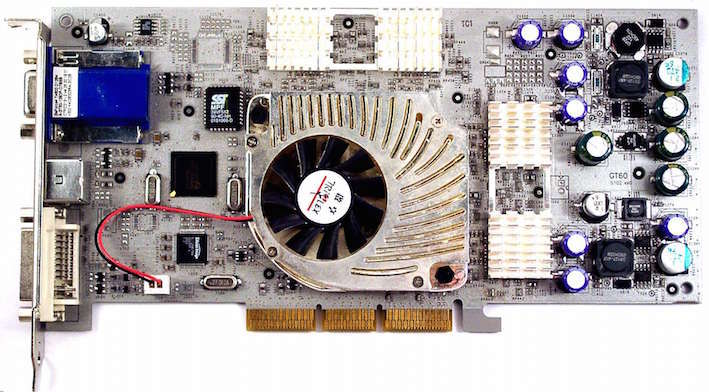

В первой части мы поговорили о зарождении дискретных видеокарт: о том, что они могли, как подключались и сколько стоили. Теперь же перейдем к, пожалуй, самому интересному периоду развития видеокарт — к 90-ым годам: уже появляются первые 3D-игры, и тут же становится понятно, что программный рендеринг не тянет их и нужно привлекать видеокарты, что и было сделано — в 1995 году, в один год с выходом легендарной PlayStation 1, появился первая доступная 3D-видеокарта — S3 Virge.S3 ViRGE — первая ласточка 3D-мира Забегая наперед — это была именно видеокарта, то есть она могла работать и с 2D, и с 3D — это было редкостью по тем временам, но об этом ниже. Правда, с 3D она работала плохо — из-за новой по тем временам билинейной фильтрации текстур (в 2D она была по понятным причинам не нужна) производительность серьезно падала. Но с 2D она справлялась без проблем, качественно отрисовывая, к примеру, интерфейс Windows.

Характеристики же ее были достаточно скромны — частота видеочипа была порядка 60 МГц, а памяти было до 4 МБ, причем память можно было наращивать самому. Да-да, на видеокарте было распаяно 2 МБ и были слоты, куда можно было вставить еще 2:

При этом разрядность шины памяти была аж целых 64 бита — к слову, такая же шина используется даже сейчас в low-level игровых видеокартах, к примеру — в GT 1030.

Достаточно большим плюсом видеокарты была всеядность, она могла работать со всеми графическими API — не только с Direct3D и OpenGL, но и с RenderWare и Brender, а также имела собственный API — S3D (особой популярности он, правда, не получил). К тому же эта видеокарта имела телевизионный выход, так что была универсальной при выводе картинки.

Из-за проблем при работе с 3D многие стали подключать к ней уже чисто 3D-видеоускоритель 3dfx Voodoo1, тем самым убивая двух зайцев — ViRGE отлично работает с 2D, Voodoo1 — с 3D, тандем же получается универсальным.

3dfx Voodoo1 — начало линейки легендарных видеоускорителей 3dfx была самым молодым игроком на рынке видеокарт — компания была основана 3 выходцами из Silicon Graphics, которые при уходе не забыли прихватить с собой разработки новых видеочипов. Куда могла податься молодая компания, умеющая в графику? Правильно, в производство видеочипов для игровых автоматов. Причем они преуспели так, что на них стали обращать внимание производители игровых приставок. На рынок ПК они выходить не хотели, однако в 1996 году цены на быструю память EDO упали до терпимого уровня, и 3dfx решили выпустить собственный видеоускоритель с этим типом памяти.

Почему именно видеоускоритель, и в чем разница с видеокартой? Видеокарта должна уметь и готовить картинку, и выводить ее на экран. Видеоускоритель же умеет только рендерить картинку — выводить ее нужно через видеокарту. 3dfx, да и другие компании, решили так — у каждого человека уже есть видеокарта, которая отрисовывает интерфейс ОС. Так зачем мучиться и впихивать на плату с 3D-видеочипом еще и чип для работы с 2D, если он есть у пользователей? Поэтому можно от него отказаться — это и цену снизит, и разрабатывать видеоускоритель проще. Ну а для вывода картинки просто будем подключать видеоускоритель к видеокарте проводом VGA. Да, громоздко, но зато дешево — и многие это оценили (на картинке две Voodoo в SLI, но суть та же):

И, как я уже писал выше, с видеокартой для Voodoo1 проблем не было — ViRGE подходил идеально, так что связка его с «вуду» была очень популярна. Причем, что достаточно забавно, по цифрам характеристики Voodoo были хуже — видеочип с частотой 50 МГц и те же 4 МБ памяти. Но 3dfx брали не частотой, а оптимизацией и дополнительными вычислительными блоками: к примеру, текстурным, который сразу решал все проблемы с фильтрацией текстур, которые были у S3. Также специально для своих видеокарт 3dfx выпустила новый API — Glide. Хотя он был основан на открытом OpenGL, из-за хорошей заточки под видеокарты Voodoo (использовались геометрические и текстурные преобразования), а также максимального упрощения (есть только то, что нужно для 3D-игр, даже цвет ужали до 16-битного: впрочем, качество было таким, что могло соперничать с 24-битным цветом) можно было получать существенно лучшую графику, чем у конкурентов:

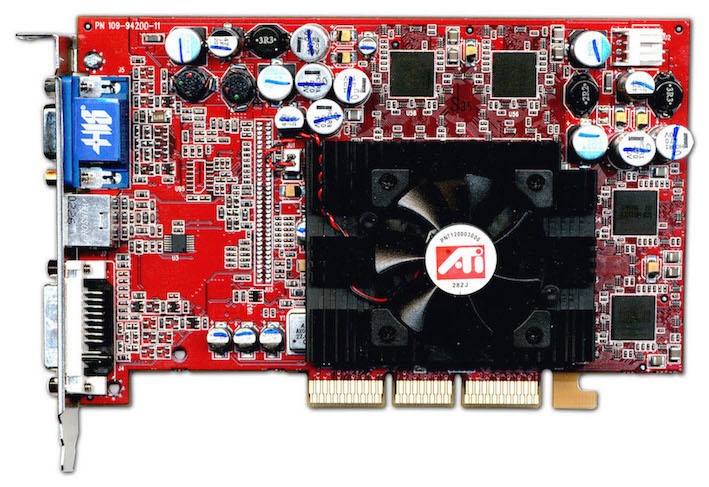

А конкуренты не дремали — в этом же 1996 году компания ATI выпустила свою видеокарту Rage.

ATI Rage I и II — красные наступают ATI появилась аж в 1985 году как производитель видеокарт для крупных игроков рынка — таких, как IBM и Commodore. Поэтому несколько странно, что первую 3D-видеокарту они выпустили позже других, более того — наделав массу ошибок. Судите сами — Rage I был основан на чисто 2D-ядре March64 с блоками для ускорения MPEG-1 и 3D. Понятное дело, что такая связка с 3D работала еще хуже, чем ViRGE, поэтому ATI в спешном порядке выпускает вторую версию видеокарты — Rage II, которая таки стала винрарной.

Во второй версии был доработан видеочип — добавили блоки фильтрации текстур, а также аппаратную возможность альфа-смешивания. Теперь он назывался March64 GUI и имел частоту в 60 МГц. Видеокарта могла работать не только с EDO, но и с SGRAM — эту память можно назвать дедушкой GDDR. Объем памяти составлял от 2 до 8 МБ, а пропускная способность была аж целых 480 Мб/с. Как и ViRGE, Rage имела поддержку всех текущих API, кроме Glide (ибо на тот момент он был еще закрыт), а драйвера были как под Windows (95 и NT, хотя под последнюю они были нестабильны — кто бы сомневался), так и под Mac OS 9, OS/2 и даже Linux! К слову, именно с этого момента началась «любовь» Apple и ATI/AMD, которая продолжается и по сей день — видеокарты Rage ставились в некоторые макинтоши того времени.

Nvidia RIVA 128 — зеленые наступают Nvidia — крупнейший на данные момент производитель видеокарт, и многие думают, что у них долгая и интересная история. А вот и нет — компания появилась лишь в 1992 году, и уже в 1995 году представили свой первый видеочип NV1. Увы — первый блин был комом: поддержки Direct3D изначально не было, а когда Nvidia попыталась ее прикрутить, то получилось настолько плохо, что даже решили драйвера с ним не выпускать, и тихо забыть про этот чип. А ведь задумка была интересная — рендеринг был основан на квадратичном маппинге текстур: это было просто реализовать, но, увы, это не поддерживалось в Direct3D, а просить Microsoft сделать поддержку у Nvidia тогда не было возможности (да и в Direct3D были проблемы по-серьезнее, так что Microsoft в любом случае отказалась бы помогать).

Поняв, что из толпы выделяться не стоит, Nvidia сделала новую карточку RIVA 128, уже на ядре NV3 и с поддержкой OpenGL 1 и Direct3D 5. И это был чистый вин в 1997 году — кристалл GPU был выполнен по 350 нм техпроцессу и имел частоту аж в 100 МГц, память была новейшего стандарта SGRAM, ее было 4 МБ, а из-за 128-битной шины скорость оказывалась 1.6 Гб/с — рекорд по тем временам, Nvidia решила это даже в названии показать. Также видеокарта (а это была именно она, да и вообще — Nvidia не производила видеоускорителей) подключалась по новейшему порту AGP x1 (хотя были и варианты с «традиционным» PCI). Из-за быстрой памяти максимальное разрешение составляло 960х720 — к примеру, у Voodoo1 оно было «всего» 640х480.

В начале 1998 года Nvidia выпустила улучшенный вариант видеокарты — RIVA 128 ZX. Основным изменением стал вдвое увеличенный объем видеопамяти — до 8 МБ, а также подключение теперь было через интерфейс AGP x2. К слову — RIVA 128 стали первыми видеокартами, где видеочип стали дополнительно охлаждать — пока еще простым радиатором.

Увы — проблем тоже хватало. Будучи огорченными тем, что NV1 не работает толком с Direct3D, Nvidia бросили все силы на то, чтобы RIVA с ним работала хорошо. Это им удалось, но вот OpenGL оказался заброшен, так что все прелести новой видеокарты могли оценить только пользователи Windows. Вторая проблема — видеокарта не могла программно работать с движком Unreal, что вылилось в проблемы с играми, созданными на нем. Ну и последний камень в огород Nvidia — их видеокарты не могли поддерживать Glide, который игроделы к тому времени оценили и стали выпускать патчи в играм, серьезно улучшающие графику на видеокартах от 3dfx.

В итоге к 1998 году расклад на рынке таков: 3dfx и Nvidia — лидеры. С некоторым отставанием от них идет ATI, ну и совсем в конце плетется S3. Чем закончилось это противостояние — поговорим уже в следующей части статьи.

www.iguides.ru

История видеокарт

Опытные пользователи ПК знают, что такое видеокарты и как они работают. Мы же расскажем, с чего они начинались, как совершенствовались и к чему в конце концов пришли.

Новый виток борьбы

Лавинообразный рост рынка Зd-игр и 3D-видеоплат заставил производителей ускорить разработку все более и более мощных моделей. Знаковым стал 1998 год, подаривший геймерам адаптер Voodoo2 с восемью или двенадцатью мегабайтами памяти EDO DRAM и рабочей частотой до 100 МГц.

Архитектурно Voodoo2 повторял своего предшественника, хотя некоторые узлы были существенно переработаны. Во-первых, адаптер обрел второй текстурный блок, что позволило накладывать по две текстуры за один проход рендеринга и тем самым заметно повысило производительность. Во-вторых, он получил возможность выводить картинку разрешением 800×600 (при 12 Мб видеопамяти – 1024×768 пикселов) с 1б-битным цветом. И, наконец, конкурентов просто сразила возможность совместной работы двух Voodoo2 в режиме SLI. Стоила такая связка безумных денег, зато ни NVIDIA, ни ATI, ни Rendition ничего подобного предложить не могли: производительность этого решения была беспрецедентной.Вот такую громоздкую конструкцию должен был разместить в своем системном блоке фанат «монстров» для получения рекордной производительности.В 1998 году NVIDIA не удалось догнать главного конкурента, тем не менее появившаяся тогда карта NV4 (Riva TNT) заложила основы для будущего успеха. Всего за два года удалось разработать совершенно новую архитектуру. RivaTNT имела два конвейера рендеринга и, как Voodoo2, умела накладывать две текстуры за один проход. Объем памяти SDRAM составлял 16 Мб. а тактовая частота достигала 90 МГц.В отличие от Voodoo2, Riva TNT могла выполнять рендеринг в 32-битном цвете. Поначалу ни разработчики, ни потребители не оценили этого новшества – производительность при переходе в этот режим падала почти вдвое. Тем не менее начало было положено, и уже не за горами были модели, обеспечивавшие комфортный рендеринг в 32-битном цвете. Также Riva TNT могла работать с текстурами размером 1024×1024 пиксела (тогда как для Voodoo2 пределом было 256×256 пикселов).Помимо отставания в производительности платам NVIDIA сильно мешало широкое распространение 3d-библиотеки 3Dfx – Glide. Этот барьер еще предстояло сломать, в чем немалую помощь оказала Microsoft, агрессивно продвигавшая свой Direct3D.ATI в тот год выпустила, мягко говоря, бледный продукт – 3D Rage Pro, единственным преимуществом которого являлась традиционная для акселераторов ATI улучшенная поддержка обработки сжатого видеопотока DVD. По производительности в 3D новинка была на уровне ускорителей предыдущего поколения Riva 128 и Voodoo Graphics, обладая к тому же весьма условной поддержкой OpenGL. Все это привело к тому, что 3D Rage Pro заняла нишу качественного 20-адаптера и была практически проигнорирована геймерами.Из ряда многочисленных производителей 20-видеокарт выделилась еще одна компания – Matrox, выпустившая в 1998 году 2D/3Dакселератор G200. У нее это был первый чип с поддержкой всех необходимых функций 3D-рендеринга. В целом он оказался весьма удачным, напрямую конкурируя с NVIDIA Riva TNT по производительности.Помимо свойственного Matrox превосходного 20-качества, G200 обеспечивал отличное качество 3D-рендеринга в 16- и 32-битном цвете. Чип работал на частотах от 84 до 90 МГц и был оснащен сразу двумя 64-битными шинами данных. По сравнению с более традиционной одной 128-битной шиной решение от Matrox обеспечивало заметно меньшую латентность шины при той же пропускной способности. Кроме того, в G200 была реализована технология DIME, то ссть видеоадаптер мог использовать часть системной памяти для хранения текстур большого формата (до 2048×2048 пикселов), что позволило ограничить объем видеопамяти 8 Мб и тем самым удешевить продукт.

Дворцовый переворот

К концу 90-х годов рынок был поделен между 3Dfx, безоговорочно господствовавшей на нем, NVIDIA, засидевшейся на вторых ролях, и толпой статистов, среди которых подавали надежды ATI, Matrox и S3. Решающая схватка конкурентов пришлась на 1999 год.Начало года ознаменовалось анонсами Voodoo3, Riva TNT2, G400 и Rage 128. 3Dfx по-прежнему полагалась на грубую силу – ее новинки могли работать на частотах до 183 МГц и теоретически поддерживали SLI (правда, адаптеры третьего поколения с поддержкой SLI так и не были выпущены). Но вот с новыми технологиями дела у компании обстояли не слишком гладко: платы получили возможности 20-адаптеров, но при этом Voodoo3 все так же имели единственный конвейер рендеринга, не поддерживали 32-битный цвет и большие текстуры.NVIDIA ударила в ответ чипом NV5, который устанавливался в адаптеры семейства TNT2. Компания сделала упор на технологические преимущества. Так, новая видеокарта стала первой, поддерживающей AGP 4х, обеспечивала вполне приемлемую скорость рендеринга в 32-битном цвете и работала на частотах до 150 МГц (память до 183 МГц). Во многих играх того времени TNT2 вполне могла потягаться с Voodoo3 скоростью и красотой картинки. Так что трон 3Dfx покачнулся…Matrox сумела пробиться на 3D-Олимп, выпустив интереснейший чип G400. Собственные оригинальные технологии компании, появившиеся в G200, были развиты; кроме того, было добавлено несколько новых. Так, чип получил две 128-битные шины данных и тактовую частоту 125-150 МГц, память работала на частоте 166-200 МГц и имела 128-битную шину. Любопытным новшеством являлась аппаратная поддержка эффектов рельефности текстур (Environment mapped Bump mapping, EMBM), обеспечивавшая совершенно иной уровень реалистичности графики.И наконец, впервые в адаптерах потребительского класса появилась поддержка двухмониторных конфигураций. Именно G-J00 впервые дал пользователям возможность работать за двумя мониторами. Все это, в сочетании с впечатляющей производительностью, позволило G400 на какой-то срок вырваться вперед, обогнав конкурентов. Но ложкой дегтя, портившей бочку меда, выступила плохая поддержка OpenGL. Большинство геймеров проигнорировали новинку, так как многие игры тех лет Direct3D просто не поддерживали, а в OpenGL плата Matrox G400 серьезно тормозила.

ATI к тому времени еще не доросла до первого эшелона, тем не менее ее новый Rage 128 привлек внимание геймеров. Будучи дешевле продуктов NVIDIA и 3Dfx, он обеспечивал неплохую скорость рендеринга в 32-битном цвете, обгоняя в этом режиме RivaTNT. Наконец-то чип от ATI получил полную поддержку OpenGL, да и DirectJD разработчики игр признали. Жизнь для ATI налаживалась.Но события 1999 года этим не исчерпываются. К его концу наметился очередной виток противостояния. 3Dfx заготовила новейший чип VSA-100, призванный устранить технологическое отставание от конкурентов, NVIDIA разрабатывала NV10, «чип с сюрпризом», ATI обещала наконец-то прорваться в первый эшелон с новым Rage Fury МАХХ, а S3 громогласно анонсировала Savage 2000, который был просто обязан вывести се на передовые позиции. Какими козырями обладала каждая компания?В VSA-100 была реализована технология T-Buffer, обеспечивающая постобработку изображения с использованием кинематографических спецэффектов. Полноэкранное сглаживание (Full-scene Anti-aliasing), глубина резкости (Depth Of Field), размазывание движущихся объектов (Motion Blur), мягкие тени (Soft Shadows) были призваны кардинально улучшить привлекательность картинки без заметного падения производительности.Козырем NVIDIA была технология расчета трансформации и освещения (Transform And Lighting. T&L). Благодаря ей видеоадаптер получал возможность снять с центрального процессора часть задач по расчету вершин треугольников. что обещало резкий прирост производительности в новых играх.ATI Rage Fury МАХХ должен был обойти всех конкурентов за счет банального удвоения мощности – видеокарта состояла из двух адаптеров Rage 128 Pro. размещенных на одной плате и формирующих кадры по очереди. Цена устройства обещала быть заоблачной.S3 Savage 2000 также обладал блоком T&L, имел передовую технологию сжатия текстур и должен был стать дешевой высокотехнологичной альтернативой Voodoo3, потеснив продукты NVIDIA.

Реальность спутала все карты. 3Dfx не смогла обеспечить своевременный выход адаптеров на VSA-100. ee Voodoo-}, Voodoo5 и Voodoo6 появились на рынке лишь летом 2000 года, причем к тому времени NVIDIA успела выпустить NV15, с которым не мог поспорить даже топовый Voodoo6. Одночиповые Voodoo4 и Voodoo5 изрядно уступали конкурентам но производительности, а двухчиповые и четырехчиповые Voodoo5 стоили дорого и сильно нагревались. Это было мощнейшим ударом по 3Dfx, еще недавно правившей бал на рынке 3D-ускорителей. Ее звезда закатилась, что незамедлительно почуяли кредиторы.S3 выпустила свой Savage 2000 лишь с небольшим опозданием. На первый взгляд все обещания оказались правдой: T&L и сжатие текстур действительно работали и обеспечивали прирост производительности при наличии поддержки со стороны приложения. Вот только в отсутствие таковой адаптер заметно проигрывал конкурентам, а S3 давно уже не была ориентиром для производителей игр. Кроме того, удачный в целом продукт подкосили проблемы с драйверами, которые компания так и не смогла довести до ума и низкая производительность блока T&L по сравнению с изделиями конкурентов. Тем не менее, технологией сжатия текстур S3TC заинтересовалась Microsoft и лицензировала ее под маркой DXTC. Потому, начиная с DirectX 6, видеоадаптеры всех производителей получили эту технологию сжатия текстур.Продукт ATI оказался удачным во многих отношениях, но слишком дорогим. Кроме того, написать драйвер для такого спаренного решения оказалось просто: программисты ATI доделывали его еще несколько месяцев после выхода адаптера.А вот чип от NVIDIA – выстрелил. Выпущенный раньше продуктов конкурентов, адаптер GeForce 256 опережал все прочие акселератеры, обладая при этом высочайшей функциональностью. NV10 имел уже четыре конвейера рендеринга, работал на частоте 120 МГц и оснащался 32 Мб памяти SDK AM (с 2000 года DDRSDRAM), работающей на частоте 166 МГц при 128-битной шине. Кроме того, не стоит забывать пресловутый T&L, поддержкой которого постепенно стали обзаводиться новейшие игры.А что же сделала находившаяся в зените славы компания Matrox? Увы, она не выпустила ровным счетом ничего. Уже тогда сформировавшийся рыночный принцип появления нового продукта каждые пол года компания Matrox проигнорировала. Ее в целом удачный G400 не мог на равных соперничать с GeForce и, ввиду низкой производительности в OpenGL и отсутствия модногоT&L, ушел в разряд нишевых продуктов, оставаясь востребованным любителями работать и играть на двух мониторах сразу. Сказалось отсутствие технологического задела: в активе у Matrox не осталось никаких новых идей.

Злейшие друзья

Казалось бы, NVIDIA пришло время почивать на лаврах. В 2000 году она выкупила остатки обанкротившейся 3Dfx вместе с перспективными разработками и ценными сотрудниками. Чип NV15, устанавливаемый в адаптеры GeForce2, получился хорошим апгрейдом NV10. Бюджетные же «порезанные* версии чипов NVIDIA и вовсе заполонили рынок, основательно потеснив производителей третьего эшелона.И тут, как это часто бывает, ближайший конкурент преподнес сюрприз: показал NVIDIA, что не стоит расслабляться, заняв позицию лидера. Вышедший в июне 2000 года ATI Radeon обладал 64 Мб памяти DDR SDRAM на 128-битной шине и работал на тактовой частоте 183 МГц. Подобно GeForce 256, новинка от ATI была оснащена блоком T&L и наглядно продемонстрировала, что никакого технологического разрыва между двумя компаниями и в помине нет. При всем при том Radeon был еще и дешевле GeForce.Одновременно с этими событиями свой ход сделала и компания Matrox. Свежий чип G450 представлял собой усовершенствованный G400. Он был выполнен по новым технологическим нормам (180 нм вместо 250 нм у G400) и получил более быструю DDR-память, но уже на 64-разрядной шине (то есть скорость обмена с памятью фактически осталась на прежнем уровне). Теоретически смена техпроцесса позволяет повысить тактовые частоты чипа, но в случае G450 этого почему-то не произошло. В целом G450 стал разочарованием для геймеров: стало ясно, что свой прорыв с G400 Matrox развить не смогла и угнаться за конкурентами ей не под силу.

Эпоха шейдеров