Видеокарты 2018 года: Итоги 2018 года: видеокарты / Видеокарты

Содержание

Лучшие видеокарты в соотношении цены к производительности (2018 год) » Eldorado.UA —> Blog

от Максим Федорчук

Каждый год игровая индустрия выдает проекты с улучшенным уровнем графики и, как следствие, растущими требованиями к системе, а геймеры ломают голову над вопросом – какая видеокарта станет оптимальным выбором? Главное, что посоветуем учесть при покупке, это Ваши ожидания от видеокарты. Не стоит переплачивать за то, чем пользоваться не намереваетесь (очевидно, что сверхмощная карта для CS:GO и DOTA 2 будет излишней). Также учтите некоторые нюансы:

- Определитесь с разрешением монитора или телевизора, на котором намерены играть.

- Убедитесь, что мощности блока питания компьютера достаточно для выбранной видеокарты (как правило производители указывают рекомендованную мощность в спецификации).

То же самое касается наличия разъемов под питание карты.

То же самое касается наличия разъемов под питание карты. - Держите в голове объем видеопамяти, который необходим для предпочитаемого уровня графики при выбранном разрешении. Для 1080p и 1440p рекомендуемый минимум равен 4 Гб, для 4K – 8 Гб.

- Современные мониторы часто поддерживают технологии FreeSync (AMD) и G-Sync (nVidia), призванные ликвидировать эффект разрыва экрана (путем синхронизации частоты обновления экрана и fps в самой игре). Для использования данных технологий нужна соответствующая видеокарта от одного из этих производителей.

Ситуация на рынке

По сравнению с концом 2017 года и началом этого, цены на мощную дискретную «графику» упали. Бум майнинга прошел, к тому же появилась манна небесная в виде специализированных ASIC-систем – добыча криптовалюты на обычных видеокартах стала не выгодной, и геймеры смогли вздохнуть, хоть и не с большим, но облегчением. Немного поностальгируем по ценам на старте продаж и взглянем на ассортимент игровых видеокарт по состоянию на лето 2018 года.

Лучшая «бюджетка»: RX 560

AMD Radeon RX 560

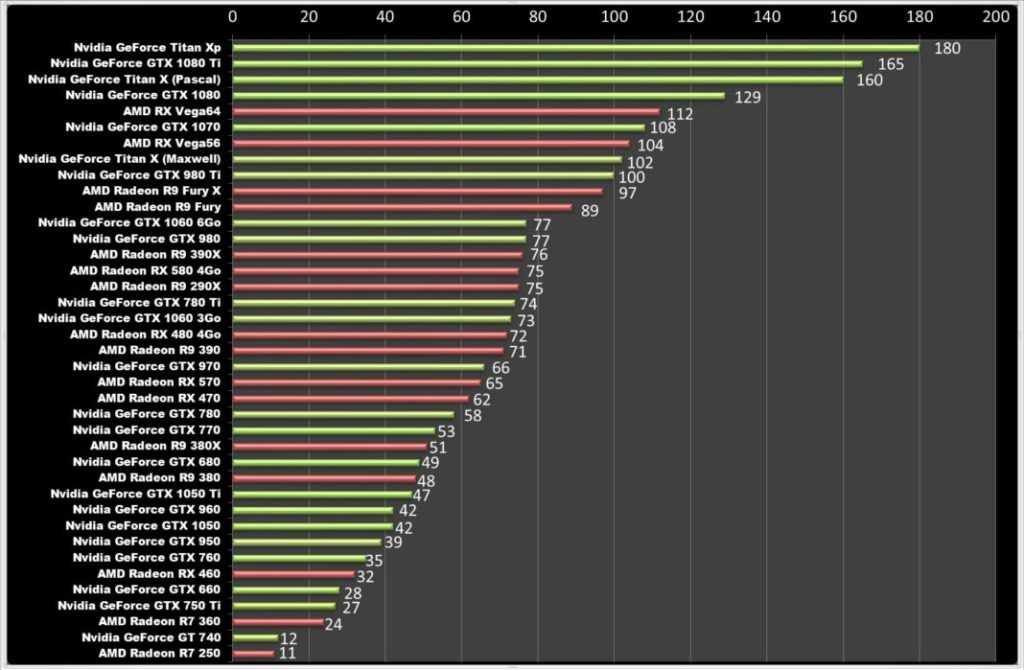

Лучшей бюджетной видеокартой назовем Radeon RX 560 от компании AMD. Данная карта отлично справляется с традиционными киберспортивными дисциплинами, но уступает более дорогой GeForce GTX 1050 Ti в проектах потяжелее на DirectX 11 порядка 10-15 кадров. Однако будущее – за DX 12 (также не забываем про Vulkan) и здесь разница минимизируется, что и стало решающим фактором. Заметим, что речь идет про разрешение Full HD, на котором частота кадров не опускается ниже 30 кадров в большинстве игровых проектов.

Лучшая видеокарта для Full HD: RX 580

AMD Radeon RX 580

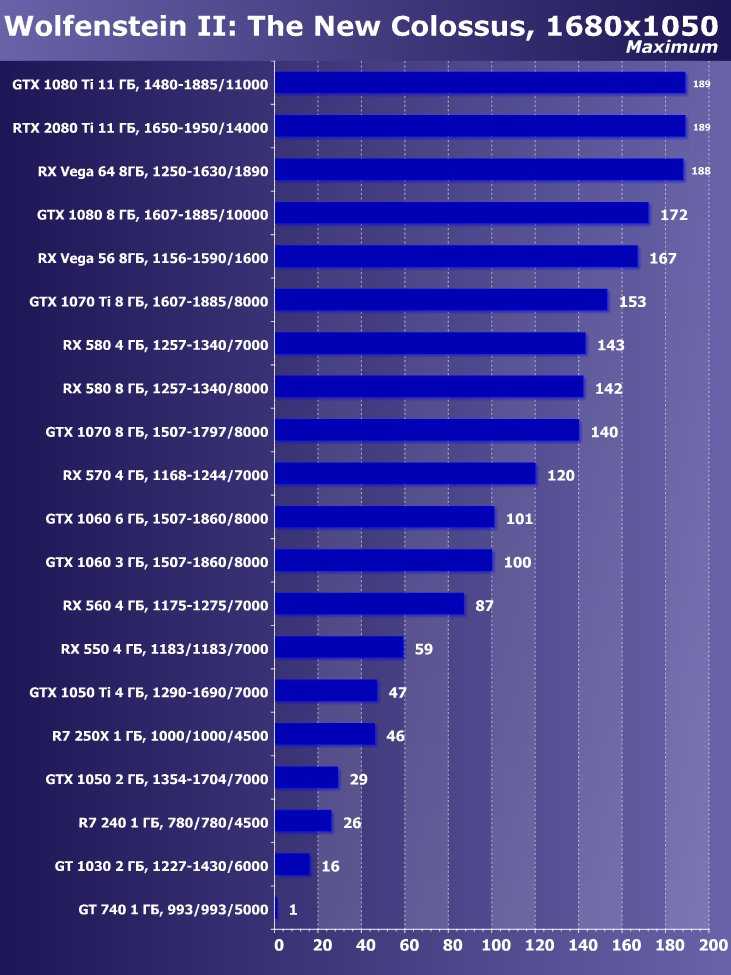

И снова AMD, и снова серия RX, а именно – Radeon RX 580. Она является по сути разогнанной RX 480. Данную видеокарту (версия с 8 Гб видеопамяти) приходится сравнивать с 6-ти гигабайтной версией GTX 1060, цена которой ниже на 20 долларов (в среднем). Что же на выходе? На DirectX 11 частота кадров у RX 580 преимущественно выше на 5-10, а разрыв в 12-ой версии и Vulkan только растет. Добавим сюда больший на 2 гигабайта объем памяти и победитель определен. Правда у карты от AMD выше и энергопотребление – 185 Ватт против 120 у 1060, что нужно учитывать при выборе блока питания.

Добавим сюда больший на 2 гигабайта объем памяти и победитель определен. Правда у карты от AMD выше и энергопотребление – 185 Ватт против 120 у 1060, что нужно учитывать при выборе блока питания.

Лучшая видеокарта для QHD: GTX 1070

nVidia GeForce GTX 1070

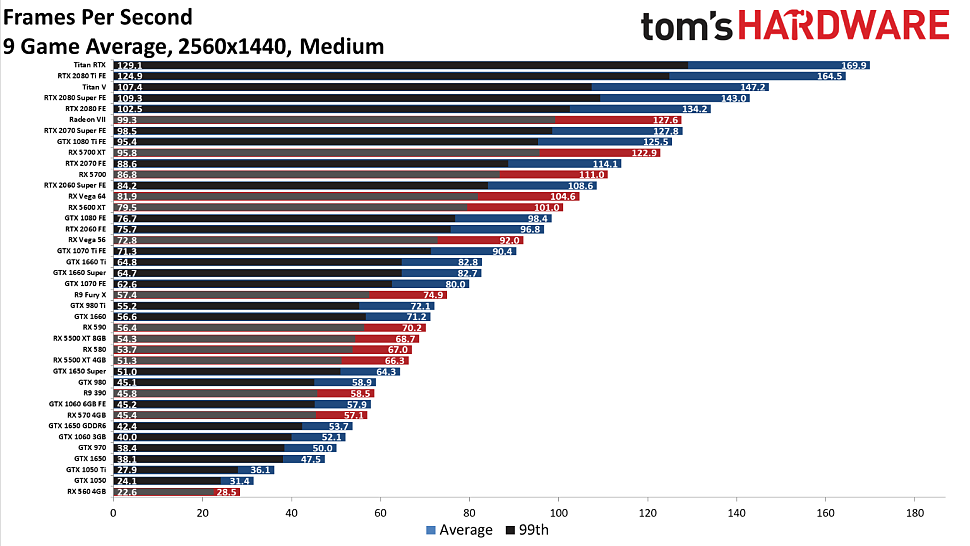

Если Вам наскучило классическое (для этого времени) 1080p, то следующей ступенью станет разрешение 2560×1440. Победителем в этой категории без видимой конкуренции становится видеокарта от «зеленых» GeForce GTX 1070. Она обеспечивает стабильно высокий fps на указанном разрешении, имеет TDP (150 Ватт) даже ниже, чем у RX 580.

Что же касается альтернативы, то цена у AMD Radeon Vega 56 выше на 3000-4000 гривен, а производительность в играх существенно выше только при задействовании API Vulkan.

Лучшая видеокарта для VR: GTX 1080

nVidia GeForce GTX 1080

«Предтоп» 10 серии от nVidia стала лучшим вариантом для любителей гейминга в очках виртуальной реальности. 1080 обеспечена целым набором вспомогательных функций и гарантирует частоту обновления наголовного дисплея на отметке в 90 Гц. Цены на 1080 все еще задраны до небес, по сравнения с темы, что были на релизе, однако иного выбора не наблюдается. Ближайший конкурент от AMD – Vega 64 обойдется дороже, а большей производительностью похвастаться, увы, не может. С энергопотреблением ситуация тоже не в пользу «красных» — 295 Ватт против 180 у 1080.

Цены на 1080 все еще задраны до небес, по сравнения с темы, что были на релизе, однако иного выбора не наблюдается. Ближайший конкурент от AMD – Vega 64 обойдется дороже, а большей производительностью похвастаться, увы, не может. С энергопотреблением ситуация тоже не в пользу «красных» — 295 Ватт против 180 у 1080.

Лучшая видеокарта для 4K: GTX 1080 Ti

nVidia GeForce GTX 1080 Ti

К сожалению, какой-либо интриги в этой категории замечено не было. Самая мощная чисто игровая видеокарта на рынке (выше только модели профессиональной линейки Titan) выдает 30+ кадров в секунду при UHD разрешении во всех играх на ультра настройках, уже не говоря про высокие и средние. Графического чипа GP102 (его ставят в выше упомянутые Титаны) и 11 Гигабайт видеопамяти GDDR5X хватит на годы комфортной игры. Воистину король ПК-гейминга. Ценник на 1080 Ti способен отпугнуть не одного энтузиаста – «дешевые» модели стоят от 23 тысяч.

Альтернативы? AMD, улыбаемся и машем…

10 видеокарт, которые изменили наш игровой опыт

Пытаясь разглядеть будущее видеокарт, довольно легко забывается прошлое PC-гейминга. Если внимательно изучить анналы истории GPU, учесть колоссальные скачки в мощности и производительности графических процессоров, совершенные менее чем за 25 лет, возможно найдется объяснение тому, почему сегодня самая мощная видеокарта продается за $1200.

Если внимательно изучить анналы истории GPU, учесть колоссальные скачки в мощности и производительности графических процессоров, совершенные менее чем за 25 лет, возможно найдется объяснение тому, почему сегодня самая мощная видеокарта продается за $1200.

Прежде чем бежать, сначала нужно научиться ходить. Подобно малышам, которые учаться вставать на ноги, в свое время было предпринято много попыток достигнуть разрешения 800×600, и столько же потребовалось для того, чтобы кто-нибудь придумал, как рендерить количество пикселей, требуемых для 4K (в первом случае 480 000 пикселей на кадр, тогда как во втором уже 8 294 400).

Вы будете удивлены и тому, какое количество современных функций GPU использовались еще на заре индустрии. Взять, к примеру, SLI. Сейчас технология уже уходит в прошлое, но за последнее десятилетие за счет сдвоенных видеокарт удалось существенно повысить производительность GPU в целом. А поверите ли вы в то, что PC-юзер мог объединить две видеокарты для совместной работы уже в 1998 году?

Но давайте начнем с самых азов, когда установка активного охлаждения была необязательной и на платах размещалось множество микрочипов.

Оригинал публикации: PCGamer

3D-ускоритель 3dfx Voodoo

- Год: 1996

- Частота памяти: 50 МГц

- Память: 4/6 МБ

- Техпроцесс: 500 нм

Март 1996. Шри-Ланка выбивает Англию из Кубка мира по крикету, а 3dfx выпускает первую из двух видеокарт, изменивших гейминг — Voodoo.

Карта Voodoo, работающая на частоте 50 МГц и оснащенная колоссальными 4/6 МБ оперативной памяти была превосходной GPU для аппаратного 3D-ускорения. Топовая спецификация могла успешно обрабатывать картинку с разрешением 800×600, однако нижней хватало лишь для 640×480. Несмотря на свои 2D-ограничения, устройство окажется сверхуспешным и принесет 3dfx славу в развитии PC-гейминга. В конечном счете, она окажется в составе Nvidia.

Примечание. 3dfx Voodoo часто упоминается как Voodoo1, хотя это название стало использоваться только после выхода Voodoo2. Точно также вместо 3dfx может использоваться аббревиатура из заглавных букв 3DFX.

Nvidia Riva 128

- Год: 1997

- Частота памяти: 100 МГц

- Память: 4 МБ

- Техпроцесс: SGS 350 нм

Компания по производству чипсетов Nvidia смогла составить реальную конкуренцию 3dfx с выходом видеокарты Nvidia Riva 128 (или NV3). Акроним расшифровывался как Real-time Interactive Video and Animation — интерактивное видео и анимация в реальном времени. Для простоты пользования были интегрированы аппаратные 2D- и 3D-ускорители. Это был невероятный скачок после выпуска Nvidia NV1, в которой пытались, но так и не смогли ввести кривые поверхности третьего порядка.

Этот 3D-ускоритель удвоил исходную частоту Voodoo1 до 100 МГц и был выпущен с неплохой памятью 4 МБ SGRAM. Первая видеокарта, которая принесла популярность Nvidia, а если внимательно изучить планировку (память, окружающую одну центральную микросхему), то можно разглядеть начало длинной линейки адаптеров GeForce, каждый из которых следует этому примеру.

Но в то время как видеокарта составляла конкуренцию Voodoo1 от 3dfx, предлагая более высокие разрешения, она была не без изъянов. Да и единоличное лидерство на рынке было недолгим, поскольку вскоре 3dfx ответит Nvidia, выпустив Voodoo2.

На фотографии выше — Nvidia Riva 128 ZX с более свежим дизайном в сравнении с оригинальным чипом.

3dfx Voodoo2

- Год: 1998

- Частота памяти: 90 МГц

- Память: 8/12 МБ

- Техпроцесс: 350 нм

Еще один 3D-ускоритель, не нуждающийся в представлении. Voodoo2 широко известен своей превосходной производительностью и тем, насколько долгим было его влияние на рынке графических процессоров.

Частота Voodoo2 составляла 90 МГц, оперативная память — 8/12 МБ, при этом поддерживался интерфейс SLI — после подключения сдвоенных видеокарт Voodoo2 мог работать при разрешении 1024×768.

3dfx с Voodoo2 удалось на некоторое время задержаться на вершине рынка, но вскоре компания приняла несколько опрометчивых решений, в результате чего вышла из гонки технологий.

Nvidia GeForce 256

- Год: 1999

- Частота памяти: 120 МГц

- Память: 32 МБ DDR

- Техпроцесс: TSMC 220 нм

Именно тогда мир впервые услышал о GeForce. GeForce 256 — это «первый в мире графический процессор». Но как же Voodoo и Riva, спросите вы? Все дело в невероятном маркетинговом ходе Nvidia, благодаря которому GeForce 256 воспринимается всеми как прародитель современных видеокарт. Однако на деле это было всего лишь название, которое Nvidia дала своему одночиповому решению: graphics processing unit (или GPU).

Как можно догадаться, отрасль тепло приняла столь грандиозное название, созвучное с центральным процессором (CPU), который еще с 70-х годов терроризировал кошельки энтузиастов.

Это не значит, что GeForce 256 не была достойна своего названия. Помимо интеграции аппаратного ускорения для преобразования и освещения, видеокарта могла похвастаться частотой 120 МГц и 32 МБ оперативной памяти DDR. Она также полностью поддерживала Direct3D 7, благодаря чему прослужила еще долгое время, позволяя запускать лучшие классические PC-игры того времени.

Она также полностью поддерживала Direct3D 7, благодаря чему прослужила еще долгое время, позволяя запускать лучшие классические PC-игры того времени.

Вот выдержка из пресс-релиза Nvidia того года. Здесь рассказывается об интегрированных преобразовании и освещении. Говорит Дэвид Кирк, главный инженер Nvidia:

Разработчики и конечные пользователи заявляют, что устали от низкокачественного искусственного интеллекта, багованных персонажей, ограниченного окружения и других неестественно выглядящих сцен. Эта новая графическая подсистема — первый шаг к интерактивной Toy Story или Jurassic Park.

Nvidia GeForce 8800 GTX

- Год: 2006

- Частота памяти: 575 МГц

- Память: 768 МБ GDDR3

- Транзисторы: 681 миллион

- Техпроцесс: TSMC 90 нм

Оглядываться назад все перестали как раз после того как Nvidia выпустила GeForce 8800 GTX. Это видеокарта, которая привлекла огромное внимание людей и заставила их позабыть о переживаниях за компактные габариты.

Это видеокарта, которая привлекла огромное внимание людей и заставила их позабыть о переживаниях за компактные габариты.

Используя 128 шейдерных блоков на столь ожидаемом ядре G80, 768 МБ GDDR3-памяти, 8800 должна быть знакома буквально каждому ветерану гейминга, даже несмотря на то, что сейчас считается более чем устаревшей. Моментально оказавшись на вершине рынка GPU, видеокарте удалось продержаться там некоторое время, во многом благодаря унифицированной шейдерной модели, введенной в Direct3D 10. А еще на ней запускался Crysis 3.

ATI Radeon HD 5970

- Год: 2009

- Частота памяти: 725 МГц

- Память: 2048 МБ GDDR5

- Транзисторы: 4308 миллионов

- Техпроцесс: 40 нм

Чем же все это время занималась AMD? Компания ATI вплоть до 90-х и начала 2000-х годов выпускада множество специальных консольных чипов, и сделала несколько отличных GPU вроде X1900 XTX. Позднее, в 2006 году она была приобретена AMD, что послужило поводом для осторожного объединения бренда с Radeon. После неудачных серий HD 2000 и 3000 были выпущены качественные HD 4870 и 4850, но после слияния наибольшую популярность получила Radeon HD 5970.

После неудачных серий HD 2000 и 3000 были выпущены качественные HD 4870 и 4850, но после слияния наибольшую популярность получила Radeon HD 5970.

По сути, Radeon 5970 была большим Cypress GPU, имела 1024 МБ памяти и большую 256-битную шину… которую можно и нужно было помножить на два. Это была видеокарта для любителей сдвоенных GPU. Вся полученная мощь использовалась для перетягивания рынка на себя.

Традиция совмещения двух чипов продолжилась вплоть до AMD Radeon R9 295X2 и Nvidia Titan Z. Но как только началось сокращение поддержки нескольких графических процессоров, преобладающим форм-фактором вновь стали одиночные карты. А поскольку в DirectX 12 эта технология не поддерживается, то о ней вовсе можно забыть.

Nvidia GTX Titan

- Год: 2013

- Частота памяти: 837 МГц

- Память: 6144 МБ GDDR3

- Транзисторы: 7080 миллионов

- Техпроцесс: TSMC 28 нм

Оригинальную GTX Titan Nvidia выпустила в 2013 году, и на то время ей удалось забраться на вершину PC-гейминга, демонстрируя лучшую производительность. Возможно, это была первая потребительская видеокарта, предназначенная для любителей ультра-характеристик.

Возможно, это была первая потребительская видеокарта, предназначенная для любителей ультра-характеристик.

В GTX Titan было 2688 потоковых процессоров, адаптер мог развивать частоту до 876 МГц. Колоссальные 6 ГБ оперативной памяти GDDR5 — недостижимые даже для некоторых лучших современных видеокарт, а благодаря 384-битной шине в свое время она могла справиться практически с любой задачей.

Выпустив оригинальную GTX Titan, Nvidia совершила невероятный скачок: появился одиночный графический процессор с ультрасовременной архитектурой, способной вытянуть до максимума последние игры, и этого было достаточно, чтобы отправить в прошлое сдвоенные видеокарты.

Nvidia GeForce GTX 1080 Ti

- Год: 2017

- Частота памяти: 1480 МГц

- Память: 11 ГБ GDDR5X

- Транзисторы: 12 миллиардов

- Техпроцесс: TSMC 16 нм

Обсуждая самые влиятельные видеокарты, до этого момента не было ничего сказано об архитектуре Pascal. Свою славу она получила во многом благодаря релизу GTX 1080 Ti. Pascal — лучшая высокопроизводительная архитектура от «зеленой команды». Усилия, приложенные компанией для снижения производительности на Ватт, привели к появлению одной из самых лучших видеокарт, которая даже сегодня уверенно справляется с большинством игр.

Свою славу она получила во многом благодаря релизу GTX 1080 Ti. Pascal — лучшая высокопроизводительная архитектура от «зеленой команды». Усилия, приложенные компанией для снижения производительности на Ватт, привели к появлению одной из самых лучших видеокарт, которая даже сегодня уверенно справляется с большинством игр.

GTX 1080 Ti с максимальным уровнем потребления 250 Вт показывала наилучшую производительность. Процессор по всем направлениям разорвал Titan X Pascal, и даже когда чуть позже Nvidia удалось собрать более быстрый Titan Xp за $1200, адаптер GTX 1080 Ti стоимостью $699 все равно смотрелся наиболее предпочтительнее в соотношении производительность на $1.

AMD Radeon RX 580

- Год: 2017

- Частота памяти: 1257 МГц

- Память: 4 ГБ / 8 ГБ GDDR5

- Транзисторы: 5,7 миллиардов

- Техпроцесс: GlobalFoundries 14 нм

Было бы упущением не вспомнить RX 580 и, соответственно, RX 480, на базе которого была построена более современная версия адаптера. Этот доступный графический процессор с архитектурой Polaris в свое время рекомендовали для тех, кто пытался собрать первый PC для игр в разрешении 1080p.

Этот доступный графический процессор с архитектурой Polaris в свое время рекомендовали для тех, кто пытался собрать первый PC для игр в разрешении 1080p.

Стоящий выше RX 570, RX 580 — воплощение изысканного подхода AMD. Да, забудьте про фальшивый Vega. Polaris со временем стали еще дешевле и лучше.

RX 580 расширила доступ для начинающих геймеров. А потом началась криптолихорадка и эти видеокарты в одно время было вовсе невозможно найти. Это стандарт, по которому следовало бы сравнивать все последующие графические процессоры Nvidia и AMD.

Nvidia GeForce RTX 2080 Ti

- Год: 2018

- Частота памяти: 1350 МГц

- Память: 11 ГБ GDDR6

- Транзисторы: 18,6 миллиарда

- Техпроцесс: TSMC 12 нм

RTX 2080 Ti — для тех, кто готов платить за производительность любую цену. Она стоит $1200, и считается самой дорогой потребительской видеокартой на сегодняшний день. Но при этом благодаря наличию 4352 шейдерных блоков она значительно превосходит RTX 2080 Super. Добавьте к этому невероятные 11 ГБ памяти GDDR6 и общую пропускную способность 616 ГБ/с. Просто возмутительно.

Но при этом благодаря наличию 4352 шейдерных блоков она значительно превосходит RTX 2080 Super. Добавьте к этому невероятные 11 ГБ памяти GDDR6 и общую пропускную способность 616 ГБ/с. Просто возмутительно.

Поэтому, столь высокую стоимость можно объяснить лишь высоким запасом производительности. RTX 2080 Ti — это не просто мощная видеокарта. Это еще и причина, по которой никто даже не вспоминает о забытой SLI-технологии.

Ах да, пока что это единственная карта, достаточно эффективно справляющая с трассировкой лучей… Однако ситуация может значительно поменяться уже в ближайшие месяцы.

Как насчет вас? Какой для вас была самая главная видеоакарта в жизни?

Больше статей на Shazoo

- Железо Steam за март: Доля RTX 3060 превысила 10% — теперь это самая популярная видеокарта среди пользователей сервиса

- Железо Steam за январь: Появление RTX 4090 и падение доли Windows 10

- СМИ: В России на фоне падения популярности майнинга видеокарты подешевели на 40-50%, ОЗУ — на 15%

Тэги:

Источники:

- pcgamer

Nvidia и AMD поставили около 12 миллионов видеокарт для настольных ПК в первом квартале

Нехватка графических процессоров может заставить задуматься о том, сколько видеокарт для ПК было продано за последние месяцы. По данным одной исследовательской фирмы, в первом квартале этого года Nvidia и AMD совместно поставили 12 миллионов карт для настольных ПК.

По данным одной исследовательской фирмы, в первом квартале этого года Nvidia и AMD совместно поставили 12 миллионов карт для настольных ПК.

Оценка(Откроется в новом окне) получена от Jon Peddie Research, которая отслеживает поставки графических процессоров с заводов. Его цифра в 12 миллионов представляет собой увеличение на 7% по сравнению с четвертым кварталом, когда Nvidia и AMD поставили более 11 миллионов карт. В первом квартале около 80% отгруженных карт приходилось на линейку графических процессоров Nvidia, остальные 20% — на AMD.

Цифра в 12 миллионов совпадает с оценкой отдельной исследовательской фирмы Mercury Research, которая также отслеживает рынок графических процессоров. «Общий объем поставок настольных ПК в этом квартале (Q1) для объединенных поставок Nvidia и AMD превысил 10 миллионов единиц», — заявил на прошлой неделе PCMag президент Mercury Research Дин Маккаррон.

Тем не менее, поставок графических процессоров было недостаточно для удовлетворения спроса. На прошлой неделе сотни потребителей выстроились в очереди в магазинах Best Buy по всей территории США, чтобы попробовать купить новейший графический процессор Nvidia, RTX 3080 Ti, но многие покупатели остались с пустыми руками.

На прошлой неделе сотни потребителей выстроились в очереди в магазинах Best Buy по всей территории США, чтобы попробовать купить новейший графический процессор Nvidia, RTX 3080 Ti, но многие покупатели остались с пустыми руками.

Графические процессоры также продолжают распродаваться за считанные секунды на сайтах электронной коммерции, отчасти из-за спекулянтов-ботов, скупающих весь товар. В результате компьютерные геймеры во всем мире надеются, что Nvidia и AMD могут увеличить свои поставки, даже несмотря на то, что производственные мощности сократились.

По иронии судьбы, Jon Peddie Research на самом деле советует производителям графических процессоров не слишком остро реагировать на нехватку. Показательный пример: цифра в 12 миллионов за первый квартал на самом деле не является рекордно высокой для поставок графических карт для настольных ПК. В первом квартале 2018 года производители графических процессоров в совокупности отгрузили 16 миллионов единиц, чтобы попытаться удовлетворить спрос со стороны майнеров криптовалюты. Однако стоимость Биткойна резко упала за тот же период, что привело к огромному отставанию от графических карт для настольных ПК.

Однако стоимость Биткойна резко упала за тот же период, что привело к огромному отставанию от графических карт для настольных ПК.

«Внезапно спрос исчез, и Nvidia больше всего пострадала от этого. Так что в итоге у них была целая куча запасов, на выведение которых ушло почти два или три квартала», — сказал Джон Педди, президент Jon Peddie Research. «[Розничные] каналы пытались продавать эти вещи, и они не покупали никаких новых деталей у Nvidia».

Рекомендовано нашими редакторами

RTX 3080 Ti Founders Edition был в (очень) дефиците в магазинах Best Buy в США

Никогда не пишите в Твиттере: как Илон Маск разрушает обещание Crypto

Советы Nvidia Выборочное развертывание ограничителя майнинга на видеокартах RTX 3000

Производители графических процессоров могут столкнуться с повторением, если они переоценят спрос. Майнинг криптовалют снова в моде. Но интерес может быстро угаснуть. Например, сообщество Ethereum уже готовится отказаться от майнинга с интенсивным использованием GPU в ближайшие месяцы. Между тем, стоимость криптовалют в целом падает.

Между тем, стоимость криптовалют в целом падает.

«Я уже видел этот фильм, и у него плохой конец», — добавила Педди, намекая на прошлые проблемы с перепроизводством. С другой стороны, резкий спад в майнинге может высвободить запасы графических процессоров для потребителей.

Получите наши лучшие истории!

Подпишитесь на Что нового сейчас , чтобы каждое утро получать наши главные новости на ваш почтовый ящик.

Этот информационный бюллетень может содержать рекламу, предложения или партнерские ссылки. Подписка на информационный бюллетень означает ваше согласие с нашими Условиями использования и Политикой конфиденциальности. Вы можете отказаться от подписки на информационные бюллетени в любое время.

Спасибо за регистрацию!

Ваша подписка подтверждена. Следите за своим почтовым ящиком!

Подпишитесь на другие информационные бюллетени

Nvidia RTX: все, что вам нужно знать о трассировке лучей, DLSS и видеокартах Nvidia следующего поколения благодаря их высокой производительности и мощным новым функциям по сравнению с предыдущими аналогами GTX.

Но что делает карту Nvidia RTX лучше обычной старой карты GTX, и как они складываются по сравнению со всем остальным? И что за ерунда про Тьюринг, трассировку лучей и DLSS? В этом руководстве я раскрываю все. К тому времени, когда мы закончим здесь, вы будете знать все, что нужно знать о картах Nvidia RTX, что на самом деле означают трассировка лучей и DLSS и (надеюсь), какую карту вы должны выбрать для следующего обновления. Итак, давайте потренируемся, а?

Nvidia RTX: что это и для чего?

Карты RTX от Nvidia — это новейшее поколение графических карт компании, которые постепенно придут на смену нынешнему поколению графических карт GTX, в частности серии GTX 10, такой как GTX 1060 и GTX 1080.

Что касается того, почему эти карты называются RTX , в отличие от обычных старых GTX , это связано с их довольно уникальным набором функций. Когда Nvidia выпустила свою первую пару карт RTX еще в августе 2018 года, было много шума о том, как их новая архитектура графического процессора Turing, наконец, принесла в реальном времени с трассировкой лучей для обычных видеокарт. Благодаря новым ядрам RT Cores (или ядрам трассировки лучей) внутри своих графических процессоров Turing трассировка лучей, как вы уже догадались, дает картам RTX от Nvidia их название.

Благодаря новым ядрам RT Cores (или ядрам трассировки лучей) внутри своих графических процессоров Turing трассировка лучей, как вы уже догадались, дает картам RTX от Nvidia их название.

Но что на самом деле означает трассировка лучей? По сути, это действительно причудливая (и интенсивно использующая GPU) технология отражения, которая заставляет свет в игре вести себя точно так же, как мы видим его в реальной жизни. Это не что-то особенно новое — например, фильмы Pixar использовали эту технику в течение многих лет, — но до сих пор этого было практически невозможно добиться в играх из-за огромного количества времени и вычислительных усилий, которые требуются для рендеринга, когда вы постоянно архивируете. камера везде. Я расскажу более подробно о том, как это выглядит на самом деле, далее по странице, но достаточно сказать, что это довольно впечатляющий материал.

Трассировка лучей — не единственное, что делает карты Nvidia RTX особенными. Существует также DLSS , отличная технология Nvidia для сглаживания и сглаживания краев, которая использует новые тензорные ядра Turing под управлением искусственного интеллекта и ноу-хау глубокого обучения, помогающие повысить производительность при более высоких разрешениях. Карты RTX также способны к тому, что известно как затенение с переменной скоростью , что еще больше снижает нагрузку на графический процессор, имитируя определенные фрагменты среды, которые не требуют такой большой детализации рендеринга, помогая увеличить частоту кадров без большая потеря качества изображения.

Карты RTX также способны к тому, что известно как затенение с переменной скоростью , что еще больше снижает нагрузку на графический процессор, имитируя определенные фрагменты среды, которые не требуют такой большой детализации рендеринга, помогая увеличить частоту кадров без большая потеря качества изображения.

Плохая новость заключается в том, что покупка одной из этих новых карт RTX не заставит ваши игры выглядеть потрясающе или работать с молниеносной скоростью. Вместо этого многие из ключевых функций Turing требуют специальной поддержки со стороны отдельных разработчиков, а в случае с DLSS — большого количества обучения нейронных сетей от самой Nvidia — и сейчас существует лишь довольно небольшой список подтвержденных игр с трассировкой лучей и DLSS, поэтому далеко.

Это не значит, что карты Nvidia RTX не являются мощными сами по себе, конечно, поскольку большинство из них по-прежнему предлагают достойный шаг вперед по сравнению с картами GTX последнего поколения Nvidia. Кстати…

Кстати…

Характеристики и цена Nvidia RTX

Ниже вы найдете таблицу, в которой сравниваются все характеристики каждой карты Nvidia RTX, выпущенной на данный момент, а также ссылки на все наши обзоры для более подробного изучения их индивидуальных показателей производительности. Просто нажмите на розовые ссылки, и вы попадете на страницу их обзора.

Единственная карта, которую мы действительно все еще ждем на данный момент, — это неизбежная RTX 2050 — хотя, согласно последним слухам, Nvidia вполне может отказаться от своего прозвища RTX и поддержки трассировки лучей заголовка для своей бюджетной карты следующего поколения и возвращаясь к своему старому соглашению об именах GTX с так называемой (и не говоря уже о том, что это очень запутанно) GTX 1660. Конечно, я обновлю это более точной информацией, как только Nvidia официально объявит об этом. А пока давайте сосредоточимся на картах Nvidia RTX, которые мы сделать знать о.

Что касается выходов дисплея, каждая карта также будет поддерживать разрешение 8K при 60 Гц с включенным HDR — на одном экране, не меньше, благодаря их готовым портам DisplayPort 1. 4a, а также 4K при 60 Гц через их HDMI 2.0 б выходы. Они также готовы поддерживать новую модную технологию USB-C VirtualLink. Это будет иметь особое значение для пользователей виртуальной реальности, поскольку это означает, что выход USB-C карты сможет обеспечить всю мощность, отображение и все данные, необходимые для использования гарнитуры виртуальной реальности, через один разъем.

4a, а также 4K при 60 Гц через их HDMI 2.0 б выходы. Они также готовы поддерживать новую модную технологию USB-C VirtualLink. Это будет иметь особое значение для пользователей виртуальной реальности, поскольку это означает, что выход USB-C карты сможет обеспечить всю мощность, отображение и все данные, необходимые для использования гарнитуры виртуальной реальности, через один разъем.

Надеюсь, у вас есть большой кейс, в который можно поместить одну из этих вещей…

Nvidia также надеется, что их карты Turing будут привлекательными для стримеров, поскольку они смогут кодировать 8K-видео со скоростью 30 кадров в секунду в HDR в режиме реального времени впервые, а также экономия битрейта до 25% при кодировании с помощью HEVC и до 15% при кодировании H.264. Потоковая передача 4K также станет намного более практичной: Nvidia заявляет, что вы получите лучшую производительность, чем типичная настройка кодирования x264, которую вы могли бы использовать сегодня, с 1% пропущенных кадров при потоковой передаче на Twitch в 4K с битрейтом 40K по сравнению с 90% через x264 и 1% загрузка ЦП по сравнению с 73% x264 при 4K с битрейтом 40K.

Производительность Nvidia RTX

Спецификации все хороши и хороши, но ключевой вопрос у всех на устах — это скорость, скорость, скорость. Насколько они быстрее видеокарт Nvidia GTX и стоит ли тратить на них столько денег? В некоторых случаях абсолютно. Вы найдете более подробные данные о производительности в каждом обзоре видеокарты RTX, но, например, RTX 2060 — это удивительно хорошая видеокарта с отличным соотношением цены и качества, которая легко может сравниться с текущей GTX 1070Ti от Nvidia, предлагая почти 60 кадров в секунду. в разрешении 2560×1440, а также абсолютно безупречные 60 кадров в секунду на 1920х1080 на максимальных настройках качества.

RTX 2070, с другой стороны, немного быстрее, чем GTX 1080, что делает ее еще одной отличной картой 1440p, а также достойным вариантом 4K, в то время как RTX 2080 на самом деле не намного лучше, чем GTX 1080Ti — по крайней мере, когда речь идет о чистой производительности, то есть вы игнорируете все его причудливые функции RTX.

Тем временем RTX 2080Ti значительно быстрее, чем любая другая видеокарта, которую я тестировал до сих пор, и, безусловно, самая мощная карта для игр 4K со скоростью 60 кадров в секунду, доступная в настоящее время.

В ближайшие недели я сделаю больше сравнений, а пока давайте посмотрим, как многие из них выглядят по сравнению с конкурентами на GTX.

- RTX 2060 против GTX 1060

- RTX 2060 против GTX 1070

- RTX 2080 против GTX 1080

- RTX 2080 Ti против GTX 1080 Ti

Nvidia RTX: что, черт возьми, такое трассировка лучей и почему меня это должно волновать?

Как я уже упоминал выше, трассировка лучей — это действительно, действительно причудливая технология освещения, которая заставляет тени и отражения вести себя так, как они ведут себя в реальной жизни. это не — правильная трассировка лучей , как, например, в фильмах Pixar (это все еще далеко за пределами возможностей современных графических процессоров), но специалисты Nvidia по искусственному интеллекту в значительной степени дали нам следующую лучшую вещь — как мое интервью с программистом рендеринга Metro Exodus Беном Арчардом. могу засвидетельствовать. Взгляните на демонстрацию Nvidia Sol, чтобы понять, что я имею в виду:

могу засвидетельствовать. Взгляните на демонстрацию Nvidia Sol, чтобы понять, что я имею в виду:

Посмотрите, как свет отражается от каждой отдельной поверхности, как это должно быть в реальной жизни, и как каждое отражение способно отображать объекты, которые даже не находятся в этом конкретном кадре. ? Вот на что способна трассировка лучей, и только когда вы сравниваете игры бок о бок, вы понимаете, как неправильно они смотрели раньше, когда мы ничего не знали.

Трассировка лучей также необходима для создания всех тех мягких краев теней, которые просто невозможны при использовании обычных методов освещения. Взгляните на эти кадры из грядущего фильма Mundfish «Атомное сердце». Придется извинить за качество камеры моего телефона (темные демонстрационные комнаты действительно не очень способствуют хорошей фотосъемке), но разница как день и ночь.

Мягкие тени, точные зеркальные отражения…

Жесткие тени, кто знает, что такое зеркальные отражения…

В этом стеклянном резервуаре хорошо видны другие объекты со всей комнаты. ..

..

Но отключение трассировки лучей означает, что об отражениях вообще не может быть и речи.

На данный момент существует всего несколько подтвержденных игр RTX, которые будут поддерживать технологию трассировки лучей Nvidia, но все демоверсии, которые я видел до сих пор, выглядели довольно аппетитно, начиная с оживленного Day of the Tomb Raider в Shadow of the Tomb Raider. Мертвая сцена в Battlefield V: огонь взрывающихся танков прямо на глазах у ваших врагов.

Плохая новость, опять же, заключается в том, что трассировка лучей по-прежнему оказывает огромное влияние на старые уровни производительности. Хотя мне еще предстоит опробовать Battlefield V, команда Metro Exodus заявила, что они нацелены на 60 кадров в секунду при разрешении всего 1080p со всеми включенными технологиями трассировки лучей, когда я разговаривал с ними еще в августе, предполагая, что они вам понадобятся. карт Nvidia RTX более высокого уровня, чтобы по-настоящему извлечь из этого максимальную пользу.

К счастью, Nvidia усердно работает над тем, чтобы другая ключевая функция Turing помогла восполнить пробелы. Введите DLSS.

Введите DLSS.

Nvidia RTX DLSS: секретное оружие Тьюринга

К счастью, Nvidia втиснула множество других технологий искусственного интеллекта, повышающих производительность, в свои карты RTX, которые, как мы надеемся, сведут на нет любое потенциальное влияние трассировки лучей, если разработчики воспользуются ими. Действительно, несмотря на все внимание, уделяемое трассировке лучей во время запуска Nvidia RTX, она не так интересна, как другая ключевая функция Тьюринга, DLSS.

Эта технология, также известная как Deep Learning Super Sampling, чертовски хороша. По сути, это сверхэффективная форма сглаживания (AA), в которой используется искусственный интеллект Тьюринга и тензорные ядра с глубоким обучением, чтобы снять часть нагрузки с графического процессора. AA, если вы не знакомы с этим термином, — это метод, который разработчики игр используют для того, чтобы линии и края выглядели гладкими и естественными, а не миллионами зубчатых пикселей.

После того, как искусственный интеллект Тьюринга будет обучен специальной нейронной сети, предназначенной для конкретной игры (в данном случае — демо-версии Infiltrator от Epic), игры DLSS не только будут давать более точную картинку, но и дадут вам дополнительные кадры в Процесс (нажмите, чтобы увеличить).

Это особенно важно, когда вы играете в игры с разрешением 4K, так как более распространенные методы сглаживания, такие как временное сглаживание (TAA), часто могут слишком сильно смягчить изображения (сводя на нет прекрасное четкое ощущение, которое должно приносить 4K), а также сделать вещи более четкими. немного неправильно, когда сцены происходят на скорости. Заметите ли вы что-либо из этого без помощи камеры со стоп-кадром, конечно, является предметом споров.

Ключевым моментом является то, что это действительно может помочь увеличить эти цифры частоты кадров без особого снижения качества изображения. На данный момент он доступен только в Final Fantasy XV, но здесь я обнаружил, что смог получить еще 10-15 кадров в секунду с включенным DLSS по сравнению с параметрами AA по умолчанию в игре.

Вот как DLSS выглядит на практике с предустановкой FFXV Highest при 4K… (щелкните, чтобы увеличить)… и вот как выглядит игра без DLSS при максимальном разрешении 4K (щелкните, чтобы увеличить)

Очень похоже на трассировку лучей, тем не менее, DLSS — это отдельная функция, которая должна поддерживаться не только отдельными разработчиками, но и значительной частью вклада самих Nvidia, поскольку именно им необходимо обучать свои умные машины искусственного интеллекта для нейронных сетей на каждом этапе. game в первую очередь, чтобы убедиться, что они предсказывают (и, следовательно, генерируют) правильные текстуры и изображения. Только после завершения этого процесса разработчики могут включить поддержку DLSS.

game в первую очередь, чтобы убедиться, что они предсказывают (и, следовательно, генерируют) правильные текстуры и изображения. Только после завершения этого процесса разработчики могут включить поддержку DLSS.

Тем не менее, судя по тому, что я видел о DLSS до сих пор, это невероятно впечатляющая технология, которая, при достаточном использовании, должна дать картам Nvidia RTX огромное преимущество перед грядущими графическими процессорами Big Navi, особенно если она может компенсировать за падение производительности, вызванное всей этой малярией трассировки лучей.

Nvidia RTX: затенение с переменной скоростью

И последнее, но не менее важное: затенение с переменной скоростью — это еще одна умная технология искусственного интеллекта в картах RTX от Nvidia, которая может обеспечить еще один прирост производительности, помогая поддерживать эти частоты кадров на хорошем и высоком уровне. Он делает это, концентрируя детали сцены там, где они нужны больше всего (скажем, в центре, где вы концентрируете большую часть своего внимания), и уменьшая уровень детализации в других местах, таких как предметы на периферии или более простые фрагменты. геометрия на переднем плане.

геометрия на переднем плане.

В качестве примера представьте себе сцену из Forza Horizon 4. Машина стоит посередине, перед вами простирается чудесная британская сельская местность, справа и слева проносятся поля, а остальные дорога, тянущаяся за тобой.

Синие участки требуют наибольшей детализации, но фиолетовые и красные области сцены менее важны, поэтому Тьюринг может затенять их с меньшей скоростью на лету, чтобы повысить производительность.

Естественно, машина и горизонт находятся в центре вашего внимания, поэтому именно этим битам будет уделено больше всего внимания. Боковые поля менее важны, поэтому они могут иметь вдвое меньшее затенение. Дорога, тем временем, определенно не то, на чем должно быть сосредоточено ваше внимание в этом высокооктановом гонщике, так что он может снова получить вдвое меньше деталей. Конечным результатом является сцена, которая не только выглядит красиво и четко там, где это необходимо, но и обеспечивает более высокую частоту кадров, чем если бы все рендерилось с таким же количеством деталей.

Если вы беспокоитесь, что это может привести к тому, что игры будут выглядеть несколько непоследовательно, не бойтесь. Еще одним примером, который Nvidia показала мне на Gamescom, была зона подводных лодок из Wolfenstein II: The New Colossus. Здесь затенение с переменной скоростью использовалось для разумной оценки того, какие части сцены следует правильно затенить без потери общего качества.

Я играл в живую демоверсию этой технологии на Gamescom, используя ту же сцену в Wolfenstein II, и я тоже не заметил разницы.

Технически называемая «адаптивное затенение контента», это была, пожалуй, одна из самых впечатляющих демонстраций, которые я видел за всю презентацию Nvidia, и разница между ее включением и выключением была почти незаметной. Был смутный эффект ряби, когда я стоял неподвижно, осматривая центр главной диспетчерской, но он полностью исчез в тот момент, когда я начал двигаться. Более того, частота кадров подскочила на 15-20 кадров в секунду, когда я включил его, что довольно впечатляет для почти одинакового качества изображения.

Вывод Nvidia RTX: оно того стоит?

Нельзя отрицать, что технология Nvidia RTX впечатляет. Каждая демоверсия, которую я видел, подтверждает это, как и то, во что я играл и тестировал в реальных играх. Проблема в том, что по-прежнему слишком мало игр, которые на самом деле поддерживают трассировку лучей и/или DLSS, чтобы было целесообразно перейти на одну из карт Nvidia RTX только по этим причинам. На момент написания статьи Battlefield V и Final Fantasy XV были единственными играми, в которые до сих пор была добавлена поддержка RTX, и в настоящее время нет информации о том, когда она появится в других уже выпущенных играх, таких как Shadow of the Tomb Raider. , или будет ли он готов к грядущим блокбастерам, таким как Metro Exodus.

Опять же, я думаю, также будет справедливо сказать, что трассировка лучей и DLSS не кажутся просто мимолетными причудами для этого конкретного поколения видеокарт, и я был бы очень удивлен, если бы поддержка технологии RTX от Nvidia не исчезла.

То же самое касается наличия разъемов под питание карты.

То же самое касается наличия разъемов под питание карты.