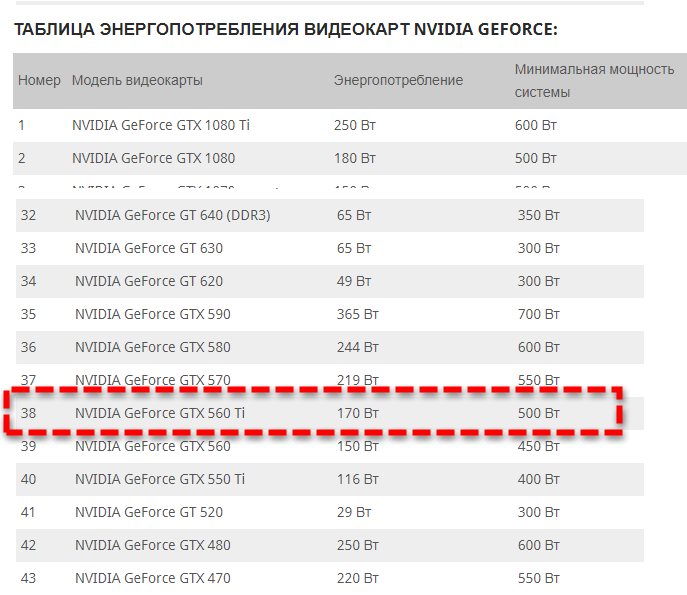

Таблица энергопотребления видеокарт: Энергопотребление видеокарт NVIDIA GeForce (таблица)

Содержание

Энергопотребление видеокарт игровых компьютеров, мощность БП

Для того, чтобы подобрать блок питания компьютера очень важно знать энергопотребление видеокарт и процессоров.

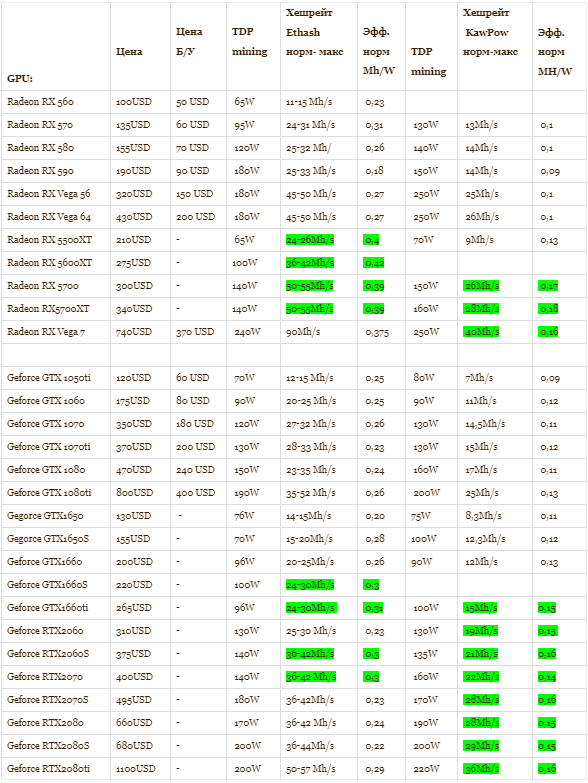

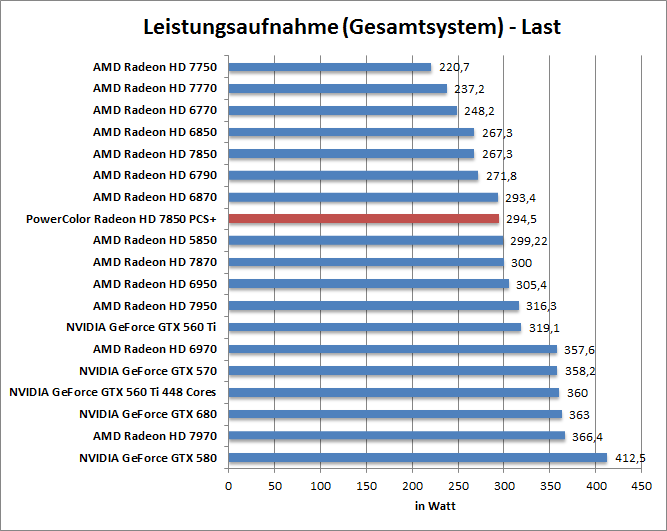

Приводим таблицу энергопотребления видеокарт.

| Видеокарта | Максимальное потребление |

|---|---|

| NVIDIA GeForce GTX 550 Ti 1Gb | 116, рекомендованный ист. пит. min 400W |

| NVIDIA GeForce GTX 650 1Gb | 65W, рекомендованный ист. пит. min 400W |

| NVIDIA GeForce GTX 650 Ti 1Gb | 110W, рекомендованный ист. пит. min 400W |

| NVIDIA GeForce GTX 660 2 Gb | 140W, рекомендованный ист. пит. min 450W |

| NVIDIA GeForce GTX 660 Ti 1Gb | 150W, рекомендованный ист. пит. min 450W |

| NVIDIA GeForce GTX 670 2Gb | 170W, рекомендованный ист. пит. min 500W |

| NVIDIA GeForce GTX 680 2Gb | 300W, рекомендованный ист. пит. min 650W |

| AMD Radeon HD 5750 1Gb | 86W, , рекомендованный ист. пит. min 450W пит. min 450W |

| AMD Radeon HD 5770 1Gb | 108W, рекомендованный ист. пит. min 450W |

| GeForce GTS 450 1Gb | 106, рекомендованный ист. пит. min 400W |

| AMD Radeon HD 5850 1Gb | 151W, рекомендованный ист. пит. min 500W |

| AMD Radeon HD 6850 1Gb | 127, рекомендованный ист. пит. min 500W |

| AMD Radeon HD 6870 1Gb | 151, рекомендованный ист. пит. min 500W |

| GeForce GTX 460 1Gb | 160, рекомендованный ист. пит. min 450W |

| AMD Radeon HD 6950 2Gb | 200W, рекомендованный ист. пит. min 500W |

| AMD Radeon HD 5870 1Gb | 188W, рекомендованный ист. пит. min 500W |

| GeForce GTX 560 1Gb | 170, рекомендованный ист. пит. min 500W |

| GeForce GTX 560 Ti 1Gb | 210, рекомендованный ист. пит. min 550W |

| GeForce GTX 570 Ti 1.3Gb | 219W, рекомендованный ист. пит. min 550W |

| AMD Radeon HD 6970 2Gb | 250W, рекомендованный ист. пит. min 550W пит. min 550W |

| GeForce GTX 470 1.3Gb | 300, рекомендованный ист. пит. min 550W |

| AMD Radeon HD 5970 2Gb | 294W, , рекомендованный ист. пит. min 650W |

| GeForce GTX 580 1.5Gb | 405, рекомендованный ист. пит. min 600W |

| GeForce GTX 480 1.5Gb | 407W, рекомендованный ист. пит. min 600W |

| GeForce GTX 590 3Gb | 365W, рекомендованный ист. пит. min 700W |

| AMD Radeon HD 6990 | 375, рекомендованный ист. пит. min 700W |

| AMD Radeon HD 7970 | 250W,рекомендованный ист. пит. min 500W |

| GeForce GTX 760 | 170W,рекомендованный ист. пит. min 500W |

| GeForce GTX 770 | 230W,рекомендованный ист. пит. min 600W |

| GeForce GTX 780 | 250W,рекомендованный ист. пит. min 600W |

| GeForce GTX 780 Ti | 250W,рекомендованный ист. пит. min 600W |

| GeForce GTX Titan | 250W,рекомендованный ист. пит. min 600W пит. min 600W |

| GeForce GTX 950 | 90W,рекомендованный ист. пит. min 350W |

| GeForce GTX 960 | 120W,рекомендованный ист. пит. min 400W |

| GeForce GTX 970 | 145W,рекомендованный ист. пит. min 500W |

| GeForce GTX 980 | 165W,рекомендованный ист. пит. min 500W |

| GeForce GTX 1060 | 120W,рекомендованный ист. пит. min 450W |

| GeForce GTX 1070 | 150W,рекомендованный ист. пит. min 500W |

| GeForce GTX 1080 | 180W,рекомендованный ист. пит. min 550W |

| GeForce GTX 1650 | 75W,рекомендованный ист. пит. min 300W |

| GeForce GTX 1660 | 120W,рекомендованный ист. пит. min 450W |

| GeForce GTX 1660 Ti | 120W,рекомендованный ист. пит. min 450W |

| GeForce RTX 2060 | 160W,рекомендованный ист. пит. min 500W |

| GeForce RTX 2070 | 175W,рекомендованный ист. пит. min 550W пит. min 550W |

| GeForce RTX 2080 | 225W,рекомендованный ист. пит. min 650W |

| GeForce RTX 2080 Ti | 260W,рекомендованный ист. пит. min 650W |

Эти данные помогут вам правильно рассчитать необходимую мощность блока питания при сборке компьютера.

В мощных видеокартах для питания используются дополнительные разъемы питания. Как правильно рассчитать необходимую мощность дополнительных контактов?

1. PCI-express обеспечивает для видеокарты до 75 Вт.

2. Через 6-контактный разъем дополнительно поступают до 75 Вт мощности.

3. Через 8-контактный разъем дополнительно поступают 150 Вт.

Основное правило. Общая мощность через PCI-express и разъемы питания должна быть больше максимальной мощности потребления видеокарты.

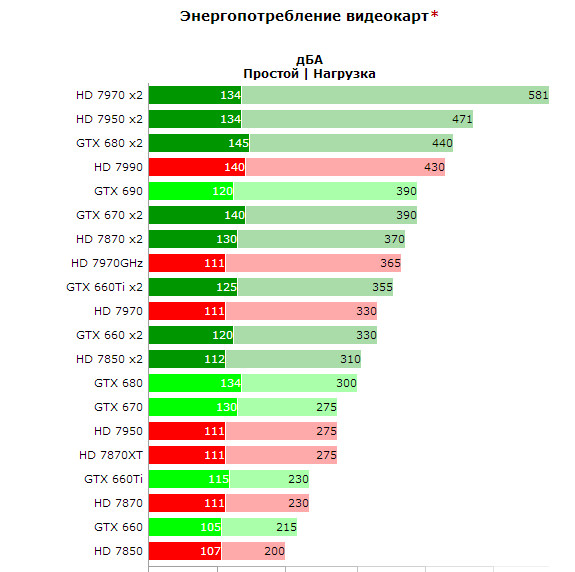

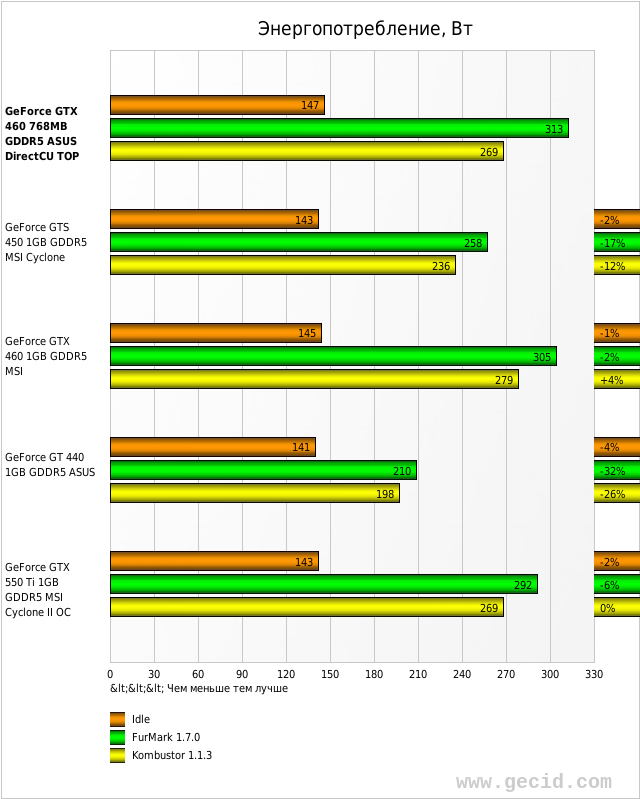

Энергопотребление современных видеокарт. Часть 2: NVIDIA против ATI

Энергопотребление и тепловыделение современных графических плат – вопрос, который интересует почти каждого, кто собирается покупать новую видеокарту или производить более широкую модернизацию своей системы.

В первой части статьи я поднял вопрос энергопотребления видеокарт, постаравшись максимально корректно измерить эту характеристику у плат, основанных на графических процессорах от

ATI. Сегодня, во второй части, будут испытаны графические платы, основанные на чипах от

NVIDIA.

Методика измерения энергопотребления со времени выхода первой части статьи не изменилась – в каждую из цепей питания видеокарты включается шунт, на котором измеряется падение напряжения. По величине падения напряжения и сопротивлению шунта вычисляется потребляемый по каждой из цепей питания ток, а, зная ток и напряжение, потребляемую мощность узнать проще простого. У видеокарт, имеющих разъемы для дополнительного питания, шунт включался как в цепи дополнительного питания…

…так и в цепи питания, идущие через AGP – соответствующие контакты разъема AGP я изолировал, подавая питание в обход разъема:

У плат, питающихся только от разъема AGP, шунт включался, разумеется, только в цепи питания 3. 3В, 5В и 12В, идущие через AGP. Более подробно о методике измерения энергопотребления рассказано в предыдущей части статьи.

3В, 5В и 12В, идущие через AGP. Более подробно о методике измерения энергопотребления рассказано в предыдущей части статьи.

Инструментарий со времени выхода первой части также не изменился: главные участники тестирования – профессиональный цифровой мультиметр UT70-D от UNI-T…:

… и шунт собственного изготовления:

рекомендации

Напомню условия тестирования видеокарт.

Тестовая система и условия тестирования

Платы были протестированы в составе тестовой системы со следующей конфигурацией:

- Процессор: AMD Athlon 64 3400+;

- Материнская плата: ASUS K8V-SE;

- Оперативная память: 2x512MB TwinMOS PC3200 CL2.5

Программное обеспечение:

- Windows XP Pro SP1;

- DirectX 9.0b

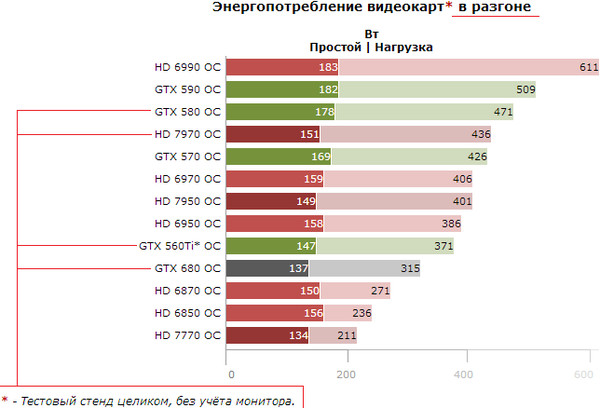

- Драйвер ForceWare версии 61.34

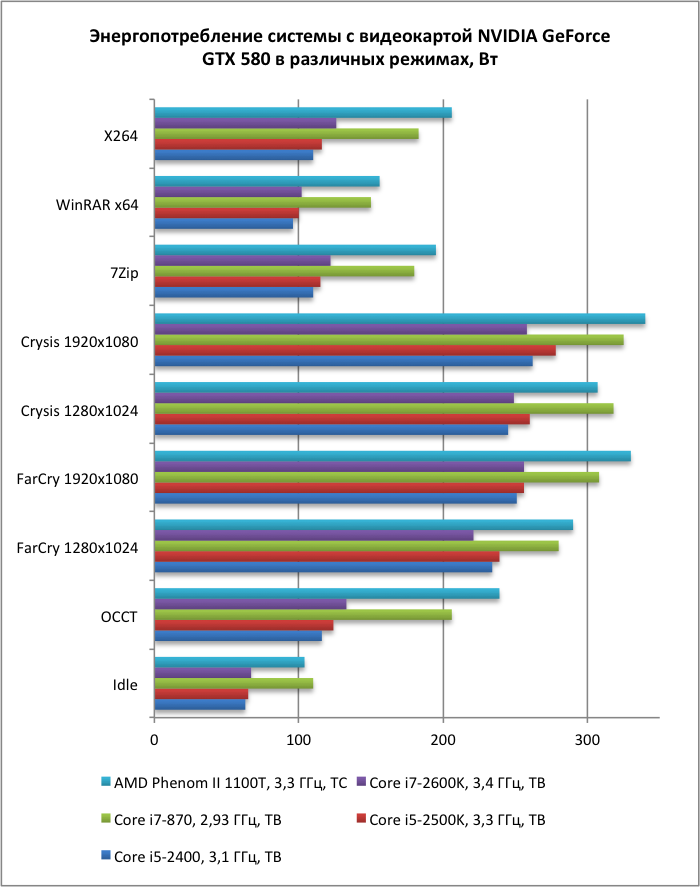

Энергопотребление видеокарт измерялось в двух режимах: «Idle» – «Простой» и «Burn» – «Загрузка». В режиме «Idle» никакие приложения запущены не были, на экране – рабочий стол Windows с россыпью стандартных иконок, видеорежим – 1280х1024х32@75 Гц. Для режима «Burn» была выбрана одна из сцен Far Cry в режиме 1600х1200 при форсировании сглаживания 4х и анизотропной фильтрации 16х (8х на платах семейства GeForce FX). На уровне Training было сделано сохранение игры, которое впоследствии использовалось на всех видеокартах для обеспечения тестирования плат в одинаковых условиях.

Для режима «Burn» была выбрана одна из сцен Far Cry в режиме 1600х1200 при форсировании сглаживания 4х и анизотропной фильтрации 16х (8х на платах семейства GeForce FX). На уровне Training было сделано сохранение игры, которое впоследствии использовалось на всех видеокартах для обеспечения тестирования плат в одинаковых условиях.

NVIDIA GeForce 6800 Ultra

NVIDIA GeForce 6800 Ultra – флагман новой линейки графических процессоров от NVIDIA. Серия чипов GeForce 6800 производится по техпроцессу 0.13 мкм и имеет около 220 млн. транзисторов. Самый скоростной чип, GeForce 6800 Ultra, имеет включенными все 16 пиксельных конвейеров и работает на частоте 400 МГц. Видеокарту на базе GeForce 6800 Ultra представляет Chaintech с моделью Apogee AA6800 Ultra:

Плата выполнена по референс-дизайну: стандартный кулер, накрывающий сразу и графический процессор, и чипы памяти, два разъема для подключения дополнительного питания и радиатор, накрывающий силовые элементы стабилизаторов питания графического процессора и видеопамяти. Плата основана на графическом процессоре NVIDIA GeForce 6800 Ultra и имеет на борту 256 МБ видеопамяти GDDR3. Номинальные частоты графического процессора и видеопамяти составляют 400/1100 МГц. При разгоне частоты поднялись ненамного: до 440/1250 МГц.

Плата основана на графическом процессоре NVIDIA GeForce 6800 Ultra и имеет на борту 256 МБ видеопамяти GDDR3. Номинальные частоты графического процессора и видеопамяти составляют 400/1100 МГц. При разгоне частоты поднялись ненамного: до 440/1250 МГц.

Итак, результаты тестирования:

А вот и первый сюрприз! Еще в первой части статьи я говорил о том, что наличие двух разъемов для подключения дополнительного питания на NVIDIA GeForce 6800 Ultra – не повод для паники. Плата потребляет лишь немногим больше, чем топовая модель от конкурента – ATI RADEON X800 XT Platinum Edition. В режиме загрузки без разгона GeForce 6800 Ultra потребляет 72.09 Вт, в то время как RADEON X800 XT PE – 63.23 Вт. Таким образом, энергопотребление в режиме загрузки у NVIDIA GeForce 6800 Ultra оказывается больше, чем у конкурента, всего лишь на 14%.

В режиме простоя энергопотребление GeForce 6800 Ultra составляет 29.28 Вт против 17.62 Вт у RADEON X800 XT PE. Разница в процентах здесь получается более солидная – флагман новой серии от NVIDIA в режиме простоя потребляет больше, чем соперник, примерно на 66%.

Разница в процентах здесь получается более солидная – флагман новой серии от NVIDIA в режиме простоя потребляет больше, чем соперник, примерно на 66%.

Примечательно, что, в отличие от топовых чипов серии GeForce FX, графические процессоры серии GeForce 6, как и ATI RADEON X800, не используют снижение тактовой частоты и понижение напряжения питания ядра – частота GeForce 6800 Ultra всегда равна 400 МГц, а напряжение, согласно замерам на плате от Chaintech, составляет около 1.45 В.

Что ж, 66% – выглядит страшно, но в абсолютном значении эти 66% составляют примерно те же 10 Вт, что и в режиме загрузки. Плюс-минус десять ватт для нынешних блоков питания – ерунда. Но зачем же в таком случае плате на базе NVIDIA GeForce 6800 Ultra понадобились два разъема для подключения дополнительного питания? Посмотрим на результаты тестирования более подробно:

Интересно: в отличие плат, основанных на серии чипов ATI RADEON X800, NVIDIA GeForce 6800 Ultra практически не нагружает по питанию разъем AGP. В режиме загрузки суммарное потребление по линиям 3.3, 5 и 12 В, идущим через разъем AGP, составляет немногим меньше 5 Вт. Зато по линии 12В, идущей через разъемы дополнительного питания, в режиме загрузки плата потребляет 48.91 Вт – бОльшую часть всей мощности, потребляемой платой. При этом ток в линии 12В составляет 4.22 А – это достаточно много даже для разъема Molex 8981-04.

В режиме загрузки суммарное потребление по линиям 3.3, 5 и 12 В, идущим через разъем AGP, составляет немногим меньше 5 Вт. Зато по линии 12В, идущей через разъемы дополнительного питания, в режиме загрузки плата потребляет 48.91 Вт – бОльшую часть всей мощности, потребляемой платой. При этом ток в линии 12В составляет 4.22 А – это достаточно много даже для разъема Molex 8981-04.

Итак, два разъема для подключения дополнительного питания на NVIDIA GeForce 6800 Ultra установлены, похоже, как раз для того, чтобы повысить надежность работы всей системы, снизив вызываемые видеокартой помехи и просадки напряжения, которые могут неблагоприятно сказаться на других устройствах, подключенных к тем же шлейфам питания, и повысить надежность работы видеокарты, уменьшив вероятность разогрева, подгораний и прочих неприятных результатов плохого контакта в разъемах.

С историей о 480-ваттных блоках питания складывается такая же ситуация: результаты тестирования показали, что в режиме загрузки плата потребляет лишь немногим больше, чем ATI RADEON X800 XT PE, и рекомендация по поводу 480-ваттных блоков питания – не более чем перестраховка. Возможно и то, что первые ревизии плат действительно имели проблемы с потреблением, а здесь же – уже серийный экземпляр. Как бы то ни было, линию +12В видеокарта загружает весьма серьезно, и поэтому для сборки мощной системы с быстрым процессором – а их стабилизаторы неуклонно переходят на питание от линии 12В — потребуется качественный блок питания с хорошим током по цепи +12В.

Возможно и то, что первые ревизии плат действительно имели проблемы с потреблением, а здесь же – уже серийный экземпляр. Как бы то ни было, линию +12В видеокарта загружает весьма серьезно, и поэтому для сборки мощной системы с быстрым процессором – а их стабилизаторы неуклонно переходят на питание от линии 12В — потребуется качественный блок питания с хорошим током по цепи +12В.

NVIDIA GeForce 6800 GT

NVIDIA GeForce 6800 GT – менее скоростные и менее дорогие модели, основанные, тем не менее, на «полноценных» графических процессорах с шестнадцатью пиксельными конвейерами и укомплектованные памятью GDDR3. В сегодняшнем тестировании GeForce 6800 GT представляет Leadtek и модель WinFast A400 GT TDH:

Эта видеокарта выполнена по тому же дизайну, что и NVIDIA GeForce 6800 Ultra, но, в отличие от более быстрой модели, имеет всего один разъем для подключения дополнительного питания. Основа платы – графический процессор NVIDIA GeForce 6800 GT и 256 МБ видеопамяти GDDR3. Номинальные тактовые частоты составляют 350/1000 МГц. Разгонный потенциал платы. что неудивительно, оказался выше, чем у более скоростной модели. Частоты графического процессора и видеопамяти при разгоне составили 420/1150 МГц – выше, чем номинальные частоты GeForce 6800 Ultra.

Номинальные тактовые частоты составляют 350/1000 МГц. Разгонный потенциал платы. что неудивительно, оказался выше, чем у более скоростной модели. Частоты графического процессора и видеопамяти при разгоне составили 420/1150 МГц – выше, чем номинальные частоты GeForce 6800 Ultra.

Результаты измерения энергопотребления:

GeForce 6800 GT потребляет намного меньше, чем GeForce 6800 Ultra: 55.39 Вт в режиме загрузки и 23.41 Вт в простое. Уменьшение энергопотребления складывается из двух факторов: во-первых, GeForce 6800 GT имеет более низкие тактовые частоты графического процессора и видеопамяти, а во-вторых, напряжение питания графического процессора также понижено: согласно замерам на плате от Leadtek, оно составляет около 1.35 В вместо 1.45 В у GeForce 6800 Ultra. Понижение напряжения питания особенно заметно по величине энергопотребления при разгоне: несмотря на то, что частоты платы превзошли номинальные частоты GeForce 6800 Ultra, энергопотребление GeForce 6800 GT осталось на более низком уровне.

Характер энергопотребления GeForce 6800 GT остался таким же, как у GeForce 6800 Ultra: плата практически не нагружает разъем AGP, забирая львиную долю мощности по цепи +12В:

В сравнении с конкурентом, ATI RADEON X800 Pro, GeForce 6800 GT имеет лишь немногим более высокое энергопотребление, причем, разница в величинах уже не столь высока, как разница между топовыми моделями. В режиме загрузки GeForce 6800 GT потребляет 55.39 Вт, в то время как RADEON X800 Pro – 48.2 Вт, а в режиме простоя эти платы потребляют, соответственно, 23.41 и 15.1 Вт.

NVIDIA GeForce 6800

NVIDIA GeForce 6800 – самая медленная модель, основанная на архитектуре NV40. GeForce 6800 использует те же кристаллы, что и более производительные модели, но имеет лишь 12 включенных пиксельных конвейеров из 16. Помимо этого, GeForce 6800 имеет пониженные тактовые частоты по сравнению с GeForce 6800 GT. NVIDIA GeForce 6800 представляет плата Galaxy Glacier GeForce 6800:

Дизайн видеокарт на основе GeForce 6800 отличается от дизайна GeForce 6800 GT/Ultra. Плата от Galaxy вместо стандартной системы охлаждения использует кулер от Arctic Cooling, очень похожий на систему охлаждения платы HIS Excalibur RADEON X800 Pro, принявшей участие в первой части статьи. Плата основана на чипе NVIDIA GeForce 6800 и, в отличие от более производительных моделей, использующих память GDDR3, имеет 256 МБ видеопамяти в обычных микросхемах DDR SDRAM.

Плата от Galaxy вместо стандартной системы охлаждения использует кулер от Arctic Cooling, очень похожий на систему охлаждения платы HIS Excalibur RADEON X800 Pro, принявшей участие в первой части статьи. Плата основана на чипе NVIDIA GeForce 6800 и, в отличие от более производительных моделей, использующих память GDDR3, имеет 256 МБ видеопамяти в обычных микросхемах DDR SDRAM.

Номинальные частоты видеокарты составляют 350/700 МГц – как видите, частота ядра на этой плате оказалась изначально поднята на 25 Мгц выше рекомендованной для GeForce 6800 частоты 325 МГц. При разгоне видеопамять показала хорошее увеличение частоты, а графический процессор, несмотря на использование очень качественной системы охлаждения – не очень: частоты платы при разгоне составили 375/900 МГц.

Результаты тестирования:

NVIDIA GeForce 6800 потребляет еще меньше, чем GeForce 6800 GT, и это неудивительно: у младшей модели понижены частоты и снижено напряжение питания графического процессора. На плате от Galaxy оно составляет примерно 1.22 В, в то время как у GeForce 6800 GT – около 1.35 В. В результате без разгона плата в режиме простоя потребляет 16.96 Вт, а под нагрузкой – всего 38.88 Вт.

На плате от Galaxy оно составляет примерно 1.22 В, в то время как у GeForce 6800 GT – около 1.35 В. В результате без разгона плата в режиме простоя потребляет 16.96 Вт, а под нагрузкой – всего 38.88 Вт.

Результаты в виде таблицы:

Стабилизаторы питания графического процессора и видеопамяти на NVIDIA GeForce 6800 построены иначе, нежели на старших моделях. Это видно как по изменению дизайна платы, так и по величинам токов потребления. GeForce 6800 нагружает AGP более активно, чем даже GeForce 6800 Ultra, потребляя в сумме по линиям 3.3, 5 и 12 В, идущим через разъем AGP, более 7 Вт в режиме загрузки. Впрочем, основная нагрузка ложится, по-прежнему, на линию 12В, идущую через разъем дополнительного питания – в режиме загрузки потребление по этой линии доходит до 23.62 Вт при токе 2.01 А.

NVIDIA GeForce FX 5950 Ultra

NVIDIA GeForce FX 5950 Ultra – топовый графический процессор предыдущего поколения от NVIDIA. Производится по технологии 0.13 мкм и содержит около 135 миллионов транзисторов. Видеокарту на основе NVIDIA GeForce FX 5950 Ultra представляет MSI с моделью FX5950 Ultra-VTD256:

Производится по технологии 0.13 мкм и содержит около 135 миллионов транзисторов. Видеокарту на основе NVIDIA GeForce FX 5950 Ultra представляет MSI с моделью FX5950 Ultra-VTD256:

Плата выполнена по референс-дизайну, но этого не видно за мощной системой охлаждения, состоящей из трех частей: кулера, накрывающего графический процессор и чипы памяти на лицевой стороне, и кулера с радиаторами, отводящими тепло, соответственно, от поверхности платы и от чипов памяти с другой стороны.

Номинальные частоты платы в 3D-режиме составляют 475/950 МГц, а в режиме простоя – 300/950 МГц. Соответственно, результаты тестирования в режиме простоя, несмотря на то, что в номинале указаны частоты 470/950 МГц, соответствуют работе на частотах 300/950 МГц – плата (точнее, драйвер) управляет частотами самостоятельно, и здесь нет резона вмешиваться.

Результаты измерения энергопотребления:

Вот это результаты! NVIDIA GeForce FX 5950 Ultra в режиме загрузки имеет самое высокое энергопотребление среди всех плат, протестированных в первой и второй частях статьи!

Что ж, по величине энергопотребления прекрасно видно, какой ценой в свое время далась NVIDIA установка настолько высокой тактовой частоты. Под нагрузкой плата имеет более высокое энергопотребление по сравнению даже с NVIDIA GeForce 6800 Ultra, платой, которая по скорости намного опережает GeForce FX 5950 Ultra. Вместе с тем интересно, что в режиме простоя плата потребляет заметно меньше, чем GeForce 6800 Ultra – в отличие от чипов нового поколения GeForce FX5950 Ultra в режиме простоя снижает тактовую частоту и величину напряжения питания графического процессора.

Под нагрузкой плата имеет более высокое энергопотребление по сравнению даже с NVIDIA GeForce 6800 Ultra, платой, которая по скорости намного опережает GeForce FX 5950 Ultra. Вместе с тем интересно, что в режиме простоя плата потребляет заметно меньше, чем GeForce 6800 Ultra – в отличие от чипов нового поколения GeForce FX5950 Ultra в режиме простоя снижает тактовую частоту и величину напряжения питания графического процессора.

Стабилизатор питания графического ядра на платах с NVIDIA GeForce FX 5950 Ultra умеет изменять напряжение питания, следуя командам драйвера – в режиме простоя напряжение питания снижается, а при старте 3D-приложения оно увеличивается. В случае возникновения перегрева ядра напряжение питания графического процессора и его тактовая частота опускаются до значений, находящихся между значениями для 2D и 3D режимов – включается так называемый «Low power 3D» режим.

Согласно показаниям RivaTuner, драйвер Detonator версии 61.24 для GeForce FX 5950 Ultra устанавливает величину напряжения питания в режиме загрузки на уровне 1. 5 В, а в режиме простоя – 1.2 В. Реальные величины на плате от MSI, как показали замеры, составили 1.217 и 1.577 В.

5 В, а в режиме простоя – 1.2 В. Реальные величины на плате от MSI, как показали замеры, составили 1.217 и 1.577 В.

Итак, NVIDIA GeForce FX 5950 Ultra потребляет больше, чем GeForce 6800 Ultra. Почему же при появлении этих видеокарт не было столько шума вокруг блоков питания? Посмотрим на более подробные результаты тестирования:

В отличие от плат на чипах серии GeForce 6, NVIDIA GeForce FX 5950 Ultra нагружает цепи питания более равномерно и «щадит» линию +12 В, традиционно наиболее загруженную другими компонентами системы: в режиме «burn» токи по линиям 12В, 5В и по линии 3.3 В, идущей через разъем AGP, составляют, соответственно, 4.92, 2.29 и 5.59 А. Наибольший ток наблюдается в линии 3.3В, как правило, наименее загруженной.

Примечательно, что при этом величина тока в линии 3.3В приближается к максимально допустимой величине, диктуемой спецификациями AGP – 6 А, а при разгоне даже превышает этот предел, поднимаясь до 6. 05 А. Впрочем, это, похоже, не повод для беспокойства: о возникновении каких-либо связанных с этим проблем ничего не слышно до сих пор.

05 А. Впрочем, это, похоже, не повод для беспокойства: о возникновении каких-либо связанных с этим проблем ничего не слышно до сих пор.

NVIDIA GeForce FX 5900 Ultra

NVIDIA GeForce FX 5900 Ultra – предшественник GeForce FX 5950 Ultra в секторе самых производительных видеокарт – речь идет, разумеется, не о настоящем моменте, а о тех временах, когда именно эти платы были самыми скоростными представителями видеокарт на чипах от NVIDIA. Архитектурно GeForce FX 5900 Ultra от предыдущего графического процессора не отличается. Более того, GeForce FX 5950 Ultra, по сути, являлся ничем иным, как «официально разогнанной» модификацией GeForce FX 5900 Ultra.

Видеокарту на основе NVIDIA GeForce FX 5900 Ultra представляет референс-плата от NVIDIA:

Видеокарта основана на графическом процессоре NVIDIA GeForce FX 5900 Ultra и оснащена 256 МБ видеопамяти в чипах DDR SDRAM. Номинальные тактовые частоты платы в 3D-режиме составляют 450/850 МГц. Разгонный потенциал этого экземпляра не впечатлил. Совсем. 455/880 МГц при разгоне – это несерьезно.

Разгонный потенциал этого экземпляра не впечатлил. Совсем. 455/880 МГц при разгоне – это несерьезно.

Результаты измерения энергопотребления:

GeForce FX 5900 Ultra потребляет меньше, чем GeForce FX 5950 Ultra. Это понятно: во-первых, GeForce FX 5900 Ultra работает на более низких частотах, а во-вторых, графический процессор по сравнению с GeForce FX 5950 Ultra имеет более низкое напряжение питания в 3D-режиме — для режимов 2D/3D драйвер устанавливает напряжения 1.2/1.4 В. При этом реальные выходные напряжения стабилизатора питания графического процессора на плате составляют 1.235/1.449 В.

По характеру потребления GeForce FX 5900 Ultra отличается от GeForce FX 5950 Ultra:

Как и видеокарты на чипах серии GeForce 6, GeForce FX 5900 Ultra бОльшую часть энергии потребляет по линии +12В, идущей через разъем дополнительного питания.

NVIDIA GeForce FX 5700 Ultra

NVIDIA GeForce FX 5700 Ultra – самый быстрый из чипов, изначально разработанных для применения на видеокартах среднего класса. Сейчас, с появлением графических процессоров серии GeForce 6, в средний класс начинают перемещаться платы на чипах GeForce FX 5900/5950, смещая GeForce FX 5700 Ultra еще ниже, а с появлением GeForce 6600, новых графических процессоров среднего класса, дни GeForce FX 5700 Ultra будут сочтены.

Сейчас, с появлением графических процессоров серии GeForce 6, в средний класс начинают перемещаться платы на чипах GeForce FX 5900/5950, смещая GeForce FX 5700 Ultra еще ниже, а с появлением GeForce 6600, новых графических процессоров среднего класса, дни GeForce FX 5700 Ultra будут сочтены.

Видеокарту на основе GeForce FX 5700 Ultra представляет модель Tornado GeForce FX 5700 Ultra от Inno3D:

Видеокарта выполнена по референс-дизайну и отличается от эталонных моделей только формой и расцветкой пластинки, накрывающей кулер. Плата основана на графическом процессоре NVIDIA GeForce FX 5700 Ultra и оснащена 128 МБ видеопамяти в чипах DDR-II. Номинальные частоты графического процессора и видеопамяти в 3D-режиме составляют 475/900 МГц. При разгоне частоты видеокарты составили 530/1000 МГц – средний результат для GeForce FX 5700 Ultra.

Результаты измерения энергопотребления:

Не стоит удивляться столь высоким величинам энергопотребления у платы среднего класса. Львиная доля потребления здесь приходится не на графический процессор, а на видеопамять – на плате используются чипы DDR-II, известные своей прожорливостью. Высокое энергопотребление и тепловыделение – одна из причин, из-за которых память DDR-II не нашла широкого применения на видеокартах, и ее очень быстро сменили гораздо более экономичные чипы GDDR3. К слову, использующая память GDDR3 плата на основе NVIDIA GeForce 6800, чью производительность даже как-то неудобно сравнивать со скоростью GeForce FX 5700 Ultra, имеет меньшее энергопотребление и тепловыделение, как в режиме простоя, так и в загрузке.

Львиная доля потребления здесь приходится не на графический процессор, а на видеопамять – на плате используются чипы DDR-II, известные своей прожорливостью. Высокое энергопотребление и тепловыделение – одна из причин, из-за которых память DDR-II не нашла широкого применения на видеокартах, и ее очень быстро сменили гораздо более экономичные чипы GDDR3. К слову, использующая память GDDR3 плата на основе NVIDIA GeForce 6800, чью производительность даже как-то неудобно сравнивать со скоростью GeForce FX 5700 Ultra, имеет меньшее энергопотребление и тепловыделение, как в режиме простоя, так и в загрузке.

Более подробные результаты:

Никаких сюрпризов. Основная часть потребления приходится на линию +12В, идущую через разъем дополнительного питания, ток в этой линии в режиме «burn» составляет 2.11 А.

NVIDIA GeForce FX 5700

NVIDIA GeForce FX 5700 – менее дорогой, но и менее производительный, чем FX 5700 Ultra, представитель «бывшего среднего класса» видеокарт. На видеокарты, основанные на GeForce FX 5700, устанавливаются обычные чипы памяти DDR SDRAM, которые прекрасно обходятся без принудительного охлаждения. В силу всех этих качеств, видеокарты на основе GeForce FX 5700 стали намного более популярны по сравнению с их «Ultra»-аналогами.

На видеокарты, основанные на GeForce FX 5700, устанавливаются обычные чипы памяти DDR SDRAM, которые прекрасно обходятся без принудительного охлаждения. В силу всех этих качеств, видеокарты на основе GeForce FX 5700 стали намного более популярны по сравнению с их «Ultra»-аналогами.

Плату на основе GeForce FX 5700 представляет модель WinFast A360 TDH MyVIVO от Leadtek:

Видеокарта не имеет разъема для подключения дополнительного питания, а система охлаждения отводит тепло только от графического процессора. Номинальные тактовые частоты платы – они одинаковы в 2D- и 3D-режиме – составляют 425/550 МГц. При разгоне плата показала неплохой рост частот: 470/660 МГц.

Результаты измерения энергопотребления:

Два фактора: понижение тактовых частот и отказ от применения DDR-II, в совокупности дают отличный результат – видеокарта потребляет почти вдвое меньше по сравнению с GeForce FX 5700 Ultra. Что примечательно, в случае NVIDIA GeForce FX 5700 даже не пришлось применять разделение частоты и напряжения питания графического процессора на режимы 2D и 3D – частота ядра составляет 425 МГц, а напряжение питания, как показали замеры – около 1. 43 В.

43 В.

Более подробные результаты измерений:

Основная нагрузка ложится на линию питания 3.3 В, ток потребления в режиме «burn» составляет 3.96 A, а потребляемая по линии 3.3 В мощность – 12.36 Вт. По нынешним меркам – более чем скромно.

Заключение – NVIDIA: сводные результаты измерений

Итак, пришла пора подвести итоги. Для начала – общая диаграмма с результатами измерения энергопотребления видеокарт на чипах от NVIDIA:

На этой диаграмме прекрасно видно, что с выходом графических процессоров нового поколения от NVIDIA энергопотребление топовых видеокарт не только не увеличилось, но даже уменьшилось. Отличный результат!

Впрочем, не всё так хорошо: новые видеокарты на чипах от NVIDIA имеют несбалансированный характер потребления. Самые мощные платы достаточно серьезно нагружают линию +12В, и именно поэтому, а не из-за величины энергопотребления, перед приобретением таких плат стоит критически оценить возможности того БП, что установлен в системе, или отнестись ответственнее к подбору нового блока питания.

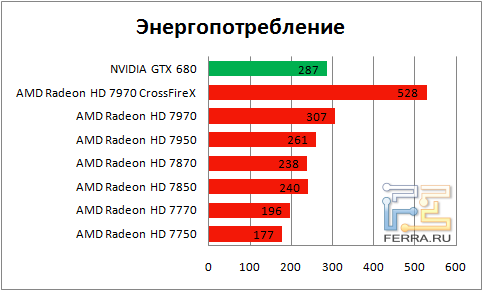

Заключение – ATI: сводные результаты измерений

В первой части статьи я не привел сводную диаграмму результатов энергопотребления видеокарт на чипах от ATI. Исправляюсь:

Новые графические процессоры от ATI серии X800 имеют лишь ненамного более высокое энергопотребление по сравнению с графическими процессорами предыдущего поколения. Новые видеокарты на чипах от ATI имеют более «сбалансированный» характер энергопотребления, поэтому при покупке новой видеокарты особых проблем при наличии не слишком мощного, но качественного блока питания быть не должно.

Энергопотребление: NVIDIA против ATI

Наконец, сводная диаграмма результатов измерения энергопотребления в стиле «NVIDIA против ATI». Для удобства восприятия я привожу результаты только без разгона:

Видеокарты на чипах от ATI в целом имеют меньшее энергопотребление в сравнении с конкурирующими платами, основанными на графических процессорах от NVIDIA. Однако, разница в энергопотреблении, по-моему, не настолько высока, чтобы при выборе платы это стало более серьезным аргументом, чем ее цена и скорость. Единственная проблема, касающаяся энергопотребления видеокарт на новых чипах от NVIDIA – большая нагрузка на линию +12В. В связи с этим при покупке подобных плат стоит более критично оценить возможности блока питания.

Однако, разница в энергопотреблении, по-моему, не настолько высока, чтобы при выборе платы это стало более серьезным аргументом, чем ее цена и скорость. Единственная проблема, касающаяся энергопотребления видеокарт на новых чипах от NVIDIA – большая нагрузка на линию +12В. В связи с этим при покупке подобных плат стоит более критично оценить возможности блока питания.

С другой стороны, видеокарты класса NVIDIA GeForce 6800/GT/Ultra и RADEON X800 XT/Pro, учитывая их стоимость, ставятся, как правило, в мощные игровые системы, а там эти видеокарты являются не единственными мощными потребителями – топовые современные процессоры даже без разгона имеют как минимум не меньшее, а зачастую намного более высокое энергопотребление. Поэтому вполне вероятно, что при модернизации системы, замены блока питания в первую очередь потребует отнюдь не только что приобретенная видеокарта.

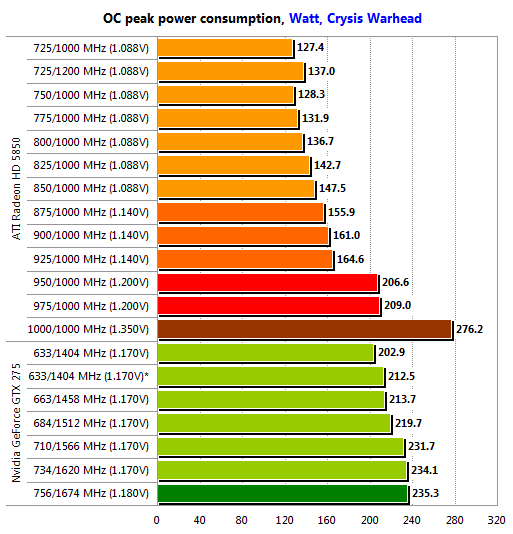

Что касается разгона, то, судя по результатам тестов, как у видеокарт, основанных на чипах от ATI, так и у плат на графических процессорах от NVIDIA разгон увеличивает энергопотребление весьма незначительно – рост частот оказывается выше, чем связанное с ним увеличение энергопотребления. Таким образом, если касаться только такой характеристики платы, как энергопотребление, то в этом плане разгон оказывается сравнительно безопасным занятием – если блок питания уверенно работает в системе с неразогнанной платой, то можно с определенной долей уверенности сказать, что и при разгоне видеокарты проблем не возникнет.

Таким образом, если касаться только такой характеристики платы, как энергопотребление, то в этом плане разгон оказывается сравнительно безопасным занятием – если блок питания уверенно работает в системе с неразогнанной платой, то можно с определенной долей уверенности сказать, что и при разгоне видеокарты проблем не возникнет.

В ближайшее время появятся платы на новых графических процессорах, разработанных для современных видеокарт среднего уровня – сейчас платами такого класса можно назвать весьма «прожорливые» графические карты на топовых чипах предыдущего поколения. Появление NVIDIA NV43, или GeForce 6600/6600GT, и ATI RV410, чье маркетинговое название еще неизвестно, должно изменить ситуацию с энергопотреблением плат среднего уровня – новые чипы изготавливаются по новым технологическим нормам и имеют все шансы оказаться экономными и «холодными».

Ждём Ваших комментариев в специально созданной ветке конференции.

Подпишитесь на наш канал в Яндекс. Дзен или telegram-канал @overclockers_news — это удобные способы следить за новыми материалами на сайте. С картинками, расширенными описаниями и без рекламы.

Дзен или telegram-канал @overclockers_news — это удобные способы следить за новыми материалами на сайте. С картинками, расширенными описаниями и без рекламы.

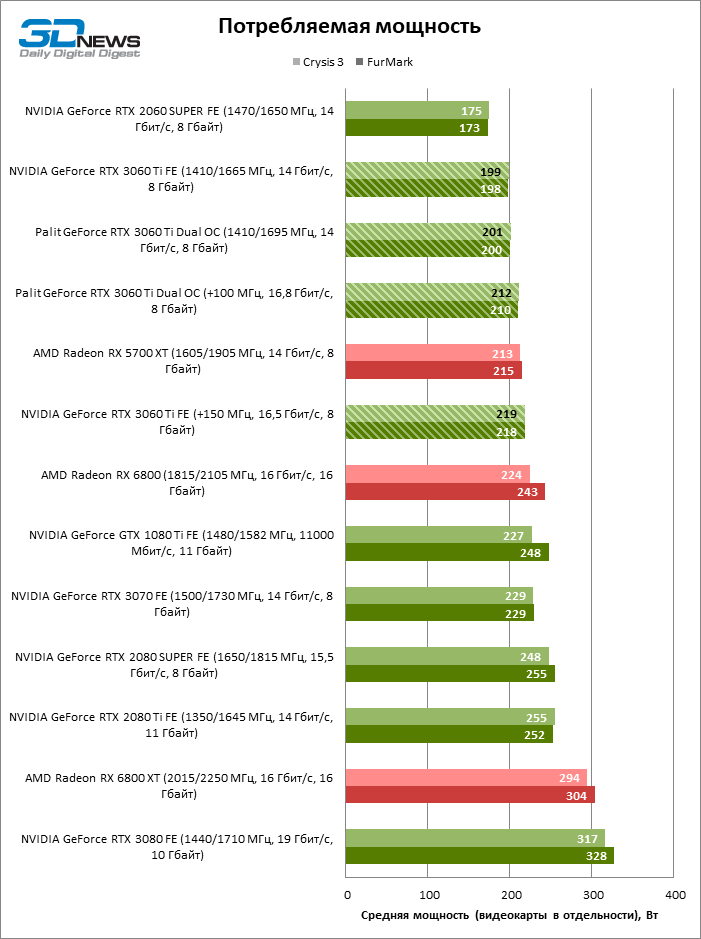

Более низкое энергопотребление — огромная победа Nvidia RTX 4080

МНЕНИЕ: Один мудрый человек однажды сказал, что «с большой мощностью приходят более дорогие счета за электроэнергию», но это следствие, которое вы должны принять при обновлении своей видеокарты.

Общепризнанно, что более мощные компоненты потребляют больше энергии, и опыт Nvidia с видеокартами показал именно это.

Nvidia RTX 2080 имеет мощность видеокарты 225 Вт, при этом Nvidia рекомендует минимальную мощность системы 650 Вт. Последующая карта RTX 3080 (12 ГБ) показала, что мощность видеокарты увеличилась до 350 Вт, а рекомендуемая мощность системы составила колоссальные 750 Вт.

В результате неудивительно, что многие отчеты предполагают, что Nvidia еще больше увеличит энергопотребление для грядущей серии RTX 4000. Это было особенно тревожно, учитывая, что растущие затраты на энергию в настоящее время загоняют в долги бесчисленное количество людей.

Это было особенно тревожно, учитывая, что растущие затраты на энергию в настоящее время загоняют в долги бесчисленное количество людей.

Но, к моему удивлению, Nvidia каким-то образом удалось снизить энергопотребление Nvidia RTX 4080 по сравнению с предыдущим поколением.

| Nvidia RTX 3080 | Nvidia RTX 4080 | |

| Мощность видеокарты | От 320 Вт | От 285 Вт |

| Требуемая мощность системы | 75 0 Вт | От 700 Вт |

RTX 4080 (16 ГБ) имеет только мощность видеокарты 320 Вт, а рекомендуемая мощность системы 750 Вт. Между тем, RTX 4080 (12 ГБ) демонстрирует низкую мощность видеокарты 285 Вт, что снижает рекомендуемую мощность системы до 700 Вт.

Конечно, здесь речь идет о небольшой марже, которая, вероятно, не окажет существенного влияния на ваш счет за электроэнергию, но все же это фантастический шаг в правильном направлении. Я рад видеть, что Nvidia пытается сделать свои компоненты более энергоэффективными, а не просто наращивать производительность за счет всего остального.

Это невероятно впечатляющее достижение, если учесть, что Nvidia не сдерживала повышения производительности. Nvidia RTX 4080, по-видимому, в 2-4 раза быстрее, чем RTX 3080 Ti. Это неудивительно, поскольку новый графический процессор содержит так много ядер CUDA, более высокую тактовую частоту и больше памяти, чем его предшественник. Но тот факт, что Nvidia смогла сделать все это, одновременно снизив энергопотребление, просто невероятен.

Nvidia не упомянула об этом улучшении энергоэффективности в основной презентации, вместо этого похваставшись улучшениями, внесенными в такие функции, как трассировка лучей и DLSS. Я могу понять эту тактику, поскольку эффективность энергопотребления просто не так интересна для среднего игрока, как прорывные достижения в области искусственного интеллекта и методов визуализации света.

Но от этого энергоэффективность не становится менее важной. Это не только удобно для экономии на счетах за электроэнергию и предотвращения необходимости модернизации блока питания, но и полезно для окружающей среды, поскольку немного снижает потребность в ископаемом топливе.

Тем не менее, несмотря на все похвалы, которые я воздаю Nvidia за RTX 4080, я также должен отметить, что в семействе RTX 4000 все еще есть одно плохое яблоко. Nvidia RTX 4090 не обманула ожиданий, как ее меньший брат, вместо этого увидев ошеломляющую мощность видеокарты 450 Вт и рекомендуемую системную мощность 850 Вт — это увеличение на 100 Вт по сравнению с RTX 309.0.

Таким образом, Nvidia еще предстоит пройти долгий путь, если она хочет получить одобрение эксперта по счетам за электроэнергию Мартина Льюиса или эковоина Греты Тунберг. Но я надеюсь, что RTX 4090 является исключением из правил, и что Nvidia продолжит свои попытки снизить энергопотребление с оставшейся частью семейства 4000-й серии.

В связи с тем, что наше повседневное энергопотребление становится все более и более актуальной темой, у Nvidia самое время продемонстрировать свои достижения в области энергоэффективности графического процессора. Это может не удивить публику, как эффекты гонок на лучах в Cyberpunk 2077, но я уверен, что это все равно будет важным фактором, когда геймеры захотят обновить свой игровой ПК этой зимой.

Бывший штатный обозреватель Stuff Magazine, Райан пишет о технологиях с тех пор, как окончил Кардиффский университет. В Trusted Reviews он сосредоточен на всем, что связано с компьютерами, что дает ему ва…

Зачем доверять нашей журналистике?

Основанная в 2003 году, Trusted Reviews существует для того, чтобы давать нашим читателям исчерпывающие, непредвзятые и независимые советы о том, что покупать.

Сегодня у нас есть миллионы пользователей в месяц со всего мира, и мы оцениваем более 1000 продуктов в год.

Редакционная независимость

Редакционная независимость означает способность выносить непредвзятый вердикт о продукте или компании, избегая конфликта интересов. Чтобы это было возможно, каждый член редакции следует четкому кодексу поведения.

Профессиональное поведение

Мы также ожидаем от наших журналистов соблюдения четких этических норм в своей работе. Наши сотрудники должны стремиться к честности и точности во всем, что они делают. Мы следуем своду правил редакторов IPSO, чтобы поддерживать эти стандарты.

Наши сотрудники должны стремиться к честности и точности во всем, что они делают. Мы следуем своду правил редакторов IPSO, чтобы поддерживать эти стандарты.

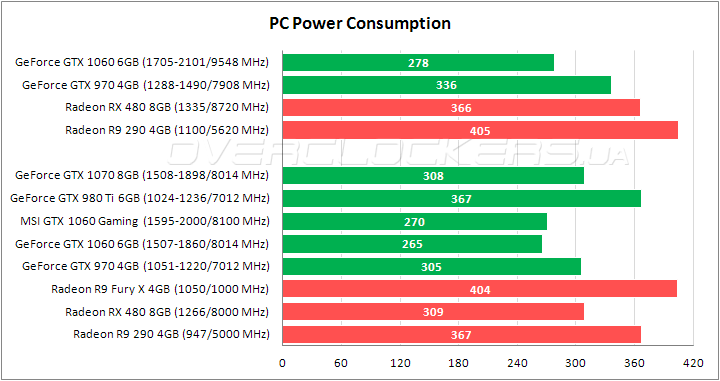

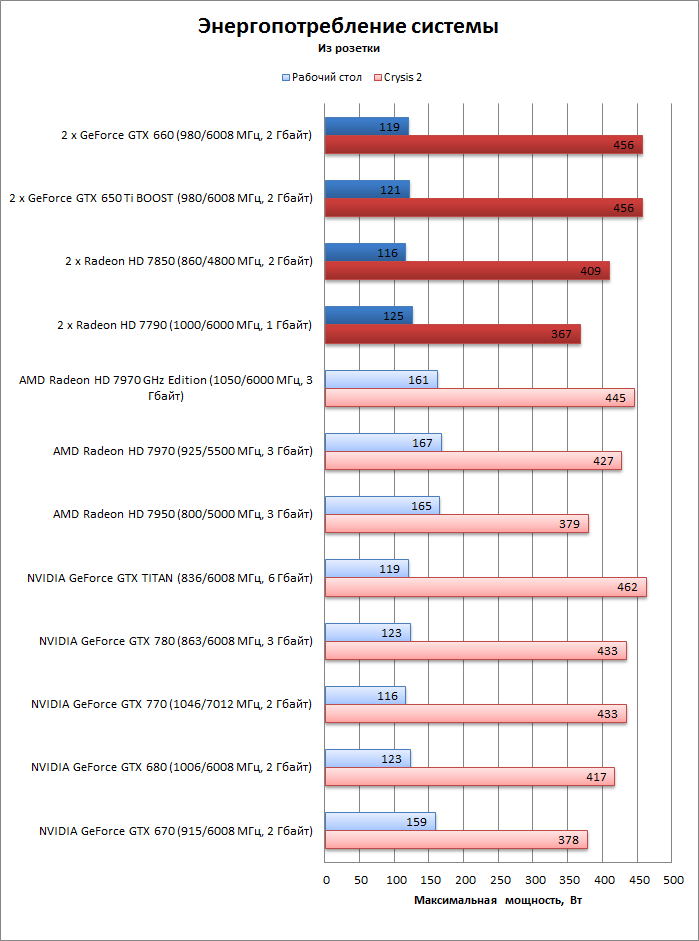

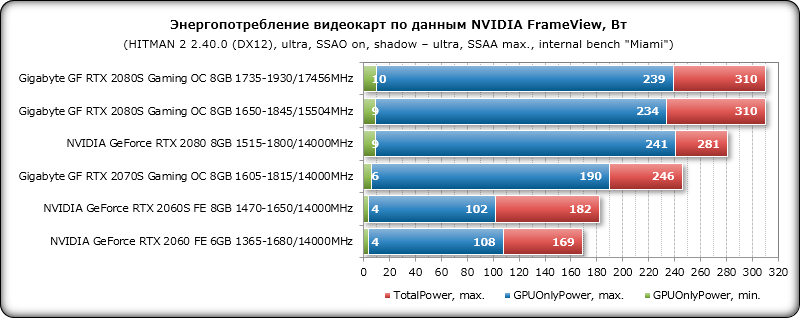

Суммарная мощность платы (TBP) в сравнении с реальным энергопотреблением и неадекватность программных средств в сравнении с реальными измерениями

Поскольку многие пользователи, особенно пользователи YouTube и твитчеры, по-прежнему используют значения таких инструментов, как MSI Afterburner или программное обеспечение AMD Radeon для энергопотребление их видеокарты по номиналу, я должен кое-что добавить. Огромное количество видеороликов, которые должны показать, насколько «экономичнее» видеокарта A должна быть по сравнению с видеокартой B, до сих пор заставляет тех, кто знает (и может) лучше, плакать подряд. Забавное примечание: даже NVIDIA распространяет PCAT, инструмент, который помогает узнать правду о энергопотреблении графических карт среди редакторов и соответствующих создателей видео сегодня. Однако, к сожалению, пока это было менее полезным.

Поскольку постоянно возникали вопросы о том, почему значения, которые я измерял в играх, так сильно отклонялись от спецификаций производителя (TBP) для всей видеокарты, я немного переработал существующую статью и добавил перед ней новую главу. Здесь я сначала анализирую 11 игр с нагрузкой трассировки лучей и без нее в Ultra-HD для наиболее актуальных карт, которые мы также знаем еще из стартовой статьи о NVIDIA GeForce RTX 4090 24 ГБ. Потому что результат довольно интересный. В отличие от предыдущего теста, я запустил кастомную Radeon RX 69.50XT с эталонным BIOS, потому что в противном случае это немного исказило бы измерения.

После этого вступления мы также в первую очередь рассмотрим подход к решению обоих производителей с точки зрения определения и регистрации энергопотребления, поскольку здесь еще многое предстоит наверстать. Программные инструменты и карты AMD всегда были мучительной проблемой, но об этом позже. Конечно, вы можете правильно измерить Radeon на блоках питания, но вы не сможете их чисто прочитать. К сожалению, все инструменты отображают не все, что проходит через линии. Но об этом на следующей странице.

К сожалению, все инструменты отображают не все, что проходит через линии. Но об этом на следующей странице.

Карта на 450 Вт не равна карте на 450 Вт!

Глядя на первый график, мы видим, что GeForce RTX 3090 Ti — это карта с настоящим пределом мощности 450 Вт (TBP), которая, к сожалению, полностью достигает этого энергопотребления даже в играх. Однако так часто (совершенно несправедливо) ругаемая GeForce RTX 4090 — это скорее карта на 380 Вт в играх, которая вообще использует доступный запас производительности только при запуске стресс-тестов или чистых вычислений на шейдерах!

В Ada NVIDIA встроила экстремальный буфер, в отличие от собственных карт Ampere и AMD, которые может достигать местами, но обычно достигается не во всех приложениях. Каждая игра уникальна, и есть экстремальные примеры, требующие высокой производительности. Но во всем диапазоне приложений средние значения всегда являются наиболее объективной констатацией. Ведь в реальной жизни не всегда едешь круто в гору.

Для всех остальных карт заявленные производителем показатели энергопотребления в играх UHD очень близки или даже немного превышают заявленные TBP при нагрузке на GPU от 98 до 99% (последние три карты в диаграммах ниже). Но это отклонения в низком однозначном процентном диапазоне. Для еще не выпущенной GeForce 4080 16GB вы можете вытащить калькулятор только из соображений NDA и сопоставить TBP и реальное измерение. Тогда для этой новой карты в играх будет 274 Вт, для которой указано 320 Вт. Этого будет недостаточно, потому что частота чипа должна быть выше из-за меньшего размера и количества шейдеров, что делает его немного менее эффективным. Тем не менее, это вполне может быть около 280 Вт. Чисто умозрительно.

Поскольку до сих пор карты AMD всегда достигали указанного TBP в Ultra HD, можно с уверенностью предположить, что может быть также в случае Radeon 7900XTX или RX 7900XT. Вопрос только в том, удалось ли AMD добиться столь же широкого диапазона фактического энергопотребления. Потому что только тогда карта будет соответствовать GeForce RTX 4080 на сокете при повседневном использовании. Здесь вам действительно придется несколько раз и более внимательно посмотреть, насколько эффективно оба противника действительно могут действовать.

Потому что только тогда карта будет соответствовать GeForce RTX 4080 на сокете при повседневном использовании. Здесь вам действительно придется несколько раз и более внимательно посмотреть, насколько эффективно оба противника действительно могут действовать.

С такими методами ускорения изображения, как DLSS, FSR или XeSS, 450-ваттная карта в виде GeForce RTX 4090 превращается в 350-ваттную карту (тоже относится к среднему), в то время как GeForce RTX 3090 Ti не может оторваться от Зона 400 Вт. Остальные карты здесь снова примерно на одном уровне. Кроме того, большая карта Ada, конечно, уже время от времени замедляется процессором. Это именно тот момент, когда вы можете протестировать GeForce RTX 4080 16 ГБ самое позднее в день запуска, потому что если бы вы применяли коэффициент, полученный для RTX 4090 здесь. Если бы это было реальным, единственным узким местом для RTX 4090, то грядущая GeForce RTX 4080 16 ГБ должна была бы затронуть очень мало и потреблять примерно то, что можно было бы измерить без DLSS снова.