Nvidia сравнение всех видеокарт: Сравнение всех видеокарт NVIDIA GeForce

Содержание

Сравнение | Графические карты (GPU). 1 199 109 сравнений графических карт

Видеокарты могут быть игровыми и профессиональными. Хотите выбрать оборудование, но не знаете как? Сравните любые две видеокарты и выберите лучшую. Для сравнения доступно более 3 000 видеокарт.

Видеокарты

Сравнение популярных видеокарт

Сравните характеристики видеокарт и выберите лучшую

VS

NVIDIA GeForce 910M VS AMD Radeon RX Vega 10

VS

NVIDIA GeForce 940MX VS AMD Radeon R9 M395X

VS

NVIDIA Quadro FX 3450 VS AMD Radeon HD 7520G + HD 7670M Dual Graphics

Популярные модели

Самые популярные видеокарты по просмотрам

AMD Radeon RX Vega 7

Intel UHD Graphics 630

Intel UHD Graphics 600

AMD Radeon RX Vega 10

NVIDIA Quadro T1000

Intel HD Graphics 530

Intel UHD Graphics 620

Intel HD Graphics 4600

NVIDIA GeForce MX330

Intel HD Graphics 520

ТОП-10 рейтинга

AMD Radeon HD 7990

NVIDIA GeForce GTX 480

AMD Radeon Pro 580

AMD Radeon Pro 460

NVIDIA Quadro M3000M

NVIDIA GeForce RTX 2070 Mobile

AMD Radeon RX 590

NVIDIA GeForce RTX 2070 Super

AMD Radeon RX 580

NVIDIA GEFORCE RTX 3060

Лучшие видеокарты в 2021 году

Рейтинг всех видеокарт в режиме реального времени!

3DMark Ice Storm GPU

NVIDIA GeForce RTX 2080 Ti

100%

NVIDIA Quadro RTX 5000 Mobile

96%

AMD Radeon RX 5600 XT

95%

NVIDIA TITAN RTX

94%

AMD Radeon RX 5700 XT

94%

3DMark Cloud Gate GPU

NVIDIA GeForce GTX 1080 SLI Mobile

100%

NVIDIA TITAN RTX

99%

NVIDIA GeForce RTX 2080 Ti

95%

NVIDIA GeForce GTX 980 SLI Mobile

89%

NVIDIA GeForce GTX 1070 SLI Mobile

88%

3DMark Fire Strike Score

NVIDIA GeForce RTX 2080 Ti

100%

NVIDIA TITAN RTX

91%

AMD Radeon R9 Fury

89%

AMD Radeon RX 5700 XT

84%

NVIDIA GeForce GTX 1080 SLI Mobile

84%

3DMark Vantage Performance

NVIDIA GeForce RTX 2080 Ti

100%

NVIDIA TITAN RTX

85%

NVIDIA GeForce RTX 2070 Super Mobile

84%

NVIDIA GeForce RTX 2080 Super Mobile

83%

NVIDIA GeForce RTX 2070 Super

82%

SPECviewperf 12 — Siemens NX

NVIDIA Quadro P5200

100%

NVIDIA Quadro P5000 Mobile

77%

NVIDIA Quadro RTX 5000 Max-Q

69%

NVIDIA Quadro RTX 5000 Mobile

68%

NVIDIA Quadro P3200

58%

SPECviewperf 12 — Showcase

NVIDIA GeForce RTX 2080 Ti

100%

NVIDIA GeForce GTX 1080 Ti

83%

NVIDIA Titan X Pascal

73%

NVIDIA GeForce RTX 2070 Super

71%

NVIDIA GeForce RTX 2070

68%

Сравнение графических карт

Получите всю информацию о новейших графических процессорах

Еще

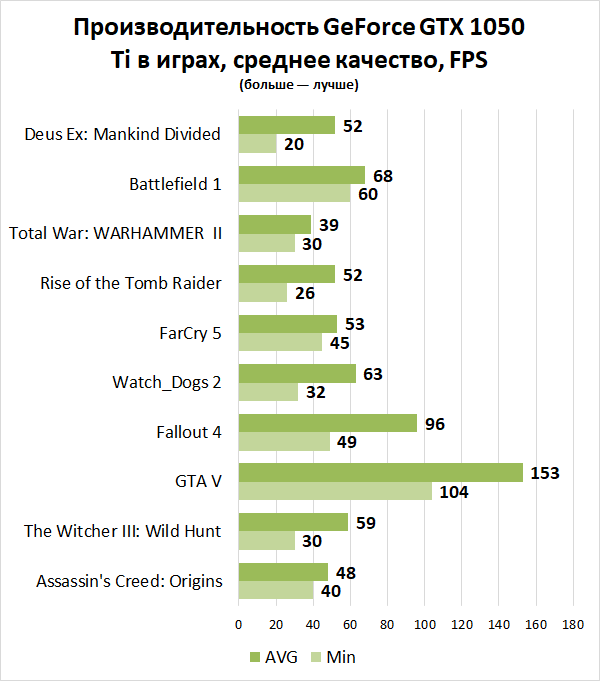

Обзор GeForce GTX 1650 — тестирование в 10 играх и характеристики

Обзор GeForce GTX 1650 — тестирование в 10 играх и характеристики

Основанная на графическом процессоре TU117, новая GeForce GTX 1650 включает в себя все инновации архитектуры Turing, повышающие производительность и эффективность видеокарты, включая поддержку одновременных операций с плавающей запятой и целыми числами, унифицированную архитектуру кэш-памяти с большим кэшем L1 и адаптивное затенение.

TDP нового графического процессора составляет всего 75 Вт, и это означает, что для него не требуется внешний разъем питания. Таким образом это будет самая мощная видеокарта на данный момент, не требующая внешнего питания PCIe.

GeForce GTX 1650 включает в себя 896 ядер CUDA, что на 36% меньше, чем у GTX 1660. Это самое большое снижений ядер среди всех видеокарт на базе Turing. При переходе с RTX 2080 на 2070, с 2070 на 2060, с 2060 на 1660 Ti наблюдается сокращение ядер примерно на 20%, затем на 8% с 1660 Ti на 1660. Единственный другой пример снижения более чем 30% присутствовал между RTX 2080 Ti и RTX 2080, где мы видим снижение количества ядер на 32%, что привело к снижению производительности примерно на 25% в разрешении 4К. Ожидается, что мы увидим аналогичное снижение для GTX 1650 по сравнению с GTX 1660. Помимо снижения числа ядер у 1650 снижена и пропускная способность памяти на 33%.

Более того, в то время как GTX 1660 оснащена 6 ГБ памяти GDDR5, GTX 1650 получила 4 ГБ, используя шину памяти шириной 128 бит для максимальной пропускной способности памяти в 128 ГБ/с. Тактовые частоты по умолчанию – 1485 МГц и 1665 МГц в разгоне, что на 7% меньше тактовой частоты GTX 1660.

Тактовые частоты по умолчанию – 1485 МГц и 1665 МГц в разгоне, что на 7% меньше тактовой частоты GTX 1660.

Тестирование GTX 1650

Согласно NVIDIA, GTX 1650 в два раза быстрее, чем GTX 950 и на 70% быстрее, чем GTX 1050 в разрешении 1080p. Протестируем GTX 1650 в десяти играх в разрешении Full HD. Тестовый стенд – Intel Core i9-9900K 5 ГГц и оперативная память DDR4-3200.

- World War Z

- Apex Legends

- The Division 2

- Shadow of the Tomb Raider

- Forza Horizon 4

- Fortnite

- Metro Exodus

- Rainbow Six Siege

- Battlefield V

- Far Cry New Dawn

World War Z

Начнем тестирование с новинки – World War Z. GTX 1650 в World War Z выдала 68 кадров на ультра настройках. Это на 26% больше, чем выдает GTX 1050 Ti, но на 15% меньше, чем у GTX 1060 3 ГБ.

Apex Legends

Производительность в Apex Legends располагается между GTX 1060 3 ГБ и RX 570. Видеокарта RX 570 оказалась быстрее на 4%, а GTX 1060 3 ГБ на 1% слабее. В обоих случаях отклонения не превышают 3 кадра в секунду.

В обоих случаях отклонения не превышают 3 кадра в секунду.

The Division 2

The Division 2 оптимизирована в сторону видеокарт AMD, что приводит к 27% разнице в производительности между RX 570 и GTX 1650 в пользу первой.

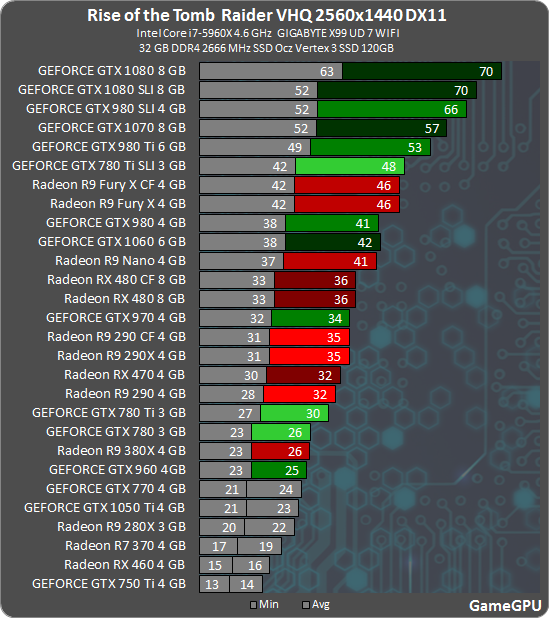

Shadow of the Tomb Raider

В Shadow of the Tomb Raider GTX 1650 вплотную приблизилась к GTX 1060 3 ГБ и RX 570 показав 49 кадров в секунду.

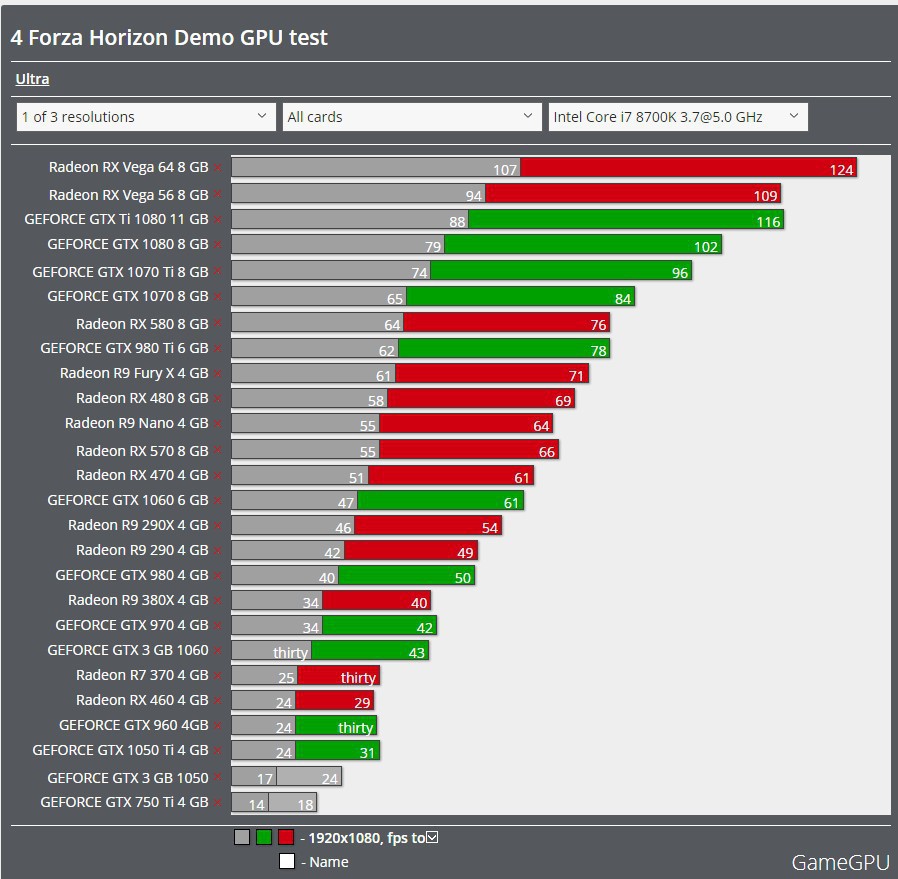

Forza Horizon 4

GTX 1650 выдает 61 FPS в Forza Horizon 4 и опережает GTX 1060 3 ГБ, но показывает результат на 21% ниже, чем RX 570.

Fortnite

С 77 кадрами в секунду GTX 1650 опережает на несколько кадров RX 570 и обгоняет GTX 1050 Ti на 26%.

Metro Exodus

GTX 1650 в Metro Exodus незначительно уступает RX 570 и GTX 1060 3 ГБ, опережая GTX 1050 Ti.

Rainbow Six Siege

В популярном шутере Rainbow Six Siege GTX 1650 опережает и RX 570 и GTX 1060 3 ГБ, выдавая 79 кадров.

Battlefield V

GTX 1650 в Battlefield V была на 26% быстрее, чем GTX 1050 Ti, и на 11% медленнее, чем 1060 3GB.

Far Cry New Dawn

GTX 1650 не впечатляет в Far Cry New Dawn, она на 23% быстрее, чем GTX 1050 Ti, но на 18% медленнее, чем RX 570 и GTX 1060 3 ГБ.

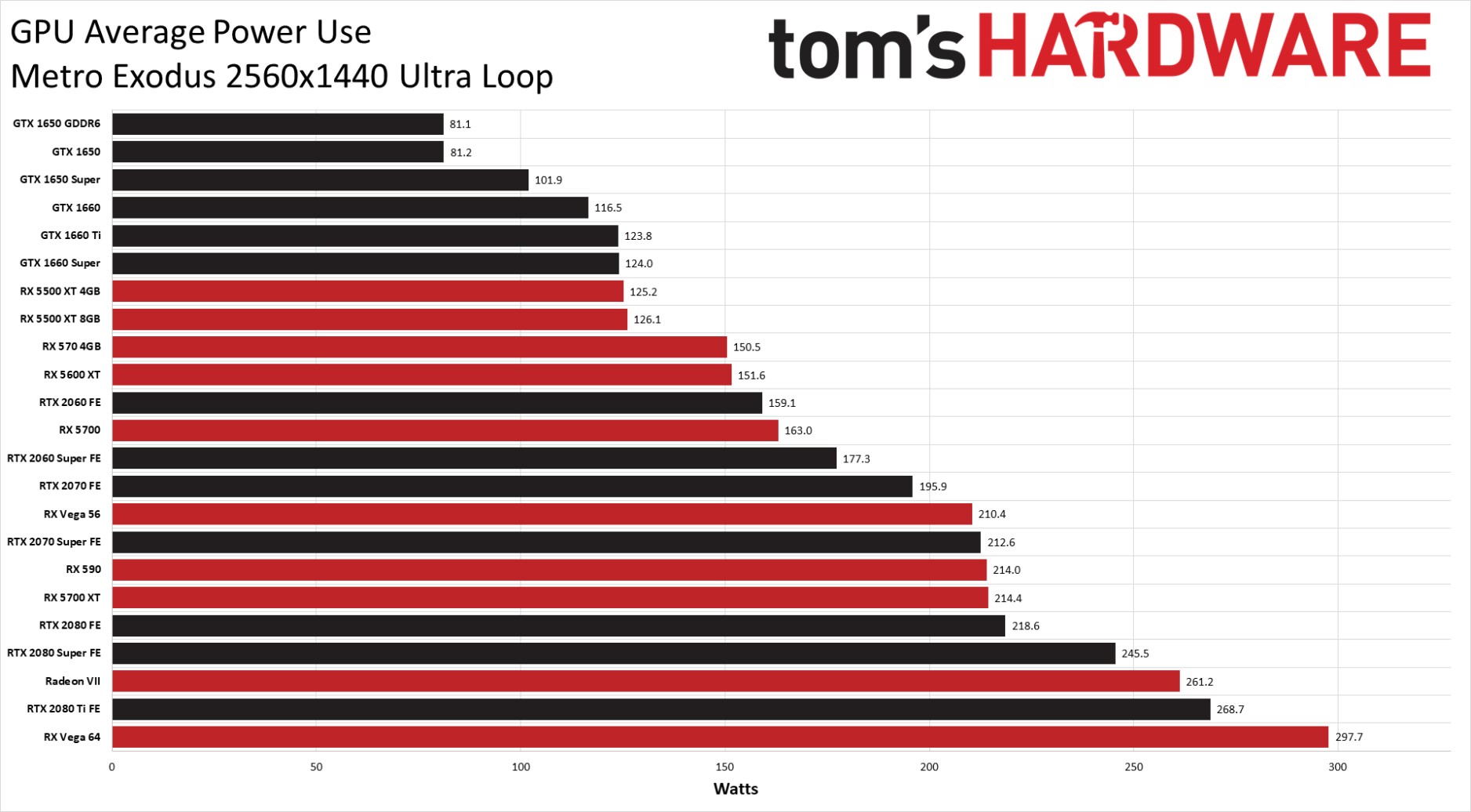

Потребляемая мощность и температура GTX 1650

GTX 1650 впечатляет в плане энергопотребления. Видеокарта Gigabyte увеличила общее потребление системы до 184 Вт, а видеокарта от MSI до 192 Вт. Разница в производительности составила 30%, но энергопотребление увеличилось всего на 10%. Для сравнения – Radeon RX 560 увеличило потребление системы сразу на 55%. Таким образом GTX 1650 получилась весьма эффективной в этом плане.

MSI Gaming X достигла температуры в 61 градус в комнате с 21-градусной температурой. И это на частоте 1920 МГц, это очень крутой результат. Gigabyte Gaming OC добилась наилучшего результата с пиковой температурой в 58 градусов на частоте в 1950 МГц.

GTX 1650 vs GTX 1060 3 ГБ

По сравнению с GTX 1060 3GB (более дорогой видеокартой), GTX 1650 показывает себя в среднем на 9% медленнее, в редких играх обгоняя на несколько процентов.

Сравните широкий выбор мощных графических процессоров

Какой графический процессор вам подходит?

Откройте для себя весь спектр высокопроизводительных графических процессоров, которые помогут воплотить в жизнь ваши творческие замыслы.

Ноутбуки

Ядра трассировки лучей: для точного освещения, теней, отражений и более качественного рендеринга за меньшее время.

ИИ и тензорные ядра: для ускоренных операций ИИ, таких как повышение разрешения, улучшение фотографий, согласование цветов, маркировка лиц и передача стилей.

Расширенные рабочие процессы с несколькими приложениями: для требовательных рабочих процессов, обычно включающих несколько творческих приложений, для каждого из которых требуется собственный набор выделенных системных ресурсов.

Сертификация программного обеспечения: поставщиков программного обеспечения, которые разрабатывают творческие приложения, тестируют и сертифицируют конкретное оборудование для оптимальной и стабильной работы.

Enterprise Support: специальных функций и поддержка для корпоративных пользователей.

Графическая память: быстрых модулей памяти, предназначенных для задач с интенсивным использованием графики. Больше графической памяти означает, что GPU может выполнять более крупные и сложные задачи.

Настольные компьютеры

Ядра трассировки лучей: для точного освещения, теней, отражений и более качественного рендеринга за меньшее время.

ИИ и тензорные ядра: для ускоренных операций ИИ, таких как повышение разрешения, улучшение фотографий, согласование цветов, маркировка лиц и передача стилей.

Расширенные рабочие процессы с несколькими приложениями: для ресурсоемких рабочих процессов, обычно включающих несколько творческих приложений, для каждого из которых требуется собственный набор выделенных системных ресурсов.

Сертификация программного обеспечения: 9Поставщики программного обеспечения 0012, разрабатывающие творческие приложения, тестируют и сертифицируют конкретное оборудование для оптимальной и стабильной работы.

Enterprise Support: специальных функций и поддержка для корпоративных пользователей.

Графическая память: быстрых модулей памяти, предназначенных для задач с интенсивным использованием графики. Больше графической памяти означает, что GPU может выполнять более крупные и сложные задачи.

Купить продукты

Ознакомьтесь с ассортиментом высокопроизводительных продуктов, совместимых с технологией NVIDIA Studio.

Получить последние новости NVIDIA Studio

Раздел

Раздел

Подпишитесь на игровые и развлекательные предложения, объявления и многое другое от NVIDIA.

Плюс креативные советы и рекомендации, подарки и эксклюзивные скидки.

Адрес электронной почты

В настоящее время мы не можем обработать ваш запрос

本人 知悉且 同意 nvidia corporation 基于 、 活动 组织 的 目的 对 本人 的 上述 的 收集 收集 和 处理 , 已经 阅读 并 同意 Ответ NVIDIA。

本人 知悉且 同意 因 调研 、 活动 组织 的 必须 , 以及 相 的 的 nvidia 内部 和 系统 操作 的 需要 , 上述 会 被 传输 到 位于 的 的 nvidia corporation 按照 符合 Ответ NVIDIA的方式进行存储,您可以通过发送邮件至>[email protected]

История видеокарт Nvidia

Компания Nvidia была основана в 1993 году, но только в 1995 году компания выпустила свой первый графический продукт — NV1.

С тех пор многое изменилось, и теперь мы избалованы трассировкой лучей, DLSS и другими замечательными технологиями, которые делают наши игровые возможности еще более приятными.

Мы оглядываемся на историю видеокарт Nvidia и на то, как эти устройства выглядели на протяжении многих лет.

Nvidia NV1

Swaaye/Wikipedia

Nvidia NV1 была выпущена в 1995 году и могла обрабатывать как 2D, так и 3D видео. Он продавался как «Diamond Edge 3D» и даже имел порт для джойстика, совместимый с Sega Saturn.

Несколько игр Sega Saturn были перенесены на ПК, включая Panzer Dragoon и Virtua Fighter Remix. Одних этих функций было недостаточно, чтобы привлечь рынок, поскольку Saturn изо всех сил пытался конкурировать с оригинальной PlayStation.

У NV1 был тяжелый старт, который усугубился выпуском Microsoft DirectX, который был несовместим с графическим процессором, и многие игры не запускались.

Nvidia RIVA 128

Mathías Tabó/Wikipedia

В 1997 году Nvidia выпустила NV3, также известную как Riva 128, Riva расшифровывалась как «Интерактивное видео и анимация в реальном времени». Эта видеокарта использовала как 2D-, так и 3D-ускорение, а также наложение полигональных текстур.

В то время конкурент Nvidia 3dfx доминировал на рынке, но NV3 имел тактовую частоту ядра/памяти 100 МГц и по существу удваивал характеристики 3dfx Voodoo 1.

Было два варианта NV3 в виде Riva 128 и Рива 128ZX. Последний был более мощным с 8 МБ видеопамяти и тактовой частотой 250 МГц.

NV3 оказался гораздо более успешным, чем первый GPU компании, и помог Nvidia завоевать широкую популярность.

Nvidia NV4

Tors/Wikipedia

В 1998 году Nvidia выпустила NV4, также известную как Riva TNT. Эта видеокарта улучшена по сравнению с предыдущими моделями за счет поддержки 32-битного True Colour. NV4 также имел больше оперативной памяти с 16 МБ SDR SDRAM, что также означало более высокую производительность.

Примерно в это же время Nvidia начала предпринимать шаги по регулярному обновлению графических драйверов, чтобы обеспечить хорошую производительность и совместимость для конечного пользователя, чем компания занимается и по сей день.

Riva TNT от Nvidia была более доступной в то время, чем Vodoo2 от 3dfx, хотя и немного медленнее с точки зрения производительности. Поддержка драйверов была ключом к успеху NV4.

Поддержка драйверов была ключом к успеху NV4.

Nvidia NV5

Uwe Hermann/Wikipedia

В 1999 году Nvidia последовала за NV4, выпустив RIVA TNT2. NV5, как она называлась, приобрела ряд обновлений, включая поддержку 32-битного Z-буфера/трафарета, до 32 МБ видеопамяти и поддержку текстур 2048 x 2048.

Что еще более важно, эта видеокарта имеет улучшенную тактовую частоту (до 150+ МГц), что дает прирост производительности на целых 17 процентов по сравнению с предыдущей моделью.

Эта карта была прямым конкурентом 3dfx Voodoo3, и обе были невероятно популярны.

Nvidia GeForce 256

Hyins/Wikipedia

В конце 1999 года Nvidia выпустила «первый в мире графический процессор» — Nvidia GeForce 256.

Это был умный маркетинговый ход со стороны Nvidia и начало любовь к графическим картам GeForce на долгие годы.

Он был улучшен по сравнению с предыдущими картами RIVA за счет увеличения пиксельных конвейеров, но также обеспечил значительный скачок в производительности для компьютерных игр.

Эта карта поддерживает до 64 МБ DDR SDRAM и работает на частоте до 166 МГц. Таким образом, он был на 50 процентов быстрее, чем NV5.

Что еще более важно, GeForce 256 также полностью поддерживала Direct3D 7, что означало, что на нем можно было запускать многие из лучших игр для ПК, доступных в то время.

Вскоре после этого запуска 3dfx обанкротилась, и основным конкурентом Nvidia стала ATI.

Nvidia GeForce2

Hyins/Wikipedia

Nvidia последовала за первым в мире графическим процессором с метко названным GeForce2.

Этот графический процессор выпускался в нескольких различных вариантах, включая модели Ti, Pro, GTS и Ultra. По сути это были карты NV11, 15 и 16. В выпусках 2000 и 2001 годов наблюдалось увеличение конвейеров и более высокая тактовая частота.

Что сделало GeForce2 интересным, так это начало поддержки мультимониторных установок.

Примерно в это же время Nvidia приобрела 3dfx.

Nvidia GeForce3

Hyins/Wikipedia

Вскоре после GeForce2 появилась GeForce3. Эта серия видеокарт под кодовым названием NV20 представляла собой первые графические процессоры Nvidia, совместимые с DirectX 8.

Эта серия видеокарт под кодовым названием NV20 представляла собой первые графические процессоры Nvidia, совместимые с DirectX 8.

Было три версии — GeForce3, GeForce3 Ti 200 и GeForce3 Ti 500. В этом следующем графическом процессоре GeForce были добавлены программируемые пиксельные и вершинные шейдеры, а также мультисэмпловое сглаживание.

Версия GeForce3, именуемая NV2A, использовалась в оригинальной консоли Xbox.

Серия Nvidia GeForce FX

Hyins/Wikipedia

Скачок вперед на пару поколений, и в 2003 году мы выпустили серию Nvidia GeForce FX.

Это были видеокарты GeForce пятого поколения с поддержкой Direct3D 9.а также ряд новых технологий памяти. К ним относятся DDR2, GDDR2 и GDDR3, а также первая попытка Nvidia использовать шину данных памяти шире 128 бит.

Между тем, GeForce FX 5800 произвела фурор, став первым графическим процессором, оснащенным большим кулером. Один такой большой, что его часто называли «пылесборником» из-за большого количества шума вентилятора.

Серия Nvidia GeForce 6

Hyins/Wikipedia

Вскоре после выпуска серии GeForce FX появилась серия 6 (она же NV40). GeForce 6 стала началом продвижения Nvidia технологии SLI, позволяющей людям комбинировать более одной видеокарты для большей мощности.

Флагманом этой линейки была GeForce 6800 Ultra, видеокарта с 222 миллионами транзисторов, 16-пиксельными суперскалярными конвейерами и шестью вершинными шейдерами. Он имел поддержку Shader Model 3.0 и был совместим как с Microsoft DirectX 9.0c, так и с OpenGL 2.0.

В этой серии также использовалась технология Nvidia PureVideo, и она могла декодировать видео H.264, VC-1, WMV и MPEG-2 с меньшим использованием ЦП.

В результате все это привело к большому успеху серии GeForce 6.

Серия Nvidia GeForce7

FxJ/Wikipedia

В 2005 году вышла серия GeForce7, включая 7800 GTX.

Одна только эта карта была настоящей электростанцией для того времени, и благодаря умному охлаждению Nvidia смогла увеличить тактовую частоту до 550 МГц. При этом компании также удалось уменьшить латентность и увеличить шину до 512 бит.

При этом компании также удалось уменьшить латентность и увеличить шину до 512 бит.

Интересно, что версия серии 7 была создана как синтезатор реальности RSX, который был проприетарным процессором, созданным совместно Nvidia и Sony для PlayStation 3.

Серия Nvidia GeForce8

Shooke/Wikipedia

В 2006 году Nvidia выпустила серию GeForce8 и представила свою микроархитектуру Tesla. Это был первый унифицированный дизайн шейдеров компании, и он также станет одной из наиболее часто используемых архитектур в будущих картах.

Популярная Nvidia GeForce 8800 GTX была флагманом линейки и пользовалась невероятной популярностью. Он имел 681 миллион транзисторов, 768 МБ памяти GDDR3 и 128 шейдеров с тактовой частотой 575 МГц.

Наиболее важно то, что эта видеокарта могла запускать Crysis, а это было всем, чего хотели компьютерные геймеры в то время.

В 2006 году ситуация также накалялась, когда AMD купила ATI за 5,4 миллиарда долларов и стала занозой в боку Nvidia на долгие годы.

Серия Nvidia GeForce9

Sk/Wikipedia

В начале 2008 года Nvidia выпустила серию GeForce9. Эти карты продолжали использовать архитектуру Tesla, но также добавили поддержку PCIe 2.0, улучшенный цвет и z-сжатие.

К этому времени Nvidia значительно повысила производительность, тактовая частота достигла 675 МГц, но при этом снизилось энергопотребление.

Серия Nvidia GeForce 400

Amazon

Следующее значительное обновление произошло в 2010 году, когда Nvidia выпустила серию GeForce 4000. Именно тогда Nvidia представила микроархитектуру Fermi, которая стала следующей крупной архитектурой компании.

Эта серия также имела поддержку OpenGL 4.0 и Direct3D 11 и была прямым конкурентом серии Radeon HD 5000.

Однако серию подвели высокие рабочие температуры и энергопотребление, что вызвало множество недовольств пользователей.

Серия Nvidia GeForce 600

HanyNAR

Серия GeForce 600 представила архитектуру Nvidia Kepler, которая была разработана для увеличения производительности на ватт, а также улучшения производительности предыдущей микроархитектуры Fermi.

С помощью Kepler Nvidia удалось увеличить тактовую частоту памяти до 6 ГГц. Он также добавил GPU Boost, который гарантировал, что GPU сможет работать на минимальной тактовой частоте, а также повышать производительность при необходимости, пока не будет достигнуто заранее определенное целевое значение мощности.

Этот диапазон также поддерживал как Direct3D 11, так и Direct3D 12. Он также представил новый метод сглаживания, известный как TXAA.

Серия Nvidia GeForce 700

Маркус Бернс

В 2013 году Nvidia подняла ситуацию на новый уровень, выпустив серию 700, которая была дополнена безумной высококлассной картой для энтузиастов GTX Titan.

Эта серия была обновлением микроархитектуры Kepler, но некоторые более поздние карты также имели архитектуры Femi и Maxwell.

GTX Titan может похвастаться 2688 ядрами CUDA, 224 TMU и 6 ГБ оперативной памяти. К этому времени Nvidia удалось втиснуть в свои графические процессоры целых семь миллиардов транзисторов.

Серия GeForce 700 была разработана для максимальной энергоэффективности, но также включала другие функции, такие как аппаратное кодирование H.264, интерфейс PCI Express 3.0, поддержку DisplayPort 1.2 и HDMI 1.4a 4K x 2K видеовыхода, а также GPU-Boost 2.0. .

Серия Nvidia GeForce 900

Маркус Бернс

В 2014 году Nvidia, казалось бы, пропустила поколение и сразу приступила к серии GeForce 900. Это было введение в микроархитектуру Maxwell, которая предлагала улучшенные графические возможности, а также лучшую энергоэффективность.

Изначально флагманом этой серии была GeForce GTX 980, за которой позже последовали 980 Ti и GeForce GTX TITAN X на крайнем конце.

NVENC также был улучшен для этой серии и появилась поддержка Direct3D 12_1, OpenGL 4.6, OpenCL 3.0 и Vulkan 1.3.

Серия Nvidia GeForce10

Маркус Бернс

В 2014 году Nvidia представила серию GeForce10 на основе микроархитектуры Pascal. GTX 1080 Ti, пожалуй, самый известный из графических процессоров этой серии и закрепил за собой историю как, пожалуй, одна из самых значимых карт, выпущенных Nvidia.

Эта графическая карта доминировала на рынке и предлагала такую превосходную производительность и энергоэффективность по сравнению с ценой, что ее часто будут упоминать при сравнении с будущими графическими процессорами.

Серия 10 также включает новые функции, такие как GPU Boost 3.0, система планирования динамической балансировки нагрузки, тройная буферизация и поддержка DisplayPort 1.4 и HDMI 2.0b.

Серия Nvidia GeForce20

Маркус Бернс

Серия GeForce 20 была выпущена в 2018 году и представила миру микроархитектуру Turing.

Примечательно, что эти видеокарты были картами RTX первого поколения, и Nvidia продвигала трассировку лучей в качестве основного преимущества.

Использование тензорных ядер и других усовершенствований помогло этим картам совершить огромный скачок в графическом совершенстве. Результатом является реалистичное освещение и убедительные эффекты отражения в игре.

Однако за улучшения пришлось заплатить: RTX 2080 Ti продавалась по невероятной цене 1199 долларов (по сравнению с 699 долларов за 1080 Ti).

Nvidia GeForce30 серии

Pocket-lint

Серия GeForce30 пришла на смену серии 20 в 2020 году и, к сожалению, стала наиболее известной из-за того, что ее просто невозможно было достать из-за нехватки силикона.

Тем не менее, Nvidia RTX 3080 должна была продаваться по цене 699 долларов, что делало ее намного более доступной, чем флагманы предыдущих поколений, и серия также получила значительные улучшения.

Флагманская видеокарта GeForce RTX 3090 Ti, анонсированная в марте 2022 года, содержит 10 752 ядра CUDA, 78 RT-TFLOP, 40 Shader-TFLOP и 320 Tensor-TFLOP мощности. Этот мощный зверь также был отмечен как энергоемкий, требующий не менее 850 Вт мощности, а это означает, что для его работы вам, вероятно, понадобится блок питания мощностью 1000 Вт.

Nvidia GeForce 40-й серии

Nvidia

Nvidia постоянно пытается раздвинуть границы с каждой итерацией. С RTX 40-й серии один пользователь доказал, что можно запускать игры с разрешением 13K.

Это была первая серия графических процессоров, в которой использовался разъем 12VHPWR, что приводило к некоторым проблемам, но в остальном в основном имело восторженные отзывы.